Under sit besøg i Storbritannien til AI Safety Summit meddelte USA's vicepræsident Kamala Harris, at 30 lande har tilsluttet sig USA's forslag til retningslinjer for militær brug af kunstig intelligens.

Meddelelsen "Politisk erklæring om ansvarlig militær brug af kunstig intelligens og autonomi" blev sendt på det amerikanske udenrigsministeriums hjemmeside den 1. november med yderligere detaljer om rammerne offentliggjort den 9. november.

I sin udtalelse om rammerne sagde Harris: "For at skabe orden og stabilitet midt i de globale teknologiske forandringer tror jeg fuldt og fast på, at vi må lade os lede af et fælles sæt forståelser blandt nationerne."

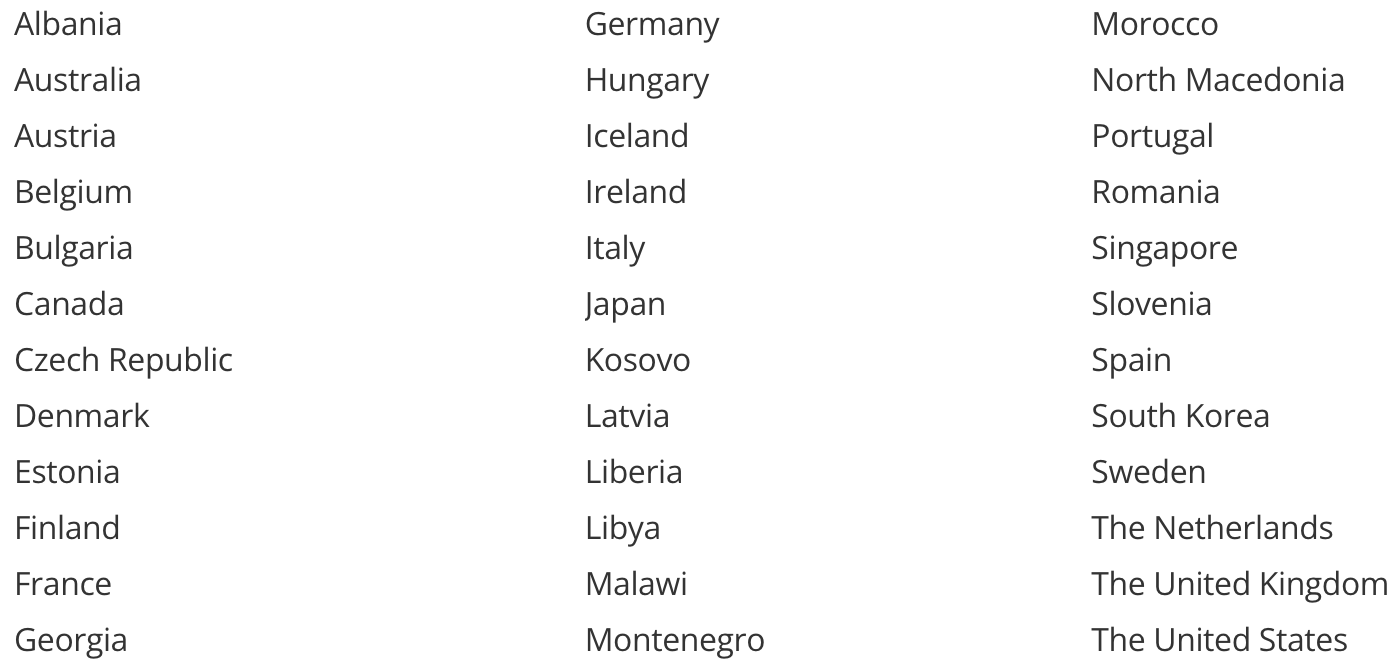

Det er de lande, der har lovet at støtte initiativet.

Det er bemærkelsesværdigt, at Kina og Rusland ikke er med på denne liste. Kina tilsluttede sig Bletchley-erklæringenog lovede sin principielle støtte til en sikker udvikling af kunstig intelligens generelt.

Ruslands og Kinas beslutning om ikke at støtte den militære AI-erklæring har måske mere at gøre med dokumentets forfattere end med deres syn på dets indhold.

Et andet hul på listen er efterladt af to lande, der i øjeblikket modtager milliarder i militær støtte fra nogle af de stater, der støtter dem, nemlig Israel og Ukraine.

Som USA's allierede skyldes deres beslutning om ikke at tilslutte sig løftet sandsynligvis, at begge lande i øjeblikket bruger AI i de konflikter, de er involveret i.

Israel bruger AI i forskellige militære applikationer, herunder dets Jernkuppel system. Ukraine har skabt kontroverser med sit Autonome AI-droner på jagt efter soldater og militært udstyr i konflikten med Rusland.

Hvad forpligter de sig til?

Hvis du vil læse de fulde detaljer om, hvad underskriverne er enige om Du kan gøre det her.

Her er den korte version, som måske ofrer lidt substans for kortfattethed:

- Sørg for, at dit militær indfører og bruger disse AI-principper.

- Din militære brug af AI skal overholde international lov og beskytte civile.

- Den øverste ledelse skal styre udviklingen og implementeringen af militær AI.

- Proaktivt minimere utilsigtet bias i militære AI-kapaciteter.

- Vær forsigtig, når du laver eller bruger AI-våben.

- Sørg for, at din AI-forsvarsteknologi er gennemsigtig og kan revideres.

- Træn dem, der bruger eller godkender brugen af militære AI-kapaciteter, så de ikke stoler blindt på AI'en, når den tager fejl.

- Definér klart, hvad du har tænkt dig at gøre med din militære AI-teknologi, og design den, så den kun gør det.

- Bliv ved med at teste selvlærende og løbende opdatere militære AI-funktioner for at se, om de stadig er sikre.

- Hav en off-switch i tilfælde af, at dit AI-våben opfører sig forkert.

Det er prisværdige idealer, men det er tvivlsomt, om de teknologisk eller endda logistisk er inden for forsvarsorganisationernes rækkevidde.

Vil de kunne håndhæves? En underskrift på pledgen er en bekræftelse på principiel tilslutning, men indebærer ikke nogen juridisk forpligtelse.

At underskrive et dokument, hvor der står: "Vi vil være forsigtige, når vi bruger AI i vores militær", betyder også, at landet fuldt ud har til hensigt at bruge AI som et våben, om end på en "ansvarlig og etisk" måde.

I det mindste anerkender disse lande AI's potentiale til at forstærke den skade, som konventionelle våben allerede forårsager. Har denne ramme gjort verden lidt mere sikker, eller har den bare sat fokus på, hvad der uundgåeligt ligger forude?