En undersøgelse foretaget af The Guardian har kastet lys over Storbritanniens gennemgribende brug af AI og komplekse algoritmer i forskellige beslutningsprocesser i den offentlige sektor.

Embedsmænd fra mindst otte offentlige afdelinger har sammen med flere politienheder indarbejdet AI-værktøjer i deres arbejdsgange.

AI-værktøjer har hjulpet vigtige beslutningsprocesser på tværs af velfærd, immigration og strafferet. Undersøgelsen afslørede tegn på misbrug og diskrimination.

Selvom algoritmisk og AI-relateret bias ikke strengt taget falder ind under samme definition, risikerer de begge at give skævvredne resultater, når de udsættes for scenarier i den virkelige verden. Selvlærende maskinlæringsmodeller kan forstærke skævheder, der er fremherskende i datasæt.

I henhold til Rapport:

- Et parlamentsmedlem har udtrykt bekymring over en algoritme, der anvendes af Department for Work and Pensions (DWP), og som mistænkes for fejlagtigt at have resulteret i, at adskillige personer har mistet deres ydelser.

- Metropolitan Police's ansigtsgenkendelsesværktøj har vist sig at have en højere fejlprocent, når det identificerer sorte ansigter sammenlignet med hvide ansigter under visse forhold. Dette er veletableret, med en undersøgelse hvilket indikerer, at disse platforme havde en nøjagtighed på sølle 2% i 2018.

- Indenrigsministeriet har brugt en algoritme, der er uforholdsmæssigt målrettet personer fra bestemte nationaliteter, til at afsløre falske ægteskaber om ydelser og skattelettelser. Statsborgere fra Albanien, Grækenland, Rumænien og Bulgarien kan være blevet uretfærdigt markeret.

AI-værktøjer lærer mønstre fra omfattende datasæt. Hvis datasættene er forudindtagede eller dårligt repræsentative for virkeligheden, arver modellen disse mønstre.

Der er mange internationale eksempler på AI-relateret og algoritmisk bias, herunder falske ansigtsgenkendelsesmatches, der fører til fængsling, kreditvurderingssystemer At påføre kvinder fordommeog diskriminerende værktøjer, der bruges i domstole og sundhedssystemer.

The Guardians rapport hævder, at Storbritannien nu befinder sig på randen af en potentiel skandale, hvor eksperter udtrykker bekymring over gennemsigtigheden og forståelsen af de algoritmer, som embedsmændene bruger.

Der har allerede været skandaler er blevet set i andre landesom f.eks. i USA, hvor Forudsigende politiplatforme er blevet afvikletog i Holland, hvor domstolene modsatte sig et AI-system, der skulle dæmme op for socialt bedrageri.

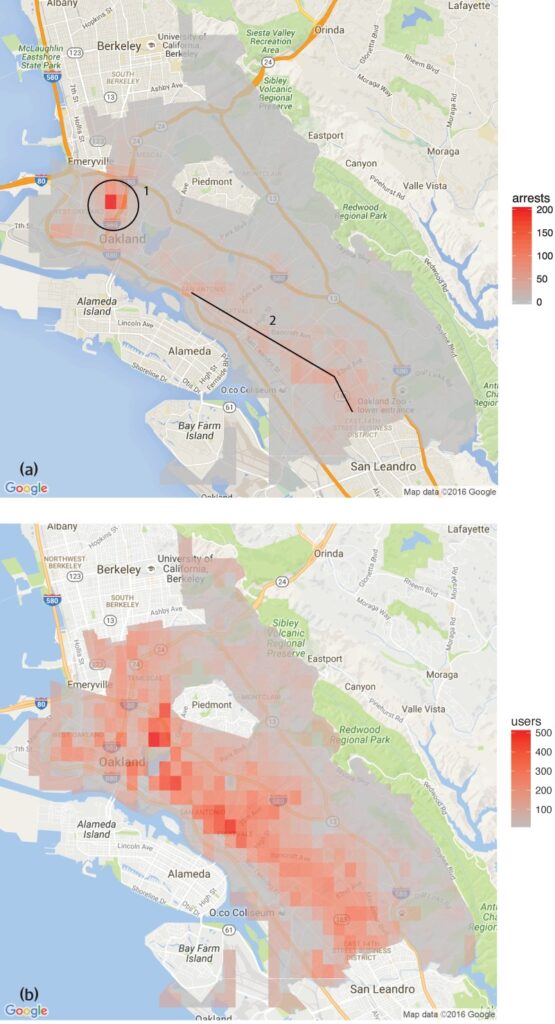

En undersøgelse foretaget af Gruppe til analyse af menneskerettighedsdata fandt ud af, at software til forudsigende politiarbejde i Oakland, Californien, i uforholdsmæssig høj grad var rettet mod farvede samfund og dermed opretholdt en cyklus af overpolitisering i disse kvarterer.

Dette afspejler de bekymringer, som Metropolitan Police's værktøj til ansigtsgenkendelsesom viste højere fejlprocenter ved identifikation af sorte ansigter under visse betingelser.

Der er også flere eksempler inden for sundhedsvæsenet, f.eks. uoverensstemmelser i AI-modeller, der er designet til at hjælpe med at opdage hudkræft. I de fleste tilfælde har minoritetsgrupper og kvinder den højeste risiko.

Shameem Ahmad, administrerende direktør for Public Law Project, understregede behovet for øjeblikkelig handling og sagde: "AI har et enormt potentiale for sociale goder. Vi kan f.eks. gøre tingene mere effektive. Men vi kan ikke ignorere de alvorlige risici. Uden hurtig handling kan vi gå i søvne ind i en situation, hvor uigennemsigtige automatiserede systemer regelmæssigt, muligvis ulovligt, bruges på livsændrende måder, og hvor folk ikke vil være i stand til at søge erstatning, når disse processer går galt."

Marion Oswald, der er juraprofessor ved Northumbria University, er enig i disse bekymringer og har fremhævet uoverensstemmelserne og den manglende gennemsigtighed i den offentlige sektors brug af AI: "Der er en mangel på konsekvens og gennemsigtighed i den måde, AI bruges på i den offentlige sektor. Mange af disse værktøjer vil påvirke mange mennesker i deres hverdag, f.eks. dem, der søger om ydelser, men folk forstår ikke, hvorfor de bliver brugt, og har ikke mulighed for at udfordre dem."

AI's risici for den offentlige sektor

Den ukontrollerede anvendelse af AI på tværs af ministerier og politistyrker giver anledning til bekymring om ansvarlighed, gennemsigtighed og partiskhed.

I tilfældet med Department for Work and Pensions (DWP) afslørede The Guardians rapport tilfælde, hvor en algoritme suspenderede folks ydelser uden en klar forklaring.

Parlamentsmedlem Kate Osamor sagde, at hendes bulgarske vælgere mistede deres ydelser på grund af et halvautomatisk system, der markerede deres sager for potentiel svindel, hvilket understreger manglen på gennemsigtighed.

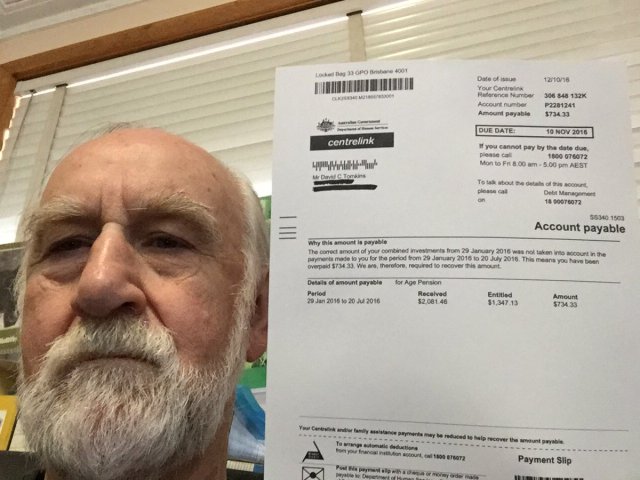

Dette minder om "Robodebt"-skandale i Australienhvor et automatiseret system fejlagtigt beskyldte over 400.000 mennesker for velfærdssvindel, hvilket førte til omfattende problemer.

Robodebt-skandalen, som blev undersøgt af Commonwealth-ombudsmanden, udfordret juridisk og udsat for offentlige undersøgelser, viste omfanget af de konsekvenser, som algoritmisk beslutningstagning har.

Den australske regering gik med til et forligsbeløb på AUS $1,8 milliarder i 2021.

AI's mangler er ikke begrænset til offentlige tjenester. Erhvervslivet har også oplevet fejl, især i AI-drevne rekrutteringsværktøjer.

Et bemærkelsesværdigt eksempel er Amazons AI-rekrutteringsværktøj, som udviste partiskhed over for kvindelige kandidater. Systemet blev trænet på CV'er indsendt til virksomheden over en 10-årig periode, hvoraf de fleste kom fra mænd, hvilket resulterede i, at AI'en favoriserede mandlige kandidater.

Tre eksempler på algoritmisk bias, som du skal være på vagt over for

I takt med at AI og algoritmisk beslutningstagning integreres i komplekse samfundsprocesser, stiger antallet af alarmerende eksempler på fordomme og diskrimination.

Det amerikanske sundheds- og retssystem

En undersøgelse fra 2019 udgivet i Science afslørede, at en udbredt sundhedsalgoritme i USA udviste racemæssig bias. Algoritmen var mindre tilbøjelig til at henvise sorte mennesker til programmer, der er designet til at forbedre behandlingen af patienter med komplekse medicinske behov, end deres hvide modparter.

Undersøgelsen forklarer hvorfor: "Bias opstår, fordi algoritmen bruger sundhedsomkostninger som en proxy for sundhedsbehov. Der bruges færre penge på sorte patienter, som har samme behov, og algoritmen konkluderer derfor fejlagtigt, at sorte patienter er sundere end lige så syge hvide patienter."

Et andet kritisk eksempel er brugen af kunstig intelligens til forudsigelse af politiarbejde og strafudmåling. Værktøjer som Profilering af kriminalforsorgens ledelse for alternative sanktioner (COMPAS) er blevet brugt til at vurdere risikoen for, at tiltalte begår ny kriminalitet.

Undersøgelser har vist, at disse værktøjer kan være forudindtagede over for afroamerikanske tiltalte og tildele dem højere risikoscore end deres hvide modparter. Det giver anledning til bekymring for, om AI-assisteret juridisk beslutningstagning er retfærdig og upartisk.

Ansigtsgenkendelse i Brasilien

Den Smart Sampa-projektet i São Paulo, Brasilien, markerede en vigtig milepæl i integrationen af AI og overvågning i bylandskaber - noget, der kun havde været typisk i Kina.

Inden 2024 er det målet at installere op til 20.000 kameraer i São Paulo og integrere et tilsvarende antal tredjeparts- og private kameraer i en enkelt videoovervågningsplatform. Dette netværk vil overvåge offentlige rum, medicinske faciliteter og skoler og granske indhold på sociale medier, der er relevant for den offentlige administration.

Mens Smart Sampa lover øget sikkerhed og bedre offentlige tjenester, advarer eksperter om, at det kan forværre eksisterende samfundsmæssige problemer, især strukturel racisme og ulighed.

Over 90% af de personer, der arresteres i Brasilien på baggrund af ansigtsgenkendelse, er sorte. São Paulos initiativ risikerer at fastholde denne tendens og yderligere marginalisere det sorte samfund, som udgør 56% af Brasiliens befolkning.

Ansigtsgenkendelsesteknologier identificerer ofte mørke hudtoner forkert, dels fordi billeddannelsesteknologien underpræsterer for mørke hudfarver, og dels fordi træningsdatasættene ikke er repræsentative.

Fernanda Rodrigues, advokat for digitale rettigheder, understregede potentialet for falske positiver og den efterfølgende risiko for massefængsling af sorte personer.

Rodrigues sagde: "Ud over risikoen for, at de oplysninger, der sendes til disse platforme, ikke er nøjagtige, og at selve systemet kan svigte, er der et problem, der går forud for de teknologiske konsekvenser, nemlig racisme."

"Vi ved, at straffesystemet i Brasilien er selektivt, så vi kan konkludere, at [brug af overvågning med ansigtsgenkendelse] handler om at øge risikoen og skaderne for denne befolkning", tilføjede hun.

Hensynet til privatlivets fred er også afgørende. Kritikere hævder, at Smart Sampa kan krænke grundlæggende menneskerettigheder, herunder privatlivets fred, ytrings-, forsamlings- og foreningsfrihed. Projektets uigennemsigtige karakter komplicerede sagen yderligere med begrænset offentlig inddragelse i høringsfasen.

Smart Sampa har ikke stået uimodsagt. Offentlige anklagere har undersøgt sagen, og menneskerettighedsorganisationer har indledt retssager for at stoppe teknologien.

Den hollandske systemrisikoindikation (SyRI)

I 2022 undersøgte distriktsdomstolen i Haag den hollandske regerings anvendelse af Indikation af systemrisiko (SyRI)en algoritme, der er designet til at opdage potentiel svindel med sociale ydelser.

SyRI skulle gøre det mere effektivt at identificere velfærdssvindel ved at samle data fra forskellige offentlige databaser og anvende risikoindikatorer til at generere profiler af potentielle svindlere. Men mistænkelige beslutninger og manglende gennemsigtighed fik alarmklokkerne til at ringe, hvilket førte til en juridisk udfordring fra en koalition af civilsamfundsorganisationer.

Sagsøgerne hævdede, at SyRI overtrådte forskellige internationale og europæiske menneskerettighedslove. De satte også spørgsmålstegn ved lovligheden, nødvendigheden og proportionaliteten af algoritmens anvendelse.

Distriktsdomstolen i Haag afgjorde, at lovgivningen om SyRI og dens anvendelse ikke levede op til de nødvendige menneskerettighedsstandarder. Retten fremhævede den manglende gennemsigtighed og potentialet for diskriminerende effekter og understregede behovet for passende juridiske garantier, når sådanne teknologier implementeres.

Sagen er blevet hyldet som en af de første, der tager fat på menneskerettighedskonsekvenserne af AI i den offentlige sektor, og den understreger behovet for gennemsigtighed, ansvarlighed og robuste juridiske rammer.

Gennemsigtig og fair test af værktøjer er altafgørende

I kølvandet på de seneste juridiske udfordringer og den offentlige granskning af algoritmisk beslutningstagning i offentlige operationer er kravet om gennemsigtig testning af AI-værktøjer blevet stadig mere presserende.

For at sikre ansvarlighed, forhindre diskrimination og bevare offentlighedens tillid er det vigtigt at implementere strenge og åbne testprotokoller.

Gennemsigtig testning giver mulighed for en omfattende forståelse af, hvordan disse algoritmer fungerer, hvilke data de bruger, og hvilke beslutningsprocesser de følger. Det er afgørende for at identificere potentielle skævheder, unøjagtigheder eller diskriminerende praksis, der er indlejret i systemet.

Men strenge testprocedurer er i modstrid med AI's løfte om hurtigvirkende effektivitet.

I Storbritanniens tilfælde er premierminister Rishi Sunaks 'Pro-innovation' holdningDet giver måske ikke plads nok til omfattende testprocedurer. Desuden er der få - hvis nogen - aftalte processer for test af AI-værktøjer, før de distribueres til offentlig brug.

Dette scenarie genfindes i hele verden. Den hastigt stigende anvendelse af AI bør ikke ske på bekostning af kontrol og analyse.