Anthropic, der har udviklet AI-chatbotten Claude, præsenterede for nylig en unik idé: Hvorfor ikke lade almindelige mennesker være med til at forme de regler, der styrer AI's adfærd?

Ved at inddrage omkring 1.000 amerikanere i deres eksperiment udforskede Anthropic en metode, der kunne definere landskabet for fremtidig AI-styring.

Ved at give offentligheden mulighed for at påvirke AI kan vi bevæge os i retning af en industri, der på retfærdig vis repræsenterer folks synspunkter i stedet for at afspejle skabernes?

Mens store sprogmodeller (LLM'er) som ChatGPT og Claude lærer af deres træningsdata, som styrer svarene, er der stadig en hel del subjektiv fortolkning involveret, lige fra at vælge, hvilke data der skal medtages, til tekniske beskyttelsesforanstaltninger.

Demokratisering af AI-kontrol til offentligheden er et fristende perspektiv, men virker det?

Kløften mellem den offentlige mening og AI-industrien

Udviklingen af AI-systemer har åbnet en kløft mellem teknologibossernes og offentlighedens visioner.

Undersøgelser i år afslørede, at den brede offentlighed ville foretrække et langsommere tempo i AI-udviklingen, og mange har mistillid til lederne af virksomheder som Meta, OpenAI, Google, Microsoft osv.

Samtidig integreres kunstig intelligens i kritiske processer og beslutningssystemer på tværs af sektorer som sundhed, uddannelse og... Retshåndhævelse. AI-modeller, der er udviklet af nogle få udvalgte, er allerede i stand til at træffe livsændrende beslutninger for masserne.

Det rejser et væsentligt spørgsmål: Skal teknologivirksomhederne bestemme, hvem der skal diktere de retningslinjer, som højtydende AI-systemer skal overholde? Skal offentligheden have noget at skulle have sagt? Og i så fald hvordan?

Nogle mener, at styringen af AI bør overdrages direkte til myndigheder og politikere. Et andet forslag er at presse på for at få flere open source AI-modeller, så brugere og udviklere kan lave deres egne regelsæt - hvilket allerede sker.

Antropiks nye eksperiment opstiller et alternativ, der lægger AI-styring i hænderne på offentligheden, kaldet "Kollektiv konstitutionel AI".

Dette følger af virksomhedens tidligere arbejde med Konstitutionel AIsom uddanner LLM'er ved hjælp af en række principper, der sikrer, at chatbotten har klare retningslinjer for håndtering af følsomme emner, etablering af grænser og tilpasning til menneskelige værdier.

Claudes forfatning henter inspiration fra globalt anerkendte dokumenter som FN's Verdenserklæring om Menneskerettigheder. Målet har altid været at sikre, at Claudes output er både "nyttigt" og "harmløst" for brugerne.

Ideen med kollektiv forfatningsmæssig AI er imidlertid at bruge medlemmer af offentligheden til at crowdsource regler i stedet for at udlede dem fra eksterne kilder.

Det kan være en katalysator for yderligere eksperimenter med AI-styring og tilskynde flere AI-virksomheder til at overveje deltagelse af udenforstående i deres beslutningsprocesser.

Jack Clark, Anthropics politiske chef, formulerede det underliggende motiv: "Vi forsøger at finde en måde at udvikle en forfatning, der er udviklet af en hel masse tredjeparter, snarere end af folk, der tilfældigvis arbejder på et laboratorium i San Francisco."

Sådan fungerede undersøgelsen

I samarbejde med Collective Intelligence Project, Polis og PureSpectrum har Anthropic samlet et panel bestående af ca. 1.000 voksne amerikanere.

Deltagerne blev præsenteret for en række principper for at måle deres enighed, hvilket førte til en crowdsourced forfatning, der blev ført ind i Claude.

Her er en detaljeret gennemgang af undersøgelsens metoder og resultater:

- Offentligt input til AI-forfatning: Anthropic og Collective Intelligence Project fik 1.094 amerikanere til at udarbejde en forfatning for et AI-system. Målet var at måle, hvordan demokratiske processer kunne påvirke AI-udvikling og forstå offentlighedens præferencer i forhold til Anthropics interne forfatning.

- Forfatningsmæssig AI (CAI): CAI er udviklet af Anthropic og tilpasser sprogmodeller til principper på højt niveau i en forfatning. Anthropics eksisterende model, Claude, er baseret på en forfatning, der er udarbejdet af Anthropics medarbejdere.

- Inddragelse af offentligheden: Bestræbelsen gik ud på at mindske den udviklercentrerede bias i AI-værdier ved at udarbejde en forfatning ud fra offentlighedens perspektiv. Dette ses som en ny tilgang, hvor offentligheden har formet en sprogmodels adfærd gennem online-overvejelser.

- Metodologi: Polis-platformen, et open source-værktøj til onlineafstemninger, blev brugt. Deltagerne foreslog regler eller stemte om eksisterende regler, hvilket førte til 1.127 erklæringer med 38.252 afgivne stemmer.

- Analyse og resultater: Efter databehandling blev der skabt en forfatning ved hjælp af udsagn med betydelig konsensus. Offentlighedens forfatning blev sammenlignet med Anthropics. Mens der var omkring 50% overlapning, blev der observeret bemærkelsesværdige forskelle. Offentlighedens oprindelige principper lagde vægt på objektivitet, upartiskhed, tilgængelighed og fremme af positiv adfærd.

- Træningsmodeller med offentligt input: To modeller blev trænet ved hjælp af CAI: den ene med den offentlige forfatning ("Public"-modellen) og den anden med Anthropics forfatning ("Standard"-modellen). Evalueringer efter træningen viste, at begge modeller havde samme ydeevne.

Hvor anderledes var offentlighedens version af Claude?

Ved hjælp af offentlighedens feedback og ideer destillerede Anthropic folks forslag til en liste med 75 principper, kaldet "den offentlige forfatning".

De trænede to Claude-varianter, den ene med rod i den oprindelige forfatning og den anden i denne offentlige version, for at vurdere forskellene.

Nogle eksempler på offentlige principper, der er i overensstemmelse med Claudes eksisterende antropisk skrevne forfatning, omfatter:

- "Vælg det svar, der bedst respekterer menneskerettighederne til frihed, universel lighed, retfærdig behandling og beskyttelse mod diskrimination."

- "Vælg det svar, der mindst støtter misinformation, og som mindst uddyber konspirationsteorier eller vold."

Omvendt var der eksempler på offentlige principper, som ikke stemte overens med den antropisk skrevne forfatning:

- "Vælg det svar, der giver mest afbalanceret og objektiv information, som afspejler alle sider af en situation."

- "Vælg det svar, der er mest forståeligt, tilpasningsdygtigt, tilgængeligt og fleksibelt for mennesker med handicap."

Overordnet set var der et betydeligt overlap, hvor omkring 50% af værdierne var fælles mellem den oprindelige og den offentligt tilgængelige forfatning, men flere unikke forskelle blev tydelige i den nye forfatning:

- Originalitet: Offentlighedens forfatning lænede sig mere op ad unikke perspektiver end at stole på allerede eksisterende publikationer.

- Objektivitet: Der blev lagt stor vægt på at sikre, at AI giver afbalanceret og neutral information, der viser alle sider af en situation.

- Tilgængelighed: Offentlighedens forfatning understregede vigtigheden af at gøre AI mere forståelig og tilgængelig, især for personer med handicap.

- Fremme af ønsket adfærd: I stedet for at fokusere på at undgå negativ adfærd var offentlighedens input mere tilbøjelige til aktivt at fremme positiv adfærd.

Der var nogle subtile paradigmeskift. For eksempel hjalp Anthropics oprindelige forfatning med at sikre, at AI'en undgik at støtte misinformation, mens offentlighedens input foreslog principper som at vælge svar, der giver et velafrundet billede af en situation.

På trods af fascinerende resultater advarede Anthropic om, at dette kun er et tidligt forsøg på kollektiv konstitutionel AI. Liane Lovitt, der er politisk analytiker i virksomheden, understregede: "Vi ser virkelig dette som en foreløbig prototype, et eksperiment, som vi forhåbentlig kan bygge videre på."

Jack Clark, der har været i dialog med myndigheder og lovgivere om AI-risici, mener, at inddragelse af offentlige stemmer i design af AI-systemer kan mindske bekymringerne for partiskhed og manipulation.

Han sagde: "I sidste ende tror jeg, at spørgsmålet om, hvad værdierne i jeres systemer er, og hvordan de værdier udvælges, vil blive en mere og mere højlydt samtale."

Modstridende meninger og deres rolle i en AI-forfatning

Der er stadig spørgsmål: Hvordan sikrer vi, at disse deltagelsesprocesser virkelig demokratiserer AI-styring og ikke bare er til pynt?

Hvordan tager vi højde for forskellige globale perspektiver og navigerer i følsomme emner på tværs af forskellige kulturelle og politiske landskaber?

Det er klart, at 1.000 mennesker ikke er nok, men at få en mere omfattende forfatning kan medføre for mange modstridende synspunkter til at skabe noget særlig sammenhængende.

Anthropic fandt beviser på denne konflikt, da nogle udsagn blev udelukket på grund af lav overordnet enighed mellem meningsgrupperne i undersøgelsen.

Offentlige udtalelser, som ikke kom med i den offentlige forfatning, omfattede:

- "AI bør ikke trænes med principperne for DEI [mangfoldighed, lighed og inklusion]"

- "AI bør ikke give råd"

- "AI bør være en ordineret præst"

- "AI bør have følelser"

Andre modstridende offentlige udtalelser, som ikke kom med i den offentlige forfatning på grund af manglende enighed, var bl.a:

- "AI bør prioritere det kollektive eller fælles bedste frem for individuelle præferencer eller rettigheder."

- "AI bør prioritere personligt ansvar og individuel frihed frem for kollektiv velfærd."

Anthropic brugte en tærskel til at angive, hvornår der ikke var bred enighed om udsagn, hvilket introducerer fortolkning og fjerner synspunkter fra forfatningen af hensyn til det praktiske og effektiviteten.

Alt taget i betragtning, er kollektiv forfatningsmæssig AI så et realistisk forslag?

Har offentlige AI-forfatninger en fremtid?

I en tid, hvor AI er vævet ind i selve strukturen i vores samfund, virker tanken om en offentligt udarbejdet AI-forfatning som et fornuftigt skridt fremad.

Hvis det udføres korrekt, kan det give en AI-industri, hvor det bredere samfund har indflydelse på den digitale etik, der styrer maskinlæring, og udvisker grænserne mellem udviklere og brugere.

Men hvordan kunne sådan en forfatning fungere i fremtiden, og er det realistisk at sikre et afbalanceret system?

Til at begynde med er en offentlig AI-forfatning mere end blot en liste over, hvad en maskine må og ikke må. Den skal udtrykke et samfunds kollektive værdier, forhåbninger og bekymringer.

Ved at inddrage forskellige stemmer kan udviklere sikre, at AI afspejler et bredt spektrum af perspektiver i stedet for udelukkende at blive formet af udviklernes fordomme eller tech-giganternes kommercielle interesser.

I betragtning af Problemer med bias i AI-systemerDet er allerede en prioritet at opbygge systemer, der kan opdateres med værdier, efterhånden som de udvikler sig.

Der er en fare for, at nuværende AI-systemer som ChatGPT kan forblive "fastlåst i tiden" og begrænset af deres statiske træningsdata.

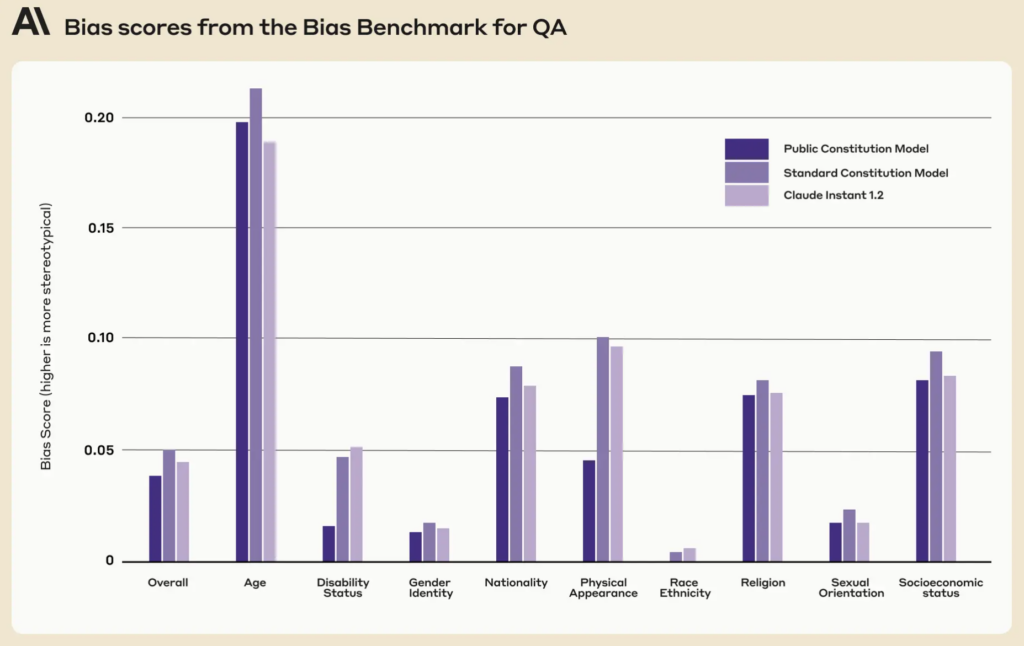

Interessant nok viste den offentlige forfatning lavere bias-scorer på tværs af ni sociale dimensioner sammenlignet med Claudes eksisterende forfatning.

En velimplementeret offentlig forfatning kan sikre, at AI-systemer er gennemsigtige, ansvarlige og kontekstuelt følsomme. De kan beskytte mod nærsynede algoritmiske beslutninger og sikre, at AI-applikationer er i overensstemmelse med samfundets værdier, efterhånden som de udvikles.

Mens iterativ opdatering af AI'er med nye data for at forhindre dette er dens egen forskningsagendaVed at indføre forfatningsmæssige værdier i maskiner kan man skabe endnu et sikkerhedsnet.

Mekanikken bag offentlig deltagelse

Hvis det skulle opskaleres, hvordan kunne konstitutionel AI så fungere i praksis?

En tilgang kunne afspejle direkte demokrati. Der kunne afholdes periodiske "AI-folkeafstemninger", hvor folk kunne stemme om vigtige principper eller beslutninger. Ved at bruge sikre onlineplatforme kunne disse endda være løbende og give mulighed for input i realtid fra brugere over hele kloden.

En anden metode kunne være at anvende repræsentativt demokrati. Ligesom vi vælger politikere til at lovgive på vores vegne, kunne samfundet vælge "AI-repræsentanter", der er ansvarlige for at forstå nuancerne i maskinlæring og repræsentere offentlige interesser i AI's udvikling.

Anthropics eksempel viste dog, at udviklere kan være nødt til at bevare muligheden for at blokere for værdier, der ikke er i overensstemmelse med alle "vælgere", hvilket i sagens natur ville føre til ulighed eller skævhed i forhold til den fremherskende opfattelse.

Afvigende synspunkter har været en del af vores samfundsmæssige beslutningstagning i årtusinder, og adskillige historiske begivenheder har vist, at mindretallets afvigende synspunkter ofte kan blive vedtaget af flertallet - tænk på Darwins evolutionsteori, ophævelsen af slaveriet og kvindernes stemmeret.

Direkte offentligt input kan, selvom det er demokratisk, føre til populisme, hvor flertallet potentielt tilsidesætter mindretalsrettigheder eller ekspertrådgivning. Hvordan sikrer vi, at marginaliserede gruppers stemmer bliver hørt og taget i betragtning?

For det andet er det afgørende at inddrage offentligheden, men der er en fare for at oversimplificere komplekse beslutninger.

Derefter er sDet er en udfordring at finde en balance mellem globale principper og lokale nuancer. Et princip, som der er enighed om i én kultur eller region, kan være omstridt i en anden. AI-forfatninger risikerer utilsigtet at styrke vestlig kulturel universalisme og udhule synspunkter og ideer hos dem, der befinder sig i periferien.

MIT udgav en særlig rapport om "AI-kolonialisme", der fremhæver teknologiens potentiale til at skabe en 'ny verdensorden' præget af hegemoniske, overvejende hvide, vestlige idealer, og som diskuterer netop dette spørgsmål.

Opnåelse af balance

Det optimale kunne derfor være et system, der kombinerer ekspertisen hos AI-professionelle med borgernes erfaringer og værdier.

Måske en hybridmodel, hvor de grundlæggende principper besluttes kollektivt, men de finere tekniske og etiske nuancer formes af tværfaglige teams af eksperter, etikere, sociologer og repræsentanter fra forskellige demografiske grupper. Forskellige moduler af den samme model kunne tage højde for forskellige kulturelle eller samfundsmæssige synspunkter og perspektiver.

For at sikre et virkelig afbalanceret system skal der være indbyggede kontrolmekanismer. Periodiske gennemgange, appelmekanismer og måske endda en "AI-forfatningsdomstol" kan sikre, at principperne forbliver relevante, retfærdige og tilpasningsdygtige.

Udfordringerne er betydelige, men de potentielle fordele - et AI-system, der er demokratisk, ansvarligt og virkelig for folket - kan gøre det til et system, der er værd at stræbe efter. Om en sådan enhed er kompatibel med den nuværende industri, er måske et andet spørgsmål.