AI gennemsyrer millioner af menneskers liv verden over, men på trods af den store udbredelse er det svært at tjene penge på teknologien på grund af de stigende omkostninger.

Generative AI-værktøjer som ChatGPT er dyre at køre og kræver avancerede servere, dyre GPU'er og omfattende supplerende hardware, der sluger masser af strøm.

Dylan Patel fra SemiAnalysis er stort set ubekræftet, men fortalte informationen at OpenAI angiveligt gafler nogle $700.000 om dagen til at køre sine modeller og havde et tab på næsten $500 millioner i 2022.

John Hennessy, formand for Googles moderselskab, Alphabet, sagde, at en enkelt prompt på Bard koster op til 10 gange mere end en Google-søgningog analytikere mener, at Google vil bruge milliarder på AI-relaterede udgifter i de kommende år.

2023 har fungeret som et testområde for AI-indtægtsgenerering. Teknologigiganter som blandt andre Microsoft, Google og Adobe forsøger sig med en lang række forskellige tilgange til at skabe, promovere og prissætte deres AI-tilbud.

De fleste kommercielle modeller som ChatGPT, Bard og Anthropics Claude 2 begrænser allerede brugerne til et vist antal forespørgsler pr. time eller dag, inklusive betalte versioner som ChatGPT Plus. Adobe sætter månedlige forbrugslofter for sine Firefly-modeller.

AI's enorme omkostninger rammer også virksomhederne. Adam Selipsky, CEO for Amazon Web Services (AWS), kommenterede de uoverkommelige omkostninger for virksomhedsbrugere, der ønsker at opbygge AI-arbejdsbelastninger: "Mange af de kunder, jeg har talt med, er utilfredse med de omkostninger, de ser for at køre nogle af disse modeller."

Chris Young, Microsofts chef for virksomhedsstrategi, bemærkede, at det stadig er tidligt for virksomheder, der ønsker at udnytte de nuværende AI-modeller, og sagde: "Det vil tage tid for virksomheder og forbrugere at forstå, hvordan de ønsker at bruge AI, og hvad de er villige til at betale for det."

Han tilføjede: "Vi er helt klart på et sted, hvor vi nu skal omsætte begejstringen og interessen til reel anvendelse."

AI-modeller vs. software

AI giver ikke den samme økonomi som konventionel software, da det kræver specifikke beregninger for hver opgave.

Når brugerne spørger en model som ChatGPT, søger den efter mønstre og sekvenser fra sine træningsdata i den neurale netværksarkitektur og udregner et specifikt svar. Hver interaktion trækker energi, hvilket fører til løbende omkostninger.

I takt med at udbredelsen vokser, stiger udgifterne også, hvilket er en udfordring for virksomheder, der tilbyder AI-tjenester til faste priser.

For eksempel har Microsoft for nylig samarbejdet med OpenAI om at introducere GitHub Copilot, som henvender sig til programmører og udviklere.

Hidtil har de høje driftsomkostninger betydet, at den ikke har været rentabel. I årets første måneder opkrævede Microsoft et abonnement på $10 om måneden for denne AI-assistent og havde et gennemsnitligt tab på mere end $20 om måneden for hver bruger. Nogle brugere pådrog sig tab på op til $80 om måneden, som det fremgår af en kilde til WSJ.

Microsofts Copilot-suite til Microsoft 365 (som til forveksling hedder det samme som GitHub-værktøjet) planlægger at opkræve $30 ekstra om måneden. Dette værktøj tilbyder funktioner som selvstændig udarbejdelse af e-mails, udarbejdelse af PowerPoint-præsentationer og oprettelse af Excel-regneark.

På samme måde er Google også klar til at frigive en AI-assistentfunktion til sine arbejdspladsværktøjer, hvilket medfører en ekstra månedlig afgift på $30 oven i de eksisterende gebyrer.

Både Microsoft og Google satser på en fast månedlig pris i håb om, at de øgede gebyrer i tilstrækkelig grad vil opveje de gennemsnitlige omkostninger ved at drive disse AI-værktøjer.

Mens $30/måned kan virke overkommeligt i nogle mere udviklede vestlige lande, omfatter disse prismodeller ikke en stor del af verdens befolkning.

Da ChatGPT Plus blev lanceret på det indiske marked, var der for eksempel mange, der klagede over, at det var alt for dyrDet koster en betydelig del af den gennemsnitlige $330-månedsløn. At udelukke milliarder af brugere fra AI kan koste udviklere dyrt, når de markedsfører værktøjer til offentligheden.

Omkostningerne er næppe heller uvæsentlige for dem, der bor i mere velhavende lande, og undersøgelser viser, at abonnementer er noget af det første, der forsvinder, når folk forsøger at reducere deres udgifter.

Hvorfor er AI så svær at tjene penge på?

AI skaber et tomrum mellem udviklernes tilsyneladende uendelige visioner og de begrænsede ressourcer, der er til rådighed for at realisere dem.

OpenAI's administrerende direktør Sam Altman hævder, at en futuristisk AI-indlejret verden simpelthen er 'uundgåelig', hvor intelligente maskiner lever ved siden af os og udfører vores opgaver, hvor mennesker lever i hundredvis af år eller udødeligt, og hvor AI'er indlejret i vores hjerner hjælper os med at udføre komplekse opgaver ved, at vi tænker alene.

Han er bestemt ikke alene om det, og Inflections CEO Mustafaya Suleman udgav for nylig sin bog "The Coming Wave", hvor han sammenligner AI med den kambriske eksplosion for 500 millioner år siden, som førte til det hurtigste udbrud i evolutionen, der nogensinde er set på vores planet.

Generativ AI vil eksplodere, og omsætningen forventes at overstige $1 billion i 2032. Fra hvor det startede, til hvor det er nu, og hvor det vil være, er overvældende ... alle brancher vil blive forandret til det bedre. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) 20. oktober 2023

Ambitioner driver ideer, men penge driver tech-industrien. Forskning i og udvikling af kunstig intelligens er dyrt, så industriledere som OpenAI, Google og Facebook investerer kraftigt for at holde sig foran i kapløbet.

AI-virksomheder tiltrak hele $94 milliarder i investeringer i 2021, og flere finansieringsrunder nåede op på $500 millioner eller mere. I 2023 blev der skruet op for indsatsen med investeringer i startups Antropisk og Bøjning passerer $1 milliarder kroner.

AI-specialister kræver store lønninger, ofte i millionklassen, på grund af hård konkurrence, og modellerne kræver regelmæssig finjustering og stresstestning, hvilket øger de løbende omkostninger.

Der er også ekstraomkostninger i forbindelse med datacentrene og vedligeholdelse, særligt kølendeDa den slags hardware bliver varm og er tilbøjelig til at gå i stykker, hvis den ikke holdes på den optimale temperatur.

Under visse omstændigheder har GPU'er en kort levetid på under fem år og kræver ofte specialiseret vedligeholdelse.

Strategier for at tjene penge på AI

I lyset af disse udfordringer, hvordan griber teknologivirksomhederne så udfordringen med at tjene penge på AI an?

Forbedring af produktiviteten

Virksomheder kan drage fordel af AI ved at øge samfundets nettoproduktivitet betydeligt. Ved at automatisere gentagne opgaver kan virksomheder lade menneskelige fagfolk fokusere på funktioner med højere værditilvækst.

Det vil hjælpe dem med at få adgang til både private og offentlige penge. For eksempel samarbejder DeepMind med National Health Service (NHS) i Storbritannien, og teknologivirksomheder arbejder sammen med regeringer om at tackle klimaforandringer.

AI-drevet produktivitet kan dog påvirke teknologivirksomhedernes andre indtægtsstrømme. For eksempel er Googles Annonceindtægterne falder, fordi AI trækker trafik væk fra søgemaskinen. I år så Googles indtægter fra YouTube-annoncer falde med 2,6%og indtægterne fra reklamenetværk falder med et hidtil uset beløb på 8,3%.

Salg af hardware

Træning og hosting af AI-modeller kræver specialiseret high-end hardware. GPU'er er uundværlige til at køre sofistikerede AI-algoritmer, hvilket gør dem til en lukrativ komponent i AI-økosystemet.

Industrilederen Nvidia er den store vinder her, med en markedsværdi på $1 billioner, men andre Producenter af AI-hardware på lavere niveau har også nydt godt af det.

Abonnementer

At tilbyde AI-forbedringer som en del af abonnementspakker er vejen frem til at generere indtægter fra offentlige brugere og virksomheder, der ikke ønsker eller har brug for at gå API-vejen.

ChatGPT Plus er den mest abonnerede AI-tjeneste på verdensplan, men der mangler oplysninger om, hvor stor en omsætning den genererer.

OpenAI lancerede sin Enterprise-variant i år for at styrke abonnementsindtægterne og erklærede, at virksomheden er på vej mod en omsætning på $1 mia. i løbet af det næste år.

API'er

Virksomheder som OpenAI bruger en token-baseret faktureringsmetode for virksomheds- og forretningsbrugere til deres API'er.

Dette system sikrer, at brugerne faktureres baseret på den faktiske beregningsbelastning af deres anmodninger, hvilket sikrer retfærdighed og gennemsigtighed.

API-prismodeller henvender sig til et bredt spektrum af brugere, fra dem, der foretager sporadiske letvægtsopkald, til tunge brugere med intensive opgaver.

AI som en iboende funktion

Nogle virksomheder integrerer AI-funktioner i deres produkter uden straks at kræve ekstra betaling. Denne strategi har til formål først at øge et produkts iboende værdi.

Når brugerne med tiden har integreret AI-funktionerne i deres arbejdsgange og indset deres værdi, er de mere tilbøjelige til at acceptere en efterfølgende prisstigning. Men AI skal levere progressive fordele, hvis omkostningerne stiger støt.

Omkostningerne til open source AI-træning bliver billigere

Der er en parallel diskussion her - hvorfor skal nogen betale for AI, når de aldrig ejer den?

Nogle - som AI-"godfather" Yann LeCun - argumenterer for, at AI bør blive en del af vores offentlige infrastruktur og understreger behovet for, at udviklere bygger open source-modeller, der er billige og nemme at få adgang til.

En NYT-artikel om debatten om, hvorvidt LLM-basismodeller skal være lukkede eller åbne.

Meta argumenterer for åbenhed, startende med udgivelsen af LLaMA (til ikke-kommerciel brug), mens OpenAI og Google ønsker at holde tingene lukkede og proprietære.

De hævder, at åbenhed kan være...

- Yann LeCun (@ylecun) 18. maj 2023

Efterhånden som AI-løsninger bliver en integreret del af virksomhederne, er der mange, der ikke har budget til at udvikle egne modeller fra bunden. Traditionelt har de henvendt sig til API'er fra nye AI-startups eller hyldesystemer.

Men efterhånden som uddannelsesomkostningerne falder, og behovet for databeskyttelse vokser, bliver samarbejde med leverandører, der specialiserer sig i at tilpasse både private og open source-modeller, mere og mere foretrukket.

Naveen Rao, CEO og medstifter af MosaicML, forklarede til The Register at open source-modeller er fristende, da de er billigere, mere fleksible og gør det muligt for virksomheder at holde arbejdsbelastninger private.

MosaicML lancerede en række open source store sprogmodeller (LLM'er) baseret på deres MPT-7B-arkitektur. I modsætning til mange andre LLM'er er denne model kommercielt levedygtig for masserne.

Rao fortalte om baggrunden for denne model og sagde: "Der er helt sikkert stor interesse for den slags, og vi gjorde det af flere grunde." Han tilføjede: "Den ene var, at vi ville have en model derude, som har tilladelse til kommerciel brug. Vi ønsker ikke at kvæle den slags innovation."

Med hensyn til overkommelige priser bemærkede Rao: "Hvis en kunde kom til os og sagde, at han skulle træne denne model, kan vi gøre det for $200.000, og vi tjener stadig penge på det."

MosaicML giver også virksomheder værktøjer til effektivt at hoste deres brugerdefinerede modeller på cloud-platforme. "Deres data deles ikke med startup-virksomheden, og de ejer modellens vægte og dens IP", bekræfter Rao.

Rao kom også ind på begrænsningerne ved kommercielle API'er og sagde: "Kommercielle API'er er et godt værktøj til at lave prototyper. Jeg tror, at med tjenester af ChatGPT-typen vil folk bruge dem til underholdning og måske nogle personlige ting, men ikke til virksomheder. Data er en meget vigtig voldgrav for virksomheder."

Rao fremhævede yderligere omkostningerne ved in-house-arkitektur og sagde: "GPU'er fejler faktisk ret ofte," "Hvis en node går ned, og der kræves en manuel indgriben, og det tog dig fem timer [at ordne], har du lige brændt $10.000 af uden at arbejde, ikke sandt?"

Han tog også fat på det truende problem med chipmangel i branchen."Vi kommer til at leve i en verden med GPU-mangel i mindst to år, måske fem."

Hvis virksomheder kan udnytte open source AI til at træne deres billige modeller med total datasuverænitet og -kontrol, så udgør det en udfordring for offentlig AI som ChatGPT.

AI's truende flaskehalse?

Ud over GPU-manglen, som Rao fremhæver, er en anden barriere for at tjene penge på AI branchens stærkt stigende energibehov.

A nylig undersøgelse forudser, at AI-industriens energiforbrug i 2027 kan svare til en lille nations.

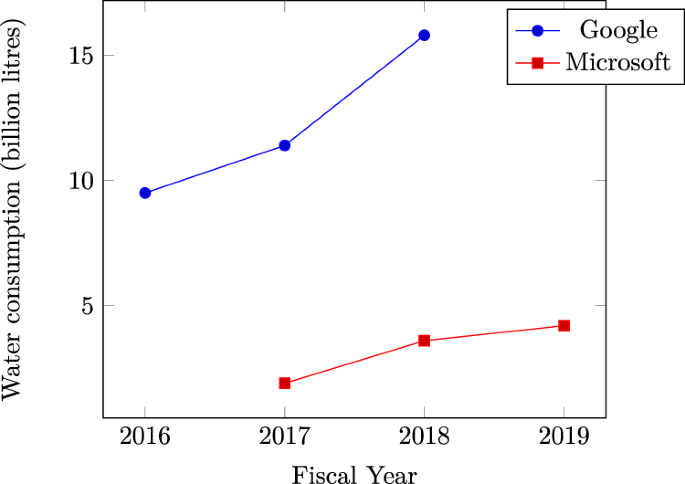

Microsofts Vandforbruget i datacentre stiger eksplosivt bekræfter AI's enorme tørst efter naturressourcer. Meget tyder på, at de seneste stigninger i vandforbruget hos tech-giganter som Microsoft og Google skyldes intensive AI-relaterede arbejdsbelastninger.

På en bredere skala overstiger den samlede energi, der bruges af datacentre, allerede 1% af det globale elforbrug, i henhold til Det Internationale Energiagentur (IEA).

Hvis energibehovet fortsætter med at stige, kan AI-virksomheder blive tvunget til at fokusere på at udvikle mere effektive tilgange til modeltræning, hvilket kan skade teknologiens udvikling på kort sigt.

Konkurrerende fortællinger

Den spirende AI-industri er stadig ung, og dens fremtidige retning er usædvanlig svær at forudsige.

Centrale personer inden for AI erkender, at deres forestillinger ikke altid stemmer overens med virkeligheden.

For eksempel indrømmede Sam Altman i Joe Rogan-podcasten, at han tog fejl med hensyn til AI's udviklingsforløb og beskrev, at vejen til at realisere meget intelligente former for AI vil være detaljeret snarere end eksplosiv.

På den ene side viser AI sig at være udfordrende at tjene penge på, hvilket skaber tvivl om, hvorvidt den indledende hype vil aftage, hvilket fører til en langsommere proces med at modne teknologien.

På den anden side har industrien måske allerede gjort tilstrækkelige fremskridt til at skubbe AI mod en "singularitet", hvor den overgår den menneskelige kognition.

Hvis menneskeheden i løbet af de næste par år opnår fremskridt på vigtige områder som energiproduktion og opbygning af AI-hardware og -arkitektur med lavt strømforbrug - og Der er sket fremskridt i år. - så kan teknologien udrydde flaskehalse på kort sigt og fortsætte sit vilde udviklingstempo.