Nvidia afslørede en opdateret version af sin Grace Hopper Superchip (GH200), som de annoncerede for 2 måneder siden. GH200 blev designet til at drive datacentre til AI-behandling i stor skala.

GH200 er ikke gået i serieproduktion endnu, men den har allerede haft en større opgradering i sin hukommelse. Den hemmelige sauce i disse nye chips er den opgraderede hukommelse med høj båndbredde kaldet HBM3e, som er i stand til at få adgang til data med 5 TB/s.

Det er en forbedring på 50% i forhold til HBM3-hukommelsen i den chip, der blev annonceret i slutningen af maj.

Nvidia har forbundet denne højhastighedshukommelse med kraftige CPU'er og GPU'er på den samme enhed. Den resulterende stigning i behandlingshastighed vil dramatisk forbedre den AI-behandlingsevne, som de nuværende datacentre har.

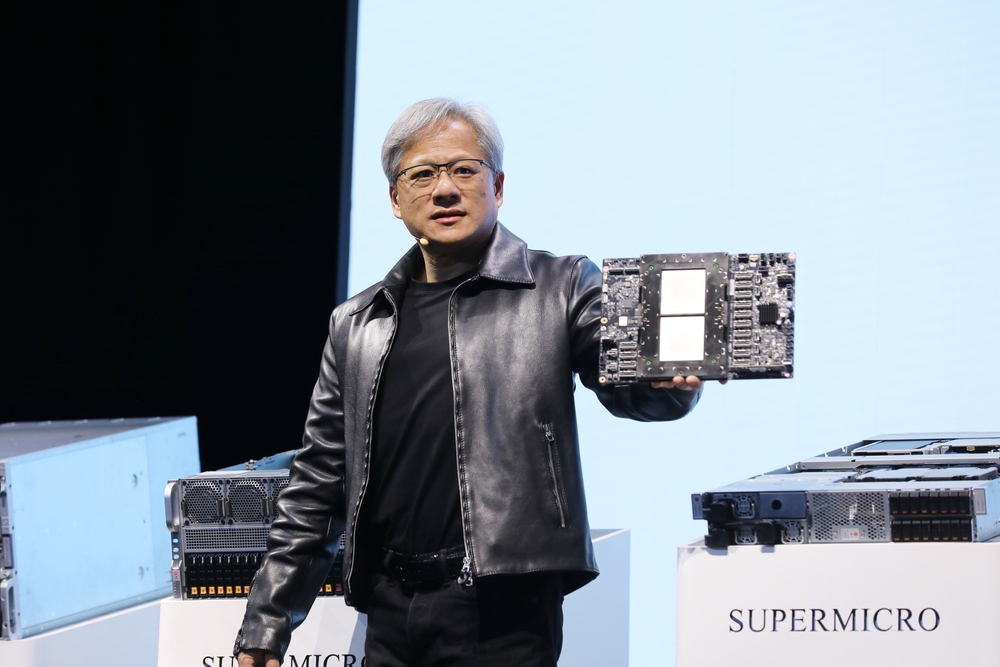

Ud over den opdaterede chip annoncerede Nvidia også GH200 Grace Hopper-platformen, som gør det muligt at forbinde to GH200-chips på et enkelt kort.

Platformen leverer otte petaflops AI-behandling og 282 GB HBM3e-hukommelse med en båndbredde på 10 TB/s.

Hvordan vil Nvidias chip ændre datacentrene?

Tallene kan være lidt svære at forstå. Så hvor stor en ting er denne nye chip og platform?

I sin præsentation brugte Nvidias CEO Jensen Huang et eksempel på et typisk datacenter med 8800 x86-processorer, der udfører en række forskellige databehandlingsfunktioner (ISO-budget).

Et datacenter som dette, der kører Llama 2 til inferens, med en vektor-database, der forespørges, og SDXL, der genererer output, vil koste dig omkring $100m og bruge 5MW strøm.

Et $100m-datacenter med 2500 GH200-platforme kunne køre de samme modeller 12 gange hurtigere og ville kun bruge 3 MW strøm.

Hvis et datacenter var fokuseret på et meget specifikt sæt opgaver (ISO-workload), bliver sammenligningen endnu mere svimlende.

Du skal kun bruge $8m på 210 GH200-enheder, der bruger 20 gange mindre energi for at matche datacenterydelsen på $100m.

Det er overflødigt at sige, at alle AI cloud computing-datacentre, der var i planlægningsfasen før denne udgivelse, skal tilbage til tegnebrættet.

GH200-chippene kommer på markedet i 2. kvartal 2024 og forventes at æde sig ind på en stor del af x86-processorforretningen. AMD's nye MI300-chip er Nvidias nærmeste rival, men dens større hukommelsesfordel ser ud til at blive udhulet af opgraderingen i den nye GH200.

De fremskridt, vi ser inden for processorteknologi, overgår alt. Moores lov og viser ingen tegn på afmatning. Generative AI-applikationer leverer allerede en imponerende ydeevne, men det ser ud til, at de bliver meget hurtigere.