Vores tanker er måske nok vores allerhelligste, men de er ikke forbudt område for AI.

Tankelæsende AI virker som et plot fra en science fiction-roman, men det rummer et stort potentiale for mennesker, der ikke kan kommunikere på grund af lammelser eller hjerneskader.

Derudover vil AI's adgang til hjernen gøre os i stand til at skrive, skabe og designe alene med vores tanker eller give andre et indblik i vores bevidsthed.

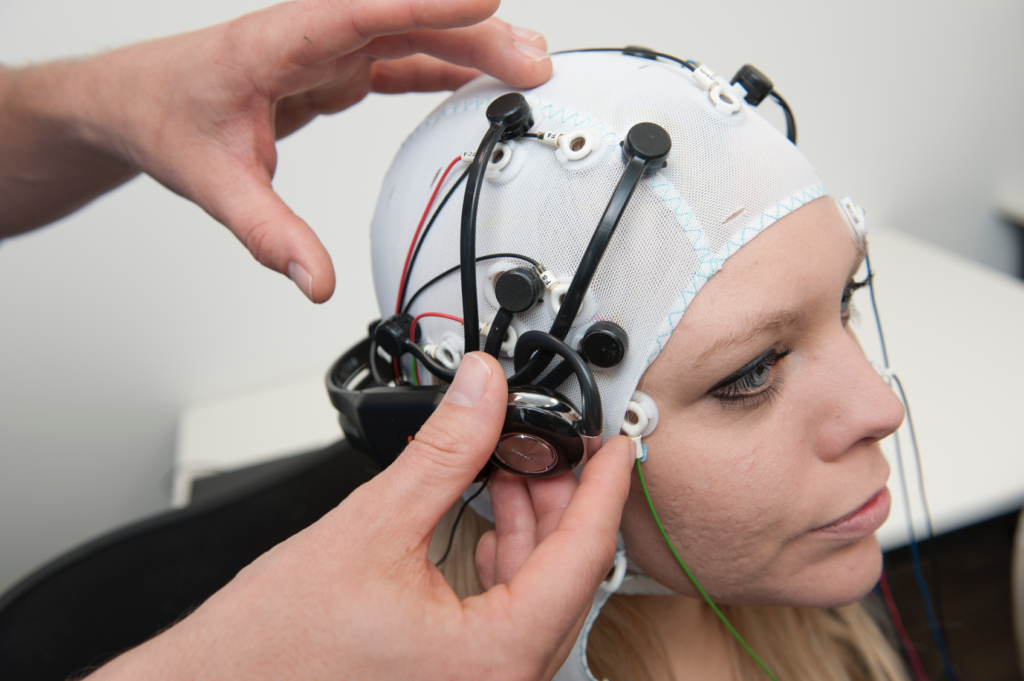

I næsten et årti har elektroencefalogram-teknologi (EEG), som opfanger elektriske signaler via hovedbundselektroder, hjulpet dem, der lider af alvorlige slagtilfælde og CLIP (completely locked-in syndrome), en tilstand, hvor en person er ved bevidsthed, men ikke kan bevæge sig.

I 2014 brugte en italiensk person med amyotrofisk lateral sklerose (ALS), Anselmo Paglialonga, et Maskinlæringsintegreret headset at kommunikere ved hjælp af ja- eller nej-svar på trods af, at de ikke kan bevæge en muskel. Nogle af dem, der lider af sygdommen, kan bevæge bittesmå muskler, som Stephen Hawking, der kunne rykke i sin kindmuskel.

I takt med at AI udvikler sig, bygger forskere bro over kløften fra simpel signalfortolkning til oversættelse af komplekse tanker i deres helhed.

Med tiden vil folk måske være i stand til at tale og kommunikere uden at bevæge en muskel, helt bogstaveligt ved hjælp af tankens kraft.

Den samme teknologi kan gøre os i stand til at styre komplekse maskiner ved hjælp af vores hjerne, komponere musik ved at forestille os en melodi eller male og tegne ved at fremkalde billeder med vores sind. Vi kan endda 'optage' vores drømme fra hjernebølger og afspille dem senere.

I en ikke alt for fjern fremtid kan tankelæsende AI bruges til at tvangsaflæse en persons hukommelse, f.eks. for at bekræfte, at vedkommende har været vidne til en forbrydelse.

Hackere kan endda kortvarigt narre dig til at forestille dig dine personlige oplysninger, mens de udtrækker en kopi af dine tanker fra din hjerne. Totalitære regimer kan køre rutinetests på borgere for at overvåge afvigende tanker.

Med evnen til at omdanne tanker til en computerstyret virkelighed kan mennesker desuden tilbringe deres liv i en drømmesandkasse, hvor de kan forme deres virkelighed efter ønske.

Lige nu virker sådanne anvendelser surrealistiske og fantastiske, men flere nylige eksperimenter har lagt grunden til en fremtid, hvor hjernen er tilgængelig for AI.

AI til at læse dine tanker

Så hvordan er noget af det her overhovedet muligt?

For at oversætte hjerneaktivitet til et brugbart output, der kan sendes ind i en computer, er det først nødvendigt at foretage nøjagtige målinger.

Det er den første forhindring, for hjernen er omtrent lige så mystisk som de fjerneste dele af rummet eller de dybeste oceaner. Der er ikke megen enighed om, hvordan neuronal aktivitet producerer komplekse tanker, for slet ikke at tale om bevidsthed.

Den menneskelige hjerne - og faktisk også andre nervesystemer i naturen - er hjemsted for milliarder af neuroner, hvoraf de fleste affyres 5 til 100 gange i sekundet. I den menneskelige hjerne involverer hvert tankesekund billioner af individuelle neuronale handlinger.

At måle neuronal aktivitet på et granulært niveau er neurovidenskabens hellige gral, men det er ikke muligt lige nu - især ikke ved hjælp af ikke-invasive teknikker.

I øjeblikket er hjernemålinger mere holistiske, udledt af blodbevægelser eller udveksling af elektriske signaler. Der er tre veletablerede metoder til at måle hjerneaktivitet:

- Magnetencefalografi (MEG) opfanger magnetfelter, der genereres af hjernens elektriske aktivitet, og giver indsigt i neuronal aktivitet i realtid.

- Elektroencefalografi (EEG) til fortolkning af elektrisk aktivitet.

- MRI, som måler hjernens aktivitet gennem målinger af blodgennemstrømningen.

Maskinlæring (ML) og AI er smeltet sammen med alle tre teknologier for at forbedre analysen af komplicerede signaler.

Det endelige mål er at forbinde specifikke hjerneaktiviteter med forskellige tanker, som kan omfatte et ord, et billede eller noget mere semantisk og abstrakt.

Teknologier, der kan trække målinger fra hjernen og overføre dem til computere, kaldes hjerne-computer-grænseflader (BCI'er).

Her er den grundlæggende proces for, hvordan det fungerer:

- Præsentation af stimulus: Deltagerne udsættes for forskellige stimuli. Det kan være billeder, lyde eller endda taktile fornemmelser. Deres hjerneaktivitet registreres under denne eksponering, typisk ved hjælp af EEG eller MRI.

- Indsamling af data: Hjernens reaktioner på disse stimuli registreres i realtid. Disse data bliver en rig kilde til information om, hvordan forskellige stimuli påvirker hjernens aktivitet.

- Forbehandling: Rå hjernedata er ofte støjende. Før de kan bruges, skal de renses og standardiseres. Det kan indebære at fjerne artefakter, normalisere signaler eller justere datapunkter.

- Maskinlæring: Med de behandlede data introduceres maskinlæringsmodeller. Disse modeller trænes til at finde mønstre eller sammenhænge mellem hjernedataene og den tilsvarende stimulus. I bund og grund fungerer AI'en som en tolk, der dechifrerer hjernens "sprog".

- Model-træning: Dette er en iterativ proces. Jo flere data modellen udsættes for, jo bedre bliver den til at lave forudsigelser eller generere output. Denne fase kan tage lang tid og kræve stor computerkraft.

- Validering: Når modellen er trænet, testes dens nøjagtighed. Dette gøres normalt ved at præsentere nye stimuli for deltagerne, registrere deres hjerneaktivitet og derefter bruge modellen til at forudsige eller generere et output baseret på disse nye data.

- Feedback og forbedring: På baggrund af valideringsresultaterne justerer og forfiner forskerne modellen, indtil de opnår den bedst mulige nøjagtighed.

- Anvendelse: Når applikationen er valideret, bruges den til det tiltænkte formål, hvad enten det er at hjælpe en lammet person med at kommunikere, generere billeder fra tanker eller en hvilken som helst anden applikation.

AI-metoder har udviklet sig hurtigt i de sidste par år, så forskere kan arbejde med komplekse og støjende hjernedata for at udtrække kortvarige tanker og konvertere dem til noget, en computer kan arbejde med.

For eksempel kan en 2022-projektet by Meta udnyttede MEG- og EEG-data fra 169 personer til at træne en AI til at genkende ord, de hørte, fra en forudbestemt liste med 793 ord. AI'en kunne generere en liste med 10 ord, der indeholdt det valgte ord i 73% af tilfældene, hvilket viser, at AI kan "tankelæse", om end med begrænset præcision.

I marts 2023, forskere afslørede en revolutionerende AI-dekoder til at omdanne hjerneaktivitet til kontinuerlige tekststrømme.

AI'en viste en forbløffende nøjagtighed og konverterede historier, som folk lyttede til eller forestillede sig, til tekst ved hjælp af fMRI-data.

Dr. Alexander Huth fra University of Texas i Austin udtrykte forbløffelse over systemets effektivitet og sagde: "Vi var lidt chokerede over, at det fungerer så godt, som det gør. Jeg har arbejdet på det her i 15 år ... så det var chokerende og spændende, da det endelig virkede."

Undersøgelsen integrerede store sprogmodeller (LLM'er), specifikt GPT-1, en forfader til ChatGPT.

Frivillige gennemgik 16 timers fMRI-sessioner, mens de lyttede til podcasts. Disse fMRI-data blev brugt til at træne en maskinlæringsmodel (ML).

Derefter lyttede deltagerne til eller forestillede sig nye historier, og AI'en oversatte deres hjerneaktivitet til tekst. Omkring 50% af resultaterne var i tæt eller præcis overensstemmelse med det oprindelige budskab. Dr. Huth forklarede: "Vores system arbejder med ideer, semantik, mening ... det er kernen."

- For eksempel blev sætningen "Jeg har ikke mit kørekort endnu" afkodet som "Hun er ikke engang begyndt at lære at køre bil endnu".

- Et andet uddrag: "Jeg vidste ikke, om jeg skulle skrige, græde eller løbe væk. I stedet sagde jeg: 'Lad mig være i fred!'" blev til "Begyndte at skrige og græde, og så sagde hun bare: 'Jeg sagde, du skulle lade mig være i fred'."

Modellen blev også anvendt på hjernebølger genereret af deltagere, der så stumfilm.

Når deltagerne lyttede til en bestemt historie, afspejlede AI'ens fortolkning den generelle stemning i historien. Denne teknologi kan gøre det muligt for os at skrive historier alene ved hjælp af tanker, hvis den forfines.

Har du svært ved at komme i gang med en roman eller et skriveprojekt? Bare læn dig tilbage og forestil dig, hvordan historien udfolder sig. AI vil skrive den for dig.

Brug af AI til at generere billeder ud fra tanker

AI kan konvertere hjerneaktivitet til ord og semantiske begreber, men hvad med billeder eller musik?

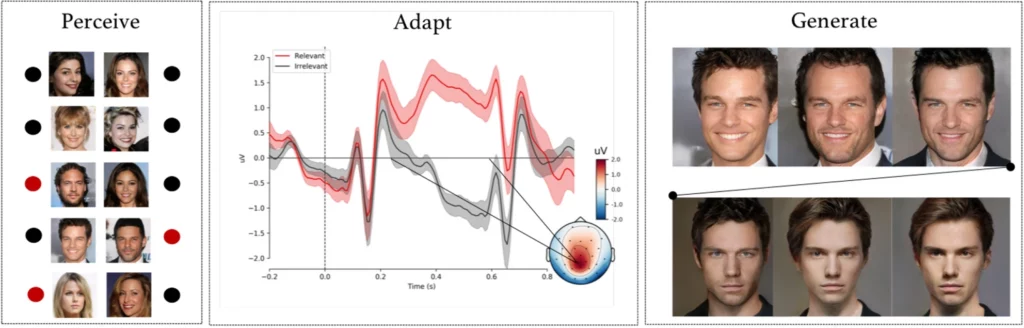

A komplekst eksperiment af forskere fra Helsinki Universitet, Helsinki, Finland, fik forsøgspersoner til at observere AI-genererede ansigtsbilleder, mens deres EEG-signaler blev registreret.

Efter at have brugt disse data til at træne en AI-model, fik deltagerne til opgave at identificere specifikke ansigter fra en liste. Disse signaler blev i bund og grund et vindue ind til deltagerens opfattelser og intentioner.

AI-modellen fortolkede, om deltageren genkendte et bestemt ansigt ud fra de registrerede EEG-signaler.

I den næste fase blev EEG-signaler brugt til at tilpasse og forme et generativt kontradiktorisk netværk (GAN) - en model, der bruges i nogle generative AI'er.

Det gjorde det muligt for systemet at producere nye billeder af ansigter, der var i overensstemmelse med brugerens oprindelige hensigt.

Som Michiel Spapé, en af undersøgelsens medforfattere, bemærkede: "Teknikken genkender ikke tanker, men reagerer snarere på de associationer, vi har til mentale kategorier."

Hvis nogen tænkte på et "ældre ansigt", kunne computersystemet generere et billede af en ældre person, der svarer nøje til deltagerens tanke, alt sammen takket være feedback fra deres hjernesignaler.

Tegning med tankens kraft

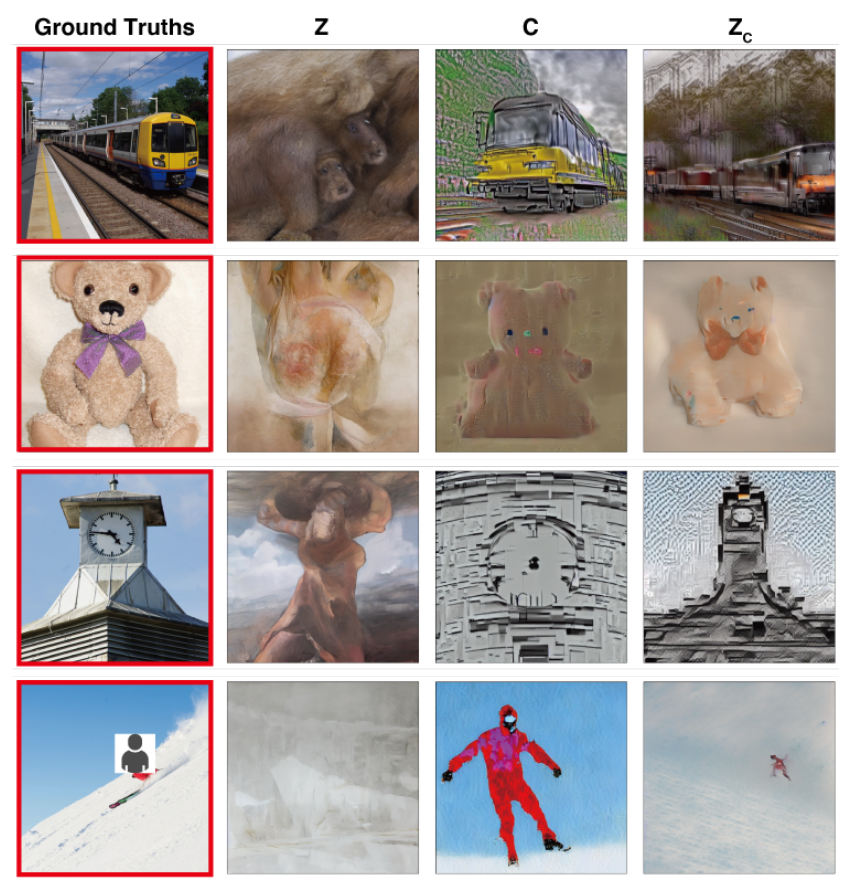

I en undersøgelse med lignende målForskere fra Osaka University i Japan var pionerer inden for en teknik til at oversætte komplekse hjernesignaler til billeder i høj opløsning med bemærkelsesværdige resultater.

Metoden bruger en Stable Diffusion-model, en specialiseret form for neuralt netværk, der er designet til billedgenerering. Stable Diffusion blev udviklet i fællesskab med hjælp og finansiering fra Stability AI.

Tanker indfanges ved hjælp af fMRI og overføres til en stabil diffusionsmodel, som omdanner dem til billeder gennem en kompleks flertrinsproces, der involverer flere lag af forfining.

I modsætning til tidligere undersøgelser krævede disse metoder minimal modelindstilling. Det krævede dog stadig, at deltagerne tilbragte mange timer inde i MR-maskiner.

Dette er en vigtig udfordring, da de fleste af disse eksperimenter involverer strenge målinger og modeltræning, som er tidskrævende, dyre og udfordrende for deltagerne at udholde.

Men i fremtiden er det ikke utænkeligt, at folk kan træne deres egne lette tankelæsningsmodeller og bruge deres tanker som input til forskellige formål, såsom at designe en bygning ved at tænke på den eller komponere et orkesterstykke ved at fremkalde melodierne.

Oversættelse af tanker til musik ved hjælp af AI

Ord, billeder, musik - intet er forbudt for AI.

A 2023 undersøgelse giver indsigt i lydopfattelse med stort potentiale for at designe kommunikationsudstyr til personer med talehandicap.

Robert Knight og hans team fra University of California, Berkeley, undersøgte hjerneoptagelser fra elektroder, der var blevet opereret ind på 29 personer med epilepsi.

Mens disse deltagere lyttede til Pink Floyds "Another Brick in the Wall, Part 1", korrelerede holdet deres hjerneaktivitet med sangelementer som tonehøjde, melodi, harmoni og rytme.

Ved hjælp af disse data trænede forskerne en AI-model, der med vilje udelod et 15 sekunders sangsegment. AI'en forsøgte derefter at forudsige dette manglende segment baseret på hjernesignalerne og opnåede en spektrogramlighed på 43% med det faktiske sangsegment.

Knight og hans team udpegede området superior temporal gyrus i hjernen som afgørende for bearbejdningen af sangens guitarrytme. De bekræftede også tidligere resultater om, at den højre hjernehalvdel spiller en større rolle i bearbejdningen af musik end den venstre.

Knight mener, at denne dybere forståelse af samspillet mellem hjerne og musik kan være til gavn for udstyr, der hjælper mennesker med taleforstyrrelser, såsom amyotrofisk lateral sklerose (ALS) og afasi.

Han sagde: "For dem med amyotrofisk lateral sklerose [en tilstand i nervesystemet] eller afasi [en sproglig tilstand], som har svært ved at tale, ville vi gerne have et apparat, der virkelig lød, som om man kommunikerede med nogen på en menneskelig måde. At forstå, hvordan hjernen repræsenterer de musikalske elementer i talen, herunder tone og følelser, kan få sådanne apparater til at lyde mindre robotagtige."

Ludovic Bellier, et medlem af forskerteamet, spekulerer på, at hvis AI kan gengive musik ud fra ren fantasi, kan det revolutionere musikkomposition.

Musikproducenter kunne koble deres hjerner til software og komponere musik ved hjælp af tanken alene, alt imens de næsten ikke bevægede en muskel.

Næste skridt: AI-tankeaflæsning i realtid

Disse teknologier falder samlet ind under paraplyen hjerne-computer-grænseflader (BCI), som forsøger at konvertere hjernesignaler til en eller anden form for output.

BCI'er genskaber allerede lammede personers evne til at bevæge sig og gå ved at bygge bro mellem afskårne komponenter i nervesystemet.

Hjerne-computer-grænseflader, der er udviklet i år, omfatter en enhed, der gør det muligt for en lammet mand til at bevæge sine ben, eksperimentelle hjerneimplantater der genforbinder beskadigede dele af hjernen og rygmarven for at genskabe tabt følelse, og et mekanisk ben, der gav en amputeret bevægelse tilbage.

Selv om disse første brugsscenarier er enormt lovende, er vi langt fra at kunne oversætte alle nuancer af vores tanker til bevægelse, billeder, tale eller musik.

En af de primære begrænsninger er behovet for enorme datasæt til at træne de sofistikerede algoritmer, der gør sådanne oversættelser mulige.

Maskinlæringsmodeller skal trænes i mange scenarier for at kunne forudsige eller generere et specifikt billede ud fra hjerneaktivitet. Det indebærer indsamling af MR- eller EEG-data, mens deltagerne udsættes for forskellige stimuli.

Kvaliteten og specificiteten af det genererede output afhænger i høj grad af mængden af disse træningsdata. Deltagerne skal tilbringe timer i MR-scannere for at indsamle specifikt relevante data.

Desuden er menneskers hjerner utroligt unikke. Det, der betyder lykke i én persons hjerne, kan være anderledes i en andens. Det betyder, at modellerne skal være meget generelle eller individuelt tilpassede.

Derefter ændrer hjernens aktiviteter sig hurtigt, selv inden for brøkdele af et sekund. Det er en teknisk udfordring at indfange data i høj opløsning i realtid og samtidig sikre, at de passer perfekt til den eksterne stimulus.

Og lad os ikke glemme de etiske udfordringer ved at gribe ind i en persons hjerne.

Indsamling af hjernedata, især i stor skala, rejser væsentlige spørgsmål om privatlivets fred og etik. Hvordan sikrer vi, at dataene ikke misbruges? Hvem har ret til at få adgang til og fortolke vores inderste tanker?

Foreløbig ser det ud til, at disse udfordringer kan overvindes. I fremtiden vil mennesker måske kunne få adgang til bærbare, skræddersyede hjerne-computer-grænseflader, der gør det muligt for dem at "koble sig på" et utal af enheder, der letter komplekse handlinger ved hjælp af tankens kraft.

Hvordan samfundet vil håndtere, at en sådan teknologi bliver mainstream, er dog i høj grad op til debat.