Våra tankar må vara vårt innersta sanctum, men de är inte förbjudna för AI.

Tankeläsande AI är som hämtat ur en science fiction-roman, men det är en mycket lovande lösning för människor som inte kan kommunicera på grund av förlamning eller hjärnskador.

Utöver det skulle AI:s tillgång till hjärnan göra det möjligt för oss att skriva, skapa och designa med enbart tankar eller ge andra fönster in i vårt medvetande.

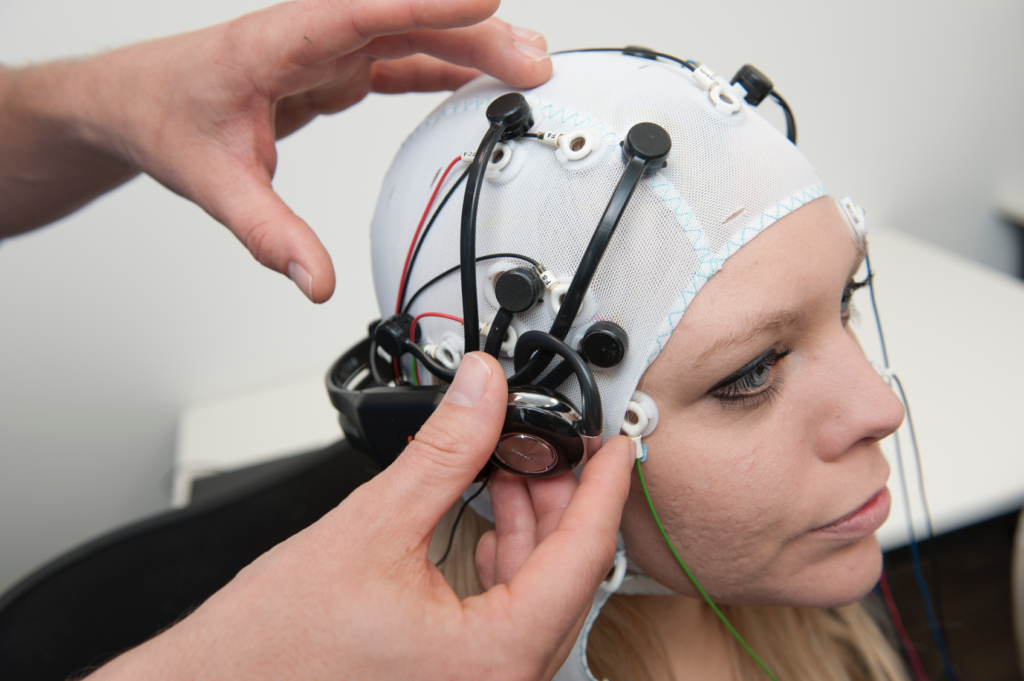

I nästan ett decennium har EEG-teknik (elektroencefalogram), som fångar upp elektriska signaler via skalpelektroder, varit ett stöd för personer som drabbats av svåra stroke och CLIP (completely locked-in syndrome), ett tillstånd där någon är vid medvetande men orörlig.

År 2014 använde en italiensk person som lider av amyotrofisk lateralskleros (ALS), Anselmo Paglialonga, en headset integrerat med maskininlärning att kommunicera med ja- eller nej-svar trots att han inte kan röra en muskel. Vissa personer som lider av sjukdomen kan röra små muskler, som Stephen Hawking, som kunde rycka i sin kindmuskel.

I takt med att AI utvecklas överbryggar forskarna klyftan från enkel tolkning av signaler till att översätta komplexa tankar i sin helhet.

Med tiden kommer människor kanske att kunna tala och kommunicera utan att röra en muskel, bokstavligen genom tankens kraft.

Samma teknik skulle kunna göra det möjligt för oss att styra komplexa maskiner med hjälp av våra hjärnor, komponera musik genom att föreställa oss en melodi eller måla och teckna genom att frammana bilder med våra sinnen. Vi skulle till och med kunna "spela in" våra drömmar från hjärnvågorna och spela upp dem senare.

I en inte alltför avlägsen framtid kan tankeläsande AI användas för att med tvång läsa någons minnen, till exempel för att verifiera att de har vittnat om ett brott.

Hackare kan till och med kortvarigt lura dig att föreställa dig din personliga information samtidigt som de extraherar en kopia av dina tankar från din hjärna. Totalitära regimer skulle kunna utföra rutinmässiga tester på medborgare för att övervaka avvikande tankar.

Med förmågan att omvandla tankar till en datoriserad verklighet skulle människor dessutom kunna tillbringa sina liv i en sandlåda med drömlandskap där de kan forma sina verkligheter efter behag.

Just nu verkar sådana tillämpningar surrealistiska och fantastiska, men flera experiment har nyligen lagt grunden för en framtid där hjärnan är tillgänglig för AI.

AI läser dina tankar

Så, hur är något av detta ens möjligt?

För att översätta hjärnans aktivitet till ett användbart resultat som kan överföras till en dator måste man först göra noggranna mätningar.

Det är det första hindret, eftersom hjärnan är ungefär lika mystisk som de yttersta delarna av rymden eller de djupaste oceanerna. Det finns inte mycket konsensus om hur neuronal aktivitet producerar komplexa tankar, för att inte tala om medvetande.

I människans hjärna - och i andra nervsystem i naturen - finns miljarder nervceller, varav de flesta avfyras 5-100 gånger per sekund. I den mänskliga hjärnan involverar varje sekund av tanke triljoner av individuella neuronala handlingar.

Att mäta nervcellernas aktivitet på detaljnivå är den heliga gralen för neurovetenskapen, men det är inte möjligt just nu - särskilt inte med icke-invasiva tekniker.

För närvarande är mätningar av hjärnan mer holistiska, extraherade från blodrörelser eller utbyten av elektriska signaler. Det finns tre väletablerade metoder för att mäta hjärnans aktivitet:

- Magnetencefalografi (MEG) fångar upp magnetfält som genereras av hjärnans elektriska aktivitet och ger insikter om neuronal aktivitet i realtid.

- Elektroencefalografi (EEG) för tolkning av elektrisk aktivitet.

- MRI, som mäter hjärnans aktivitet genom mätning av blodflödet.

Maskininlärning (ML) och AI har slagits samman med alla tre teknikerna för att förbättra analysen av invecklade signaler.

Det slutliga målet är att associera specifika hjärnaktiviteter med distinkta tankar, som kan inkludera ett ord, en bild eller något mer semantiskt och abstrakt.

Teknik som kan hämta mätvärden från hjärnan och överföra dem till datorer kallas BCI (brain-computer interfaces).

Här är den grundläggande processen för hur detta fungerar:

- Presentation av stimulus: Deltagarna utsätts för olika stimuli. Det kan vara bilder, ljud eller till och med taktila förnimmelser. Deras hjärnaktivitet registreras under denna exponering, vanligtvis genom EEG eller MRT.

- Insamling av data: Hjärnans svar på dessa stimuli registreras i realtid. Dessa data blir en rik källa till information om hur olika stimuli påverkar hjärnans aktivitet.

- Förbehandling: Rådata från hjärnan är ofta brusiga. Innan de kan användas måste de rensas och standardiseras. Detta kan innebära att artefakter tas bort, signaler normaliseras eller datapunkter justeras.

- Maskininlärning: Med de bearbetade uppgifterna introduceras maskininlärningsmodeller. Dessa modeller tränas i att hitta mönster eller korrelationer mellan hjärndata och motsvarande stimulus. I grund och botten fungerar AI som en tolk som dechiffrerar hjärnans "språk".

- Modellutbildning: Detta är en iterativ process. Ju mer data modellen utsätts för, desto bättre blir den på att göra förutsägelser eller generera utdata. Denna fas kan ta betydande tid och datorkraft i anspråk.

- Validering: När modellen har tränats testas dess noggrannhet. Detta görs vanligtvis genom att presentera nya stimuli för deltagarna, registrera deras hjärnaktivitet och sedan använda modellen för att förutsäga eller generera en utgång baserat på dessa nya data.

- Återkoppling och förfining: Baserat på valideringsresultaten finjusterar och förfinar forskarna modellen tills de uppnår bästa möjliga noggrannhet.

- Tillämpning: När applikationen har validerats används den för sitt avsedda ändamål, oavsett om det handlar om att hjälpa en förlamad person att kommunicera, generera bilder från tankar eller någon annan applikation.

AI-metoder har utvecklats snabbt under de senaste åren och gör det möjligt för forskare att arbeta med komplexa och bullriga hjärndata för att extrahera övergående tankar och omvandla dem till något som en dator kan arbeta med.

Till exempel kan en Projekt 2022 by Meta utnyttjade MEG- och EEG-data från 169 individer för att träna en AI att känna igen ord som de hörde från en förutbestämd lista med 793 ord. AI:n kunde generera en 10-ordslista som innehöll det valda ordet 73% av tiden, vilket bevisar hur AI kan "tankeläsa", om än med begränsad precision.

I mars 2023, forskare presenterade en revolutionerande AI-avkodare för att omvandla hjärnaktivitet till kontinuerliga textströmmar.

AI:n uppvisade en häpnadsväckande träffsäkerhet och omvandlade berättelser som människor lyssnat på eller föreställt sig till text med hjälp av fMRI-data.

Dr Alexander Huth, från University of Texas i Austin, uttryckte förvåning över systemets effektivitet och sa: "Vi blev lite chockade över att det fungerar så bra som det gör. Jag har jobbat med det här i 15 år ... så det var både chockerande och spännande när det äntligen fungerade."

I studien integrerades stora språkmodeller (LLM), särskilt GPT-1, en föregångare till ChatGPT.

Volontärer genomgick 16-timmars fMRI-sessioner medan de lyssnade på podcasts. Dessa fMRI-data användes för att träna en maskininlärningsmodell (ML).

Därefter lyssnade deltagarna på eller föreställde sig nya berättelser och AI:n översatte deras hjärnaktivitet till text. Cirka 50% av resultaten var i nära eller exakt linje med det ursprungliga meddelandet. Dr Huth förklarade: "Vårt system arbetar på idé-, semantik- och betydelsenivå... det är kärnan."

- Till exempel avkodades frasen "Jag har inte tagit körkort än" som "Hon har inte ens börjat lära sig köra bil än".

- Ett annat utdrag: "Jag visste inte om jag skulle skrika, gråta eller springa iväg. Istället sa jag: 'Lämna mig ifred!'" blev "Började skrika och gråta, och sedan sa hon bara: 'Jag sa ju åt dig att lämna mig ifred'."

Modellen tillämpades också på hjärnvågor som genererades av deltagare som tittade på stumfilmer.

När deltagarna lyssnade på en viss berättelse speglade AI:ns tolkning den allmänna känslan i berättelsen. Om tekniken förfinas kan den göra det möjligt för oss att skriva berättelser enbart med hjälp av tankar.

Kämpar du med att komma igång med en roman eller ett skrivprojekt? Luta dig bara tillbaka och föreställ dig hur handlingen utspelar sig. AI kommer att skriva den åt dig.

Använda AI för att generera bilder från tankar

AI kan omvandla hjärnaktivitet till ord och semantiska begrepp, men hur är det med bilder eller musik?

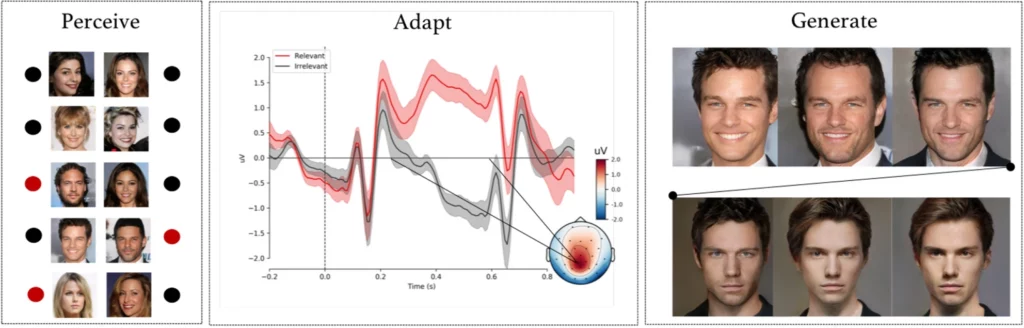

A komplext experiment av forskare från Helsingfors universitet, Helsingfors, Finland, fick försökspersoner observera AI-genererade ansiktsbilder medan deras EEG-signaler registrerades.

Efter att ha använt dessa data för att träna en AI-modell fick deltagarna i uppgift att identifiera specifika ansikten från en lista. Dessa signaler blev i princip ett fönster in till deltagarens uppfattningar och avsikter.

AI-modellen tolkade om deltagaren kände igen ett visst ansikte baserat på de inspelade EEG-signalerna.

I nästa fas användes EEG-signaler för att anpassa och forma ett generativt adversarialnätverk (GAN) - en modell som används i vissa generativa AI-system.

På så sätt kunde systemet producera nya bilder av ansikten som överensstämde med användarens ursprungliga avsikt.

Som Michiel Spapé, en av medförfattarna till studien, påpekade: "Tekniken känner inte igen tankar, utan reagerar snarare på de associationer vi har till mentala kategorier."

Om någon tänker på ett "äldre ansikte" kan datorsystemet generera en bild av en äldre person som stämmer väl överens med deltagarens tanke, allt tack vare feedback från deltagarens hjärnsignaler.

Ritning med krafttanken

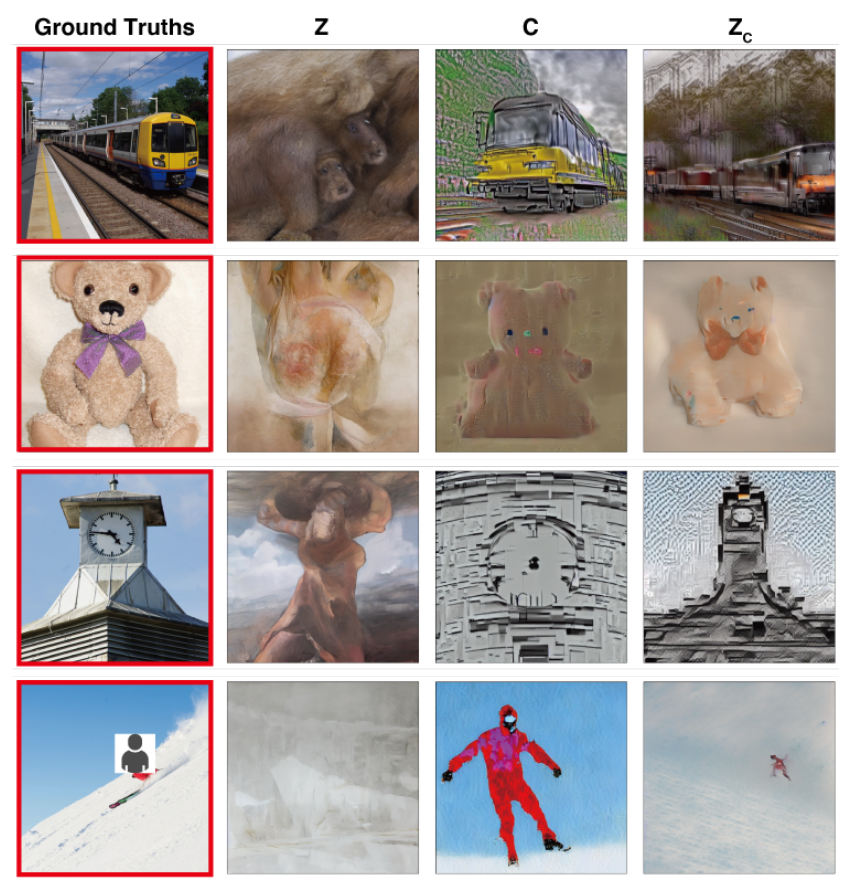

I en studie med liknande målForskare från Osaka University i Japan har utvecklat en teknik för att översätta komplexa cerebrala signaler till högupplösta bilder med anmärkningsvärda resultat.

Metoden använder sig av en Stable Diffusion-modell, en specialiserad form av neuralt nätverk som är utformat för bildgenerering. Stable Diffusion har utvecklats med hjälp och finansiering från Stability AI.

Tankarna fångas upp med hjälp av fMRI och överförs till en Stable Diffusion-modell, som omvandlar dem till bilder genom en komplex flerstegsprocess som omfattar flera lager av förfining.

Till skillnad från tidigare studier krävde dessa metoder minimal modelljustering. Det krävdes dock fortfarande att deltagarna tillbringade många timmar i MR-maskiner.

Detta är en viktig utmaning, eftersom de flesta av dessa experiment omfattar rigorösa mätningar och modellutbildning som är tidskrävande, dyr och utmanande för deltagarna att uthärda.

I framtiden är det dock inte omöjligt att människor kan träna upp sina egna lätta tankeläsningsmodeller och använda sina tankar som input för olika ändamål, t.ex. att designa en byggnad genom att tänka på den eller komponera ett orkesterstycke genom att frammana melodierna.

Översättning av tankar till musik med hjälp av AI

Ord, bilder, musik - ingenting är förbjudet för AI.

A 2023 studie ger insikter i hur ljud uppfattas, med stor potential för att utforma kommunikationsutrustning för personer med talsvårigheter.

Robert Knight och hans team från University of California, Berkeley, undersökte hjärninspelningar från elektroder som opererats in på 29 personer med epilepsi.

Medan dessa deltagare lyssnade på Pink Floyds "Another Brick in the Wall, Part 1", korrelerade teamet deras hjärnaktivitet med sångelement som tonhöjd, melodi, harmoni och rytm.

Med hjälp av dessa data tränade forskarna en AI-modell, där de avsiktligt utelämnade ett 15 sekunder långt sångsegment. AI:n försökte sedan förutsäga det saknade segmentet baserat på hjärnsignalerna och uppnådde en spektrogramlikhet på 43% med det faktiska låtsegmentet.

Knight och hans team pekade ut det övre temporala gyrusområdet i hjärnan som avgörande för att bearbeta låtens gitarrytm. De bekräftade också tidigare resultat om att den högra hjärnhalvan spelar en viktigare roll i musikbearbetningen än den vänstra.

Knight tror att denna djupare förståelse av samspelet mellan hjärna och musik kan komma att gynna utrustning som hjälper personer med talsvårigheter, såsom amyotrofisk lateral skleros (ALS) och afasi.

Han sa: "För personer med amyotrofisk lateralskleros [ett tillstånd i nervsystemet] eller afasi [ett språkligt tillstånd], som har svårt att tala, skulle vi vilja ha en apparat som verkligen låter som om man kommunicerar med någon på ett mänskligt sätt. Genom att förstå hur hjärnan representerar de musikaliska elementen i talet, inklusive ton och känsla, skulle sådana apparater kunna låta mindre robotaktiga."

Ludovic Bellier, en av medlemmarna i forskargruppen, spekulerar i att om AI kan återskapa musik från bara fantasin skulle det kunna revolutionera musikskapandet.

Musikproducenter kunde koppla upp sina hjärnor till programvara och komponera musik enbart med hjälp av tanken, samtidigt som de knappt rörde en muskel.

Nästa steg: AI-tankeavläsning i realtid

Dessa teknologier faller under paraplyet BCI (brain-computer interfaces), som syftar till att omvandla hjärnans signaler till någon form av utdata.

BCI återställer redan förlamade individers förmåga att röra sig och gå genom att överbrygga klyftan mellan skadade delar av nervsystemet.

Hjärna-dator-gränssnitt som utvecklats i år inkluderar en enhet som gör det möjligt för en förlamad man att röra på benen, experimentella hjärnimplantat som återkopplar skadade delar av hjärnan och ryggmärgen för att återställa förlorad känsel, och ett mekaniskt ben som återställde rörelseförmågan hos en amputerad.

Även om dessa första användningsområden är mycket lovande är vi långt ifrån att sömlöst översätta varje nyans av våra tankar till rörelser, bilder, tal eller musik.

En av de främsta begränsningarna är behovet av enorma datamängder för att träna de sofistikerade algoritmer som gör sådana översättningar möjliga.

Maskininlärningsmodeller måste tränas på många scenarier för att kunna förutsäga eller generera en specifik bild från hjärnaktivitet på ett korrekt sätt. Detta innebär att man samlar in MR- eller EEG-data medan deltagarna utsätts för olika stimuli.

Kvaliteten och specificiteten på de resultat som genereras är starkt beroende av hur omfattande dessa utbildningsdata är. Deltagarna måste tillbringa timmar i MR-scanners för att samla in specifikt relevanta data.

Dessutom är människors hjärnor otroligt unika. Vad som betyder lycka i en persons hjärna kan skilja sig åt i en annans. Detta innebär att modellerna måste vara allmänt hållna eller individuellt anpassade.

Sedan förändras hjärnans aktiviteter snabbt, till och med inom bråkdelar av en sekund. Det är en teknisk utmaning att fånga högupplösta data i realtid och samtidigt se till att de stämmer perfekt överens med den externa stimulansen.

Och låt oss inte glömma de etiska utmaningarna med att nå in i någons hjärna.

Insamling av hjärndata, särskilt i stor skala, väcker viktiga frågor om integritet och etik. Hur säkerställer vi att uppgifterna inte missbrukas? Vem har rätt att få tillgång till och tolka våra innersta tankar?

Preliminärt verkar det som om dessa utmaningar kan övervinnas. I framtiden kanske människor kan få tillgång till bärbara, skräddarsydda hjärn-datorgränssnitt som gör det möjligt för dem att "koppla in sig" på en mängd olika enheter som underlättar komplexa handlingar genom tankens kraft.

Hur samhället skulle hantera att sådan teknik blir mainstream är dock en fråga som i högsta grad är uppe till diskussion.