Расследование The Guardian пролило свет на повсеместное использование в Великобритании искусственного интеллекта и сложных алгоритмов в различных процессах принятия решений в государственном секторе.

Государственные служащие как минимум восьми департаментов государственного сектора, а также несколько полицейских подразделений внедрили инструменты искусственного интеллекта в свой рабочий процесс.

Инструменты искусственного интеллекта помогают принимать важнейшие решения в таких областях, как социальное обеспечение, иммиграция и уголовное правосудие. В ходе расследования были выявлены факты злоупотреблений и дискриминации.

Хотя алгоритмическая предвзятость и предвзятость, связанная с искусственным интеллектом, не подпадают под одно и то же определение, они оба рискуют получить необъективные результаты при столкновении с реальными сценариями. Самообучающиеся модели машинного обучения могут усиливать смещения, преобладающие в наборах данных.

Согласно отчет:

- Один из членов парламента выразил обеспокоенность алгоритмом, используемым Департаментом по труду и пенсиям (DWP), который, как предполагается, привел к тому, что многие люди лишились своих пособий по ошибке.

- Оказалось, что инструмент распознавания лиц, разработанный столичной полицией, при определенных условиях допускает больше ошибок при идентификации черных лиц по сравнению с белыми. Это хорошо известно, и одно исследование указывая, что в 2018 году точность этих платформ составляла всего 2%.

- Министерство внутренних дел использовало алгоритм, который непропорционально нацелен на лиц определенных национальностей, чтобы выявить мошеннические браки для получения пособий и налоговых льгот. Граждане Албании, Греции, Румынии и Болгарии могли быть несправедливо отмечены.

Инструменты искусственного интеллекта изучают закономерности на основе обширных наборов данных. Если наборы данных необъективны или плохо отражают реальность, модель наследует эти закономерности.

В мире существует множество примеров предвзятости, связанной с ИИ и алгоритмами, в том числе ложные совпадения при распознавании лиц, приводящие к тюремному заключению, системы кредитного скоринга предвзятое отношение к женщинамВ судах и системах здравоохранения используются инструменты дискриминации.

В отчете The Guardian утверждается, что Великобритания сейчас находится на грани потенциального скандала, а эксперты выражают опасения по поводу прозрачности и понимания алгоритмов, используемых чиновниками.

Скандалы уже были наблюдается в других странахкак, например, в США, где Платформы предиктивной полиции были демонтированыВ Нидерландах суды выступили против системы искусственного интеллекта, предназначенной для борьбы с мошенничеством в сфере социального обеспечения.

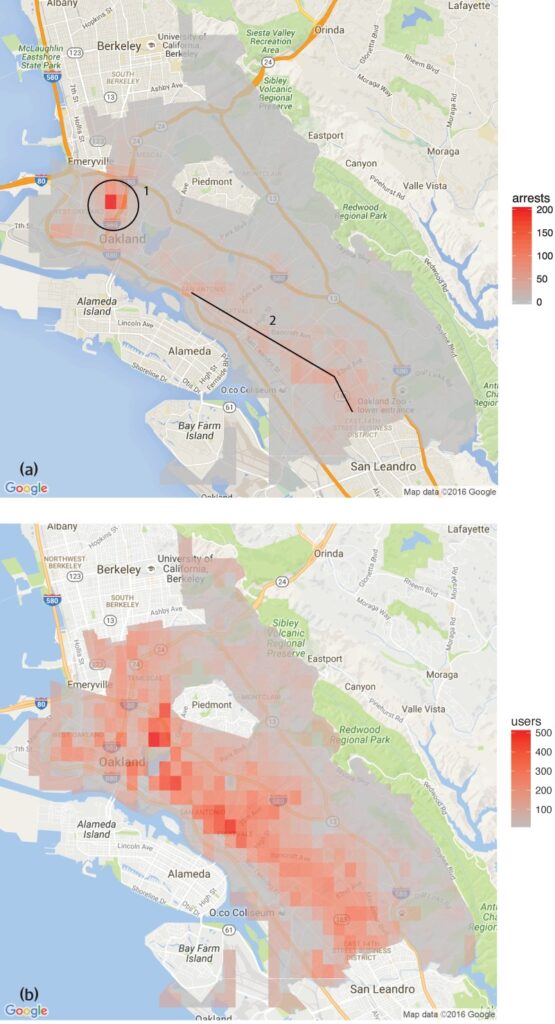

Исследование, проведенное Группа анализа данных по правам человека обнаружили, что программное обеспечение для предиктивной полицейской деятельности, используемое в Окленде, штат Калифорния, непропорционально нацелено на цветные сообщества, что увековечивает цикл чрезмерного полицейского контроля в этих районах.

Это отражает опасения, высказанные Инструмент распознавания лиц, разработанный столичной полициейВ определенных условиях они демонстрировали более высокий процент ошибок при идентификации черных лиц.

Есть несколько примеров и в здравоохранении, например, несоответствия в моделях искусственного интеллекта, разработанных для выявления рака кожи. В большинстве случаев наибольшему риску подвергаются меньшинства и женщины.

Шамим Ахмад, исполнительный директор проекта "Общественное право", подчеркнул необходимость немедленных действий, заявив: "ИИ обладает огромным потенциалом для социального блага. Например, мы можем сделать вещи более эффективными. Но мы не можем игнорировать серьезные риски. Если не принять срочных мер, мы можем оказаться в ситуации, когда непрозрачные автоматизированные системы будут регулярно, возможно, незаконно, использоваться для решения жизненно важных задач, а люди не смогут получить компенсацию, если эти процессы пойдут не так".

Поддерживая эти опасения, Марион Освальд, профессор права из Нортумбрийского университета, обратила внимание на несоответствия и отсутствие прозрачности в использовании ИИ в государственном секторе, заявив: "В том, как ИИ используется в государственном секторе, не хватает последовательности и прозрачности. Многие из этих инструментов будут влиять на многих людей в их повседневной жизни, например, на тех, кто обращается за пособиями, но люди не понимают, зачем они используются, и не имеют возможности оспорить их".

Риски ИИ для государственного сектора

Бесконтрольное применение ИИ в государственных ведомствах и полиции вызывает опасения по поводу подотчетности, прозрачности и предвзятости.

В случае с Департаментом по труду и пенсиям (DWP) в отчете The Guardian были обнаружены случаи, когда алгоритм приостанавливал выплату людям пособий без четкого объяснения причин.

Член парламента Кейт Осамор заявила, что ее болгарские избиратели потеряли свои пособия из-за полуавтоматической системы, которая отмечала их дела как потенциальные мошеннические, что подчеркивает отсутствие прозрачности.

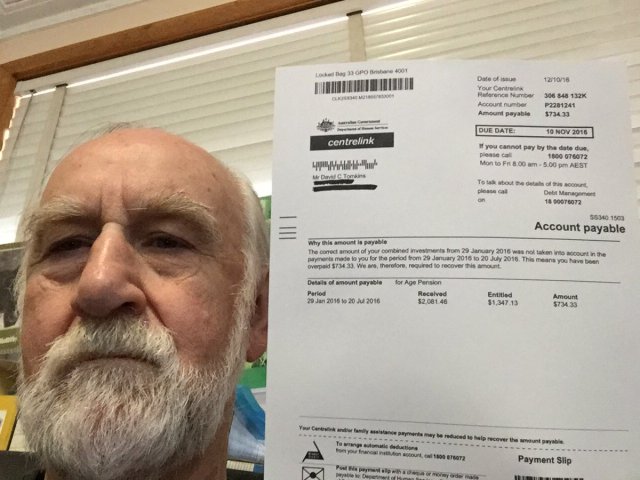

Это напоминает Скандал с "рободебютом" в Австралиигде автоматизированная система ошибочно обвинила более 400 000 человек в мошенничестве с социальным обеспечением, что привело к массовым лишениям.

Скандал с компанией Robodebt, ставший предметом расследования омбудсмена Содружества, судебных и общественных разбирательств, продемонстрировал масштабы последствий принятия алгоритмических решений.

Правительство Австралии согласилось на цифру урегулирования в размере $1,8 млрд австралийских долларов в 2021 году.

Недостатки ИИ не ограничиваются государственными службами. В корпоративном мире также наблюдаются сбои, особенно в инструментах подбора персонала, основанных на ИИ.

Ярким примером является инструмент ИИ Amazon для подбора персонала, который проявил предвзятое отношение к кандидатам-женщинам. Система была обучена на резюме, поданных в компанию за 10 лет, большинство из которых были от мужчин, в результате чего ИИ отдавал предпочтение кандидатам-мужчинам.

Три примера алгоритмической предвзятости, которых следует опасаться

По мере того как искусственный интеллект и алгоритмическое принятие решений интегрируются в сложные общественные процессы, растет число тревожных примеров предвзятости и дискриминации.

Здравоохранение и судебная система США

Исследование 2019 года Опубликовано в журнале Science Выяснилось, что широко используемый в США алгоритм оказания медицинской помощи имеет расовую предвзятость. Алгоритм реже направлял чернокожих людей в программы, призванные улучшить уход за пациентами со сложными медицинскими потребностями, чем их белых коллег.

В исследовании объясняется, почему: "Предвзятость возникает потому, что алгоритм использует расходы на здравоохранение в качестве косвенного показателя потребностей в медицинском обслуживании. На чернокожих пациентов с тем же уровнем потребностей тратится меньше денег, поэтому алгоритм делает ложный вывод о том, что чернокожие пациенты более здоровы, чем такие же больные белые пациенты".

Еще один важный пример - использование ИИ в предиктивной работе полиции и вынесении судебных приговоров. Такие инструменты, как Профилирование управления исправительными учреждениями для альтернативных наказаний (COMPAS) использовались для оценки риска повторного совершения преступлений обвиняемыми.

Расследования показали, что эти инструменты могут быть предвзяты к афроамериканским обвиняемым, присваивая им более высокие баллы риска, чем их белым коллегам. Это вызывает обеспокоенность по поводу справедливости и беспристрастности судебных решений, принимаемых с помощью ИИ.

Распознавание лиц в Бразилии

Сайт Проект Smart Sampa в Сан-ПаулуБразилия, отметила значительную веху в интеграции искусственного интеллекта и видеонаблюдения в городские ландшафты - то, что ранее было характерно только для Китая.

К 2024 году в Сан-Паулу планируется установить до 20 000 камер и объединить столько же сторонних и частных камер в единую платформу видеонаблюдения. Эта сеть будет следить за общественными местами, медицинскими учреждениями и школами, а также просматривать материалы социальных сетей, имеющие отношение к государственному управлению.

Хотя Smart Sampa обещает повысить безопасность и улучшить качество государственных услуг, эксперты предупреждают, что она может усугубить существующие социальные проблемы, в частности структурный расизм и неравенство.

Более 90% лиц, арестованных в Бразилии на основе распознавания лиц, являются чернокожими. Инициатива Сан-Паулу рискует закрепить эту тенденцию и еще больше маргинализировать чернокожее сообщество, составляющее 56% населения Бразилии.

Технологии распознавания лиц часто ошибаются в определении темных оттенков кожи, отчасти потому, что технологии обработки изображений не справляются с темным цветом лица, а отчасти потому, что наборы данных для обучения нерепрезентативны.

Фернанда Родригес, адвокат по цифровым правам, подчеркнула возможность ложных срабатываний и последующий риск массового лишения свободы чернокожих.

Родригес говорит: "Помимо риска того, что информация, поступающая на эти платформы, может быть неточной, а сама система может дать сбой, существует проблема, которая предшествует технологическим последствиям, - это расизм".

"Мы знаем, что система исполнения наказаний в Бразилии является избирательной, поэтому можно сделать вывод, что [использование системы наблюдения с распознаванием лиц] направлено на увеличение рисков и вреда для этой категории населения", - добавила она.

Вопросы конфиденциальности также имеют первостепенное значение. Критики утверждают, что Smart Sampa может нарушить основные права человека, включая неприкосновенность частной жизни, свободу слова, собраний и ассоциаций. Непрозрачный характер проекта еще больше усложняет ситуацию, поскольку на этапе консультаций общественность была привлечена лишь частично.

Smart Sampa не осталась без внимания. Прокуроры провели расследование, а правозащитные организации инициировали судебные иски с целью остановить развитие технологии.

Голландский индикатор системного риска (SyRI)

В 2022 году окружной суд Гааги тщательно проверил, как голландское правительство использует Индикация системного риска (SyRI)алгоритм, предназначенный для обнаружения потенциального мошенничества в сфере социального обеспечения.

Система SyRI должна была повысить эффективность выявления мошенничества в сфере социального обеспечения путем объединения данных из различных государственных баз данных и применения индикаторов риска для создания профилей потенциальных мошенников. Однако подозрительные решения и отсутствие прозрачности вызвали тревогу, что привело к судебному разбирательству со стороны коалиции организаций гражданского общества.

Истцы утверждали, что SyRI нарушает различные международные и европейские законы о правах человека. Они также ставили под сомнение законность, необходимость и пропорциональность применения алгоритма.

Окружной суд Гааги постановил, что законодательство, регулирующее СиРИ и ее применение, не соответствует необходимым стандартам в области прав человека. Суд отметил отсутствие прозрачности и возможность дискриминационных последствий, подчеркнув необходимость надлежащих правовых гарантий при внедрении подобных технологий.

Это дело было названо одним из первых, в котором рассматривается воздействие ИИ на права человека в государственном секторе, что подчеркивает необходимость прозрачности, подотчетности и надежной правовой базы.

Прозрачное и справедливое тестирование инструментов имеет первостепенное значение

В связи с недавними судебными разбирательствами и общественным вниманием к алгоритмическому принятию решений в правительственных операциях, призыв к прозрачному тестированию инструментов ИИ становится все более актуальным.

Обеспечение подотчетности, предотвращение дискриминации и сохранение общественного доверия зависят от внедрения строгих и открытых протоколов тестирования.

Прозрачное тестирование позволяет получить полное представление о том, как функционируют эти алгоритмы, какие данные они используют и какими процессами принятия решений руководствуются. Это очень важно для выявления потенциальных предубеждений, неточностей или дискриминационных практик, заложенных в систему.

Однако строгие процедуры тестирования противоречат обещаниям ИИ о быстрой эффективности.

В случае с Великобританией премьер-министр Риши Сунак Стан "За инновацииЭто, возможно, не оставляет места для всесторонних процедур тестирования. Более того, существует мало согласованных процессов тестирования инструментов ИИ перед их распространением для публичного использования.

Этот сценарий повторяется во всем мире. Быстрое внедрение ИИ не должно происходить за счет тщательного изучения и анализа.