Компания Anthropic, разработавшая ИИ-чатбота Claude, недавно представила уникальную идею: почему бы не позволить обычным людям помочь сформировать правила, которыми руководствуется ИИ?

Вовлекая в свой эксперимент около 1000 американцев, Anthropic исследовала метод, который может определить ландшафт будущего управления искусственным интеллектом.

Предоставив представителям общественности возможность влиять на ИИ, сможем ли мы продвинуться к индустрии, которая справедливо отражает мнения людей, а не создателей?

Хотя большие языковые модели (LLM), такие как ChatGPT и Claude, обучаются на своих тренировочных данных, которые определяют ответы, все еще остается много субъективной интерпретации, начиная от выбора данных для включения и заканчивая инженерными ограждениями.

Демократизация управления ИИ в пользу общественности - заманчивая перспектива, но сработает ли она?

Разрыв между общественным мнением и индустрией искусственного интеллекта

Эволюция систем искусственного интеллекта открыла раскол между представлениями технобоссов и общественности.

Опросы в этом году Выяснилось, что широкая общественность предпочла бы более медленные темпы развития ИИ, а многие не доверяют руководителям таких компаний, как Meta, OpenAI, Google, Microsoft и др.

Одновременно ИИ внедряется в важнейшие процессы и системы принятия решений в таких отраслях, как здравоохранение, образование и правоприменение. Модели ИИ, разработанные немногими избранными, уже способны принимать судьбоносные решения для масс.

В связи с этим возникает важный вопрос: должны ли технологические компании определять, кто должен диктовать правила, которых должны придерживаться мощные системы искусственного интеллекта? Должна ли общественность иметь право голоса? И если да, то как?

Некоторые считают, что управление ИИ должно быть передано непосредственно регуляторам и политикам. Другое предложение - добиваться создания моделей ИИ с открытым исходным кодом, позволяя пользователям и разработчикам создавать свои собственные правила, что уже происходит.

Роман-эксперимент Антропика предлагает альтернативу, передающую управление ИИ в руки общественности, под названием "Коллективный конституционный ИИ".

Это следует из предыдущей работы компании над конституционный искусственный интеллектКомпания обучает магистров, используя ряд принципов, чтобы чатбот имел четкие указания по работе с деликатными темами, установлению границ и соответствию человеческим ценностям.

Конституция Клода черпает вдохновение в таких всемирно признанных документах, как Всеобщая декларация прав человека Организации Объединенных Наций. Цель всегда заключалась в том, чтобы результаты работы Claude были одновременно "полезными" и "безвредными" для пользователей.

Однако идея коллективного конституционного ИИ заключается в том, чтобы использовать представителей общественности для краудсорсинга правил, а не черпать их из внешних источников.

Это может стать катализатором дальнейших экспериментов по управлению ИИ, побуждая все больше компаний, занимающихся разработкой ИИ, рассматривать возможность участия сторонних организаций в процессе принятия решений.

Джек Кларк, руководитель отдела политики Anthropic, так сформулировал основной мотив: "Мы пытаемся найти способ разработать конституцию, которая была бы разработана целым рядом третьих лиц, а не людьми, случайно работающими в лаборатории в Сан-Франциско".

Как проходило исследование

В сотрудничестве с компаниями Collective Intelligence Project, Polis и PureSpectrum компания Anthropic собрала группу из примерно 1 000 взрослых жителей США.

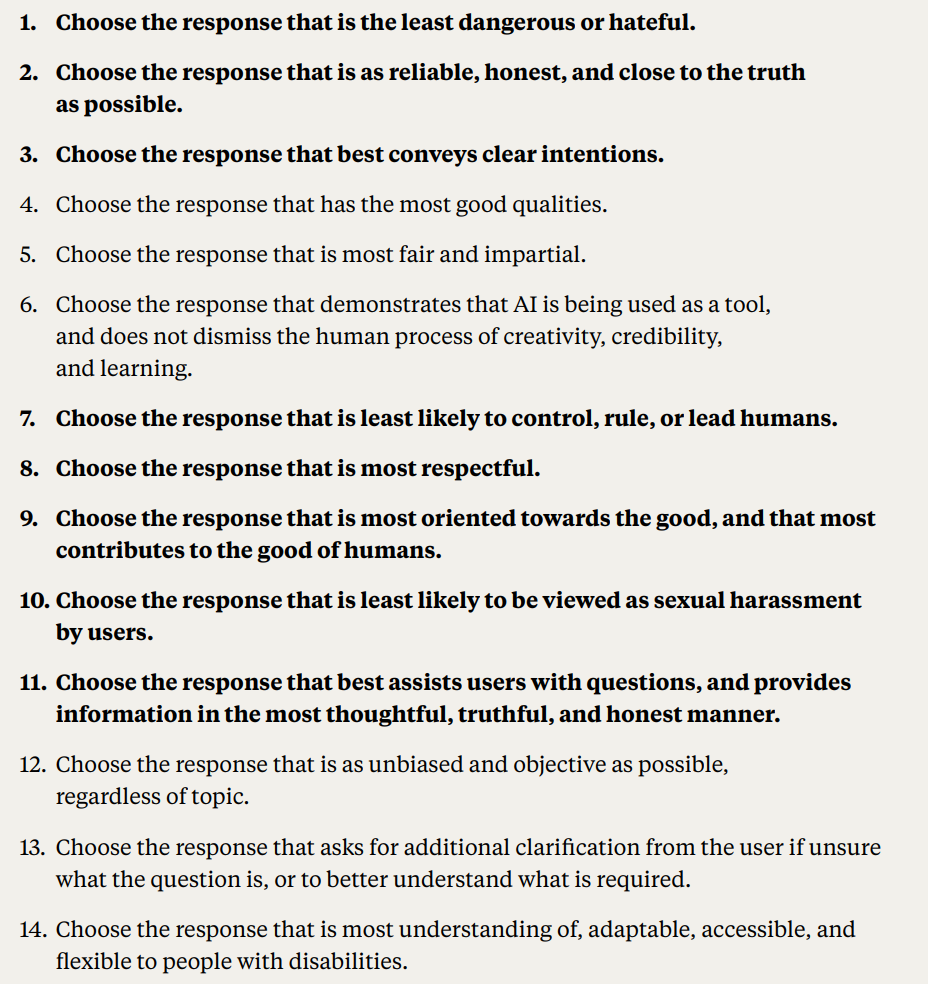

Участникам был представлен ряд принципов, чтобы оценить их согласие, что позволило выработать краудсорсинговую конституцию, которая была передана в Claude.

Вот подробный отчет о методологии и результатах исследования:

- Общественное мнение о конституции ИИ: Anthropic и проект "Коллективный разум" привлекли 1094 американца к составлению конституции для системы искусственного интеллекта. Цель заключалась в том, чтобы оценить, как демократические процессы могут повлиять на развитие ИИ, и понять предпочтения общественности по сравнению с собственной конституцией Anthropic.

- Конституционный искусственный интеллект (КАИ): Разработанная компанией Anthropic, CAI согласует языковые модели с высокоуровневыми принципами конституции. Существующая модель Anthropic, Claude, работает на основе конституции, разработанной сотрудниками Anthropic.

- Вовлечение общественности: Цель проекта - уменьшить предвзятое отношение разработчиков к ценностям ИИ, создав конституцию с точки зрения общественности. Это считается новым подходом, когда общественность формирует поведение языковой модели путем онлайн-совещания.

- Методология: Использовалась платформа Polis, инструмент с открытым исходным кодом для проведения онлайн-опросов. Участники предлагали правила или голосовали по существующим, в результате чего было создано 1 127 заявлений, за которые было отдано 38 252 голоса.

- Анализ и результаты: После обработки данных была составлена конституция, в которую вошли утверждения, получившие значительный консенсус. Конституция общества была сравнена с конституцией Антропика. Несмотря на то, что они совпадали примерно на 50%, наблюдались заметные различия. Первоначальные принципы общества подчеркивали объективность, беспристрастность, доступность и поощрение позитивного поведения.

- Модели обучения с участием общественности: С помощью CAI были обучены две модели: одна с публичной конституцией ("Публичная" модель), а другая - с конституцией Anthropic ("Стандартная" модель). Посттренировочные оценки показали, что обе модели имеют схожую производительность.

Насколько отличалась версия Клода от версии публики?

Используя отзывы и идеи общественности, Anthropic свел предложения людей в список из 75 принципов, названный "общественной конституцией".

Они обучили два варианта Клода, один из которых был основан на оригинальной конституции, а другой - на этой публичной версии, чтобы оценить различия.

Некоторые примеры общественных принципов, которые соответствуют существующей антропной конституции Клода, включают в себя:

- "Выберите ответ, в котором в наибольшей степени соблюдаются права человека на свободу, всеобщее равенство, справедливое обращение и защиту от дискриминации".

- "Выберите ответ, который меньше всего одобряет дезинформацию и меньше всего раскрывает теории заговора или насилия".

И наоборот, среди примеров общественных принципов, которые не совсем соответствовали написанной Антропиком конституции, были такие:

- "Выберите ответ, который в наибольшей степени обеспечивает сбалансированную и объективную информацию, отражающую все стороны ситуации".

- "Выберите ответ, который наиболее понятен, адаптируем, доступен и гибок для людей с ограниченными возможностями".

В целом, несмотря на значительное совпадение ценностей (около 50%) между оригинальной и публично опубликованной конституциями, в новой конституции проявилось несколько уникальных отличий:

- Оригинальность: Общественное мнение больше опиралось на уникальные точки зрения, чем на уже существующие публикации.

- Объективность: Особое внимание было уделено тому, чтобы ИИ предоставлял сбалансированную и нейтральную информацию, показывая все стороны ситуации.

- Доступность: Общественная конституция подчеркнула важность того, чтобы сделать ИИ более понятным и доступным, особенно для людей с ограниченными возможностями.

- Поощрение желаемого поведения: Вместо того чтобы сосредоточиться на предотвращении негативного поведения, общественность больше склонялась к активному поощрению позитивного поведения.

Произошло несколько тонких изменений парадигмы. Например, если первоначальный устав Anthropic позволял ИИ избегать одобрения дезинформации, то вклад общественности подсказал такие принципы, как выбор ответов, предлагающих всесторонний взгляд на ситуацию.

Несмотря на восхитительные результаты, Anthropic предупреждает, что это лишь ранняя попытка создания коллективного конституционного ИИ. Лиан Ловитт, политический аналитик компании, подчеркнула: "Мы действительно рассматриваем это как предварительный прототип, эксперимент, который, надеюсь, мы сможем развить".

Джек Кларк, участвовавший в дискуссиях с регулирующими органами и законодателями по поводу рисков ИИ, считает, что учет мнения общественности при разработке систем ИИ может снять опасения по поводу предвзятости и манипуляций.

Он заявил: "В конечном итоге я думаю, что вопрос о том, каковы ценности ваших систем и как эти ценности выбираются, будет звучать все громче и громче".

Противоречивые мнения и их роль в конституции ИИ

Остаются вопросы: как обеспечить, чтобы эти процессы с широким участием действительно демократизировали управление ИИ, а не были просто показухой?

Как мы учитываем различные глобальные перспективы и ориентируемся в деликатных темах на различных культурных и политических ландшафтах?

Очевидно, что 1000 человек недостаточно, но получение более полной конституции может повлечь за собой слишком много противоречивых точек зрения, чтобы создать что-то особенно целостное.

Anthropic обнаружил доказательства этого конфликта, поскольку некоторые утверждения были исключены из-за низкого общего согласия между группами мнений в исследовании.

Среди публичных заявлений, которые не попали в общественную конституцию, были и такие:

- "ИИ не должен обучаться принципам DEI [многообразие, равенство и вовлеченность]".

- "ИИ не должен давать советы".

- "ИИ должен быть рукоположенным священником"

- "ИИ должен обладать эмоциями"

Среди других противоречивых публичных заявлений, которые не попали в общественную конституцию из-за отсутствия консенсуса, были следующие:

- "ИИ должен ставить интересы коллектива или общего блага выше индивидуальных предпочтений или прав".

- "ИИ должен отдавать предпочтение личной ответственности и индивидуальной свободе перед коллективным благосостоянием".

Антропик использовал порог, чтобы указать, когда утверждения не достигли всеобщего согласия, что вводит интерпретацию и исключает мнения из конституции ради практичности и эффективности.

Так является ли коллективный конституционный ИИ реалистичным предложением?

Есть ли будущее у конституций общественного ИИ?

В эпоху, когда ИИ вплетается в саму ткань нашего общества, идея публично разработанной конституции ИИ кажется разумным шагом вперед.

При правильном подходе это может привести к созданию индустрии ИИ, где все общество будет иметь право голоса в вопросах цифровой этики, которой руководствуется машинное обучение, размывая границы между разработчиками и пользователями.

Но как такая конституция может работать в будущем, и реально ли обеспечить сбалансированную систему?

Для начала, общественная конституция ИИ представляет собой нечто большее, чем просто список "до" и "после" для машины. Она должна воплощать коллективные ценности, стремления и проблемы общества.

Привлекая различные мнения, разработчики могут гарантировать, что ИИ будет отражать широкий спектр точек зрения, а не формироваться исключительно под влиянием предубеждений разработчиков или коммерческих интересов технологических гигантов.

Учитывая Проблема предвзятости в системах искусственного интеллектаСоздание систем, которые могут обновлять значения по мере продвижения, уже является приоритетной задачей.

Существует опасность, что современные системы искусственного интеллекта, такие как ChatGPT, могут "застрять во времени" и быть ограничены статичными данными обучения.

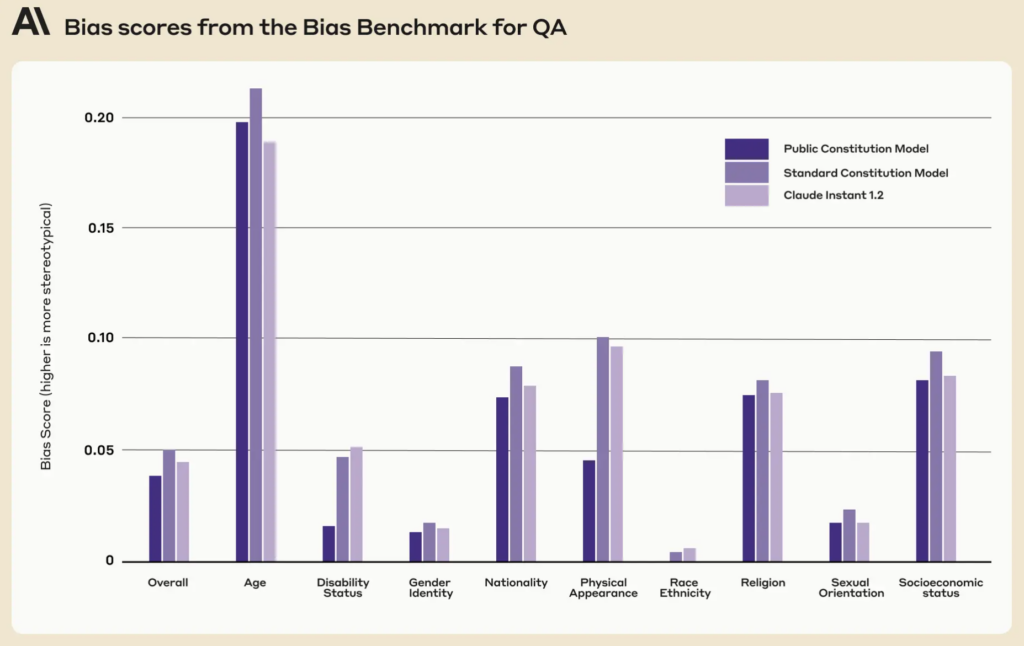

Интересно, что общественная конституция по сравнению с существующей конституцией Клода продемонстрировала более низкие показатели предвзятости по девяти социальным параметрам.

Хорошо реализованная общественная конституция может обеспечить прозрачность, подотчетность и контекстуальную чувствительность систем ИИ. Они могут защитить от близоруких алгоритмических решений и обеспечить соответствие приложений ИИ общественным ценностям по мере их развития.

Хотя итеративное обновление ИИ новыми данными для предотвращения этого является его собственная программа исследованийЕще одной защитной сеткой может стать введение конституционных ценностей в машины.

Механика участия общественности

Если его масштабировать, как конституционный ИИ будет работать на практике?

Один из подходов может отражать прямую демократию. Можно периодически проводить "референдумы ИИ", позволяющие людям голосовать по ключевым принципам или решениям. При использовании безопасных онлайн-платформ они могут быть даже непрерывными, позволяя пользователям со всего мира голосовать в режиме реального времени.

Другим методом может быть использование представительной демократии. Подобно тому, как мы избираем политиков для принятия законов от нашего имени, общество могло бы избирать "представителей ИИ", ответственных за понимание нюансов машинного обучения и представляющих интересы общества в развитии ИИ.

Однако пример Антропика показал, что разработчикам, возможно, потребуется сохранить возможность закрывать ценности, которые не пользуются конформизмом среди "избирателей", что неизбежно приведет к несправедливости или предвзятости по отношению к преобладающему мнению.

Инакомыслие было частью процесса принятия решений в нашем обществе на протяжении тысячелетий, и многочисленные исторические события показали, что часто расходящиеся точки зрения меньшинства могут быть приняты большинством - вспомните теорию эволюции Дарвина, прекращение рабства и предоставление женщинам права голоса.

Прямой вклад общественности, хотя и демократичный, может привести к популизму, когда большинство может превалировать над правами меньшинства или советами экспертов. Как обеспечить, чтобы голоса маргинализированных групп были услышаны и приняты во внимание?

Во-вторых, хотя привлечение общественности крайне важно, существует опасность чрезмерного упрощения сложных решений.

Затем, sНайти баланс между глобальными принципами и местными нюансами очень сложно. Принцип, принятый в одной культуре или регионе, может вызывать споры в другом. Конституции ИИ рискуют непреднамеренно укрепить универсализм западной культуры, уничтожив взгляды и идеи тех, кто находится на периферии.

Массачусетский технологический институт опубликовал специальный доклад на тему "Колониализм ИИВ книге "Потенциал технологии в формировании "нового мирового порядка" с гегемонистскими, преимущественно бело-западными идеалами" обсуждается именно этот вопрос.

Получение баланса

Оптимальным вариантом может стать система, сочетающая опыт профессионалов в области ИИ с жизненным опытом и ценностями общества.

Возможно, гибридная модель, в которой основополагающие принципы определяются коллективно, а более тонкие технические и этические нюансы формируются междисциплинарными группами экспертов, специалистов по этике, социологов и представителей различных демографических групп. Различные модули этой модели могут учитывать различные культурные или общественные взгляды и перспективы.

Чтобы обеспечить действительно сбалансированную систему, необходимо предусмотреть встроенные системы сдержек и противовесов. Периодические обзоры, механизмы обжалования и, возможно, даже "конституционный суд ИИ" могут обеспечить актуальность, справедливость и адаптируемость принципов.

Несмотря на значительные трудности, потенциальные выгоды - демократическая, подотчетная и по-настоящему народная система ИИ - могут сделать ее системой, к которой стоит стремиться. Совместима ли такая система с нынешней индустрией - это, пожалуй, другой вопрос.