Данные - жизненная сила ИИ, но они не бесконечный ресурс. Может ли у человечества закончиться запас данных? Что произойдет, если это случится?

Сложные модели ИИ требуют огромного количества обучающих данных. Например, для обучения большой языковой модели (LLM), такой как ChatGPT, требуется около 10 триллионов слов.

Некоторые эксперты считают, что запасы высококачественных данных сокращаются. Например, в исследовании 2022 года, проведенном учеными из нескольких университетов заявил, "Наш анализ показывает, что запасы высококачественных языковых данных скоро будут исчерпаны; скорее всего, до 2026 года... Наша работа предполагает, что нынешняя тенденция постоянного роста ML-моделей, опирающихся на огромные массивы данных, может замедлиться, если эффективность данных не будет радикально повышена или не появятся новые источники данных".

Генерирование синтетических данных позволяет решить проблему, но, как правило, оно не может передать всю глубину, нюансы и разброс реальных данных.

Еще больше усложняет ситуацию то, что произойдет, когда ИИ начнет потреблять собственную продукцию, что, по мнению исследователей из Федеральной политехнической школы Лозанны (EPFL) в Швейцарии, является уже происходит.

Их исследование показывает, что ИИ-компании, покупающие данные, произведенные людьми, через такие платформы, как Amazon Mechanical Turk, могут получить вместо них данные, сгенерированные ИИ.

Что произойдет, если ИИ начнет поедать свои собственные результаты? Можно ли этого избежать?

Создание наборов данных требует больших затрат и времени, а ставки высоки

Данные распространены повсеместно, но их операционализация для ИИ - сложный процесс. Качество данных и меток влияет на производительность модели - это случай "мусор внутрь, мусор наружу".

Чтобы кратко описать процесс создания наборов данных, аннотаторы данных (или маркировщики) берут обработанные данные (например, обрезанное изображение) и маркируют их. признаки (например, автомобиль, человек, птица).

Это дает алгоритмам "цель" для обучения. Алгоритмы извлекают и анализируют признаки из помеченных данных, чтобы предсказать эти признаки в новых, еще не просмотренных данных.

Это необходимо для контролируемого машинного обучения, которое является одним из основных направлений машинного обучения наряду с неконтролируемым машинным обучением и обучением с подкреплением. По ссылке некоторые оценкиПроцесс подготовки и маркировки данных занимает 80% времени в проекте модели машинного обучения, но слишком много углов рискует поставить под угрозу производительность модели.

Помимо практических проблем, связанных с созданием высококачественных наборов данных, сама природа данных постоянно меняется. То, что вы определили бы как "набор данных, содержащий типичную подборку транспортных средств на дорогах" 10 лет назад, сегодня совсем не то же самое. Например, сейчас на дорогах можно встретить гораздо большее количество эскутеров и эбайков.

Это так называемые "крайние случаи", которые представляют собой редкие объекты или явления, не встречающиеся в наборах данных.

Модели отражают качество своих наборов данных

Если обучить современную систему искусственного интеллекта на старом наборе данных, то при работе с новыми, неизвестными данными модель рискует получить низкую производительность.

В период с 2015 по 2020 год исследователи выявили серьезные структурные ошибки в алгоритмах ИИ, которые частично объяснялись обучением моделей на старых и необъективных данных.

Например. Маркированные лица в диком доме (LFW)набор данных лиц знаменитостей, обычно используемый в задачах распознавания лиц, состоит из 77,5% мужчин и 83,5% белокожих люди. У искусственного интеллекта нет надежды на нормальное функционирование, если данные не представляют всех, кого он собирается обслуживать. Коэффициент ошибок при распознавании лиц среди лучших алгоритмов составил 0,8% для белых мужчин и 34,7% для темнокожих женщин.

Результатом этого исследования стала эпохальная работа Исследование гендерных оттенков и документальный фильм под названием Кодированное предубеждениев котором исследовалось, как искусственный интеллект может обучаться на несовершенных и нерепрезентативных данных.

Последствия этого далеко не благотворны - это приводит к неправильным судебным решениям, ложным заключениям, а также к тому, что женщинам и другим группам населения отказывают в работе и кредитах.

ИИ требуется больше высококачественных данных, которые должны быть справедливыми и репрезентативными - это неуловимое сочетание.

Синтетические данные - это выход?

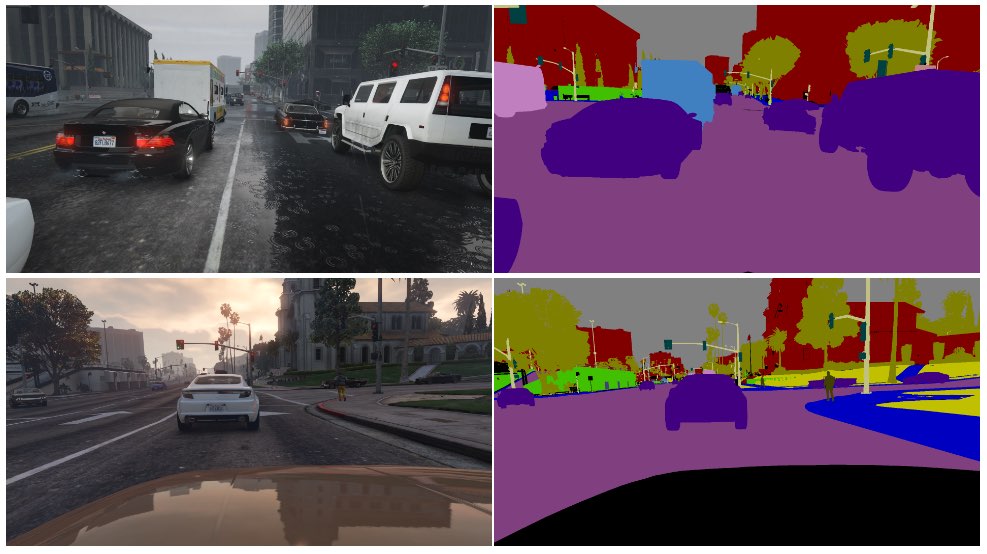

Синтетические данные широко используются в компьютерном зрении (КВ), где искусственный интеллект определяет объекты и особенности по изображениям и видео.

Вместо того чтобы собирать данные о реальном мире, например, фотографировать или снимать на видео улицы, что технически сложно и создает проблемы с конфиденциальностью, вы просто генерируете данные в виртуальной среде.

Хотя это позволяет дополнить ИИ большим количеством данных, есть и ряд недостатков:

- Моделирование реальных сценариев в виртуальной среде - задача не из простых.

- Генерирование большого количества синтетических данных по-прежнему требует больших затрат и времени.

- Краевые случаи и выбросы остаются проблемой.

- Он не может идеально повторить настоящий.

- С другой стороны, некоторые аспекты могут быть слишком идеальными, и трудно определить, чего не хватает.

В итоге синтетические данные отлично подходят для легко виртуализируемых сред, таких как заводской цех, но не всегда подходят для быстро меняющихся реальных сред, таких как городская улица.

А как насчет создания синтетических текстовых данных?

Текстовые данные проще, чем изображения или видео, поэтому можно ли использовать модели типа ChatGPT для создания практически бесконечного количества синтетических обучающих данных?

Да, но это рискованно, и последствия нелегко предсказать. Хотя синтетические текстовые данные могут помочь в настройке, тестировании и оптимизации моделей, они не идеальны для обучения моделей новым знаниям и могут закрепить предвзятость и другие проблемы.

Вот аналогия того, почему обучение ИИ на данных, созданных ИИ, является проблематичным:

- Подумайте о школе, которая использует все лучшие учебники мира, чтобы за один день обучить своих учеников всему, что нужно знать из имеющихся ресурсов.

- После этого школа начинает производить собственную работу на основе этих знаний - по аналогии с работой чатбота. Студенты извлекли знания из всех данных, доступных к моменту начала обучения, но после этого они не могут эффективно вводить новые данные в систему знаний.

- Знания создаются ежедневно - хотя подавляющее большинство человеческих знаний было создано до какого-то конкретного дня, знания развиваются и трансформируются с течением времени. Важно, что люди не только постоянно создают новые знания, но и меняют свой взгляд на существующие.

- Теперь предположим, что школа, переполненная данными, начинает обучать своих учеников, используя собственные результаты. Студенты начинают "есть" свой контент, чтобы производить новый.

- На этом этапе результаты студентов не адаптируются к реальному миру, и их полезность снижается. Система повторяет свою собственную работу. Хотя работа может адаптироваться и развиваться, она делает это в отрыве от всего, что находится за пределами этой петли обратной связи.

ИИ постоянно ставит перед людьми загадки, которые нужно решить, и В этой книге много комментаторы на Reddit и Форум Y Combinator в тупике.

Это умопомрачительная вещь, и пока нет единого мнения о ее последствиях.

Люди, занимающиеся маркировкой данных, часто используют искусственный интеллект для создания данных

У проблемы получения качественных обучающих данных есть еще один непредвиденный слой.

Такие платформы для краудворкинга, как Amazon Mechanical Turk (MTurk) регулярно используются компаниями, занимающимися разработкой искусственного интеллекта и стремящимися получить настоящие "человеческие" базы данных. Tесть опасения, что аннотаторы данных на этих платформах используют ИИ для выполнения своих задач.

Исследователи из Федеральной политехнической школы Лозанны (EPFL) в Швейцарии проанализировали данные, созданные в MTurk, чтобы выяснить, использовали ли работники искусственный интеллект для создания своих работ.

ИсследованиеВ исследовании, опубликованном 13 июня, 44 участникам MTurk было предложено обобщить аннотации 16 медицинских исследований. Выяснилось, что от 33% до 46% пользователей платформы создавали свои материалы с помощью искусственного интеллекта, несмотря на то, что их просили отвечать на естественном языке.

"Мы разработали очень специфическую методологию, которая отлично сработала для обнаружения синтетического текста в нашем сценарии", - говорит Маноэль Рибейро, соавтор исследования и аспирант EPFL, рассказал The Register на этой неделе.

Хотя набор данных и размер выборки в исследовании довольно малы, далеко не исключено, что ИИ невольно обучаются на контенте, создаваемом ИИ.

Исследование не обвиняет работников MTurk - исследователи отмечают, что низкая зарплата и повторяющаяся работа способствуют возникновению этой проблемы. Компании, занимающиеся разработкой искусственного интеллекта, хотят получать данные высочайшего качества, созданные людьми, при этом сохраняя низкие затраты. Один из комментаторов на Reddit сказал: "Сейчас я один из этих работников, которому поручено обучать Барда. Я чертовски уверен, что использую для этого ChatGPT. 20$/час - это мало за то ужасное обращение, которое мы получаем, так что я собираюсь выжать каждый цент из этой ******* работы".

Кроличья нора становится еще глубже, поскольку ИИ часто обучаются на данных, взятых из интернета. По мере того как в сети будет публиковаться все больше контента, написанного ИИ, он неизбежно будет учиться на своих собственных результатах.

По мере того как люди начинают зависеть от ИИ в получении информации, качество их результатов становится все более критичным. Нам необходимо найти инновационные методы обновления ИИ свежими, достоверными данными.

По словам Рибейро, "человеческие данные - это золотой стандарт, потому что нам важны именно люди, а не большие языковые модели".

Работа по анализу потенциального влияния ИИ, потребляющего собственные результаты, продолжается, но подлинные человеческие данные остаются критически важными для широкого спектра задач машинного обучения.

Генерирование огромного количества данных для голодных ИИ при одновременной навигации по рискам - это работа над собой.