A OpenAI anunciou que irá utilizar a norma C2PA para adicionar metadados às imagens geradas com o DALL-E 3.

O anúncio surge numa altura em que as empresas continuam a procurar formas de impedir que os seus produtos de IA generativa sejam utilizados para espalhar desinformação.

A C2PA é uma norma técnica aberta que acrescenta metadados a uma imagem, incluindo a sua origem, histórico de edições e outras informações. A OpenAI afirma que as imagens geradas diretamente com o DALL-E 3, ou através do ChatGPT ou da sua API, passarão a incluir dados C2PA. Os utilizadores móveis verão isto implementado até 12 de fevereiro.

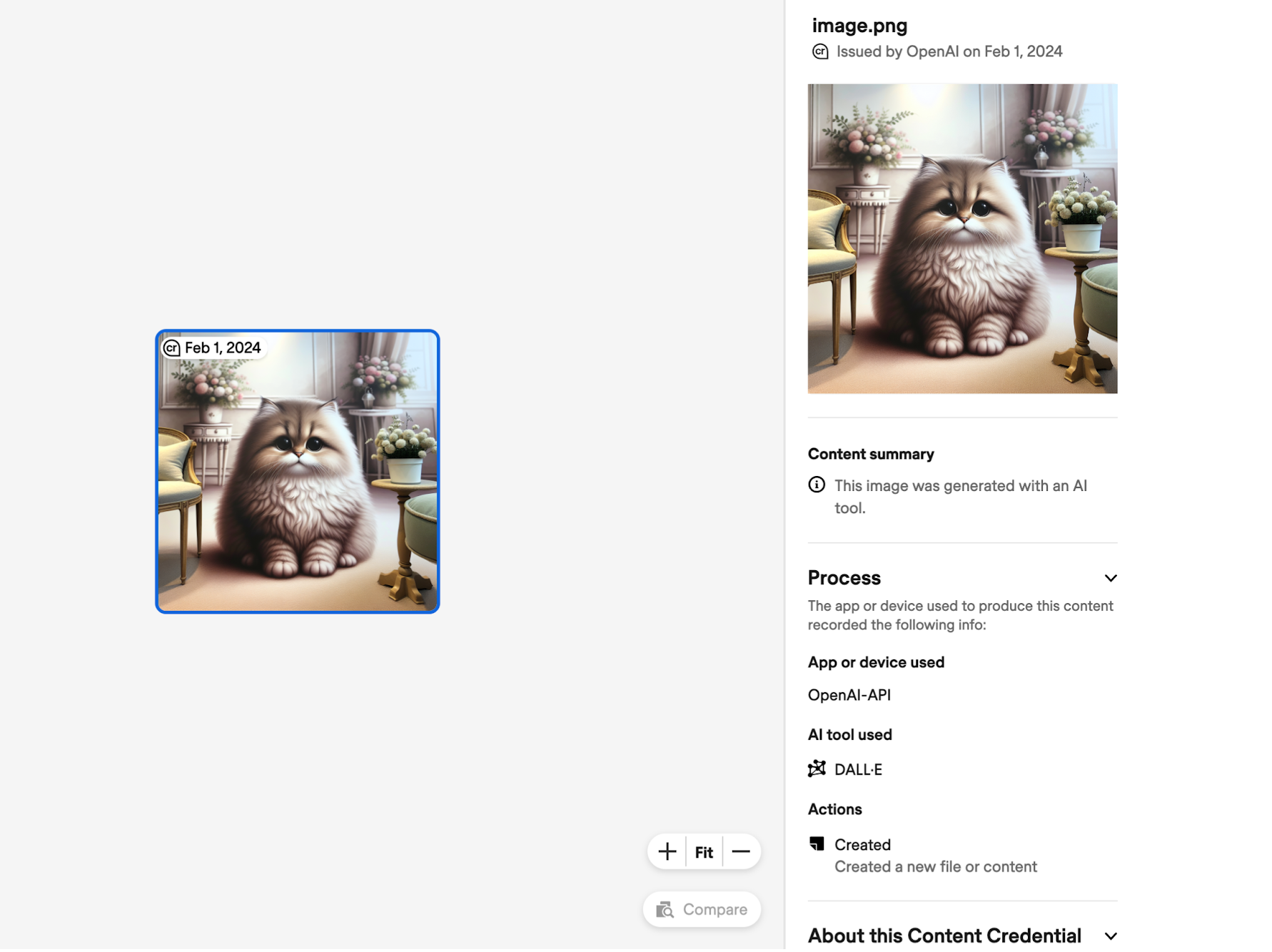

Uma imagem que tenha metadados C2PA adicionados pode ser carregada em sítios como Verificação de credenciais de conteúdo para verificar a proveniência da imagem. Eis um exemplo da informação que o C2PA revela sobre uma imagem feita com DALL-E através da API.

As plataformas de redes sociais também poderiam utilizar estes dados para assinalar e rotular as imagens como sendo geradas por IA. A Meta anunciou recentemente que estaria a fazer um esforço maior para o fazer.

A adição de dados C2PA aumenta o tamanho do ficheiro, com estimativas de exemplo da OpenAI citadas como:

- 3,1MB → 3,2MB para PNG através da API (aumento de 3%)

- 287k → 302k para WebP através de API (aumento de 5%)

- 287k → 381k para WebP através do ChatGPT (aumento de 32%)

A OpenAI reconhece que "a C2PA não é uma solução milagrosa para resolver as questões de proveniência". Os metadados são facilmente removidos, muitas vezes de forma não intencional.

Se tirar uma captura de ecrã da imagem, os dados C2PA não são mantidos. Mesmo a conversão de uma imagem de PNG para JPG destruirá a maioria dos metadados. A maioria das plataformas de redes sociais retira os metadados das imagens quando estas são carregadas.

A OpenAI afirma que, ao adicionar o C2PA às imagens do DALL-E, espera incentivar "os utilizadores a reconhecer que estes sinais são fundamentais para aumentar a fiabilidade da informação digital".

É possível que o faça até certo ponto, mas o facto de a C2PA ser tão fácil de remover não ajuda muito quando uma pessoa pretende intencionalmente utilizar uma imagem para induzir em erro. Quando muito, pode apenas abrandar um pouco os "deepfakers".

Marca de água digital SynthID da Google parece ser uma solução muito mais segura, mas é pouco provável que a OpenAI utilize uma ferramenta criada pela sua concorrência.