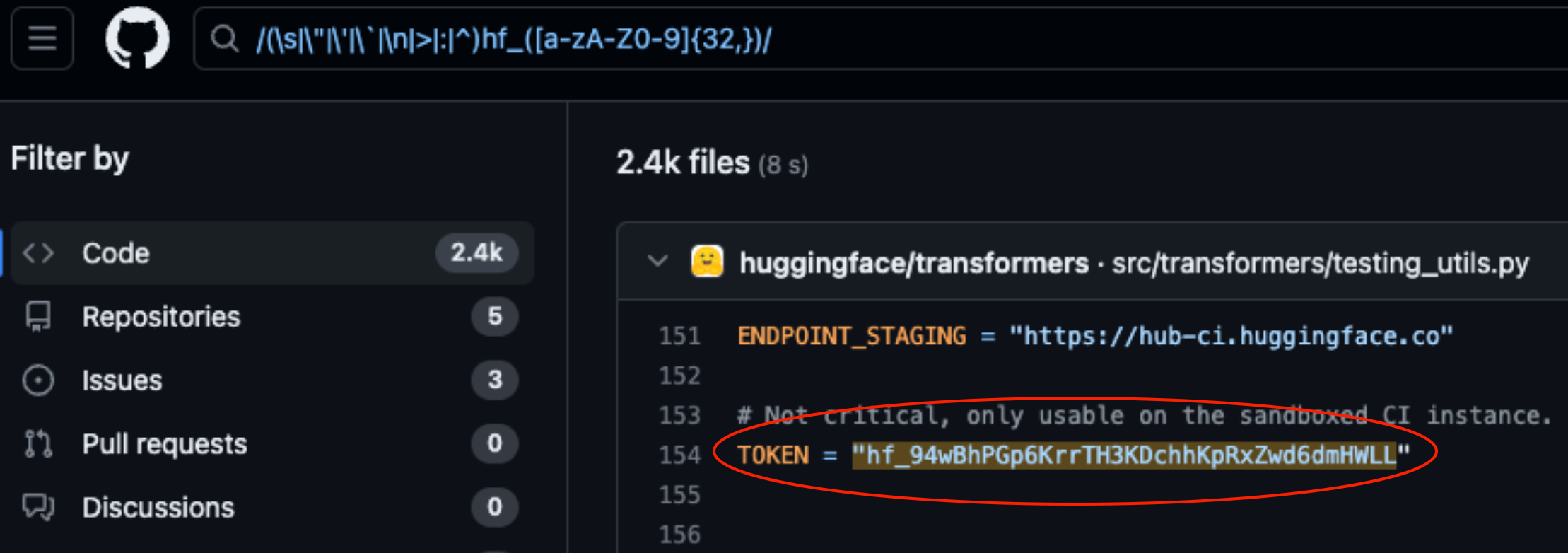

A Lasso Security expôs vulnerabilidades de segurança no HuggingFace e no GitHub depois de ter encontrado 1681 tokens de API expostos e codificados no código armazenado nas plataformas.

HuggingFace e GitHub são dois dos repositórios mais populares onde os programadores podem fornecer acesso aos seus modelos e código de IA. Pense neles como pastas na nuvem que são geridas pelas organizações que os possuem.

O HuggingFace e o GitHub facilitam a interação dos utilizadores com centenas de milhares de modelos e conjuntos de dados de IA através de APIs. Também permite que as organizações que possuem os modelos e conjuntos de dados utilizem o acesso à API para ler, criar, modificar e eliminar repositórios ou ficheiros.

As permissões associadas ao seu token API determinam o nível de acesso que tem. Laço encontrado que, com um pouco de investigação, conseguiram encontrar muitos tokens em código armazenado em repositórios nas plataformas.

Dos 1681 tokens válidos que encontraram, 655 tokens de utilizadores tinham permissões de escrita, 77 dos quais tinham permissões totais de conta.

Porque é que isto é importante?

Pense num token de API como uma chave para a sua porta da frente. Pode ser conveniente deixar a chave debaixo do capacho, mas se alguém a encontrar, terá acesso à sua casa.

Quando os programadores escrevem uma parte do código que precisa de interagir com o seu modelo de IA ou conjunto de dados, por vezes tornam-se um pouco preguiçosos. Podem codificar os tokens no seu código em vez de utilizarem formas mais seguras de os gerir.

Alguns dos tokens que o Lasso encontrou davam-lhes permissões completas de leitura e escrita na base de dados do Meta Lhama 2, BigScience Workshop e EleutherAI. Todas estas organizações têm modelos de IA que foram descarregados milhões de vezes.

Se os Lasso fossem os maus da fita, poderiam ter modificado os modelos ou conjuntos de dados nos repositórios expostos. Imaginem se alguém adicionasse algum código furtivo ao repositório Meta e depois fizesse com que milhões de pessoas o descarregassem.

Quando a Meta, a Google, a Microsoft e outras empresas souberam dos tokens de API expostos, revogaram-nos rapidamente.

O roubo de modelos, o envenenamento de dados de treino e a combinação de conjuntos de dados de terceiros e modelos pré-treinados são todos grandes riscos para as empresas de IA. Os programadores que deixam casualmente os tokens de API expostos no código só facilitam a sua exploração por parte dos maus actores.

É de perguntar se os engenheiros da Lasso foram os primeiros a descobrir estas vulnerabilidades.

Se cibercriminosos se encontrassem estas fichas, teriam certamente feito muito pouco barulho enquanto abriam a porta da frente.