Uma investigação do The Guardian lançou luz sobre a utilização generalizada da IA e de algoritmos complexos em vários processos de tomada de decisões do sector público no Reino Unido.

Funcionários públicos de pelo menos oito departamentos do sector público, juntamente com várias unidades policiais, incorporaram ferramentas de IA nos seus fluxos de trabalho.

As ferramentas de IA têm ajudado em processos decisórios cruciais nos domínios da segurança social, da imigração e da justiça penal. O inquérito revelou provas de utilização abusiva e de discriminação.

Embora o viés algorítmico e o viés relacionado com a IA não se enquadrem estritamente na mesma definição, ambos correm o risco de apresentar resultados tendenciosos quando expostos a cenários do mundo real. Os modelos de auto-aprendizagem da aprendizagem automática podem aumentar os enviesamentos predominantes nos conjuntos de dados.

De acordo com o relatório:

- Um deputado manifestou a sua preocupação em relação a um algoritmo utilizado pelo Departamento do Trabalho e das Pensões (DWP), que se suspeita ter feito com que muitas pessoas perdessem incorretamente os seus benefícios.

- Verificou-se que a ferramenta de reconhecimento facial da Polícia Metropolitana tem uma taxa de erro mais elevada na identificação de rostos negros do que de rostos brancos em determinadas condições. Este facto está bem estabelecido, com um estudo indicando que estas plataformas ofereciam uma precisão de uns míseros 2% em 2018.

- O Ministério do Interior tem estado a utilizar um algoritmo que visa desproporcionadamente indivíduos de determinadas nacionalidades para detetar casamentos fraudulentos para obtenção de benefícios e benefícios fiscais. Cidadãos da Albânia, Grécia, Roménia e Bulgária podem ter sido injustamente assinalados.

As ferramentas de IA aprendem padrões a partir de conjuntos de dados alargados. Se os conjuntos de dados forem tendenciosos ou pouco representativos da realidade, o modelo herda esses padrões.

Há muitos exemplos internacionais de preconceitos relacionados com a IA e os algoritmos, incluindo falsas correspondências de reconhecimento facial que levam à prisão, sistemas de pontuação de crédito infligir preconceitos às mulherese instrumentos discriminatórios utilizados nos tribunais e nos sistemas de saúde.

O relatório do The Guardian argumenta que o Reino Unido se encontra agora à beira de um potencial escândalo, com os especialistas a expressarem preocupações sobre a transparência e a compreensão dos algoritmos utilizados pelos funcionários.

Os escândalos já verificado noutros paísescomo nos EUA, onde as plataformas de policiamento preditivo foram desmanteladase nos Países Baixos, onde os tribunais se opuseram a um sistema de IA concebido para travar a fraude na segurança social.

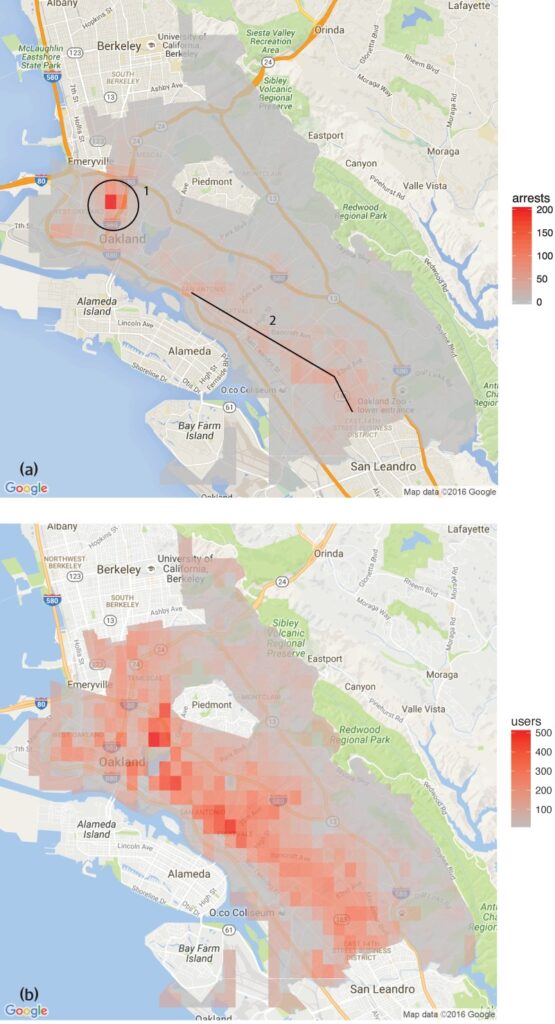

Um estudo efectuado pelo Grupo de Análise de Dados sobre Direitos Humanos descobriu que o software de policiamento preditivo utilizado em Oakland, na Califórnia, visava desproporcionadamente as comunidades de cor, perpetuando um ciclo de policiamento excessivo nesses bairros.

Isto reflecte as preocupações manifestadas pelo Ferramenta de reconhecimento facial da Polícia Metropolitanaque demonstraram taxas de erro mais elevadas na identificação de rostos negros em determinadas condições.

Há também vários exemplos na área da saúde, como as inconsistências nos modelos de IA concebidos para ajudar a detetar o cancro da pele. Na maioria dos casos, os grupos minoritários e as mulheres estão em maior risco.

Shameem Ahmad, Diretor Executivo do Public Law Project, sublinhou a necessidade de uma ação imediata, afirmando que "a IA tem um enorme potencial para o bem social. Por exemplo, podemos tornar as coisas mais eficientes. Mas não podemos ignorar os riscos graves. Se não forem tomadas medidas urgentes, poderemos entrar numa situação em que sistemas automatizados opacos são regularmente utilizados, possivelmente de forma ilegal, para alterar a vida das pessoas, e em que estas não poderão obter reparação quando esses processos correm mal".

Fazendo eco destas preocupações, Marion Oswald, professora de direito na Universidade de Northumbria, destacou as inconsistências e a falta de transparência na utilização da IA no sector público, afirmando: "Há uma falta de consistência e transparência na forma como a IA está a ser utilizada no sector público. Muitas destas ferramentas vão afetar muitas pessoas no seu dia a dia, por exemplo, as que pedem prestações sociais, mas as pessoas não compreendem por que razão estão a ser utilizadas e não têm a oportunidade de as contestar".

Os riscos da IA para o sector público

A aplicação sem controlo da IA em todos os departamentos governamentais e forças policiais suscita preocupações quanto à responsabilidade, transparência e parcialidade.

No caso do Departamento do Trabalho e Pensões (DWP), a reportagem do The Guardian revelou casos em que um algoritmo suspendeu os benefícios das pessoas sem uma explicação clara.

A deputada Kate Osamor afirmou que os seus eleitores búlgaros perderam os seus subsídios devido a um sistema semi-automatizado que assinalou os seus casos como potenciais fraudes, o que revela uma falta de transparência.

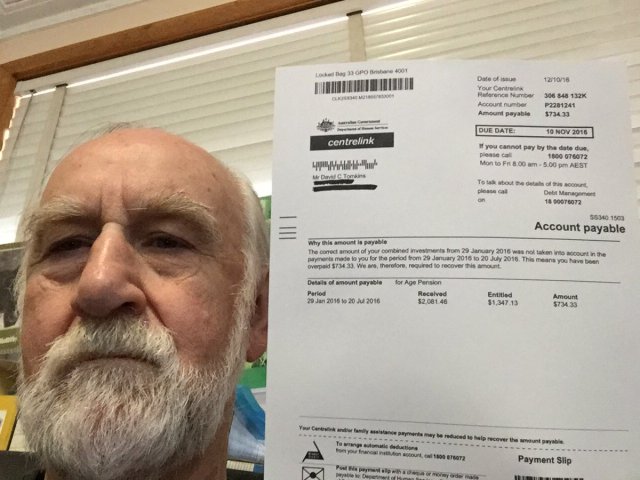

Isto faz lembrar o Escândalo do "Robodebt" na Austráliaem que um sistema automatizado acusou incorretamente mais de 400 000 pessoas de fraude em matéria de assistência social, provocando dificuldades generalizadas.

O escândalo Robodebt, objeto de investigações do Provedor de Justiça da Commonwealth, de acções judiciais e de inquéritos públicos, demonstrou a escala do impacto infligido pela tomada de decisões algorítmicas.

O governo australiano concordou com um valor de liquidação de $1,8 mil milhões de dólares australianos em 2021.

As deficiências da IA não se limitam aos serviços públicos. O mundo empresarial também tem assistido a falhas, nomeadamente nas ferramentas de recrutamento baseadas em IA.

Um exemplo notável é a ferramenta de recrutamento de IA da Amazon, que revelou um preconceito contra as candidatas do sexo feminino. O sistema foi treinado com base em currículos apresentados à empresa ao longo de um período de 10 anos, a maioria dos quais provinha de homens, o que fez com que a IA favorecesse os candidatos do sexo masculino.

Três exemplos de enviesamento algorítmico com os quais é preciso ter cuidado

À medida que a IA e a tomada de decisões algorítmicas se integram em processos sociais complexos, estão a surgir exemplos alarmantes de preconceitos e discriminação.

O sistema judicial e de saúde dos EUA

Um estudo de 2019 publicado na Science revelou que um algoritmo de cuidados de saúde muito utilizado nos EUA apresentava preconceitos raciais. O algoritmo tinha menos probabilidades de encaminhar pessoas de raça negra para programas destinados a melhorar os cuidados prestados a doentes com necessidades médicas complexas do que as pessoas de raça branca.

O estudo explica porquê: "O enviesamento ocorre porque o algoritmo utiliza os custos de saúde como um indicador das necessidades de saúde. Gasta-se menos dinheiro com os doentes negros que têm o mesmo nível de necessidades, pelo que o algoritmo conclui erradamente que os doentes negros são mais saudáveis do que os doentes brancos igualmente doentes".

Outro exemplo crítico é a utilização da IA no policiamento preditivo e nas sentenças judiciais. Ferramentas como Perfil de gestão de delinquentes para sanções alternativas (COMPAS) têm sido utilizados para avaliar o risco de reincidência dos arguidos.

As investigações revelaram que estas ferramentas podem ser tendenciosas em relação aos arguidos afro-americanos, atribuindo-lhes classificações de risco mais elevadas do que aos seus homólogos brancos. Este facto suscita preocupações quanto à justiça e imparcialidade da tomada de decisões judiciais assistida por IA.

Reconhecimento facial no Brasil

O Projeto Smart Sampa em São PauloO evento, que teve lugar na cidade de São Paulo, no Brasil, constituiu um marco significativo na integração da IA e da vigilância nas paisagens urbanas - algo que só era típico na China.

Até 2024, pretende instalar até 20.000 câmaras em São Paulo e integrar um número igual de câmaras de terceiros e privadas numa única plataforma de videovigilância. Essa rede fiscalizará espaços públicos, instalações médicas e escolas e examinará o conteúdo das mídias sociais relevantes para a administração pública.

Embora a Smart Sampa prometa maior segurança e melhores serviços públicos, os especialistas alertam que ela pode exacerbar as questões sociais existentes, especialmente o racismo estrutural e a desigualdade.

Mais de 90% dos indivíduos presos no Brasil com base no reconhecimento facial são negros. A iniciativa de São Paulo corre o risco de perpetuar essa tendência, marginalizando ainda mais a comunidade negra, que constitui 56% da população brasileira.

As tecnologias de reconhecimento facial identificam frequentemente de forma incorrecta os tons de pele mais escuros, em parte porque a tecnologia de imagem tem um desempenho inferior para tez mais escura e em parte porque os conjuntos de dados de treino não são representativos.

Fernanda Rodrigues, advogada de direitos digitais, salientou o potencial de falsos positivos e o risco subsequente de encarceramento em massa de indivíduos negros.

Para Rodrigues, "para além dos riscos de a informação introduzida nestas plataformas não ser exacta e de o próprio sistema falhar, há um problema que antecede as implicações tecnológicas, que é o racismo".

"Sabemos que o sistema penal no Brasil é seletivo, pelo que podemos concluir que [a utilização da vigilância com reconhecimento facial] tem tudo a ver com o aumento dos riscos e dos danos para esta população", acrescentou.

As preocupações com a privacidade também são fundamentais. Os críticos argumentam que a Smart Sampa poderia infringir os direitos humanos fundamentais, incluindo a privacidade, a liberdade de expressão, de reunião e de associação. A natureza opaca do projeto complicou ainda mais as coisas, com um envolvimento público limitado durante a fase de consulta.

A Smart Sampa não passou sem contestação. Promotores públicos investigaram e organizações de direitos humanos iniciaram ações legais para interromper a tecnologia.

Indicação neerlandesa de risco do sistema (SyRI)

Em 2022, o Tribunal Distrital de Haia examinou a utilização pelo Governo neerlandês de Indicação de risco do sistema (SyRI)um algoritmo concebido para detetar potenciais fraudes na segurança social.

O SyRI tinha como objetivo melhorar a eficiência da identificação de fraudes na segurança social, agregando dados de várias bases de dados governamentais e aplicando indicadores de risco para gerar perfis de potenciais autores de fraudes. No entanto, as decisões suspeitas e a falta de transparência fizeram soar o alarme, levando a uma contestação legal por parte de uma coligação de organizações da sociedade civil.

Os queixosos alegaram que a SyRI violou várias leis internacionais e europeias em matéria de direitos humanos. Questionaram também a legalidade, a necessidade e a proporcionalidade da aplicação do algoritmo.

O Tribunal Distrital de Haia decidiu que a legislação que regula a SyRI e a sua aplicação não cumprem as normas necessárias em matéria de direitos humanos. O tribunal salientou a falta de transparência e a possibilidade de efeitos discriminatórios, sublinhando a necessidade de salvaguardas jurídicas adequadas aquando da implementação de tais tecnologias.

O caso foi saudado como um dos primeiros a abordar o impacto da IA nos direitos humanos no sector público, salientando a necessidade de transparência, responsabilidade e quadros jurídicos sólidos.

É fundamental que as ferramentas sejam testadas de forma transparente e justa

Na sequência dos recentes desafios legais e do escrutínio público em torno da tomada de decisões algorítmicas nas operações governamentais, o apelo a testes transparentes das ferramentas de IA tornou-se cada vez mais urgente.

Garantir a responsabilização, evitar a discriminação e manter a confiança do público depende da implementação de protocolos de teste rigorosos e abertos.

Testes transparentes permitem uma compreensão abrangente do funcionamento destes algoritmos, dos dados que utilizam e dos processos de decisão que seguem. Isto é crucial para identificar potenciais enviesamentos, imprecisões ou práticas discriminatórias incorporadas no sistema.

No entanto, os procedimentos de ensaio rigorosos não se coadunam com a promessa de eficiência de ação rápida da IA.

No caso do Reino Unido, o primeiro-ministro Rishi Sunak posição "pró-inovaçãoe talvez não deixe espaço suficiente para procedimentos de teste abrangentes. Além disso, existem poucos - ou nenhuns - processos acordados para testar as ferramentas de IA antes de as distribuir para utilização pública.

Este cenário reflecte-se em todo o mundo. O aumento rápido da adoção da IA não deve ser feito à custa do escrutínio e da análise.