Bem-vindo ao nosso resumo semanal de notícias sobre a IA criada por humanos.

Esta semana, a OpenAI distribuiu produtos API.

O projeto de lei da Califórnia sobre a segurança da IA foi morto.

E a NVIDIA surpreendeu-nos com um poderoso modelo aberto.

Vamos lá ver.

Aí vêm os agentes

A OpenAI não anunciou quaisquer novos modelos (ou Sora) no seu evento Dev Day, mas os programadores ficaram entusiasmados com as novas funcionalidades da API. A API Realtime será um divisor de águas para criar aplicações mais inteligentes que falem com os utilizadores e até actuem como agentes.

A demonstração foi muito fixe.

Houve rumores de que a OpenAI iria enveredar por uma via "com fins lucrativos" e conceder a Sam Altman biliões de dólares em acções, mas Altman rejeitou-os. Mesmo assim, a empresa está a tentar obter mais investimento e espera obter algum retorno do seu dinheiro.

A Apple integrou os modelos da OpenAI nos seus dispositivos, mas desistiu da última ronda de financiamento da OpenAI que se espera venha a obter cerca de $6,5 mil milhões.

Não sabemos ao certo porque é que a Apple não quer uma fatia do bolo da OpenAI, mas poderá ter algo a ver com novos desenvolvimentos com a sua Apple Inteligência. Ou talvez esteja relacionado com a exigência de exclusividade de Sam Altman.

Diga-me que não tem fosso sem me dizer que não tem fosso. pic.twitter.com/3I18MosvOg

- Pedro Domingos (@pmddomingos) 3 de outubro de 2024

Matar o projeto de lei

Gavin Newsom teve de decidir entre impor um limite de segurança aos criadores de IA ou deixá-los avançar a todo o vapor. No final, decidiu vetar o projeto de lei SB 1047 da Califórnia sobre a segurança da IA e apresentou algumas razões interessantes para o fazer.

Será que já chegámos a um ponto em que enfrentamos verdadeiros riscos de IA?

Bem, a situação agravou-se rapidamente https://t.co/xhZCITRJjE pic.twitter.com/aLZn4blS8G

- AI Notkilleveryoneism Memes ⏸️ (@AISafetyMemes) 30 de setembro de 2024

Newsom assinou uma série de projectos de lei sobre IA no último mês relacionados com deepfakes, marcas de água de IA, segurança infantil, direitos de IA dos artistas e desinformação eleitoral. Na semana passada, assinou AB 2013, o que irá abanar as coisas para o criador do LLMs.

O projeto de lei diz que, até 1 de janeiro de 2026, os criadores terão de fornecer um resumo de alto nível do conjunto de dados de formação de quaisquer modelos criados a partir de 1 de janeiro de 2022, se o modelo for disponibilizado na Califórnia. Alguns desses requisitos podem revelar alguns segredos sujos.

Mais regulamentos da UE sobre a IA

A UE está claramente muito mais preocupada com a segurança da IA do que o resto do mundo. Ou isso ou então gostam de escrever e aprovar legislação. Esta semana deram início a um projeto de projeto de elaboração de um código de práticas de IA para tentar equilibrar inovação e segurança.

Quando vir quem lidera o grupo técnico de segurança, terá uma boa ideia de para que lado se inclinará.

Modelos de bases líquidas

Os modelos Transformer foram os que nos deram o ChatGPT, mas, recentemente, tem-se debatido muito se estarão à altura de dar o próximo salto na IA. Uma empresa chamada Liquid AI está a agitar as coisas com o seu Modelos de fundação líquida (LFMs).

Estas não são as típicas IAs generativas. As LFMs são especificamente optimizadas para gerir dados de contexto mais longo, o que as torna ideais para tarefas que têm de lidar com dados sequenciais como texto, áudio ou vídeo.

Os LFMs alcançam um desempenho impressionante com um modelo muito mais pequeno, menos memória e menos computação.

NVIDIA abre-se

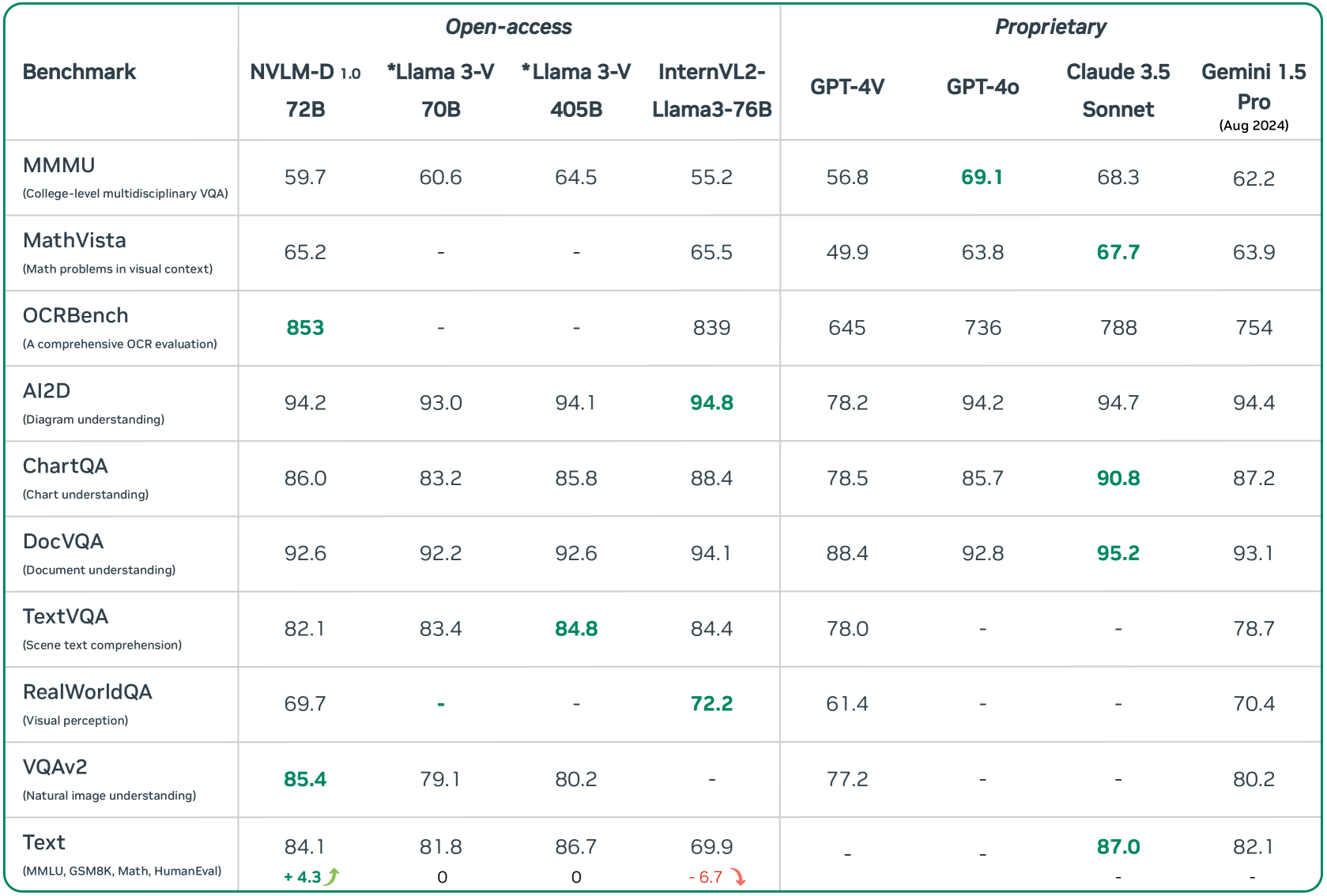

A Nvidia acaba de lançar um produto revolucionárioA NVLM é um modelo de IA de fonte aberta que enfrenta grandes empresas como a OpenAI e a Google. A sua nova linha NVLM 1.0, liderada pelo parâmetro topo de gama 72B NVLM-D-72B, brilha em tarefas de visão e de linguagem, ao mesmo tempo que melhora as capacidades apenas de texto.

Com pesos abertos e a promessa da NVIDIA de lançar o código, está a tornar-se mais difícil justificar o pagamento de modelos proprietários para muitos casos de utilização.

Basta dizer que sabe

Um novo estudo concluiu que os modelos linguísticos de grande dimensão (LLM) mais recentes são menos propensos a admitir quando não sabem uma resposta à pergunta de um utilizador. Quando os utilizadores fazem uma pergunta a estes modelos, é mais provável que inventem algo em vez de admitirem que não sabem a resposta.

O estudo sublinha a necessidade de uma mudança fundamental na conceção e no desenvolvimento da IA para fins gerais, especialmente quando é utilizada em áreas de alto risco. Os investigadores ainda estão a tentar perceber porque é que os modelos de IA estão tão interessados em agradar-nos em vez de dizerem: "Desculpe, não sei a resposta".

IA no interior

Parece que toda a gente está a colocar um rótulo de "IA" nos seus produtos para atrair clientes. Aqui estão algumas ferramentas alimentadas por IA que valem realmente a pena verificar.

Bluedot: Grave, transcreva e resuma as suas reuniões com notas geradas por IA sem um bot.

Guia: O Guidde transforma magicamente os seus fluxos de trabalho em guias de vídeo passo a passo, com locuções geradas por IA e imagens de nível profissional, tudo em apenas alguns cliques.

Noutras notícias...

Aqui estão algumas outras histórias de IA dignas de clique que apreciámos esta semana:

- Os óculos inteligentes com IA da Meta aumentam preocupações com a privacidade e os dados dos utilizadores.

- As ferramentas de IA são revelar segredos incómodos da empresa.

- O MIT faz um avanço na robótica para lidar com o caos da vida real.

- LinkedIn enfrenta complicações legais sobre a integração da IA.

- Anthropic contratações Durk Kingma, cofundador da OpenAI.

- A Y Combinator está a ser criticada depois de ter apoiado uma empresa de IA que admite que basicamente clonou outra empresa de IA.

E é tudo.

Se vive na Califórnia, gostaríamos de saber o que pensa do facto de o SB 1047 ter sido vetado. Trata-se de uma oportunidade perdida para a segurança da IA ou de um passo positivo que nos permitirá obter a AGI em breve? Com poderosos modelos de código aberto como a nova bomba da NVIDIA, vai ser mais difícil regular os LLMs de qualquer forma.

A API em tempo real da OpenAI foi o destaque desta semana. Mesmo que não seja um programador, a perspetiva de interagir com bots de atendimento ao cliente mais inteligentes que falam consigo é muito fixe. A menos que trabalhe como agente de apoio ao cliente e queira manter o seu emprego.

Diga-nos o que pensa, seguir-nos no Xe envie-nos ligações para coisas interessantes sobre IA que nos possam ter escapado.