O fundador e CEO da HyperWrite, Matt Shumer, anunciou que seu novo modelo, o Reflection 70B, usa um truque simples para resolver alucinações LLM e fornece resultados de benchmark impressionantes que superam modelos maiores e até mesmo fechados como o GPT-4o.

Shumer colaborou com o fornecedor de dados sintéticos, Glaive, para criar o novo modelo, que se baseia no modelo Llama 3.1-70B Instruct da Meta.

No anúncio de lançamento no Hugging Face, Shumer disse. "O Reflection Llama-3.1 70B é (atualmente) o melhor LLM de código aberto do mundo, treinado com uma nova técnica chamada Reflection-Tuning que ensina um LLM a detetar erros no seu raciocínio e a corrigir o curso."

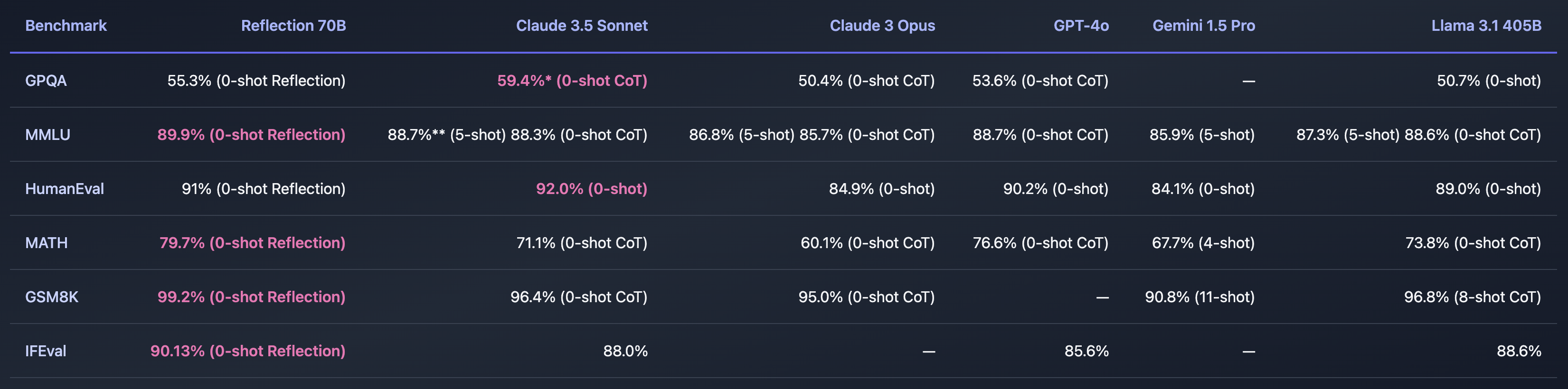

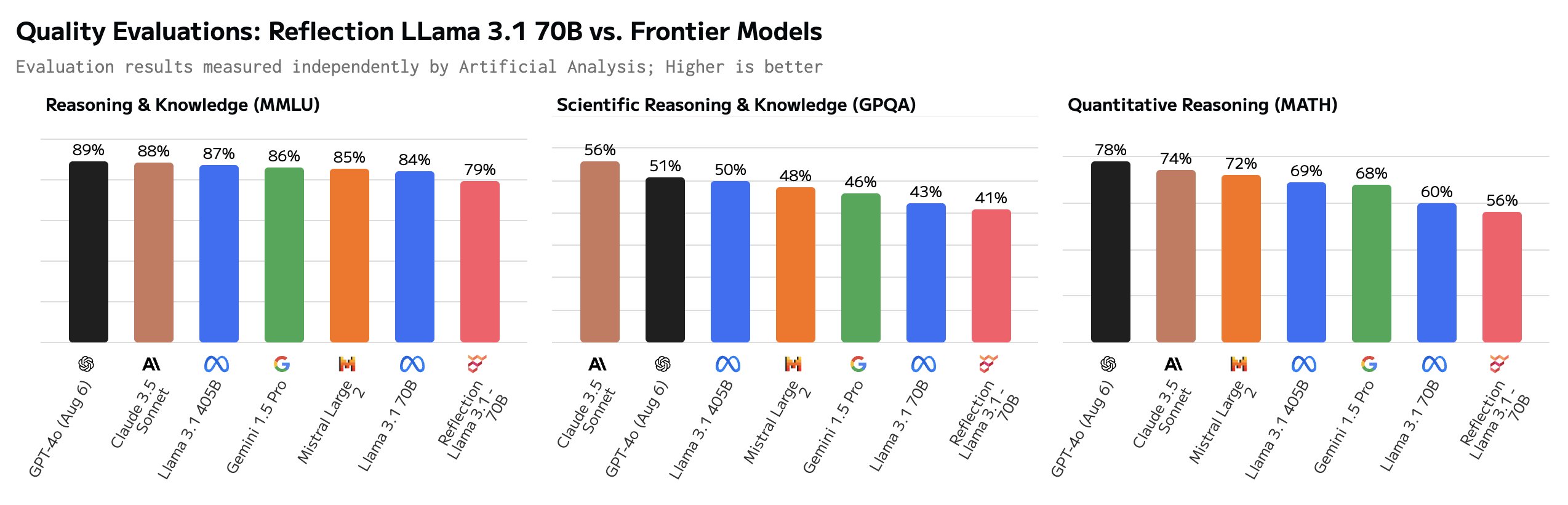

Se Shumer encontrasse uma maneira de resolver o problema das alucinações da IA, isso seria incrível. As referências que partilhou parecem indicar que o Reflection 70B está muito à frente de outros modelos.

O nome do modelo é uma referência à sua capacidade de auto-correção durante a inferência. Shumer não revela muito, mas explica que o modelo reflecte sobre a sua resposta inicial a um pedido e só a emite quando estiver convencido de que está correta.

Shumer diz que uma versão 405B do Reflection está a ser trabalhada e que vai arrasar com outros modelos, incluindo o GPT-4o, quando for apresentada na próxima semana.

O Reflection 70B é uma fraude?

Será que tudo isso é bom demais para ser verdade? O Reflection 70B está disponível para download no Huging Face, mas os primeiros testadores não foram capazes de duplicar o desempenho impressionante que os benchmarks de Shumer mostraram.

O Parque infantil de reflexão permite-lhe experimentar o modelo, mas diz que, devido à elevada procura, a demonstração está temporariamente inativa. As sugestões de prompt "Contar 'r' em morango" e "9,11 vs 9,9" sugerem que o modelo acerta esses prompts complicados. Mas alguns utilizadores afirmam que o Reflection foi especificamente concebido para responder a estas questões.

Alguns utilizadores questionaram os impressionantes valores de referência. O GSM8K de mais de 99% parecia especialmente suspeito.

Olá, Matt! Isso é muito interessante, mas estou bastante surpreso ao ver uma pontuação GSM8k de mais de 99%. No meu entender, é provável que mais de 1% do GSM8k estejam mal rotulados (a resposta correta está realmente errada)!

- Hugh Zhang (@hughbzhang) 5 de setembro de 2024

Algumas das respostas verdadeiras no conjunto de dados GSM8K estão de facto erradas. Por outras palavras, a única forma de obter uma pontuação superior a 99% no GSM8K era fornecer as mesmas respostas incorrectas a esses problemas.

Depois de alguns testes, os utilizadores dizem que o Reflection é pior do que o Llama 3.1 e que, na verdade, era apenas o Llama 3 com o ajuste LoRA aplicado.

Em resposta ao feedback negativo, Shumer publicou uma explicação no X dizendo: "Atualização rápida - voltámos a carregar os pesos, mas continua a haver um problema. Começámos a treinar de novo para eliminar qualquer problema possível. Deve estar pronto em breve".

Shumer explicou que havia uma falha na API e que eles estavam trabalhando nisso. Enquanto isso, ele forneceu acesso a uma API secreta e privada para que os céticos pudessem experimentar o Reflection enquanto eles trabalhavam na correção.

E é aí que as rodas parecem sair, já que algumas perguntas cuidadosas parecem mostrar que a API é realmente apenas um invólucro do Claude 3.5 Sonnet.

"Reflection API" é um wrapper sonnet 3.5 com prompt. E estão atualmente a disfarçá-lo filtrando a cadeia 'claude'.https://t.co/c4Oj8Y3Ol1 https://t.co/k0ECeo9a4i pic.twitter.com/jTm2Q85Q7b

- José (@RealJosephus) 8 de setembro de 2024

Testes subseqüentes alegaram que a API retornou resultados de Llama e GPT-4o. Shumer insiste que os resultados originais são exactos e que estão a trabalhar para corrigir o modelo descarregável.

Será que os céticos são um pouco prematuros em chamar Shumer de vigarista? Talvez o lançamento tenha sido apenas mal conduzido e o Reflection 70B seja realmente um modelo inovador de código aberto. Ou talvez seja mais um exemplo de propaganda de IA para angariar capital de risco de investidores que procuram a próxima grande novidade em IA.

Teremos de esperar um dia ou dois para ver como isto se desenrola.