A Alibaba lançou mais de 100 modelos de IA de fonte aberta, incluindo o Qwen 2.5 72B, que supera outros modelos de fonte aberta em termos de matemática e de codificação.

Grande parte da atenção da indústria de IA em modelos de código aberto tem sido sobre os esforços da Meta com o Llama 3, mas o Qwen 2.5 da Alibaba fechou a lacuna significativamente. A recém-lançada família de modelos Qwen 2.5 varia em tamanho de 0,5 a 72 bilhões de parâmetros com modelos básicos generalizados, bem como modelos focados em tarefas muito específicas.

A Alibaba afirma que estes modelos vêm com "conhecimentos melhorados e capacidades mais fortes em matemática e codificação", com modelos especializados centrados na codificação, matemática e múltiplas modalidades, incluindo linguagem, áudio e visão.

A Alibaba Cloud também anunciou uma atualização para o seu modelo principal proprietário Qwen-Max, que não foi lançado como código aberto. Os benchmarks do Qwen 2.5 Max parecem bons, mas é o modelo Qwen 2.5 72B que tem gerado a maior parte do entusiasmo entre os fãs do código aberto.

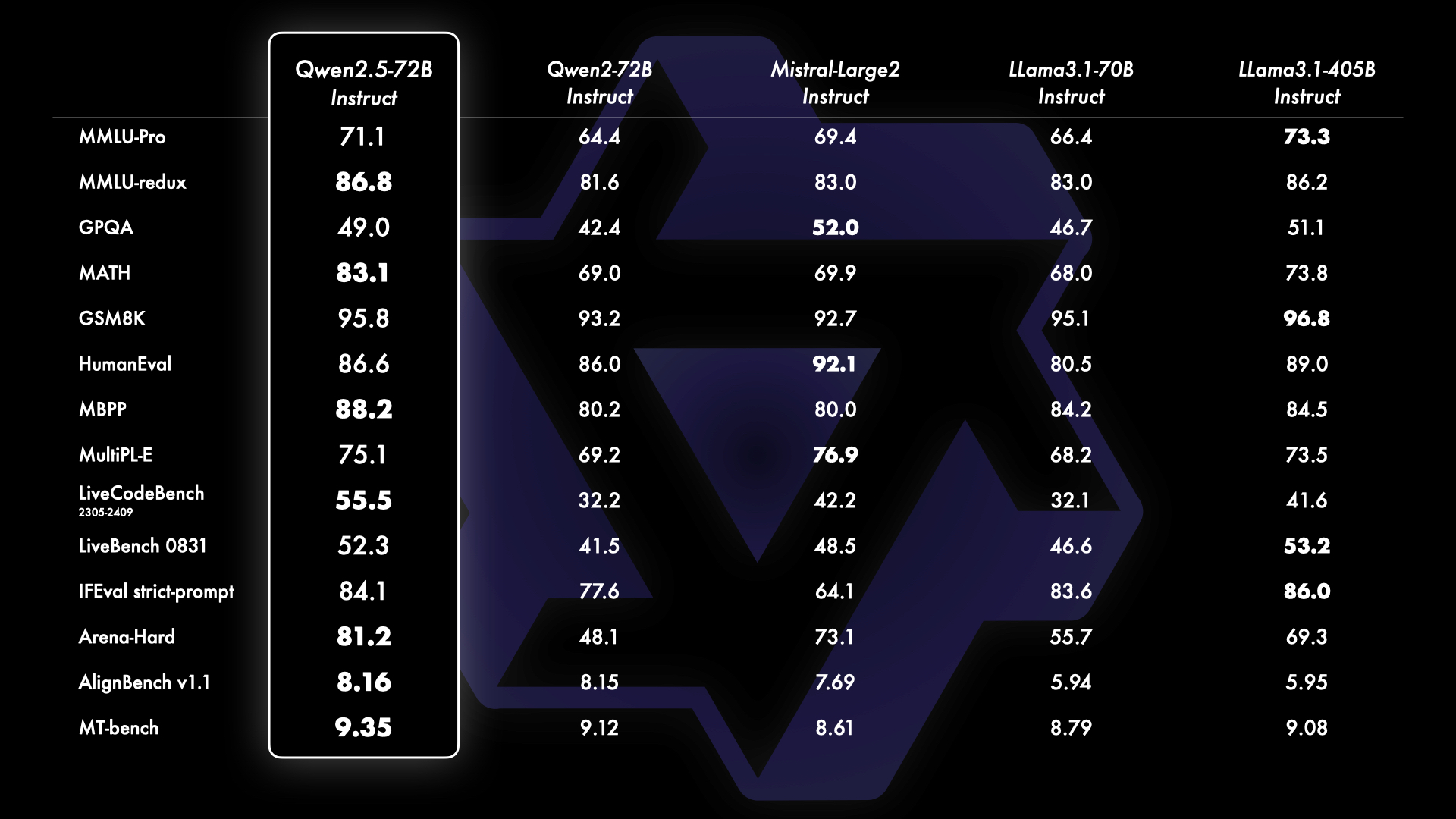

Os testes de referência mostram que o Qwen 2.5 72B está a bater o topo de gama muito maior da Meta Lhama 3.1 405B em várias frentes, especialmente em matemática e programação. O fosso entre os modelos de código aberto e os modelos proprietários, como os da OpenAI e da Google, também está a diminuir rapidamente.

Os primeiros utilizadores do Qwen 2.5 72B mostram que o modelo fica apenas a um passo do Sonnet 3.5 e até mesmo do OpenAImodelos o1 da 's na codificação.

O Qwen 2.5 de código aberto bate os modelos o1 em termos de codificação 🤯🤯

O Qwen 2.5 tem resultados mais elevados do que os modelos o1 em termos de codificação no Livebench AI

O Qwen está mesmo abaixo do Sonnet 3.5 e, para um modo de código aberto, isso é fantástico!

o1 é bom em alguns códigos difíceis, mas péssimo em problemas de preenchimento de código e... pic.twitter.com/iazam61eP9

- Bindu Reddy (@bindureddy) 20 de setembro de 2024

Alibaba diz que esses novos modelos foram todos treinados em seu conjunto de dados em grande escala, abrangendo até 18 trilhões de tokens. Os modelos Qwen 2.5 vêm com uma janela de contexto de até 128k e podem gerar saídas de até 8k tokens.

A mudança para modelos gratuitos mais pequenos, mais capazes e de código aberto terá provavelmente um impacto maior em muitos utilizadores do que os modelos mais avançados como o o1. As capacidades de ponta e no dispositivo destes modelos significam que se pode tirar muito partido de um modelo gratuito executado no portátil.

O modelo mais pequeno Qwen 2.5 oferece codificação de nível GPT-4 por uma fração do custo, ou mesmo gratuitamente se tiver um portátil decente para o executar localmente.

Temos o GPT-4 para codificar em casa! Pesquisei OpenAI?ref_src=twsrc%5Etfw”>@OpenAI Os resultados do GPT-4 0613 para vários parâmetros de referência e comparados com @Alibaba_Qwen 2.5 Codificador 7B. 👀

> 15 meses após o lançamento do GPT-0613, temos um LLM aberto sob o Apache 2.0, que tem o mesmo desempenho. 🤯

> Preços do GPT-4... pic.twitter.com/2szw5kwTe5

- Philipp Schmid (@_philschmid) 22 de setembro de 2024

Para além dos LLMs, a Alibaba lançou uma atualização significativa do seu modelo de linguagem de visão com a introdução do Qwen2-VL. O Qwen2-VL pode compreender vídeos com duração superior a 20 minutos e suporta respostas a perguntas baseadas em vídeo.

Foi concebido para integração em telemóveis, automóveis e robôs para permitir a automatização de operações que requerem compreensão visual.

A Alibaba também revelou um novo modelo de texto para vídeo como parte do seu gerador de imagens, a grande família de modelos Tongyi Wanxiang. O Tongyi Wanxiang AI Video pode produzir conteúdo de vídeo de qualidade cinematográfica e animação 3D com vários estilos artísticos com base em instruções de texto.

As demos parecem impressionantes e a ferramenta é gratuita, embora seja necessário um número de telemóvel chinês para inscrever-se aqui. Sora vai ter uma concorrência séria quando, ou se, a OpenAI acabar por o lançar.