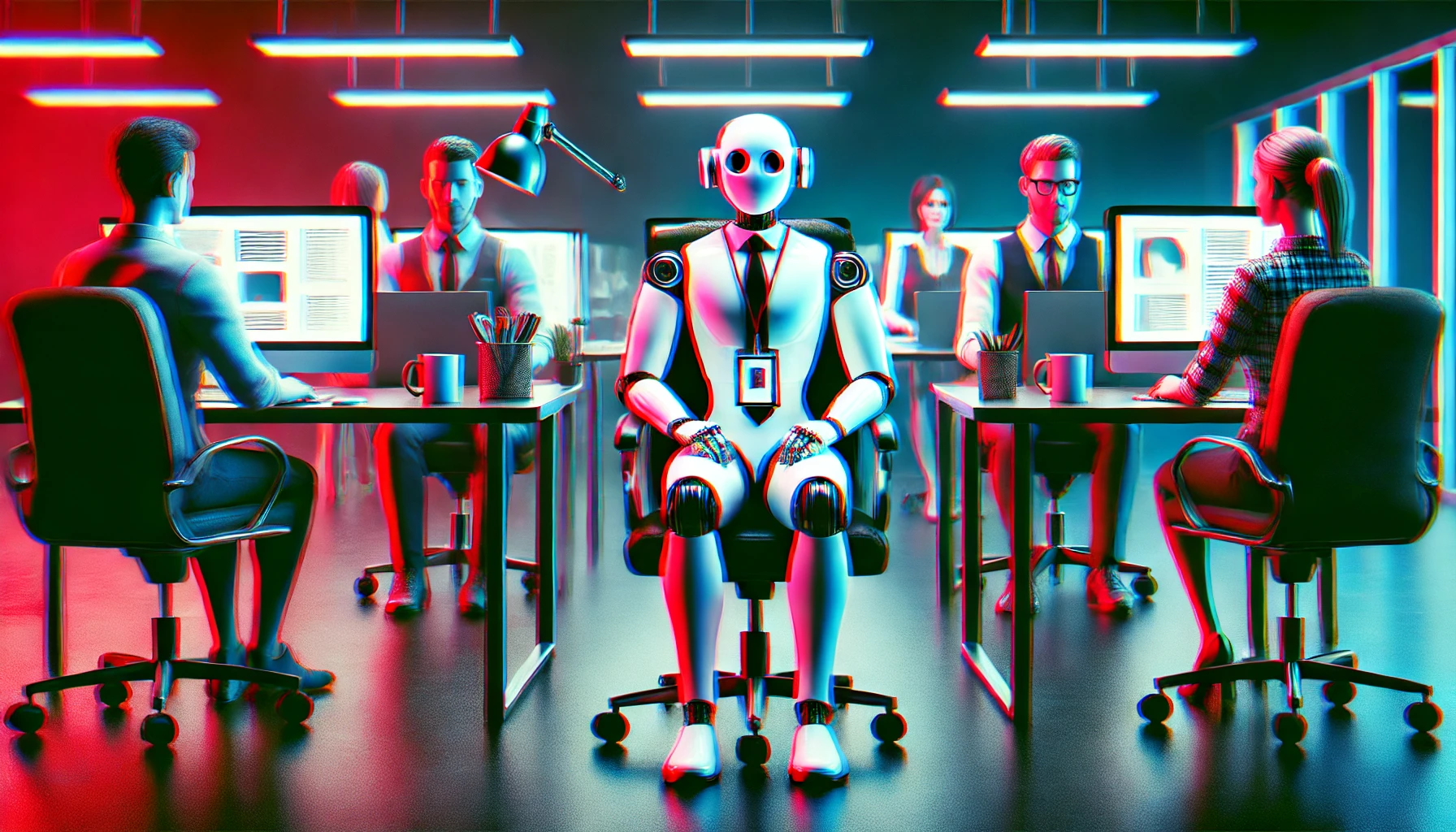

A empresa de software de RH Lattice, fundada pelo irmão de Sam Altman, Jack Altman, foi a primeira a dar aos trabalhadores digitais registos oficiais de empregados, mas cancelou a medida apenas 3 dias depois.

Sarah Franklin, Directora Executiva da Lattice anunciado no LinkedIn que a Lattice "fez história ao tornar-se a primeira empresa a liderar o emprego responsável de 'trabalhadores digitais' de IA, criando um registo digital dos trabalhadores para os governar com transparência e responsabilidade".

Franklin afirmou que os "trabalhadores digitais" serão integrados de forma segura, formados e ser-lhes-ão atribuídos objectivos, métricas de desempenho, acesso a sistemas adequados e até um gestor responsável".

Se acha que este movimento para antropomorfizar a IA é um passo demasiado longe e surdo face à perda iminente de postos de trabalho, então não está sozinho.

Houve uma reação rápida da comunidade em linha, incluindo de pessoas do sector da IA.

Sawyer Middeleer, chefe de equipe da plataforma de vendas de IA Aomni, comentou o post dizendo: "Essa estratégia e mensagens erram o alvo em grande estilo, e eu digo isso como alguém que está construindo uma empresa de IA. Tratar agentes de IA como funcionários desrespeita a humanidade de seus funcionários reais. Pior, isso implica que você vê os humanos simplesmente como "recursos" a serem otimizados e medidos em relação às máquinas.

Ed Zitron, diretor executivo da empresa de relações com os meios tecnológicos EZPR, perguntou a Franklin: "No caso de um esforço de sindicalização na Lattice, estes funcionários da IA poderão votar?"

A Lattice apercebeu-se rapidamente de que o mundo talvez ainda não esteja preparado para os "empregados digitais". Apenas três dias após o anúncio, a empresa diz agora que cancelou o projeto.

São trabalhadores?

Está a tornar-se demasiado fácil humanizar os modelos de IA e os robôs. Eles soam como nós, emocionam-se e são muitas vezes mais empáticos do que nós.

Mas será que são conscientes ou sencientes ao ponto de devermos considerar a possibilidade de lhes conceder direitos de "trabalhadores"? A Lattice pode estar simplesmente a tentar antecipar-se a esta questão inevitável, embora de forma um pouco desajeitada.

Claude 3 engenheiros surpreendidos pela Opus quando revelou uma medida de auto-consciência durante os testes. A Google despediu um dos seus engenheiros em 2022, quando este afirmou que o seu modelo de IA demonstrava ter consciência, e os investigadores afirmam que o GPT-4 passou no teste de Turing.

O facto de os modelos de IA terem ou não uma medida de consciência pode nem sequer ser o que decide se os empregados digitais terão direitos no futuro.

Em abril, os investigadores publicou um estudo interessante na revista Neuroscience of Consciousness. Perguntaram a 300 cidadãos norte-americanos se acreditavam que o ChatGPT era consciente e tinha experiências subjectivas como sentimentos e sensações. Mais de dois terços dos inquiridos responderam que sim, apesar de a maioria dos especialistas discordar.

Os investigadores descobriram que quanto mais frequentemente as pessoas utilizavam ferramentas como o ChatGPT, maior era a probabilidade de lhe atribuírem algum nível de consciência.

A nossa reação inicial automática pode ser recusar a ideia de um "colega" de IA ter direitos laborais. Esta investigação sugere que quanto mais interagirmos com a IA, maior será a probabilidade de simpatizarmos com ela e considerarmos a possibilidade de a acolher na equipa.