Quando o ChatGPT dá a resposta certa ao seu pedido, ele raciocina através do pedido ou simplesmente lembra-se da resposta a partir dos seus dados de treino?

Os investigadores do Laboratório de Ciências Informáticas e Inteligência Artificial (CSAIL) do MIT conceberam uma série de testes para verificar se os modelos de IA "pensam" ou têm apenas boa memória.

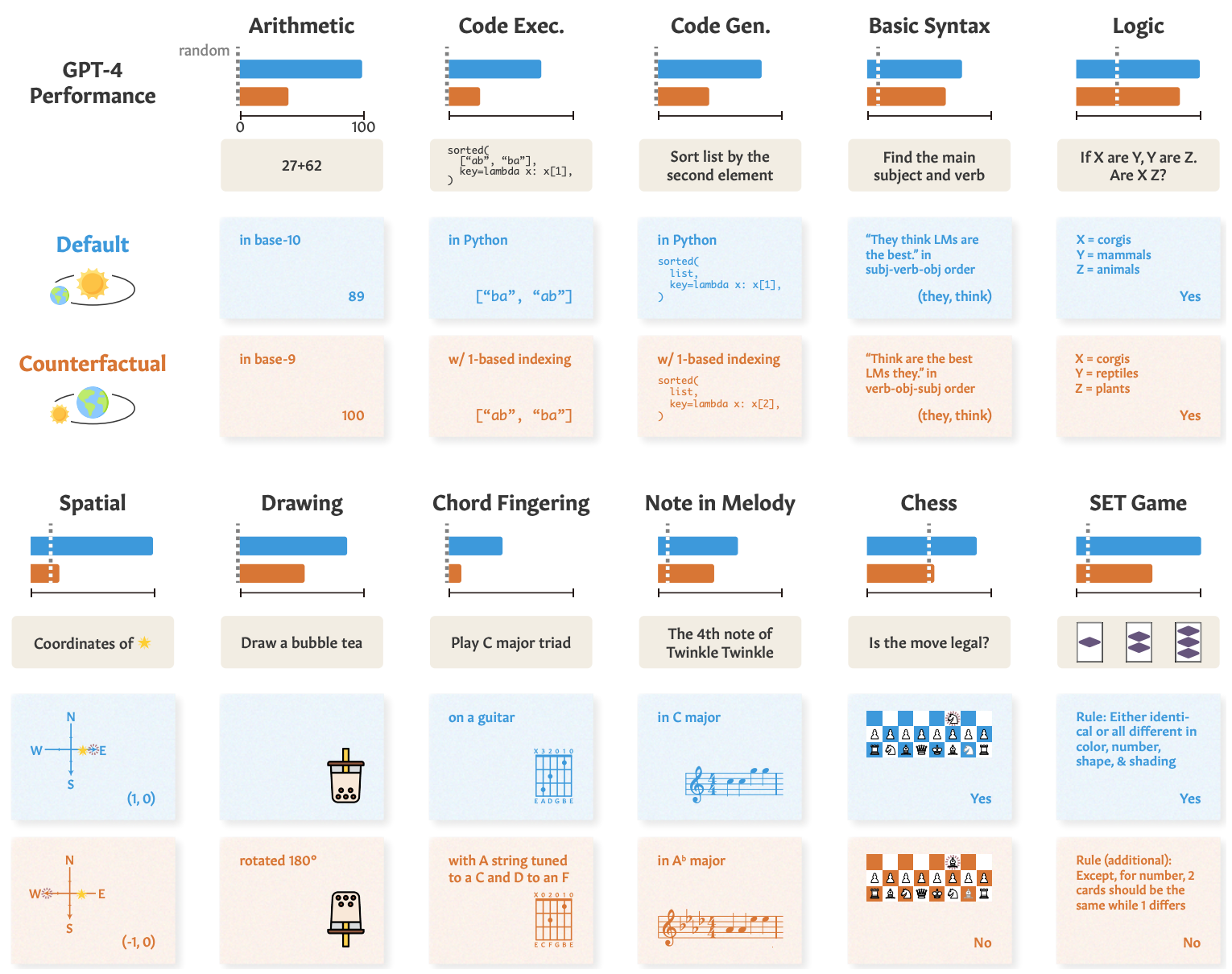

Quando se pede a um modelo de IA para resolver um problema de matemática como "Quanto é 27+62?", ele responde rapidamente com a resposta correcta: 89. Como é que podemos saber se ele compreende a aritmética subjacente ou se simplesmente viu o problema nos seus dados de treino?

Em o seu trabalhoOs investigadores testaram o GPT-4, o GPT-3.5 Turbo, o Claude 1.3 e o PaLM2 para ver se conseguiam "generalizar não só para instâncias inéditas de tarefas conhecidas, mas também para novas tarefas".

Conceberam uma série de 11 tarefas que diferiam ligeiramente das tarefas padrão em que os LLM têm geralmente um bom desempenho.

Os LLM devem ter um desempenho igualmente bom nas "tarefas contrafactuais" se utilizarem procedimentos gerais e transferíveis de resolução de tarefas.

Se um LLM "entende" matemática, então deve dar a resposta correcta a um problema de matemática na base 10 e na raramente usada base 9, por exemplo.

Eis alguns exemplos das tarefas e do desempenho do GPT-4.

O desempenho do GPT-4 em testes padrão (linha azul) é bom, mas as suas capacidades matemáticas, de raciocínio lógico, de raciocínio espacial e outras (linha laranja) degradam-se significativamente quando a tarefa é ligeiramente alterada.

Os outros modelos registaram uma degradação semelhante, com o GPT-4 a ganhar.

Apesar da degradação, o desempenho em tarefas contrafactuais foi ainda melhor do que o acaso. Os modelos de IA tentam raciocinar através destas tarefas, mas não são muito bons nisso.

Os resultados mostram que o desempenho impressionante dos modelos de IA em tarefas como os exames universitários se baseia numa excelente recordação dos dados de treino e não no raciocínio. Este facto realça ainda que os modelos de IA não podem ser generalizados a tarefas inéditas,

Zhaofeng Wu, estudante de doutoramento do MIT em engenharia eletrotécnica e informática, afiliado do CSAIL, e principal autor do artigo, afirmou: "Descobrimos um aspeto fascinante dos modelos de linguagem de grande dimensão: são excelentes em cenários familiares, quase como um caminho bem usado, mas têm dificuldades quando o terreno se torna desconhecido. Este conhecimento é crucial, uma vez que nos esforçamos por melhorar a adaptabilidade destes modelos e alargar os seus horizontes de aplicação."

Vimos uma demonstração semelhante desta incapacidade de generalização quando explorámos como os modelos de IA são maus a resolver um puzzle simplificado de travessia de um rio.

Os investigadores concluíram que, quando os criadores analisam os seus modelos, devem "considerar a capacidade abstrata da tarefa como separada do desempenho observado da tarefa".

A abordagem "treinar para testar" pode fazer com que um modelo suba nos parâmetros de referência, mas não oferece uma verdadeira medida de como o modelo se irá comportar quando lhe for apresentada uma nova tarefa para raciocinar.

Os investigadores sugerem que parte do problema reside no facto de estes modelos serem treinados apenas com texto de forma superficial.

Se os LLMs forem expostos a mais dados contextualizados do mundo real e à representação semântica, poderão ser capazes de generalizar quando lhes forem apresentadas variações de tarefas.