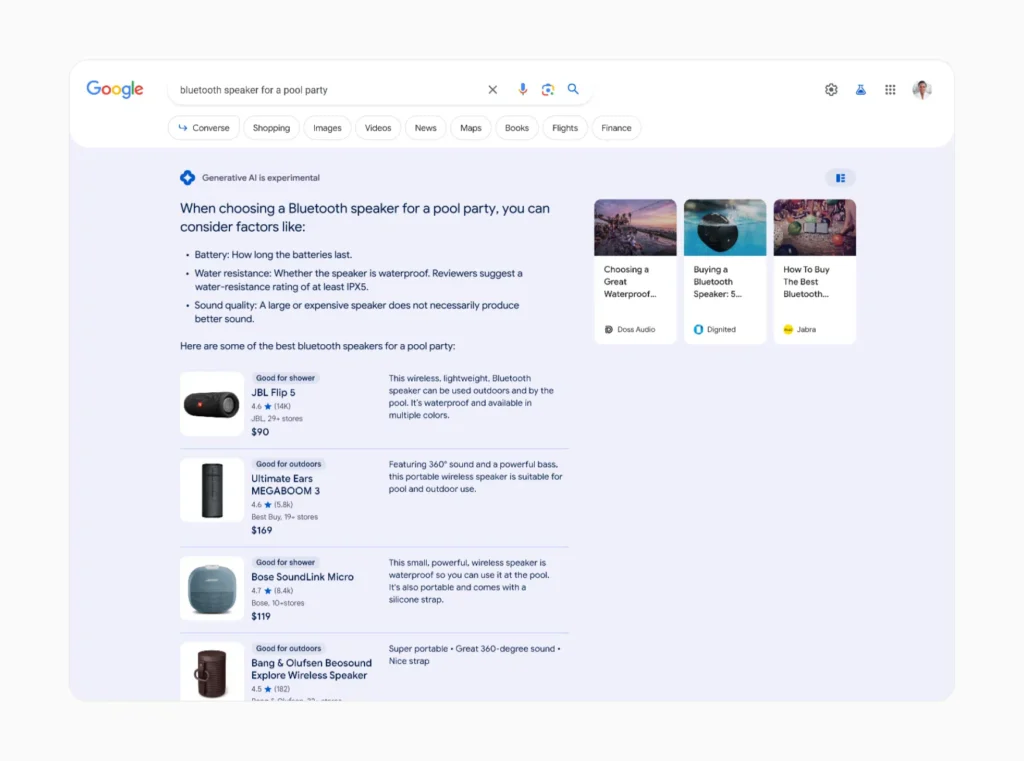

Na última conferência emblemática da Google, a I/O, a empresa reforçou a sua Search Generative Experience (SGE), que irá incorporar a IA generativa na Pesquisa Google.

O SGE, que tem como objetivo fornecer respostas geradas por IA a mais de mil milhões de utilizadores até ao final de 2024, baseia-se no Gemini, a família de modelos de linguagem de grande dimensão (LLM) da Google, para gerar respostas de tipo humano às consultas de pesquisa.

Em vez de uma pesquisa tradicional no Google, que apresenta principalmente hiperligações, ser-lhe-á apresentado um resumo gerado por IA juntamente com outros resultados.

Esta "visão geral da IA" foi criticada por fornecer informações sem sentidoe a Google está a trabalhar rapidamente em soluções antes de iniciar a sua implementação em massa.

Mas, para além de recomendar a adição de cola à pizza e de dizer que as pitões são mamíferos, há outro problema com a nova estratégia de pesquisa baseada em IA da Google: a sua pegada ambiental.

Porque é que a SGE consome muitos recursos

Enquanto os motores de pesquisa tradicionais se limitam a recuperar informações existentes na Internet, os sistemas de IA generativa como o SGE têm de criar conteúdos inteiramente novos para cada consulta.

Este processo requer muito mais potência computacional e energia do que os métodos de pesquisa convencionais.

Estima-se que são efectuadas diariamente entre 3 e 10 mil milhões de pesquisas no Google. O impacto da aplicação da IA, mesmo que a uma pequena percentagem dessas pesquisas, pode ser incrível.

Sasha Luccioni, investigadora da empresa de IA Hugging Face, que estuda o impacto ambiental destas tecnologias, discutiu recentemente o aumento acentuado do consumo de energia que a SGE poderá provocar.

Luccioni e a sua equipa estimam que a geração de informações de pesquisa com IA pode exigir 30 vezes mais energia do que uma pesquisa convencional.

"Faz sentido, certo? Enquanto uma consulta de pesquisa banal encontra dados existentes na Internet, aplicações como a AI Overviews têm de criar informações totalmente novas" disse à Scientific American.

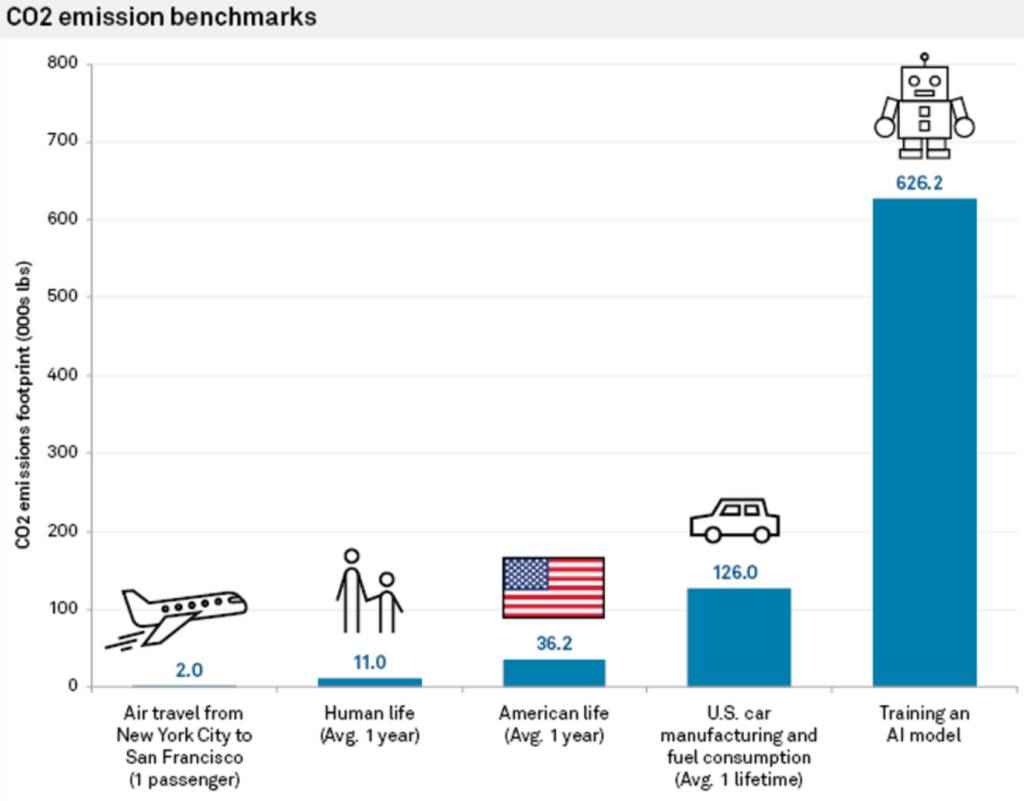

Em 2023, Luccioni e os seus colegas descobriram que o treino do LLM BLOOM emitia gases com efeito de estufa equivalentes a 19 quilogramas de CO2 por dia de utilização, ou seja, a quantidade gerada pela condução de 49 milhas num automóvel médio a gasolina. Também descobriram que a geração de apenas duas imagens com recurso à IA podem consumir tanta energia como o carregamento completo de um smartphone médio.

Estudos anteriores estimaram que as emissões de CO2 associadas ao treino de um modelo de IA podem exceder as de centenas de voos comerciais ou as de um automóvel médio durante o seu tempo de vida.

Num entrevista à Reuters no ano passadoO próprio John Hennessy, presidente da empresa-mãe da Google, a Alphabet, admitiu o aumento dos custos associados à pesquisa baseada em IA.

"Uma bolsa com um grande modelo linguístico pode custar dez vezes mais do que uma pesquisa tradicional", afirmou, embora preveja que os custos diminuam à medida que os modelos forem sendo aperfeiçoados.

A pressão da pesquisa de IA sobre as infra-estruturas e os recursos

Prevê-se que os centros de dados que albergam servidores de IA dupliquem o seu consumo de energia até 2026, utilizando potencialmente tanto poder como país pequeno.

Com os fabricantes de chips, como a NVIDIA, a lançarem chips maiores e mais potentes, em breve poderá ser necessário o equivalente a várias centrais nucleares para executar cargas de trabalho de IA em grande escala.

Quando as empresas de IA respondem a perguntas sobre a forma como isto pode ser sustentado, citam normalmente o aumento da eficiência e da capacidade das energias renováveis e a melhoria da eficiência energética do hardware de IA.

No entanto, a transição para fontes de energia renováveis nos centros de dados está a revelar-se lenta e complexa.

Como explicou Shaolei Ren, engenheiro informático da Universidade da Califórnia, Riverside, que estuda a IA sustentável, "há um desfasamento entre a oferta e a procura de energia renovável. A natureza intermitente da produção de energia renovável muitas vezes não corresponde à energia constante e estável exigida pelos centros de dados".

Devido a este desfasamento, as centrais de combustíveis fósseis estão a ser mantidas em funcionamento durante mais tempo do que o previsto em zonas com elevada concentração de infra-estruturas tecnológicas.

Outra solução para os problemas energéticos reside no hardware de IA energeticamente eficiente. O projeto novo chip Blackwell é muitas vezes mais eficiente em termos energéticos do que os seus antecessores, e outros empresas como a Delta estão a trabalhar em hardware eficiente para centros de dados.

Rama Ramakrishnan, professor da MIT Sloan School of Management, explicou que, embora seja provável que o número de pesquisas efectuadas através dos LLM aumente, o custo por consulta parece diminuir à medida que as empresas trabalham para tornar o hardware e o software mais eficientes.

Mas será isso suficiente para compensar o aumento da procura de energia? "É difícil de prever", diz Ramakrishnan. "O meu palpite é que provavelmente vai subir, mas provavelmente não vai subir drasticamente."

À medida que a corrida à IA aquece, a mitigação dos impactos ambientais tornou-se necessária. A necessidade é a mãe da invenção, e as empresas tecnológicas estão sob pressão para criar soluções que mantenham a dinâmica da IA.

Hardware energeticamente eficiente, energias renováveis e até mesmo a energia de fusão pode abrir caminho a um futuro mais sustentável para a IA, mas o caminho está cheio de incertezas.

A SGE poderá também afetar o abastecimento de água

Podemos também especular sobre as necessidades de água criadas pelo SGE, que poderiam refletir os vastos aumentos no consumo de água dos centros de dados atribuídos à indústria de IA generativa.

De acordo com relatórios ambientais recentes da Microsoft, o consumo de água tem aumentou até 50% em algumas regiões, com o consumo de água do centro de dados de Las Vegas a duplicar desde 2022. Os relatórios da Google também registaram um aumento de 20% nas despesas de água dos centros de dados em 2023, em comparação com 2022.

Ren atribui a maior parte deste crescimento à IA, afirmando: "É justo dizer que a maior parte do crescimento se deve à IA, incluindo o forte investimento da Microsoft em IA generativa e a parceria com a OpenAI."

Ren calculou que cada interação com o ChatGPT, que consiste em 5 a 50 mensagens, consome uns impressionantes 500 ml de água.

Num papel publicado em 2023, a equipa de Ren escreveu: "A procura global de IA pode ser responsável por 4,2 - 6,6 mil milhões de metros cúbicos de captação de água em 2027, o que é mais do que a captação anual total de água de 4 - 6 Dinamarca ou metade do Reino Unido".

Utilizando a investigação de Ren, podemos criar alguns cálculos de guardanapo sobre a forma como o SGE da Google pode ser considerado nestas previsões.

Digamos que a Google processa uma média de 8,5 mil milhões de pesquisas diárias em todo o mundo. Partindo do princípio de que mesmo uma fração destas pesquisas, digamos 10%, utiliza o SGE e gera respostas baseadas em IA com uma média de 50 palavras por resposta, o consumo de água pode ser fenomenal.

Utilizando a estimativa de Ren de 500 mililitros de água por cada 5 a 50 pedidos (digamos, uma única sessão no Google SGE), podemos calcular aproximadamente que 850 milhões de pesquisas efectuadas com o SGE (10% das pesquisas diárias do Google) consumiriam cerca de 425 milhões de litros de água por dia.

Isto é equivalente ao diário consumo de água de uma cidade com uma população de mais de 2,5 milhões de pessoas.

Na realidade, o consumo real de água pode variar em função de factores como a eficiência dos centros de dados da Google e a implementação e escala específicas do SGE.

No entanto, é muito razoável especular que o SGE e outras formas de pesquisa de IA irão aumentar ainda mais a utilização de recursos de IA.

Serão as experiências globais de IA como a SGE sustentáveis a uma escala maciça? Estão em jogo inúmeros factores, mas não será fácil.