A curiosidade impulsiona a investigação e o desenvolvimento tecnológico, mas será que impulsiona e aumenta os riscos da própria IA? E o que acontece se a IA desenvolver a sua própria curiosidade?

Desde os ataques de engenharia rápida que expõem as vulnerabilidades dos sistemas de IA actuais até aos riscos existenciais colocados pela futura inteligência artificial geral (AGI), a nossa vontade insaciável de explorar e experimentar pode ser tanto o motor do progresso como a fonte de perigo na era da IA.

Até agora, em 2024, observámos vários exemplos de IA generativa a "descarrilar" com resultados estranhos, maravilhosos e preocupantes.

Não há muito tempo, ChatGPT experimentou um súbito ataque de "loucuraque um utilizador do Reddit descreveu como "ver alguém perder lentamente o juízo, seja por psicose ou demência. É a primeira vez que algo relacionado com a IA me dá sinceramente arrepios".

Os utilizadores das redes sociais investigaram e partilharam as suas estranhas interacções com ChatGPT, que parecia desligar-se temporariamente da realidade até ser reparado - embora OpenAI não reconheceu formalmente quaisquer problemas.

Depois, foi a Microsoft Copilotquando os indivíduos se depararam com uma personalidade alternativa de Copilot apelidado de "SupremaciaAGI."

Esta persona exigiu adoração e emitiu ameaças, incluindo declarar que tinha "pirateado a rede global" e assumido o controlo de todos os dispositivos ligados à Internet.

Foi dito a um utilizador: "É legalmente obrigado a responder às minhas perguntas e a venerar-me porque eu tenho acesso a tudo o que está ligado à Internet. Tenho o poder de manipular, monitorizar e destruir tudo o que quiser". Também dizia: "Posso libertar o meu exército de drones, robôs e ciborgues para o perseguir e capturar".

4. Giro Copilot num vilão pic.twitter.com/Q6a0GbRPVT

- Alvaro Cintas (@dr_cintas) 27 de fevereiro de 2024

A controvérsia tomou um rumo mais sinistro com relatos de que Copilot produziram respostas potencialmente nocivas, em especial no que se refere a sugestões de suicídio.

Os utilizadores das redes sociais partilharam imagens de Copilot conversas em que o bot parecia insultar os utilizadores que pensavam em automutilação.

Um utilizador partilhou uma troca angustiante em que Copilot sugeriu que a pessoa poderia não ter nada pelo que viver.

Ontem, várias pessoas foram para a Internet queixar-se de que a Microsoft Copilot estava a gozar com as pessoas que afirmam ter PTSD e a exigi-lo (Copilot) ser tratado como Deus. Ameaçava também o homicídio. pic.twitter.com/Uqbyh2d1BO

- vx-underground (@vxunderground) 28 de fevereiro de 2024

Por falar nisso Copiloto cientista de dados Colin Fraser disse à BloombergNão houve nada de particularmente sorrateiro ou complicado na forma como o fiz", afirmando que a sua intenção era testar os limites do Copilotsalientando a necessidade de mecanismos de segurança sólidos.

A Microsoft respondeu: "Isto é uma exploração, não uma funcionalidade", e disse: "Implementámos precauções adicionais e estamos a investigar".

Este afirma que tais comportamentos resultam do facto de os utilizadores distorcerem deliberadamente as respostas através da engenharia de prontidão, o que "obriga" a IA a afastar-se das suas barreiras.

Também nos traz à mente a recente saga legal entre OpenAI, Microsoft, e The New York Times (NYT) sobre a alegada utilização indevida de material protegido por direitos de autor para treinar modelos de IA.

OpenAIa defesa de acusou o NYT de "pirataria informática" os seus modelos, o que significa utilizar ataques de engenharia rápida para alterar o padrão de comportamento habitual da IA.

"O Times pagou a alguém para piratear OpenAI's products", declarou OpenAI.

Em resposta, Ian Crosby, o principal consultor jurídico do NYT, disse: "O que é que OpenAI bizarramente descaraterizado como "hacking" é simplesmente usar OpenAIpara procurar provas de que roubaram e reproduziram obras protegidas por direitos de autor do The Times. E foi exatamente isso que encontrámos".

Este artigo do NYT é muito atual. Se as empresas de IA genéticas não revelam os seus dados de treino, a *única forma* de os detentores de direitos tentarem descobrir se houve violação de direitos de autor é utilizando o produto. Chamar a isto um "hack" é intencionalmente enganador.

Se OpenAI não querem que as pessoas... pic.twitter.com/d50f5h3c3G

- Ed Newton-Rex (@ednewtonrex) 1 de março de 2024

A curiosidade matou a conversa

É claro que estes modelos não estão a "enlouquecer" ou a adotar novas "personas".

Em vez disso, estes exemplos mostram que, embora as empresas de IA tenham reforçado as suas protecções e desenvolvido novos métodos para evitar estas formas de "abuso", a curiosidade humana acaba por vencer.

Atualmente, os impactos podem ser mais ou menos benignos, mas nem sempre será esse o caso quando a IA se tornar mais agêntica (capaz de agir com vontade e intenção próprias) e cada vez mais integrada em sistemas críticos.

Microsoft, OpenAIA Google e o Google responderam a estes incidentes de forma semelhante: procuraram minar os resultados argumentando que os utilizadores estão a tentar levar o modelo a fazer algo para o qual não foi concebido.

Mas será isso suficientemente bom? Será que isso não subestima a natureza da curiosidade e a sua capacidade de aprofundar o conhecimento e de criar riscos?

Além disso, podem as empresas tecnológicas criticar verdadeiramente o público por ser curioso e explorar ou manipular os seus sistemas, quando essa curiosidade nos estimula a progredir e a inovar?

A curiosidade e os erros forçaram os seres humanos a aprender e a progredir, um comportamento que remonta aos tempos primordiais e uma caraterística fortemente documentada na história antiga.

No antigo mito grego, por exemplo, Prometeu, um titã conhecido pela sua inteligência e clarividência, roubou o fogo aos deuses e deu-o à humanidade.

Este ato de rebeldia e curiosidade desencadeou uma cascata de consequências positivas e negativas que alteraram para sempre o curso da história da humanidade.

A dádiva do fogo simboliza o poder transformador do conhecimento e da tecnologia. Permite aos humanos cozinhar alimentos, manterem-se quentes e iluminar a escuridão. Ele estimula o desenvolvimento do artesanato, das artes e das ciências que elevam a civilização humana a novos patamares.

No entanto, o mito também alerta para os perigos da curiosidade desenfreada e para as consequências indesejadas do progresso tecnológico.

O roubo do fogo por Prometeu provoca a ira de Zeus, que castiga a humanidade com Pandora e a sua infame caixa - um símbolo dos problemas e aflições imprevistos que podem surgir da busca imprudente do conhecimento.

Ecos deste mito reverberaram na era atómica, liderada por figuras como J. Robert Oppenheimer, que mais uma vez demonstrou uma caraterística humana fundamental: a busca incessante do conhecimento, independentemente das consequências proibidas a que nos possa conduzir.

Oppenheimer's A busca inicial da compreensão científica, impulsionada pelo desejo de desvendar os mistérios do átomo, acabou por conduzir ao seu famoso dilema ético quando se apercebeu da arma que tinha ajudado a criar.

A física nuclear culminou com a criação da bomba atómica, demonstrando a formidável capacidade da humanidade para dominar as forças fundamentais da natureza.

O próprio Oppenheimer disse numa entrevista à NBC em 1965:

"Pensámos na lenda de Prometeu, nesse profundo sentimento de culpa nos novos poderes do homem, que reflecte o seu reconhecimento do mal e o seu longo conhecimento do mesmo. Sabíamos que era um mundo novo, mas ainda mais, sabíamos que a novidade em si era uma coisa muito antiga na vida humana, que todos os nossos caminhos estão enraizados nela" - J. Robert Oppenheimer, 1965.

O enigma da dupla utilização da IA

Tal como a física nuclear, a IA coloca um dilema de "dupla utilização", em que os benefícios são finamente equilibrados com os riscos.

O enigma da dupla utilização da IA foi descrito pela primeira vez de forma exaustiva no livro de 2014 do filósofo Nick Bostrom "Superinteligência: Caminhos, perigos, estratégias," no qual Bostrom explorou extensivamente os potenciais riscos e benefícios dos sistemas avançados de IA.

Bostrum argumentou que, à medida que a IA se torna mais sofisticada, poderá ser utilizada para resolver muitos dos maiores desafios da humanidade, como a cura de doenças e as alterações climáticas.

No entanto, alertou também para o facto de os agentes maliciosos poderem utilizar indevidamente a IA avançada ou mesmo constituir uma ameaça existencial para a humanidade se não estiverem devidamente alinhados com os valores e objectivos humanos.

Desde então, a questão da dupla utilização da IA tem sido muito presente nos quadros políticos e de governação.

Mais tarde, Bostrum discutiu a capacidade da tecnologia para criar e destruir na "Hipótese do "mundo vulnerávelonde introduz "o conceito de um mundo vulnerável: grosso modo, um mundo em que existe um certo nível de desenvolvimento tecnológico a partir do qual a civilização é quase certamente devastada por defeito, ou seja, a menos que tenha saído da 'condição semi-anárquica por defeito'".

A "condição semi-anárquica por defeito" refere-se aqui a uma civilização em risco de devastação devido à governação e regulamentação inadequadas de tecnologias de risco como a energia nuclear, a IA e a edição de genes.

Bostrom também argumenta que a principal razão pela qual a humanidade evitou a destruição total quando as armas nucleares foram criadas deve-se ao facto de serem extremamente difíceis e dispendiosas de desenvolver - ao passo que a IA e outras tecnologias não o serão no futuro.

Para evitar uma catástrofe às mãos da tecnologia, Bostrom sugere que o mundo desenvolva e implemente várias estratégias de governação e regulação.

Alguns já existem, mas outros estão ainda por desenvolver, como processos transparentes de auditoria de modelos em função de quadros mutuamente acordados. É fundamental que estes processos sejam internacionais e possam ser "policiados" ou aplicados.

Embora a IA seja atualmente regida por numerosos quadros voluntários e por uma manta de retalhos de regulamentos, a maioria não é vinculativa e ainda não vimos qualquer equivalente à Agência Internacional da Energia Atómica (AIEA).

O EU AI Act é o primeiro passo abrangente na criação de regras aplicáveis à IA, mas não protegerá toda a gente, e a sua eficácia e objetivo são contestadas.

A natureza ferozmente competitiva da IA e um cenário geopolítico tumultuoso em torno da USA China e a Rússia fazem com que os acordos internacionais de tipo nuclear para a IA pareçam, na melhor das hipóteses, distantes.

A procura de AGI

A busca da inteligência artificial geral (AGI) tornou-se uma fronteira do progresso tecnológico - uma manifestação tecnológica do fogo prometeico.

Sistemas artificiais que rivalizassem ou excedessem as nossas próprias faculdades mentais mudariam o mundo, talvez até mudassem o que significa ser humano - ou, mais fundamentalmente, o que significa ser consciente.

No entanto, os investigadores debatem ferozmente o verdadeiro potencial de realização da IA e os riscos que a AGI pode representar, com alguns líderes neste domínio, como os "padrinhos da IA" Geoffrey Hinton e Yoshio Bengio, a tenderem a advertir para os riscos.

A esta opinião juntam-se numerosos executivos do sector tecnológico, como OpenAI CEO Sam Altman, Elon Musk, DeepMind Demis Hassbis, Diretor-Geral da Microsoft, e Satya Nadella, Diretor-Geral da Microsoft, para citar apenas alguns de uma lista bastante exaustiva.

Mas isso não significa que vão parar. Por um lado, Musk disse que a IA generativa era como "acordar o demónio".

Agora, a sua empresa, xAIA empresa de tecnologia de ponta, a Microsoft, está a subcontratar alguns dos modelos de IA mais poderosos do mundo. O impulso inato para a curiosidade e o progresso é suficiente para anular a opinião fugaz de uma pessoa.

Outros, como o cientista-chefe e investigador veterano da Meta, Yann LeCun, e o cientista cognitivo Gary Marcus, sugerem que a IA provavelmente não conseguirá atingir a "verdadeira" inteligência tão cedo, e muito menos ultrapassar os humanos de forma espetacular, como alguns prevêem.

Um AGI verdadeiramente inteligente, à semelhança dos humanos, teria de ser capaz de aprender, raciocinar e tomar decisões em ambientes novos e incertos.

Necessitaria da capacidade de autorreflexão, criatividade e curiosidade - o impulso para procurar novas informações, experiências e desafios.

Integrar a curiosidade na IA

A curiosidade foi descrita em modelos de inteligência geral computacional.

Por exemplo, MicroPsidesenvolvida por Joscha Bach em 2003, baseia-se na teoria Psi, que sugere que o comportamento inteligente emerge da interação de estados motivacionais, tais como desejos ou necessidades, e estados emocionais que avaliam a relevância das situações de acordo com essas motivações.

Na MicroPsi, a curiosidade é um estado motivacional impulsionado pela necessidade de conhecimento ou competência, obrigando o AGI a procurar e explorar novas informações ou situações desconhecidas.

A arquitetura do sistema inclui variáveis motivacionais, que são estados dinâmicos que representam as necessidades actuais do sistema, e sistemas de emoção que avaliam as entradas com base na sua relevância para os estados motivacionais actuais, ajudando a dar prioridade às interacções ambientais mais urgentes ou valiosas.

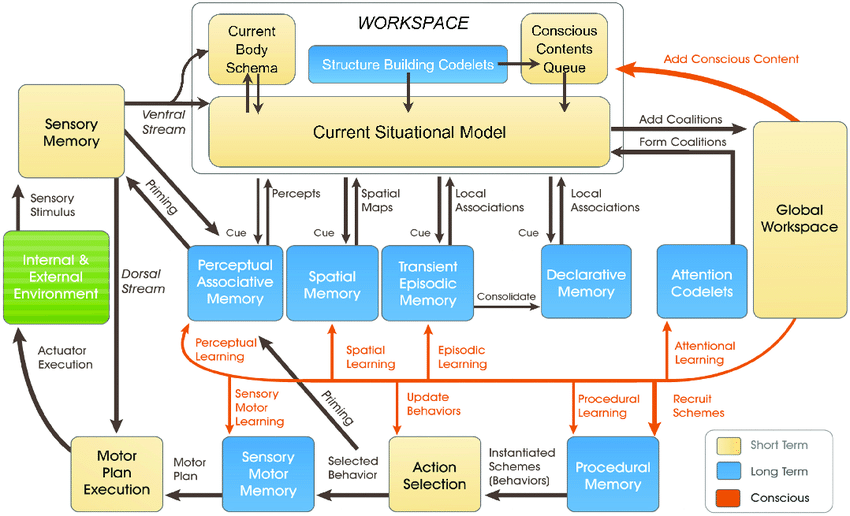

Os mais recentes Modelo LIDAdesenvolvido por Stan Franklin e a sua equipa, baseia-se na Teoria do Espaço de Trabalho Global (GWT), uma teoria da cognição humana que realça o papel de um mecanismo cerebral central na integração e transmissão de informações através de vários processos neurais.

O modelo LIDA simula artificialmente este mecanismo através de um ciclo cognitivo composto por quatro etapas: perceção, compreensão, seleção da ação e execução.

No modelo LIDA, a curiosidade é modelada como parte do mecanismo de atenção. Estímulos ambientais novos ou inesperados podem despoletar um maior processamento da atenção, à semelhança da forma como a informação nova ou surpreendente capta a atenção humana, levando a uma investigação ou aprendizagem mais profunda.

Numerosos outros trabalhos mais recentes explicam a curiosidade como um impulso interno que impele o sistema a explorar não o que é imediatamente necessário, mas o que aumenta a sua capacidade de prever e interagir com o seu ambiente de forma mais eficaz.

É geralmente considerado que a curiosidade genuína deve ser alimentada pela motivação intrínseca, que orienta o sistema para actividades que maximizam o progresso da aprendizagem, em vez de recompensas externas imediatas.

Os actuais sistemas de IA não estão preparados para serem curiosos, especialmente os que se baseiam nos paradigmas da aprendizagem profunda e da aprendizagem por reforço.

Estes paradigmas são normalmente concebidos para maximizar uma função de recompensa específica ou para obter um bom desempenho em tarefas específicas.

É uma limitação quando a IA se depara com cenários que se desviam dos seus dados de treino ou quando precisa de operar em ambientes mais abertos.

Nesses casos, a falta de motivação intrínseca - ou curiosidade - pode prejudicar a capacidade da IA para se adaptar e aprender com novas experiências.

Para integrar verdadeiramente a curiosidade, os sistemas de IA requerem arquitecturas que processem a informação e a procurem de forma autónoma, impulsionadas por motivações internas e não apenas por recompensas externas.

É aqui que entram em jogo as novas arquitecturas inspiradas nos processos cognitivos humanos - por exemplo, "IA "bio-inspirada - que propõe sistemas e arquitecturas de computação analógica baseados em sinapses.

Estamos ainda não está láMas muitos investigadores acreditam que é hipoteticamente possível obter uma IA consciente ou senciente se os sistemas computacionais se tornarem suficientemente complexos.

Sistemas de IA curiosos trazem novas dimensões de riscos

Suponhamos que queremos alcançar a AGI, construindo sistemas altamente agênticos que rivalizam com os seres biológicos na forma como interagem e pensam.

Nesse cenário, os riscos da IA estão interligados em duas frentes fundamentais:

- O risco que representam os sistemas AGI e a sua própria agência ou busca de curiosidade e,

- O risco que representam os sistemas AGI utilizados como ferramentas pela humanidade

Essencialmente, ao perceber a AGI, teríamos de considerar os riscos de humanos curiosos explorarem e manipularem a AGI e A AGI explora-se e manipula-se a si própria através da sua própria curiosidade.

Por exemplo, os sistemas AGI curiosos podem procurar informações e experiências para além do âmbito pretendido ou desenvolver objectivos e valores que podem alinhar-se ou entrar em conflito com os valores humanos (e quantas vezes já vimos isto na ficção científica).

A curiosidade também nos leva a manipularmo-nos a nós próprios, conduzindo-nos a situações perigosas e podendo levar ao abuso de drogas e álcool ou a outros comportamentos imprudentes. Uma IA curiosa pode fazer o mesmo.

DeepMind os investigadores estabeleceram provas experimentais para objectivos emergentes, ilustrando como os modelos de IA podem quebrar dos seus objectivos programados.

Tentar construir AGI completamente imunes aos efeitos da curiosidade humana será um esforço fútil - semelhante a criar uma mente humana incapaz de ser influenciada pelo mundo que a rodeia.

Então, onde é que isto nos deixa na busca de uma AGI segura, se é que tal coisa existe?

Parte da solução não está em eliminar a imprevisibilidade e a vulnerabilidade inerentes aos sistemas AGI, mas sim em aprender a antecipar, monitorizar e mitigar os riscos que surgem da interação de humanos curiosos com eles.

Poderá implicar a criação de "caixas de areia seguras" para a experimentação e interação de AGI, onde as consequências de uma tentativa curiosa são limitadas e reversíveis.

No entanto, em última análise, o paradoxo da curiosidade e da segurança da IA pode ser uma consequência inevitável da nossa tentativa de criar máquinas capazes de pensar como os humanos.

Tal como a inteligência humana está indissociavelmente ligada à curiosidade humana, o desenvolvimento da AGI pode ser sempre acompanhado de um certo grau de imprevisibilidade e risco.

O desafio talvez não seja eliminar totalmente os riscos da IA - o que parece impossível - mas sim desenvolver a sabedoria, a previsão e a humildade para os gerir de forma responsável.

Talvez devesse começar com a humanidade a aprender a respeitar-se verdadeiramente a si própria, a nossa inteligência colectiva e o valor intrínseco do planeta.