A corrida ao hardware de IA mais potente e eficiente avançou esta semana com a Intel e a Google a anunciarem novos chips para as ajudar a tornarem-se menos dependentes da tecnologia NVIDIA.

Parece que todas as semanas são lançados novos modelos de IA. Por trás de cada lançamento estão semanas de treinamento em centros de dados de computação em nuvem, a maioria dos quais é alimentada por GPUs NVIDIA.

A Intel e a Google anunciaram novos chips de IA internos que podem treinar e implementar grandes modelos de IA mais rapidamente, utilizando menos energia.

Chip acelerador de IA Gaudi 3 da Intel

A Intel é provavelmente mais conhecida pelos chips que alimentam o seu PC, mas na terça-feira a empresa anunciado o seu novo chip de IA denominado Gaudi 3.

H100 da NVIDIA As GPUs formaram a maior parte dos centros de dados de IA, mas a Intel diz que o Gaudi 3 oferece "50% em média melhor inferência e 40% em média melhor eficiência energética do que a Nvidia H100 - por uma fração do custo".

Um grande fator que contribui para a eficiência energética do Gaudi 3 é o facto de a Intel ter utilizado o processo de 5 nm da Taiwan Semiconductor Manufacturing Co para fabricar os chips.

A Intel não forneceu informações sobre preços, mas quando questionada sobre a comparação com os produtos da NVIDIA, Das Kamhout, vice-presidente de software Xeon da Intel, disse: "Esperamos que seja altamente competitivo".

A Dell Technologies, a Hewlett Packard Enterprise, a Lenovo e a Supermicro serão as primeiras a implementar o Gaudi 3 nos seus centros de dados de IA.

O CEO da Intel, Pat Gelsinger, resumiu as ambições de IA da empresa dizendo: "A Intel está levando a IA para todos os lugares da empresa, do PC ao data center e à borda".

O #IntelGaudi 3 #AI oferece uma alternativa altamente competitiva ao H100 da NVIDIA com maior desempenho, maior escalabilidade e integração com o PyTorch. Explore mais benefícios importantes do produto. https://t.co/sXdQKjYFw0 pic.twitter.com/iJSndBQkvT

- Intel AI (@IntelAI) 9 de abril de 2024

Actualizações do braço e da TPU da Google

Na terça-feira, a Google anunciou o seu primeiro produto personalizado CPUs baseadas em Arm que planeia utilizar para alimentar os seus centros de dados. O novo chip, denominado Axion, é um concorrente direto dos CPUs da Intel e da AMD.

A Google afirma que o Axion oferece "um desempenho 30% superior ao das instâncias mais rápidas de uso geral baseadas em Arm disponíveis atualmente na nuvem, um desempenho até 50% superior e uma eficiência energética até 60% superior à das instâncias comparáveis de geração atual baseadas em x86".

A Google tem vindo a transferir vários dos seus serviços, como o YouTube e o Google Earth, para a sua atual geração de servidores baseados em Arm, que em breve serão actualizados com os chips Axion.

Ter uma opção poderosa baseada em Arm facilita aos clientes a migração das suas aplicações de formação, inferência e outras aplicações de IA baseadas em CPU para a plataforma de nuvem da Google sem terem de as redesenhar.

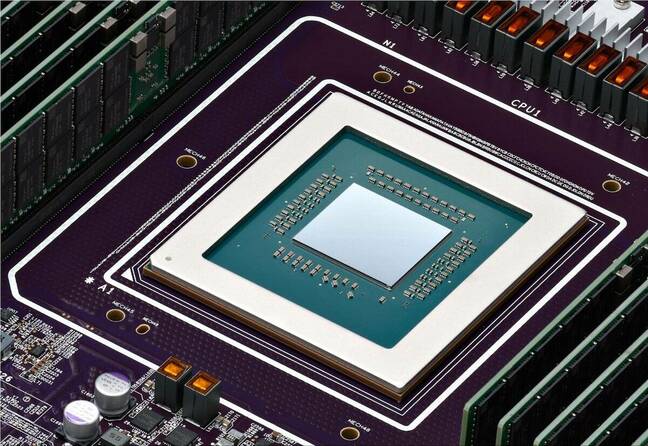

Para o treino de modelos em grande escala, a Google tem confiado largamente nos seus chips TPU como uma alternativa ao hardware da NVIDIA. Estas também serão actualizadas com uma única nova TPU v5p que contém agora mais do dobro do número de chips da atual cápsula TPU v4.

TPU v5p, a nossa TPU mais poderosa e escalável, está agora disponível para todos! #GoogleCloudNext pic.twitter.com/mmfWlzHeqs

- Google Cloud Tech (@GoogleCloudTech) 9 de abril de 2024

A Google não está a tentar vender os seus novos chips Arm ou TPUs. A empresa pretende impulsionar os seus serviços de computação em nuvem em vez de se tornar um concorrente direto da NVIDIA em termos de hardware.

As TPUs actualizadas darão um impulso às Hipercomputador de IA que permite o treino de modelos de IA em grande escala. O hipercomputador de IA também utiliza GPUs NVIDIA H100 que, segundo a Google, serão em breve substituídas pelas novas GPUs Blackwell.

Não é provável que a procura de chips de IA abrande tão cedo, e parece que a corrida da NVIDIA não é tão fácil como antes.