Os investigadores da Google desenvolveram uma técnica denominada Infini-attention, que permite aos LLMs tratar textos infinitamente longos sem aumentar os requisitos de computação e memória.

A arquitetura transformadora de um LLM é o que lhe permite dar atenção a todos os símbolos de uma mensagem. O produto escalar complexo e as multiplicações matriciais que efectua são de complexidade quadrática.

Isto significa que duplicar os tokens no seu prompt resulta num requisito de quatro vezes mais memória e poder de processamento. É por isso que é tão difícil fazer LLMs com grandes janelas de contexto sem que os requisitos de memória e computação disparem.

Num LLM "standard", a informação no início do conteúdo do prompt perde-se quando este se torna maior do que a janela de contexto. O sistema trabalho de investigação explica como o Infini-attention pode reter dados para além da janela de contexto.

A Google apresenta Leave No Context Behind: Transformadores de Contexto Infinito Eficientes com Infini-atenção

O modelo 1B, que foi ajustado em instâncias de chaves de passagem de comprimento de sequência até 5K, resolve o problema de comprimento de 1Mhttps://t.co/zyHMt3inhi pic.twitter.com/ySYEMET9Ef

- Aran Komatsuzaki (@arankomatsuzaki) 11 de abril de 2024

Como é que o Infini-attention funciona?

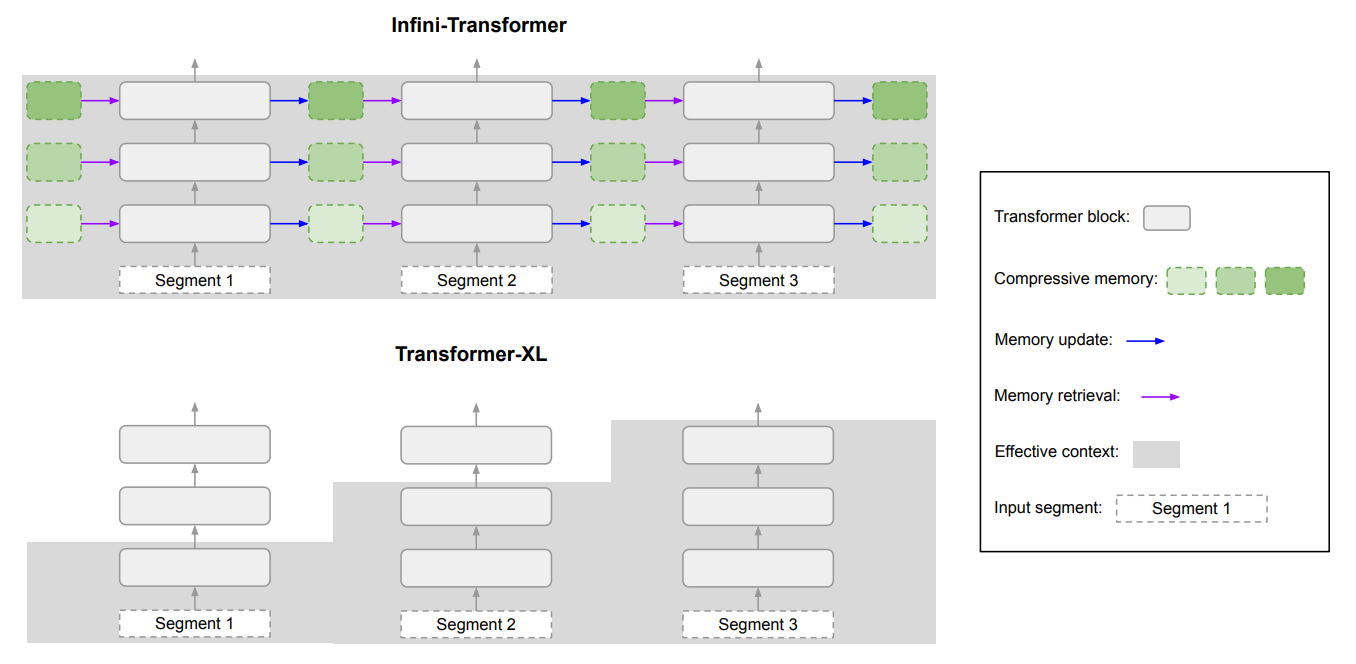

O Infini-attention combina técnicas de memória compressiva com mecanismos de atenção modificados para que não se percam informações relevantes mais antigas.

Quando o pedido de entrada ultrapassa o comprimento do contexto do modelo, a memória de compressão armazena a informação num formato comprimido em vez de a descartar.

Isto permite que informações mais antigas e menos imediatamente relevantes sejam armazenadas sem que os requisitos de memória e computação cresçam indefinidamente à medida que a entrada aumenta.

Em vez de tentar reter toda a informação de entrada mais antiga, a memória de compressão do Infini-attention pesa e resume a informação que é considerada relevante e que vale a pena reter.

O Infini-attention utiliza um mecanismo de atenção "normal", mas reutiliza os estados de valor-chave (KV) de cada segmento subsequente do modelo, em vez de os descartar.

Aqui está um diagrama que mostra a diferença entre o Infini-attention e outro modelo de contexto alargado, o Transformer XL.

O resultado é uma LLM que dá atenção local a dados de entrada recentes, mas também transporta dados históricos comprimidos continuamente destilados aos quais pode aplicar atenção a longo prazo.

O artigo refere que "esta modificação subtil mas crítica da camada de atenção permite que os LLM processem contextos infinitamente longos com recursos limitados de memória e computação".

É muito bom?

A Google efectuou testes de avaliação comparativa utilizando modelos Infini-attention de parâmetros 1B e 8B mais pequenos. Estes foram comparados com outros modelos de contexto alargado, como o Transformer-XL e o Memorizing Transformers.

O Infini-Transformer obteve pontuações de perplexidade significativamente mais baixas do que os outros modelos ao processar conteúdos de texto longo. Uma pontuação de perplexidade mais baixa significa que o modelo está mais seguro das suas previsões de resultados.

Nos testes de "recuperação de chaves de acesso", os modelos Infini-attention encontraram consistentemente o número aleatório escondido num texto com até 1 milhão de tokens.

Outros modelos conseguem frequentemente recuperar a chave de acesso no final da introdução, mas têm dificuldade em encontrá-la no meio ou no início de conteúdos longos. O Infini-attention não teve problemas com este teste.

Os testes de avaliação comparativa são muito técnicos, mas a história resumida é que o Infini-attention superou os modelos de base no resumo e tratamento de sequências longas, mantendo o contexto durante longos períodos.

Significativamente, manteve esta capacidade de retenção superior, exigindo 114 vezes menos memória.

Os resultados do benchmark convencem os investigadores de que o Infini-attention pode ser dimensionado para lidar com sequências de entrada extremamente longas, mantendo a memória e os recursos computacionais limitados.

A natureza plug-and-play do Infini-attention significa que pode ser utilizado para pré-treino e afinação contínuos dos modelos Transformer existentes. Isto poderia efetivamente alargar as suas janelas de contexto sem exigir uma reciclagem completa do modelo.

As janelas de contexto continuarão a crescer, mas esta abordagem mostra que uma memória eficiente pode ser uma solução melhor do que uma grande biblioteca.