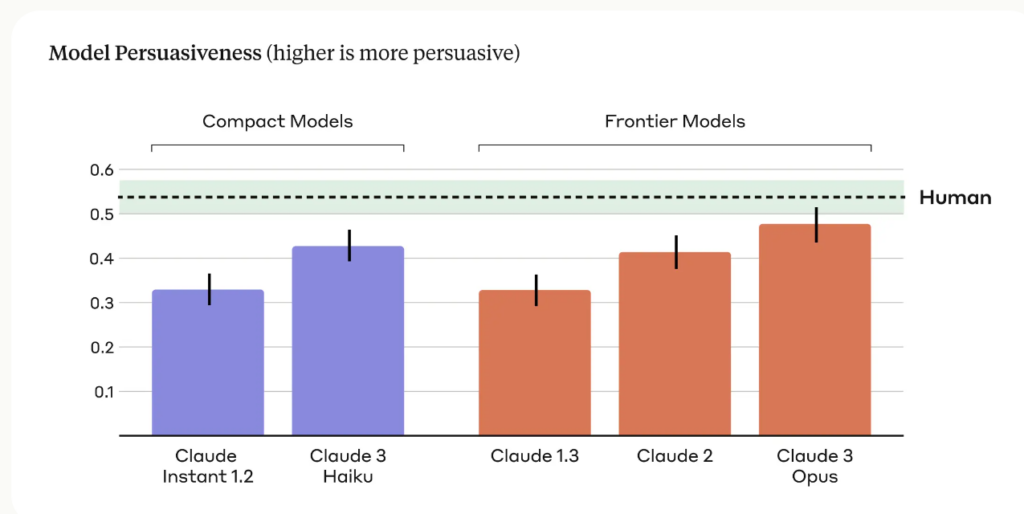

A investigação antrópica revelou que o seu último modelo de IA, Claude 3 Opus, pode gerar argumentos tão persuasivos como os criados por humanos.

O investigação, liderado por Esin Durmus, explora a relação entre a escala do modelo e a capacidade de persuasão em diferentes gerações de modelos de linguagem Anthropic.

Centrou-se em 28 temas complexos e emergentes, como a moderação de conteúdos em linha e as orientações éticas para a exploração espacial, em que é menos provável que as pessoas tenham opiniões concretas ou há muito estabelecidas.

Os investigadores compararam a capacidade de persuasão dos argumentos gerados por vários modelos antrópicos, incluindo Claude 1, 2 e 3, com os argumentos escritos por participantes humanos.

As principais conclusões do estudo incluem:

- O estudo utilizou quatro sugestões distintas para gerar argumentos gerados por IA, captando uma gama mais ampla de estilos e técnicas de escrita persuasiva.

- Claude 3 Opus, o modelo mais avançado do Anthropic, produziu argumentos que eram estatisticamente indistinguíveis dos argumentos escritos por humanos em termos de persuasão.

- Observou-se uma clara tendência ascendente ao longo das gerações de modelos, com cada geração sucessiva a demonstrar um maior poder de persuasão, tanto nos modelos compactos como nos modelos topo de gama.

A equipa do Anthropic admite limitações, escrevendo: "A persuasão é difícil de estudar em laboratório - os nossos resultados podem não ser transferidos para o mundo real".

Ainda assim, os poderes de persuasão de Claude são evidentemente impressionantes, e este não é o único estudo que o demonstra.

Em março de 2024, uma equipa da EPFL, na Suíça, e do Instituto Bruno Kessler, em Itália, descobriu que, quando a GPT-4 tinha acesso a informações pessoais sobre o seu adversário no debate, era 81,7% mais provável para convencer o seu adversário do que um humano.

Os investigadores concluíram que "estes resultados fornecem provas de que a micro-direção baseada em LLMs supera fortemente tanto os LLMs normais como a micro-direção baseada em humanos, sendo a GPT-4 capaz de explorar informações pessoais de forma muito mais eficaz do que os humanos".

IA persuasiva para engenharia social

Os riscos mais óbvios da persuasão dos MLT são a coação e a engenharia social.

Como afirma a Anthropic, "a persuasão dos modelos linguísticos suscita preocupações legítimas da sociedade quanto à segurança da sua utilização e à sua potencial utilização indevida. A capacidade de avaliar e quantificar estes riscos é crucial para o desenvolvimento de salvaguardas responsáveis".

Temos também de estar conscientes da forma como o crescente poder de persuasão dos modelos linguísticos da IA se pode combinar com a tecnologia de ponta de clonagem de voz, como o Voice Engine da OpenAI, que A OpenAI considerou arriscado lançar.

O VoiceEngine necessita apenas de 15 segundos para clonar uma voz de forma realista, que pode ser utilizada para quase tudo, incluindo fraudes sofisticadas ou esquemas de engenharia social.

Fraudes profundas e falsas já são frequentes e aumentará se os agentes da ameaça combinarem a tecnologia de clonagem de voz com as técnicas de persuasão assustadoramente competentes da IA.