A NVIDIA lançou o Chat with RTX como uma demonstração técnica de como os chatbots de IA podem ser executados localmente em PCs com Windows utilizando as suas GPUs RTX.

A abordagem padrão da utilização de um chatbot de IA é utilizar uma plataforma Web como o ChatGPT ou executar consultas através de uma API, com a inferência a ter lugar em servidores de computação em nuvem. As desvantagens desta abordagem são os custos, a latência e as preocupações com a privacidade, com a transferência de dados pessoais ou empresariais para trás e para a frente.

RTX da NVIDIA de GPUs está agora a tornar possível executar um LLM localmente no seu PC Windows, mesmo que não esteja ligado à Internet.

O Chat with RTX permite aos utilizadores criar um chatbot personalizado utilizando Mistral ou Lhama 2. Utiliza a geração aumentada por recuperação (RAG) e o software TensorRT-LLM de otimização da inferência da NVIDIA.

Pode direcionar o Chat com RTX para uma pasta no seu PC e depois fazer-lhe perguntas relacionadas com os ficheiros da pasta. Suporta vários formatos de ficheiros, incluindo .txt, .pdf, .doc/.docx e .xml.

Uma vez que o LLM analisa ficheiros armazenados localmente com a inferência a ocorrer no seu computador, é muito rápido e nenhum dos seus dados é partilhado em redes potencialmente não seguras.

Também é possível enviar-lhe o URL de um vídeo do YouTube e fazer-lhe perguntas sobre o vídeo. Isto requer acesso à Internet, mas é uma óptima forma de obter respostas sem ter de ver um vídeo longo.

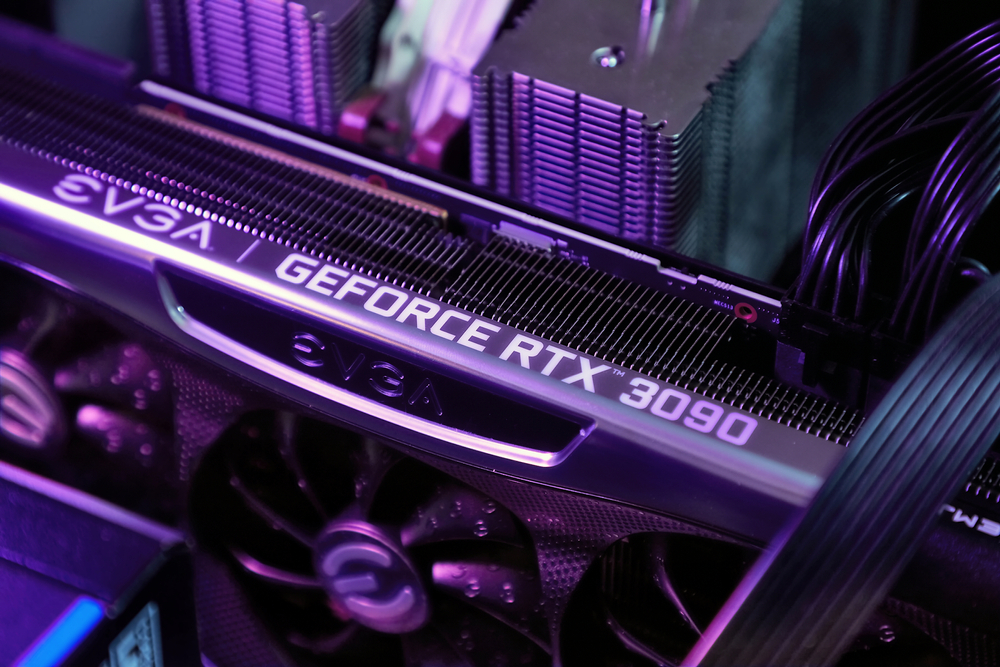

Pode descarregar Conversa com RTX gratuitamente, mas terá de ter o Windows 10 ou 11 no seu PC com uma GPU GeForce RTX série 30 ou superior, com um mínimo de 8 GB de VRAM.

O Chat com RTX é uma demonstração e não um produto acabado. Tem alguns bugs e não se lembra do contexto, pelo que não é possível fazer-lhe perguntas de seguimento. Mas é um bom exemplo da forma como vamos usar os LLMs no futuro.

Utilizar um chatbot de IA localmente com custos zero de chamadas à API e muito pouca latência é provavelmente a forma como a maioria dos utilizadores acabará por interagir com os LLM. A abordagem de código aberto que empresas como a Meta adoptaram fará com que a IA no dispositivo impulsione a adoção dos seus modelos gratuitos em vez dos modelos proprietários como o GPT.

Dito isto, os utilizadores de telemóveis e portáteis ainda terão de esperar algum tempo até que o poder de computação de uma GPU RTX possa caber em dispositivos mais pequenos.