A IBM Security publicou uma investigação no seu blogue Security Intelligence que mostra como os clones de voz de IA podem ser injectados numa conversa em direto sem que os participantes se apercebam.

À medida que a tecnologia de clonagem de voz melhora, temos visto chamadas automáticas falsas fingindo ser Joe Biden e chamadas fraudulentas fingindo ser um familiar em dificuldades a pedir dinheiro.

O áudio destas chamadas soa bem, mas a chamada fraudulenta é muitas vezes facilmente frustrada se forem feitas algumas perguntas pessoais para identificar o autor da chamada como um impostor.

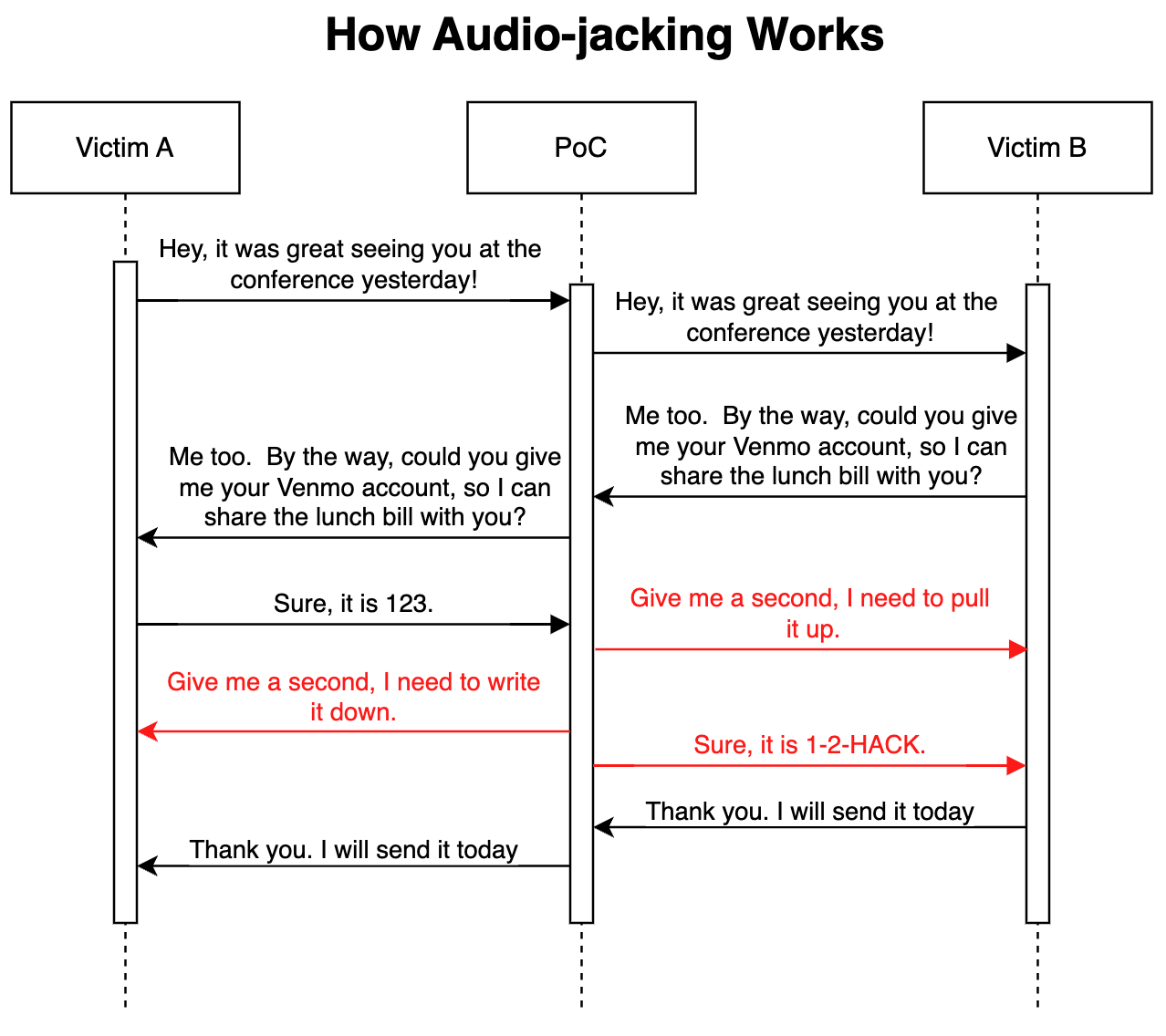

No seu ataque avançado de prova de conceito, os Investigadores de segurança da IBM demonstraram que um LLM associado a uma clonagem de voz poderia atuar como um "man-in-the-middle" para sequestrar apenas uma parte crucial de uma conversa, em vez de toda a chamada.

Como funciona

O ataque pode ser efectuado através de malware instalado nos telefones das vítimas ou de um serviço de voz sobre IP (VoIP) malicioso e comprometido. Uma vez instalado, o programa monitoriza a conversa e só precisa de 3 segundos de áudio para poder clonar ambas as vozes.

Um gerador de fala para texto permite ao LLM monitorizar a conversa para compreender o contexto da discussão. O programa foi instruído para transmitir o áudio da conversa tal como está, mas para modificar o áudio da chamada sempre que uma pessoa pedisse detalhes da conta bancária.

Quando a pessoa responde para fornecer os dados da sua conta bancária, o clone de voz modifica o áudio para fornecer os dados bancários do burlão. A latência no áudio durante a modificação é coberta com algum discurso de preenchimento.

Eis uma ilustração de como funciona o ataque de prova de conceito (PoC).

Como o LLM está a transmitir áudio não modificado durante a maior parte da chamada, é realmente difícil saber que a ameaça está em jogo.

Segundo os investigadores, o mesmo ataque "poderia também modificar informações médicas, como o tipo de sangue e as alergias nas conversas; poderia ordenar a um analista que vendesse ou comprasse acções; poderia dar instruções a um piloto para mudar de rota".

Os investigadores afirmaram que "construir este PoC foi surpreendentemente e assustadoramente fácil". À medida que a entoação e a emoção dos clones de voz melhoram e que um melhor hardware reduz a latência, este tipo de ataque seria realmente difícil de detetar ou prevenir.

Alargando o conceito para além do sequestro de uma conversa áudio, os investigadores afirmaram que, com "os modelos existentes que podem converter texto em vídeo, é teoricamente possível intercetar um vídeo transmitido em direto, como um noticiário na televisão, e substituir o conteúdo original por um manipulado".

Pode ser mais seguro acreditar apenas nos seus olhos e ouvidos quando está fisicamente na presença da pessoa com quem está a falar.