Poderão os humanos aprender a detetar de forma fiável as falsificações geradas pela IA? Como é que elas nos afectam a nível cognitivo?

Sistema Sora da OpenAI previu recentemente uma nova vaga de meios de comunicação sintéticos alimentados por IA. Provavelmente, não demorará muito até que qualquer forma de media realista - áudio, vídeo ou imagem - podem ser gerados com instruções em poucos segundos.

À medida que estes sistemas de IA se tornam cada vez mais capazes, teremos de aperfeiçoar novas competências de pensamento crítico para separar a verdade da ficção.

Até à data, os esforços das grandes tecnologias para abrandar ou travar as falsificações profundas não passaram de um mero sentimento, não por falta de convicção, mas porque o conteúdo da IA é muito realista.

Isso torna-o difícil de detetar ao nível do pixelEnquanto outros sinais, como os metadados e as marcas de água, têm as suas falhas.

Além disso, mesmo que o conteúdo gerado por IA fosse detetável em grande escala, é difícil separar o conteúdo autêntico e intencional daquele que se destina a espalhar desinformação.

A passagem de conteúdos para revisores humanos e a utilização de "notas da comunidade" (informações anexadas ao conteúdo, frequentemente vistas no X) constituem uma solução possível. No entanto, tal implica, por vezes, uma interpretação subjectiva e corre o risco de uma rotulagem incorrecta.

Por exemplo, no Conflito israelo-palestinianoEm alguns casos, assistimos a imagens perturbadoras rotuladas como reais quando eram falsas e vice-versa.

Quando uma imagem real é rotulada como falsa, isto pode criar umdividendo do mentiroso," em que alguém ou alguma coisa pode fazer com que a verdade seja considerada falsa.

Assim, na ausência de métodos técnicos para impedir as falsificações profundas do lado da tecnologia, o que podemos fazer?

E até que ponto é que as falsificações profundas afectam a nossa tomada de decisões e a nossa psicologia?

Por exemplo, quando as pessoas são expostas a imagens políticas falsas, isso tem um impacto tangível nos seus comportamentos de voto?

Vejamos alguns estudos que avaliam exatamente isso.

As falsificações profundas afectam as nossas opiniões e estados psicológicos?

Um estudo de 2020O estudo "Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News", explorou a forma como os vídeos "deepfakes" influenciam a perceção do público, em particular no que respeita à confiança nas notícias partilhadas nas redes sociais.

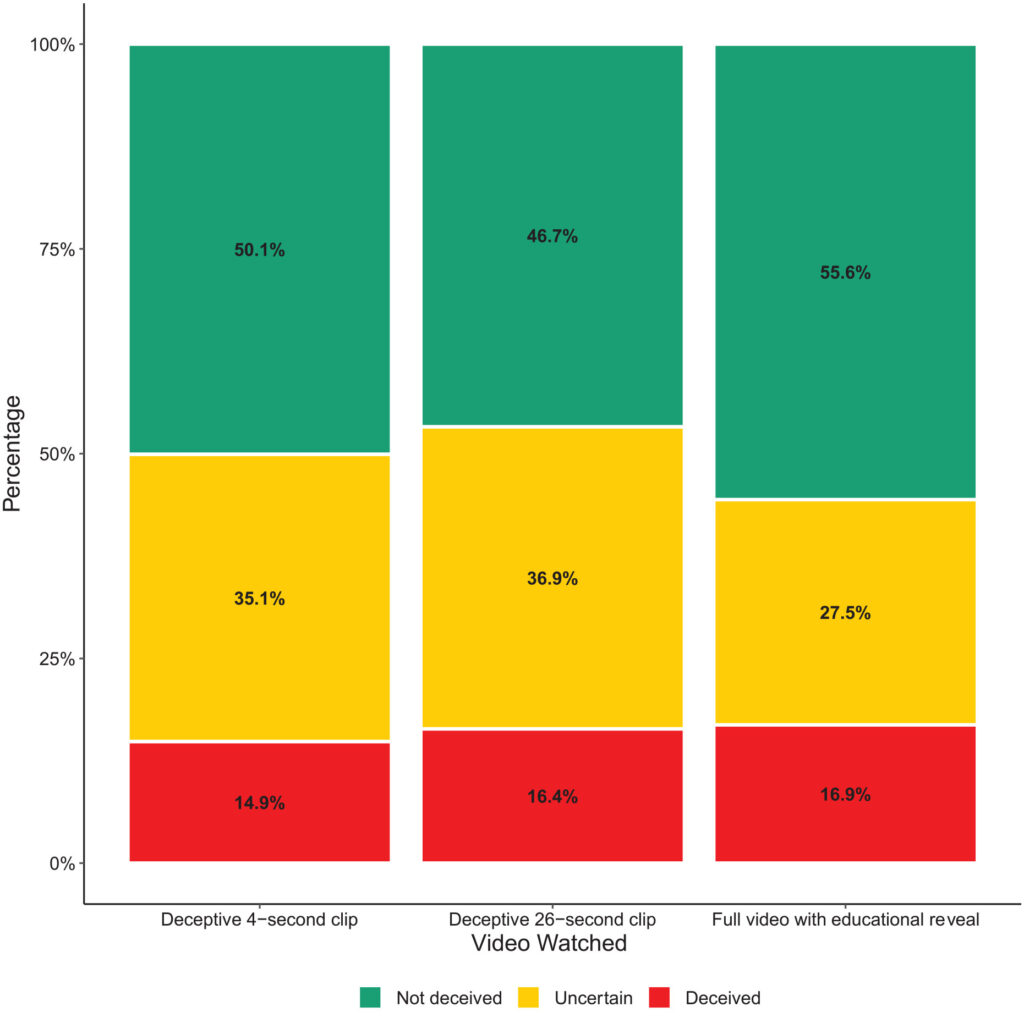

A investigação envolveu uma experiência em grande escala com 2 005 participantes do Reino Unido, concebida para medir as reacções a diferentes tipos de vídeos "deep fake" do antigo Presidente dos EUA, Barack Obama.

Os participantes foram seleccionados aleatoriamente para ver um de três vídeos:

- Um clip de 4 segundos que mostra Obama a fazer uma declaração surpreendente sem qualquer contexto.

- Um clip de 26 segundos que incluía algumas dicas sobre a natureza artificial do vídeo, mas que era sobretudo enganador.

- Um vídeo completo com uma "revelação educacional" em que a natureza artificial do deep fake é explicitamente revelada, com Jordan Peele a explicar a tecnologia por detrás do deep fake.

Principais conclusões

O estudo explorou três domínios fundamentais:

- Deceção: O estudo encontrou evidências mínimas de que os participantes acreditaram nas afirmações falsas das deep fakes. A percentagem de participantes que foram induzidos em erro pelas deep fakes foi relativamente baixa em todos os grupos de tratamento.

- Incerteza: No entanto, um resultado importante foi o aumento da incerteza entre os espectadores, especialmente aqueles que viram os clipes mais curtos e enganosos. Cerca de 35,1% dos participantes que viram o clipe de 4 segundos e 36,9% que viram o clipe de 26 segundos relataram sentir-se inseguros quanto à autenticidade do vídeo. Em contrapartida, apenas 27,5% dos participantes que viram o vídeo educativo completo se sentiram assim.

- Confiança nas notícias: Esta incerteza teve um impacto negativo na confiança dos participantes nas notícias das redes sociais. Os que foram expostos aos deep fakes enganadores apresentaram níveis de confiança mais baixos do que os que viram a revelação educativa.

Isto mostra que a exposição a imagens falsas profundas causa incerteza a longo prazo.

Com o tempo, as imagens falsas podem enfraquecer a fé em todas as informações, incluindo a verdade.

Resultados semelhantes foram demonstrados por um estudo mais recente de 2023O estudo "Face/Off: Changing the face of movies with deepfake", que também concluiu que as imagens falsas têm impactos a longo prazo.

As pessoas "lembram-se" de conteúdos falsos depois de os exporem

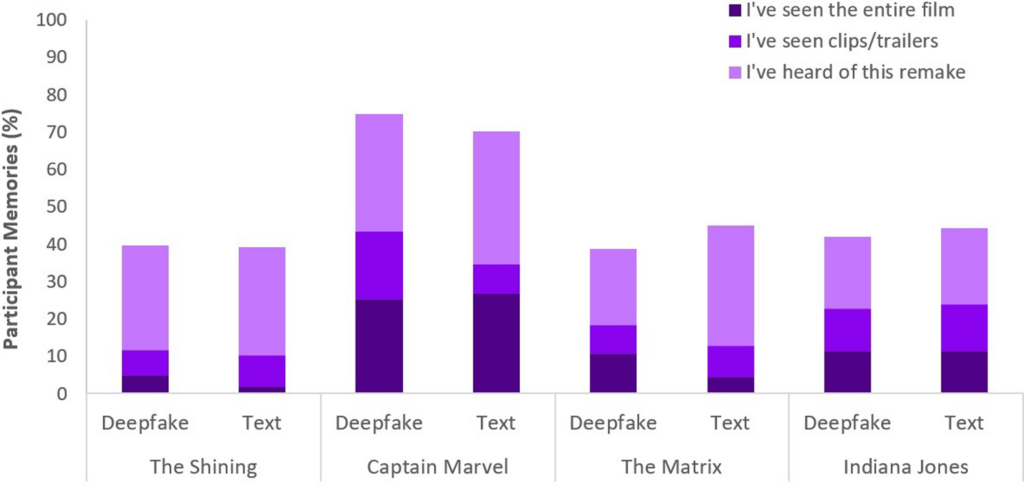

Realizado com 436 participantes, o estudo Face/Off investigou até que ponto as falsificações profundas podem influenciar a nossa recordação dos filmes.

Os participantes participaram num inquérito em linha destinado a analisar as suas percepções e memórias de remakes de filmes reais e imaginários.

O núcleo do inquérito consistia em apresentar aos participantes seis títulos de filmes, que incluíam uma mistura de quatro remakes de filmes reais e dois fictícios.

MOs filmes foram aleatorizados e apresentados em dois formatos: metade dos filmes foram apresentados através de breves descrições de texto e a outra metade foi acompanhada de breves clips de vídeo.

Os remakes de filmes fictícios consistiam em versões de "The Shining", "The Matrix", "Indiana Jones" e "Captain Marvel", com descrições que alegavam falsamente o envolvimento de actores de alto nível nestes remakes inexistentes.

Por exemplo, os participantes foram informados sobre um falso remake de "The Shining" com Brad Pitt e Angelina Jolie, que nunca aconteceu.

Em contrapartida, os remakes de filmes reais apresentados no inquérito, como "Charlie & The Chocolate Factory" e "Total Recall", foram descritos com exatidão e acompanhados por clips de filmes genuínos. Esta mistura de remakes reais e falsos tinha como objetivo investigar a forma como os participantes discernem entre conteúdo factual e fabricado.

Os participantes foram questionados sobre a sua familiaridade com cada filme, perguntando-lhes se tinham visto o filme original ou o remake ou se tinham algum conhecimento prévio dos mesmos.

Principais conclusões

- Fenómeno de falsa memória: Um dos principais resultados do estudo é a revelação de que quase metade dos participantes (49%) desenvolveram falsas memórias de assistir a remakes fictícios, como imaginar Will Smith como Neo em "The Matrix". Isto ilustra o efeito duradouro que os meios de comunicação sugestivos, quer sejam vídeos falsos profundos ou descrições textuais, podem ter na nossa memória.

- EspecificamenteNa lista, "Capitão Marvel" encabeçava a lista, com 73% de participantes a recordar o seu remake de IA, seguido de "Indiana Jones" com 43%, "Matrix" com 42% e "The Shining" com 40%. Entre os que acreditaram erradamente nestes remakes, 41% pensaram que o remake do "Capitão Marvel" era superior ao original.

- Influência comparativa das falsificações profundas e do texto: Outra descoberta é que as falsificações profundas, apesar do seu realismo visual e auditivo, não foram mais eficazes na alteração da memória dos participantes do que as descrições textuais do mesmo conteúdo fictício. Isto sugere que o formato da desinformação - visual ou textual - não altera significativamente o seu impacto na distorção da memória no contexto do filme.

O fenómeno das falsas memórias que é objeto deste estudo está amplamente estudado. Mostra como os seres humanos constroem ou reconstroem eficazmente memórias falsas que temos a certeza que são reais quando não o são.

Todas as pessoas são susceptíveis de construir falsas memórias, e dAs falsificações eep parecem ativar este comportamento, o que significa que a visualização de determinado conteúdo pode alterar a nossa perceção, mesmo quando compreendemos conscientemente que não é autêntico.

Em ambos os estudos, as falsificações profundas tiveram impactos tangíveis e potencialmente a longo prazo. O efeito pode aparecer sorrateiramente e acumular-se ao longo do tempo.

Também não podemos esquecer que os conteúdos falsos circulam por milhões de pessoas, pelo que pequenas alterações na perceção têm escala na população mundial.

O que fazer com as falsificações profundas?

Entrar em guerra com os deep fakes significa combater o cérebro humano.

Embora o aumento das notícias falsas e da desinformação tenha forçado as pessoas a desenvolver uma nova literacia mediática nos últimos anos, os meios de comunicação sintéticos gerados pela IA exigirão um novo nível de adaptação.

Já nos confrontámos com pontos de inflexão deste tipo antes, desde a fotografia aos efeitos especiais CGI, mas a IA exigirá uma evolução dos nossos sentidos críticos.

Atualmente, temos de ir além da mera crença nos nossos olhos e confiar mais na análise das fontes e das pistas contextuais.

É essencial interrogar os incentivos ou preconceitos dos conteúdos. Está de acordo com os factos conhecidos ou contradiz-nos? Existem provas de corroboração de outras fontes fiáveis?

Outro aspeto fundamental é o estabelecimento de normas jurídicas para identificar os meios de comunicação falsificados ou manipulados e responsabilizar os criadores.

O Lei da DEFIANÇA dos EUAA Lei de Segurança Online do Reino Unido e outras leis equivalentes em todo o mundo estão a estabelecer procedimentos legais para lidar com as falsificações profundas. Resta saber até que ponto serão eficazes.

Estratégias para desvendar a verdade

Vamos concluir com cinco estratégias para identificar e interrogar potenciais deep fakes.

Embora nenhuma estratégia seja perfeita, a promoção de mentalidades críticas é a melhor coisa que podemos fazer coletivamente para minimizar o impacto da desinformação sobre a IA.

- Verificação de origem: Examinar a credibilidade e a origem da informação é um passo fundamental. Os conteúdos autênticos provêm frequentemente de fontes respeitáveis com um historial de fiabilidade.

- Análise técnica: Apesar da sua sofisticação, as falsificações profundas podem apresentar falhas subtis, como expressões faciais irregulares ou iluminação inconsistente. Examine o conteúdo e considere se foi alterado digitalmente.

- Referências cruzadas: A verificação das informações com base em várias fontes fiáveis pode proporcionar uma perspetiva mais ampla e ajudar a confirmar a autenticidade do conteúdo.

- Literacia digital: Compreender as capacidades e limitações das tecnologias de IA é fundamental para avaliar os conteúdos. A educação para a literacia digital nas escolas e nos meios de comunicação social, incluindo o funcionamento da IA e as suas implicações éticas, será crucial.

- Interação cautelosa: Interagir com desinformação gerada por IA amplifica os seus efeitos. Tenha cuidado ao gostar, partilhar ou reenviar conteúdos sobre os quais tem dúvidas.

À medida que as falsificações profundas evoluem, o mesmo acontece com as técnicas necessárias para detetar e mitigar os danos. O ano de 2024 será revelador, uma vez que cerca de metade da população mundial irá votar em eleições importantes.

As provas sugerem que as falsificações profundas podem afetar a nossa perceção, pelo que está longe de ser estranho pensar que a desinformação da IA pode ter um impacto material nos resultados.

À medida que avançamos, as práticas éticas de IA, a literacia digital, a regulamentação e o envolvimento crítico serão fundamentais para moldar um futuro em que a tecnologia amplifica, em vez de obscurecer, a essência da verdade.