O treino de modelos de IA como o GPT-4 tem-se baseado sobretudo em conjuntos de dados constituídos por texto e imagens. O conjunto de dados de perceção multimodal Ego-Exo4D da Meta apresenta aos cientistas de dados um novo e rico conjunto de dados de treino.

É possível aprender uma nova habilidade lendo um livro, mas é muito mais fácil quando alguém nos mostra como fazer algo enquanto nos explica. É este o objetivo que a equipa FAIR (Fundamental Artificial Intelligence Research) da Meta tem para o Ego-Exo4D.

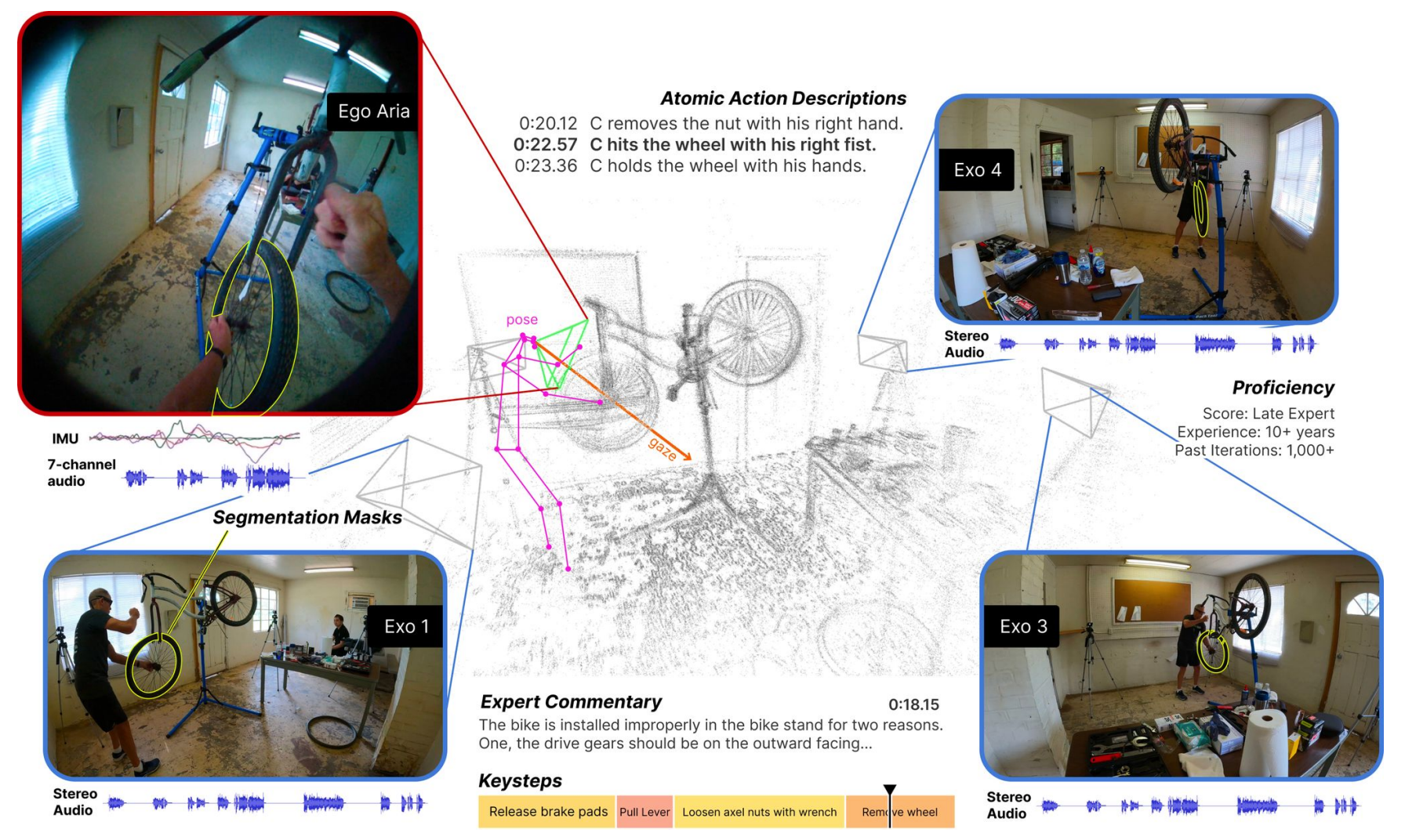

O conjunto de dados é constituído por vídeos na primeira pessoa (Ego) e na terceira pessoa (Exo) de pessoas que realizam diferentes actividades humanas especializadas. Estas actividades podem ser qualquer coisa, desde cozinhar, dançar, tocar música ou reparar uma bicicleta. Os dados foram recolhidos em 13 cidades de todo o mundo por 839 utilizadores de câmaras, tendo sido captadas 1422 horas de vídeo.

Os vídeos, que são filmados em simultâneo, são depois aumentados com modos de dados adicionais, cortesia dos óculos Project Aria da Meta.

Os óculos Project Aria são computadores portáteis em forma de óculos. Captam o vídeo e o áudio do utilizador, bem como o seguimento dos olhos e a informação de localização. Os óculos também detetam as posições da cabeça e as nuvens de pontos 3D do ambiente.

O resultado é um conjunto de dados de vídeos simultâneos de uma tarefa que está a ser executada, com narrações na primeira pessoa pelos utilizadores da câmara descrevendo as suas acções, e o seguimento da cabeça e dos olhos da pessoa que executa a tarefa.

Apresentamos o Ego-Exo4D - um conjunto de dados fundamental e de referência centrado em actividades humanas especializadas para apoiar a investigação sobre aprendizagem de vídeo e perceção multimodal. É o maior conjunto de dados públicos do género.

Mais pormenores ➡️ https://t.co/82OR4msehv pic.twitter.com/NTI1kdj1RN

- IA no Meta (@AIatMeta) 4 de dezembro de 2023

A Meta adicionou então descrições na terceira pessoa das acções de cada utilizador da câmara. A Meta também contratou especialistas em vários domínios para adicionar comentários de especialistas falados na terceira pessoa, criticando a forma como a pessoa no vídeo executava a tarefa.

Ao recolher pontos de vista egocêntricos e exocêntricos, o conjunto de dados Ego-Exo4D pode mostrar aos investigadores como são as actividades a partir de diferentes perspectivas. Isto poderá ajudá-los a desenvolver algoritmos de visão por computador capazes de reconhecer o que uma pessoa está a fazer a partir de qualquer perspetiva.

Ego-Exo4D abre novas oportunidades de aprendizagem

Um dos principais obstáculos à realização da AGI ou ao treino mais eficiente dos robôs é a falta de perceção sensorial dos computadores. Como seres humanos, temos tantas entradas sensoriais do nosso ambiente que muitas vezes tomamos como garantidas quando aprendemos novas competências.

O Ego-Exo4D será um recurso extremamente útil para ajudar a colmatar esta lacuna.

O Dr. Gedas Bertasius, Professor Assistente no Departamento de Ciências Informáticas da Universidade da Carolina do Norte, afirmou: "O Ego-Exo4D não se trata apenas de recolher dados, mas de mudar a forma como a IA compreende, percepciona e aprende. Com uma aprendizagem e uma perspetiva centradas no ser humano, a IA pode tornar-se mais útil na nossa vida quotidiana, ajudando-nos de formas que apenas imaginámos."

A Meta diz esperar que o Ego-Exo4D "permita que os robôs do futuro adquiram conhecimentos sobre manipulações complexas de destreza observando especialistas humanos qualificados em ação".

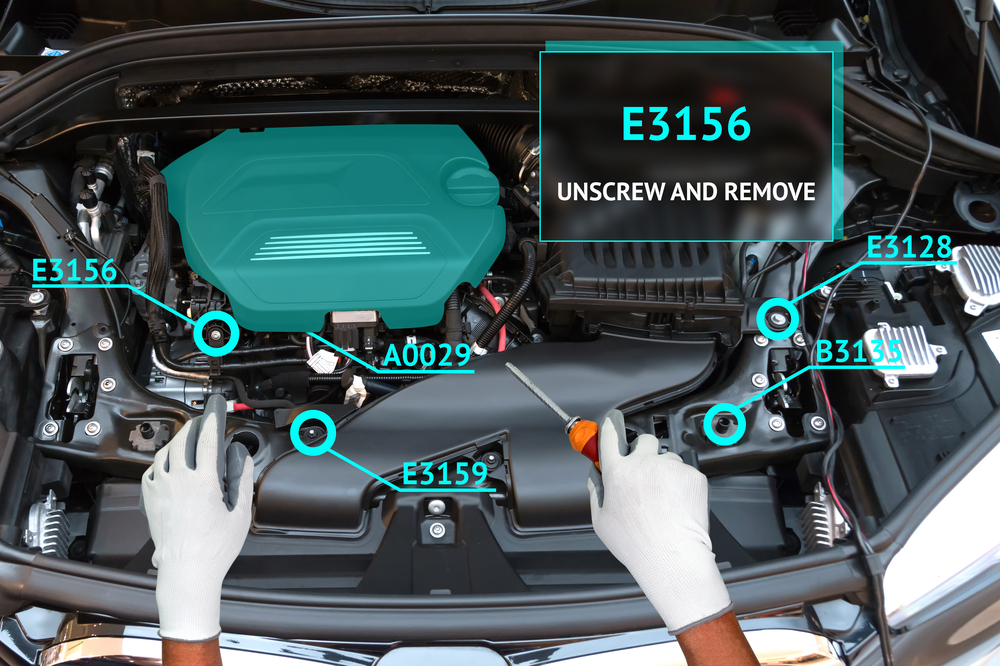

Este conjunto de dados, combinado com os óculos do Projeto Aria, permitirá em breve uma experiência de aprendizagem verdadeiramente imersiva para os seres humanos. Imagine-se a executar uma tarefa enquanto os seus óculos utilizam a realidade aumentada (RA) para sobrepor um vídeo tutorial ou para o orientar na sua tarefa.

Pode estar a aprender a tocar piano e ter uma sobreposição visual que lhe mostra onde as suas mãos se devem mover, com conselhos áudio em tempo real à medida que o faz. Ou pode abrir o capot do seu carro e ser guiado na resolução de problemas e na reparação de um problema no motor.

Será interessante ver se o Meta's Conceito de aprendizagem Ego How-To irá impulsionar uma melhor adoção dos óculos do Projeto Aria do que o fracassado produto Google Glass. No entanto, ainda não se sabe quando estarão disponíveis para compra.

Meta vai criar o conjunto de dados Ego-Exo4D disponível para descarregar antes do final de dezembro.