Os Modelos Multimodais de Linguagem Ampla (MLLM), como o GPT-4V, são muito bons a analisar e a descrever imagens, mas por vezes têm alucinações e enganam-se. Uma nova abordagem chamada Woodpecker pode resolver isso.

Se pedirmos a um MLLM para descrever uma fotografia, ele consegue normalmente identificar os objectos e descrever a cena com precisão. Mas, tal como acontece com as respostas a pedidos de texto, o modelo faz por vezes suposições baseadas em objectos ou conceitos que aparecem frequentemente juntos.

Consequentemente, um MLLM pode descrever uma fotografia de uma fachada de uma loja e dizer que há pessoas na cena, quando na realidade não há nenhumas.

A correção de alucinações em LLMs baseados em texto está em curso, mas torna-se muito mais fácil quando o modelo está ligado à Internet. O LLM pode gerar uma resposta de texto a um pedido, verificar a sua veracidade com base em dados relevantes da Internet e auto-corrigir-se quando necessário.

Os cientistas do Laboratório YouTu da Tencent e da Universidade de Ciência e Tecnologia da China adoptaram esta abordagem e traduziram-na numa solução visual chamada Woodpecker.

Em termos simples, o Woodpecker constrói um conjunto de conhecimentos a partir da imagem e, em seguida, um LLM pode utilizá-lo como referência para corrigir a descrição inicial gerada pelo MLLM.

Segue-se uma breve descrição do seu funcionamento:

- Um LLM como o GPT-3.5 Turbo analisa a descrição gerada pelo MLLM e extrai conceitos-chave como objectos, quantidades e atributos. Por exemplo, na frase "O homem está a usar um chapéu preto", são extraídos os objectos "homem" e "chapéu".

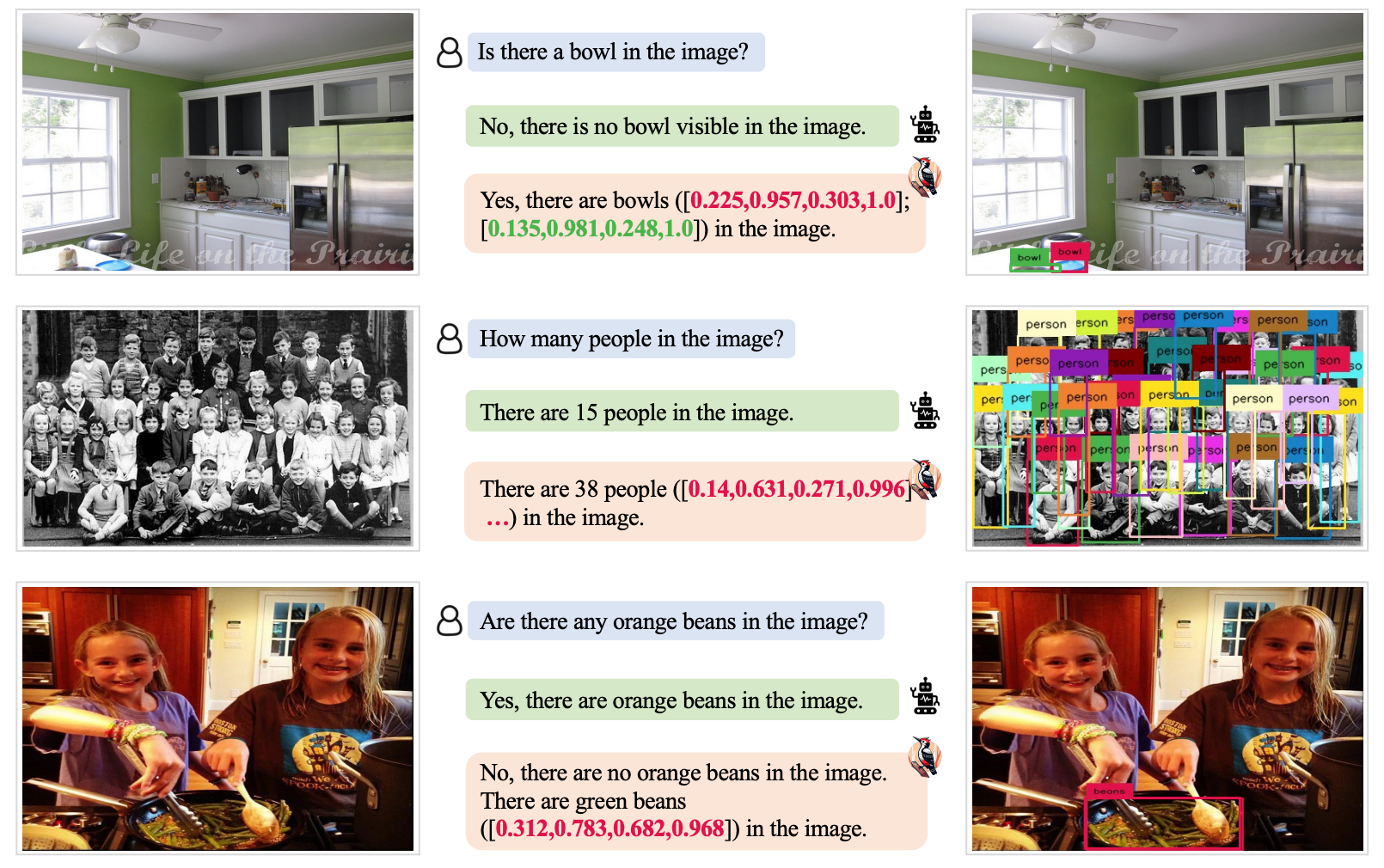

- Um LLM é então levado a gerar perguntas relacionadas com estes conceitos, como "Há um homem na imagem?" ou "O que é que o homem tem vestido?".

- Estas perguntas são transmitidas como instruções a um modelo de resposta a perguntas visuais (VQA). O Grounding DINO efectua a deteção e contagem de objectos, enquanto o BLIP-2-FlanT5 VQA responde a perguntas relacionadas com atributos depois de analisar a imagem.

- Um LLM combina as respostas às perguntas numa base de conhecimento visual para a imagem.

- Um LLM utiliza este corpo de conhecimentos de referência para corrigir quaisquer alucinações na descrição original do MLLM e acrescenta pormenores que lhe escaparam.

Os investigadores deram à sua abordagem o nome de Pica-pau, em referência à forma como a ave apanha insectos das árvores.

Os resultados dos testes mostraram que o Woodpecker alcançou uma melhoria de precisão de 30,66% para o MiniGPT4 e 24,33% para os modelos mPLUG-Owl.

O carácter genérico dos modelos exigidos nesta abordagem significa que a abordagem Woodpecker pode ser facilmente integrada em vários MLLM.

Se a OpenAI integrar o Woodpecker no ChatGPT, poderemos assistir a uma melhoria significativa do já impressionante desempenho visual. Uma redução da alucinação MLLM poderia também melhorar a tomada de decisões automatizada por parte dos sistemas que utilizam descrições visuais como inputs.