A IA gira em torno dos dados, mas de onde é que eles vêm? Os conjuntos de dados são legais e éticos? Como é que os programadores determinam isso com certeza?

O treino de modelos de aprendizagem automática, como os modelos de linguagem de grande dimensão (LLM), requer grandes volumes de dados de texto.

Existem montes de conjuntos de dados disponíveis em plataformas como o Kaggle, o GitHub e o Hugging Face, mas estes encontram-se numa zona cinzenta do ponto de vista legal e ético, principalmente devido a questões de licenciamento e de utilização justa.

O Iniciativa sobre a proveniência dos dados, um esforço de colaboração entre investigadores de IA e profissionais do sector jurídico, analisou milhares de conjuntos de dados para esclarecer as suas verdadeiras origens.

É centrou-se em mais de 1800 conjuntos de dados disponíveis em plataformas, incluindo Hugging Face, GitHub e Papers With Code. Os conjuntos de dados são predominantemente concebidos para afinar modelos de fonte aberta como o Llama-2.

O estudo revelou que aproximadamente 70% destes conjuntos de dados não tinham informações claras sobre o licenciamento ou estavam marcados com licenças demasiado permissivas.

Com uma flagrante falta de clareza sobre os direitos de autor e as restrições de utilização comercial, os programadores de IA arriscam-se a infringir acidentalmente a lei ou a violar os direitos de autor.

Shayne Longpre, um candidato a doutoramento no MIT Media Lab que liderou a auditoria, sublinhou que a questão não é culpa das plataformas de alojamento, mas sim um problema sistémico da comunidade de aprendizagem automática.

2023 assistiu-se a um enxurrada de acções judiciais visando os principais criadores de IA, como a Meta, a Anthropic e a OpenAI, que estão sob extrema pressão para adotar práticas de recolha de dados mais transparentes. Regulamentos, como o Lei da IA da UEestão definidas para aplicar exatamente isso.

A iniciativa Data Provenance permite aos programadores de aprendizagem automática explorar os conjuntos de dados auditados aqui. A iniciativa também analisa padrões dentro dos conjuntos de dados, lançando luz sobre as suas origens geográficas e institucionais.

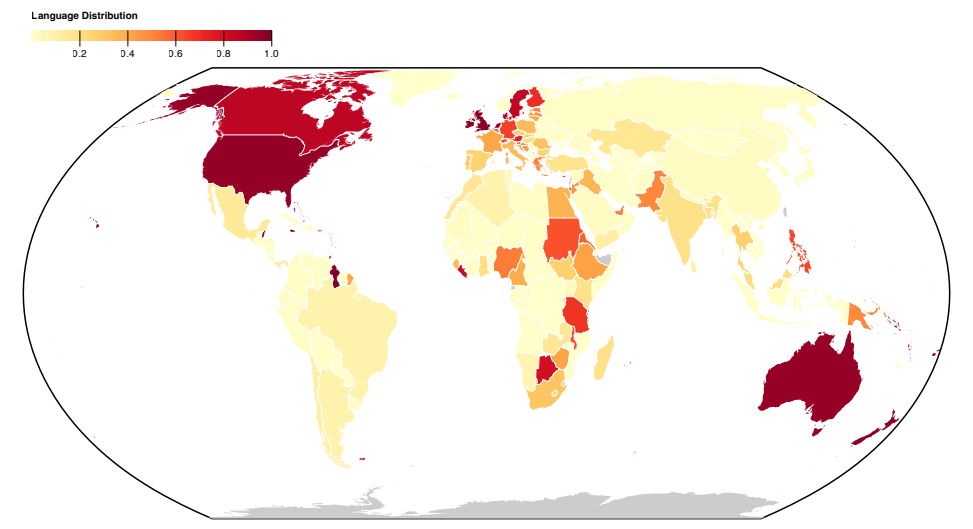

A maior parte dos conjuntos de dados são construídos no Norte Global anglófono, o que realça os desequilíbrios socioculturais.

Mais informações sobre o estudo

Esta análise em grande escala de conjuntos de dados revelou problemas sistemáticos na forma como os dados são recolhidos e distribuídos. A iniciativa também produziu um documento para explicar as suas conclusões, publicado aqui.

Mais informações sobre os métodos e os resultados do estudo:

- Analisar conjuntos de dados quanto à origem e rotulagem: Este estudo auditou sistematicamente mais de 1800 conjuntos de dados de afinação para analisar a proveniência, o licenciamento e a documentação dos dados.

- Provas de rotulagem incorrecta: Os resultados evidenciaram a diferença entre os tipos de dados disponíveis ao abrigo de diferentes licenças e as implicações para as interpretações jurídicas dos direitos de autor e da utilização justa. Descobriu-se uma elevada taxa de má classificação das licenças, com mais de 72% de conjuntos de dados que não especificam uma licença e uma taxa de erro de 50% nos que a especificam.

- Proveniência de dados não fiável: A investigação chama a atenção para a questão da falta de fiabilidade da proveniência dos dados, salientando a necessidade de normas para rastrear a linhagem dos dados, garantir uma atribuição adequada e incentivar uma utilização responsável dos dados.

- Distribuição geográfica: O estudo destaca uma grave falta de representação e atribuição de conjuntos de dados provenientes do Sul Global. A maioria dos conjuntos de dados gira em torno da língua inglesa e está culturalmente ligada à Europa, à América do Norte e à Oceânia de língua inglesa.

Este estudo destaca questões sistémicas e estruturais na forma como os dados são criados, distribuídos e utilizados. Os dados são um recurso crítico para a IA e, tal como os recursos naturais, são finitos.

Existe a preocupação de que a tecnologia de IA acabe por ultrapassar os actuais conjuntos de dados e, possivelmente, até começar a consumir a sua própria produçãoou seja, os modelos de IA aprenderão com o texto gerado pela IA.

Esta situação pode corroer a qualidade dos modelos, o que significa que os dados de alta qualidade, éticos e legais podem tornar-se efetivamente muito valiosos.