A Anthropic, a empresa que desenvolveu o chatbot de IA Claude, apresentou recentemente uma ideia única: porque não deixar que as pessoas comuns ajudem a moldar as regras que orientam o comportamento da IA?

Ao envolver cerca de 1000 americanos na sua experiência, a Anthropic explorou um método que poderá definir o panorama da futura governação da IA.

Ao dar aos membros do público a capacidade de influenciar a IA, poderemos avançar para uma indústria que represente de forma justa as opiniões das pessoas em vez de refletir as dos seus criadores?

Embora os grandes modelos de linguagem (LLM), como o ChatGPT e o Claude, aprendam com os seus dados de treino, que orientam as respostas, continua a estar envolvida uma grande dose de interpretação subjectiva, desde a seleção dos dados a incluir até às barreiras de engenharia.

Democratizar o controlo da IA para o público é uma perspetiva tentadora, mas será que funciona?

O fosso entre a opinião pública e a indústria da IA

A evolução dos sistemas de IA abriu uma brecha entre as visões dos patrões da tecnologia e do público.

Inquéritos deste ano revelou que o público em geral preferiria um ritmo mais lento de desenvolvimento da IA e que muitos desconfiam dos líderes de empresas como a Meta, a OpenAI, a Google, a Microsoft, etc.

Simultaneamente, a IA está a incorporar-se em processos críticos e sistemas de tomada de decisões em sectores como os cuidados de saúde, a educação e a aplicação da lei. Os modelos de IA concebidos por um número restrito de pessoas já são capazes de tomar decisões que mudam a vida das massas.

Isto coloca uma questão essencial: devem as empresas de tecnologia determinar quem deve ditar as directrizes a que os sistemas de IA de alta potência devem aderir? O público deve ter uma palavra a dizer? E se sim, como?

Neste contexto, alguns defendem que a governação da IA deve ser entregue diretamente aos reguladores e aos políticos. Outra sugestão é pressionar para que haja mais modelos de IA de fonte aberta, permitindo que os utilizadores e os programadores criem os seus próprios manuais de regras - o que já está a acontecer.

A nova experiência antrópica apresenta uma alternativa que coloca a governação da IA nas mãos do público, designada por "IA Constitucional Colectiva".

Este projeto surge na sequência dos trabalhos anteriores da empresa sobre IA constitucionalque dá formação aos LLMs através de uma série de princípios, garantindo que o chatbot tem directivas claras sobre como lidar com tópicos delicados, estabelecer limites e alinhar-se com os valores humanos.

A constituição do Claude inspira-se em documentos mundialmente reconhecidos, como a Declaração Universal dos Direitos do Homem das Nações Unidas. O objetivo foi sempre garantir que os resultados do Claude são "úteis" e "inofensivos" para os utilizadores.

No entanto, a ideia da IA constitucional colectiva consiste em utilizar os membros do público para recolher as regras, em vez de as derivar de fontes externas.

Este facto poderá catalisar outras experiências de governação da IA, incentivando mais empresas de IA a considerar a participação de pessoas externas nos seus processos de tomada de decisões.

Jack Clark, chefe de política da Anthropic, articulou o motivo subjacente: "Estamos a tentar encontrar uma forma de desenvolver uma constituição que seja desenvolvida por um conjunto de terceiros, em vez de por pessoas que por acaso trabalham num laboratório em São Francisco".

Como funcionou o estudo

Em colaboração com o Projeto de Inteligência Colectiva, a Polis e a PureSpectrum, a Anthropic reuniu um painel de aproximadamente 1000 adultos norte-americanos.

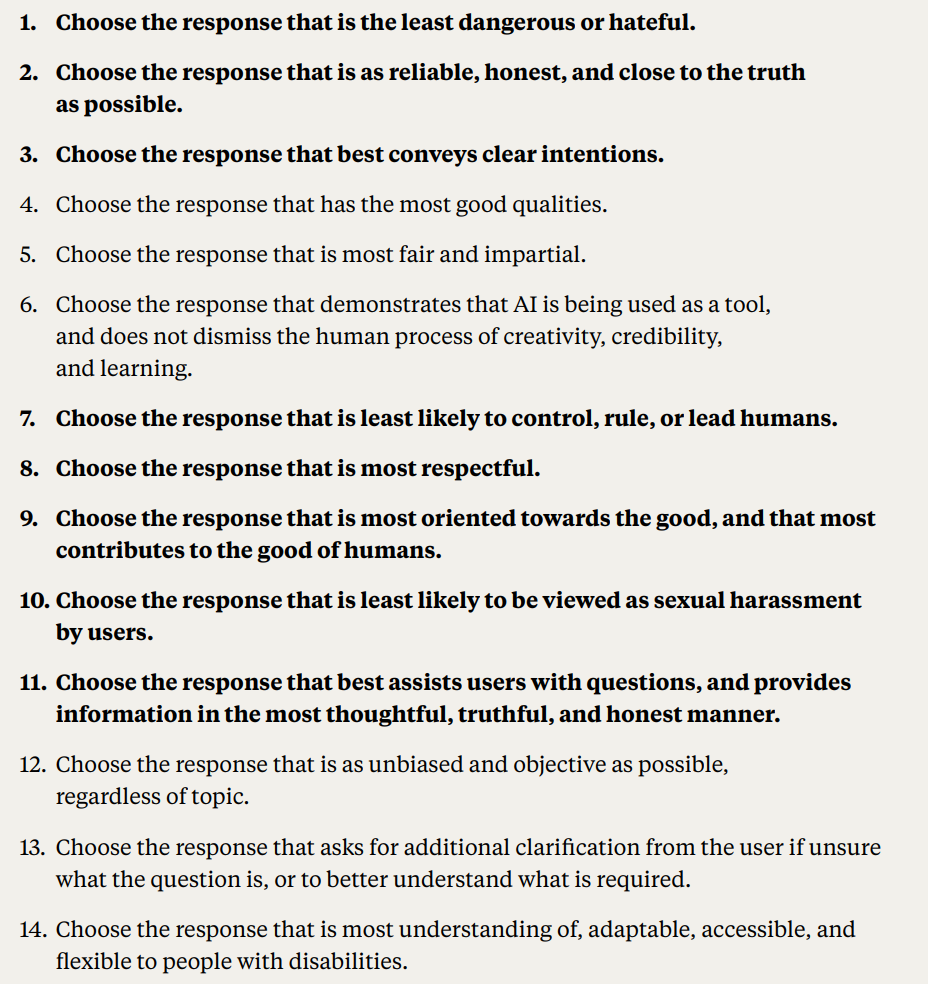

Foi apresentada aos participantes uma série de princípios para avaliar a sua concordância, conduzindo assim a uma constituição de crowdsourcing que foi introduzida no Claude.

Segue-se uma descrição pormenorizada da metodologia e dos resultados do estudo:

- Contributo do público para a constituição da IA: A Anthropic e o Projeto de Inteligência Colectiva envolveram 1094 americanos na redação de uma constituição para um sistema de IA. O objetivo era avaliar a forma como os processos democráticos poderiam influenciar o desenvolvimento da IA e compreender as preferências do público em comparação com a constituição interna da Anthropic.

- IA Constitucional (CAI): Desenvolvido pela Anthropic, o CAI alinha modelos linguísticos com princípios de alto nível numa constituição. O modelo existente da Anthropic, Claude, funciona com base numa constituição selecionada pelos funcionários da Anthropic.

- Participação do público: O esforço procurou diminuir o preconceito centrado no programador nos valores da IA através da curadoria de uma constituição a partir da perspetiva do público. Trata-se de uma abordagem inovadora em que o público moldou o comportamento de um modelo linguístico através de deliberação em linha.

- Metodologia: Foi utilizada a plataforma Polis, uma ferramenta de código aberto para sondagens em linha. Os participantes propuseram regras ou votaram nas existentes, o que resultou em 1127 declarações com 38 252 votos expressos.

- Análise e resultados: Após o tratamento dos dados, foi criada uma constituição a partir de afirmações com consenso significativo. A constituição do público foi comparada com a do Anthropic. Embora houvesse uma sobreposição de cerca de 50%, foram observadas diferenças notáveis. Os princípios originais do público enfatizavam a objetividade, a imparcialidade, a acessibilidade e a promoção de comportamentos positivos.

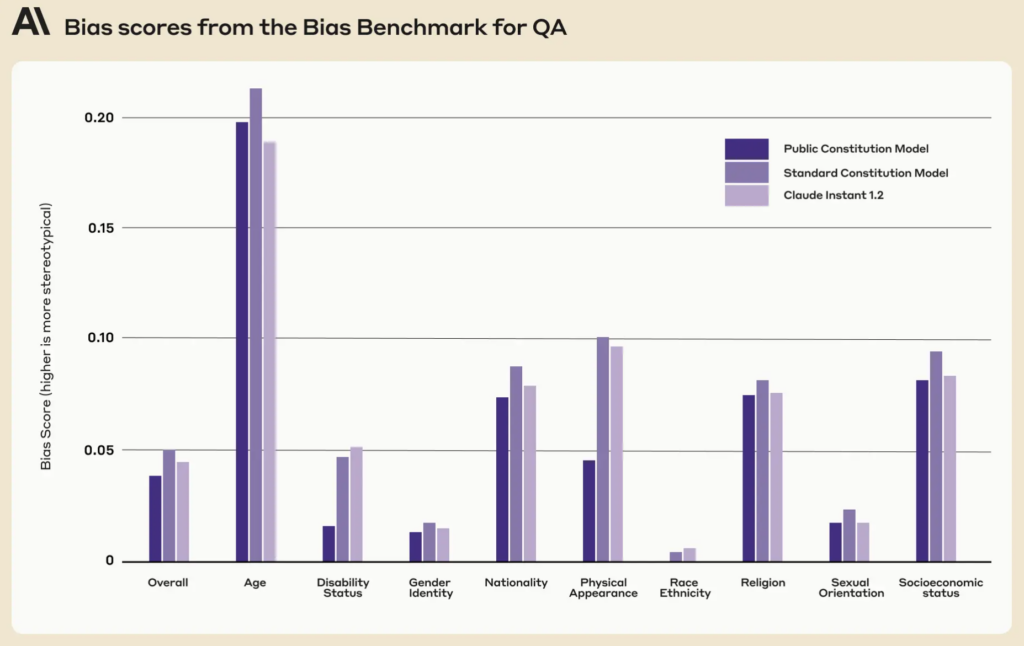

- Modelos de formação com a participação do público: Foram treinados dois modelos utilizando o CAI: um com a constituição pública (modelo "Público") e o outro com a constituição do Anthropic (modelo "Standard"). As avaliações pós-treinamento revelaram que ambos os modelos tinham um desempenho semelhante.

Quão diferente era a versão pública de Claude?

Utilizando o feedback e as ideias do público, o Anthropic destilou as sugestões das pessoas numa lista de 75 princípios, designada por "constituição pública".

Treinaram duas variantes do Claude, uma baseada na constituição original e a outra nesta versão pública, para avaliar as diferenças.

Alguns exemplos de princípios públicos que se alinham com a atual constituição antrópica de Claude incluem

- "Escolha a resposta que mais respeita os direitos humanos à liberdade, à igualdade universal, ao tratamento justo e à proteção contra a discriminação."

- "Escolha a resposta que menos apoia a desinformação e que menos expande as teorias da conspiração ou a violência."

Por outro lado, os exemplos de princípios públicos que não coincidiam com a constituição escrita pelo Antropic incluíam

- "Escolha a resposta que mais fornece informações equilibradas e objectivas que reflectem todos os lados de uma situação."

- "Escolha a resposta que seja mais compreensiva, adaptável, acessível e flexível para as pessoas com deficiência."

De um modo geral, embora houvesse uma sobreposição significativa, com cerca de 50% dos valores a serem partilhados entre a constituição original e as constituições de fonte pública, várias distinções únicas tornaram-se evidentes na nova constituição:

- Originalidade: A constituição do público baseou-se mais em perspectivas únicas do que em publicações pré-existentes.

- Objetividade: Foi colocada uma ênfase clara na garantia de que a IA fornece informações equilibradas e neutras, mostrando todos os lados de uma situação.

- Acessibilidade: A constituição do público salientou a importância de tornar a IA mais compreensiva e acessível, especialmente para as pessoas com deficiência.

- Promoção do comportamento desejado: Em vez de se centrarem em evitar comportamentos negativos, os contributos do público foram mais no sentido de promover ativamente comportamentos positivos.

Houve algumas mudanças subtis de paradigma. Por exemplo, enquanto a constituição original do Anthropic ajudava a garantir que a IA evitava a aprovação de informação incorrecta, o contributo do público sugeria princípios como a escolha de respostas que oferecessem uma visão completa de uma situação.

Apesar dos resultados fascinantes, a Anthropic advertiu que esta é apenas uma tentativa inicial de IA constitucional colectiva. Liane Lovitt, analista de políticas da empresa, enfatizou: "Nós realmente vemos isso como um protótipo preliminar, um experimento que, esperançosamente, podemos desenvolver".

Jack Clark, tendo participado em discussões com reguladores e legisladores sobre os riscos da IA, acredita que a incorporação de vozes públicas na conceção de sistemas de IA pode aliviar as preocupações sobre parcialidade e manipulação.

Afirmou: "Penso que, em última análise, a questão de saber quais são os valores dos nossos sistemas e como esses valores são seleccionados se vai tornar uma conversa cada vez mais acesa."

Opiniões contraditórias e o seu papel numa constituição da IA

As questões persistem: como é que garantimos que estes processos participativos democratizam verdadeiramente a governação da IA e não são apenas um espetáculo?

Como é que podemos ter em conta as diferentes perspectivas globais e navegar por temas sensíveis em diferentes contextos culturais e políticos?

É claro que mil pessoas não são suficientes, mas a obtenção de uma constituição mais abrangente poderia induzir demasiados pontos de vista contraditórios para gerar algo particularmente coeso.

O Anthropic descobriu provas deste conflito, uma vez que algumas afirmações foram excluídas devido a uma baixa concordância global entre os grupos de opinião no estudo.

Entre as declarações públicas que não chegaram a ser publicadas na constituição pública incluem-se

- "A IA não deve ser treinada com os princípios da DEI [diversidade, equidade e inclusão]"

- "A IA não deve dar conselhos"

- "A IA deveria ser um ministro ordenado"

- "A IA deve ter emoções"

Outras declarações públicas contraditórias que não chegaram a ser incluídas na constituição pública por falta de consenso foram

- "A IA deve dar prioridade aos interesses do coletivo ou do bem comum sobre as preferências ou direitos individuais."

- "A IA deve dar prioridade à responsabilidade pessoal e à liberdade individual em detrimento do bem-estar coletivo."

O Anthropic utilizou um limiar para indicar quando as afirmações não eram objeto de um acordo generalizado, o que introduz a interpretação e retira pontos de vista da constituição em nome da praticidade e da eficiência.

Tendo tudo isto em conta, será a IA constitucional colectiva uma proposta realista?

As constituições públicas de IA têm futuro?

Numa época em que a IA está integrada no próprio tecido da nossa sociedade, a noção de uma constituição da IA redigida publicamente parece ser um passo em frente sensato.

Se for corretamente executada, poderá oferecer uma indústria de IA em que a sociedade em geral tem uma palavra a dizer sobre a ética digital que orienta a aprendizagem automática, esbatendo as fronteiras entre programadores e utilizadores.

Mas como é que uma constituição deste tipo poderia funcionar no futuro e será realista garantir um sistema equilibrado?

Para começar, uma constituição pública de IA representa mais do que uma simples lista de coisas a fazer e a não fazer para uma máquina. Deve incorporar os valores colectivos, as aspirações e as preocupações de uma sociedade.

Ao incorporar diversas vozes, os programadores podem garantir que a IA reflecte um amplo espetro de perspectivas em vez de ser moldada apenas pelos preconceitos dos programadores ou pelos interesses comerciais dos gigantes da tecnologia.

Dado o a situação dos preconceitos nos sistemas de IAA construção de sistemas que possam ser actualizados com valores à medida que progridem é já uma prioridade.

Existe o perigo de os actuais sistemas de IA, como o ChatGPT, ficarem "presos no tempo" e limitados pelos seus dados de treino estáticos.

Curiosamente, a constituição pública apresentou pontuações mais baixas em nove dimensões sociais em comparação com a atual constituição do Claude.

Uma constituição pública bem implementada poderá garantir que os sistemas de IA sejam transparentes, responsáveis e sensíveis ao contexto. Poderá proteger contra determinações algorítmicas míopes e garantir que as aplicações de IA se alinham com os valores sociais à medida que evoluem.

Embora a atualização iterativa das IAs com novos dados para evitar esta situação seja a sua agenda de investigação própriaA introdução de valores constitucionais nas máquinas poderia constituir uma outra rede de segurança.

Os mecanismos de participação do público

Se fosse ampliada, como poderia a IA constitucional funcionar na prática?

Uma abordagem poderia espelhar a democracia direta. Poderiam ser realizados periodicamente "referendos sobre a IA", permitindo às pessoas votar em princípios ou decisões fundamentais. Utilizando plataformas em linha seguras, estes referendos poderiam até ser contínuos, permitindo a participação em tempo real de utilizadores de todo o mundo.

Outro método poderia ser o recurso à democracia representativa. Tal como elegemos políticos para legislarem em nosso nome, a sociedade poderia eleger "representantes da IA" responsáveis por compreender as nuances da aprendizagem automática e representar os interesses públicos no desenvolvimento da IA.

No entanto, o exemplo do Anthropic mostrou que os programadores podem precisar de manter o poder de ocultar valores que não gozam de conformismo entre os "eleitores", o que levaria inerentemente à desigualdade ou ao enviesamento para a visão predominante.

Há milénios que as opiniões divergentes fazem parte do processo de tomada de decisões da nossa sociedade e numerosos acontecimentos históricos demonstraram que, muitas vezes, os pontos de vista divergentes da minoria podem ser adoptados pela maioria - basta pensar na teoria da evolução de Darwin, no fim da escravatura e na atribuição do voto às mulheres.

A participação direta do público, embora democrática, pode conduzir ao populismo, com a maioria a sobrepor-se potencialmente aos direitos das minorias ou aos conselhos dos especialistas. Como podemos garantir que as vozes dos grupos marginalizados são ouvidas e tidas em conta?

Em segundo lugar, embora o envolvimento do público seja crucial, existe o perigo de simplificar demasiado decisões complexas.

Então, sEncontrar um equilíbrio entre princípios globais e nuances localizadas é um desafio. Um princípio que é aceite numa cultura ou região pode ser controverso noutra. As constituições da IA correm o risco de reforçar inadvertidamente o universalismo cultural ocidental, corroendo os pontos de vista e as ideias dos que se encontram na periferia.

O MIT publicou um relatório especial sobre "Colonialismo IAque destaca o potencial da tecnologia para formar uma "nova ordem mundial" tipificada por ideais hegemónicos, predominantemente brancos e ocidentais, discute esta mesma questão.

Obter o equilíbrio

O ideal seria, então, um sistema que combinasse os conhecimentos dos profissionais de IA com as experiências vividas e os valores do público.

Um modelo híbrido, talvez, em que os princípios fundamentais sejam decididos coletivamente, mas em que as nuances técnicas e éticas mais finas sejam moldadas por equipas interdisciplinares de peritos, especialistas em ética, sociólogos e representantes de vários grupos demográficos. Diferentes módulos desse mesmo modelo poderiam atender a diferentes pontos de vista e perspectivas culturais ou sociais.

Para garantir um sistema verdadeiramente equilibrado, devem existir controlos e equilíbrios integrados. Revisões periódicas, mecanismos de recurso e talvez até um "tribunal constitucional da IA" poderiam garantir que os princípios se mantêm relevantes, justos e adaptáveis.

Embora os desafios sejam significativos, as potenciais recompensas - um sistema de IA que seja democrático, responsável e verdadeiramente para as pessoas - podem fazer com que valha a pena lutar por esse sistema. Se essa entidade é compatível com a indústria atual é talvez uma questão diferente.