Os investigadores da Universidade de Chicago desenvolveram uma nova ferramenta para "envenenar" os modelos de IA quando as empresas de IA incluem imagens nos seus conjuntos de dados sem consentimento.

Empresas como a OpenAI e a Meta foram alvo de críticas e acções judiciais devido ao facto de terem extraído conteúdos em linha para treinar os seus modelos. Para que os geradores de texto-imagem como o DALL-E ou o Midjourney sejam eficazes, têm de ser treinados com grandes quantidades de dados visuais.

Uma série de artistas queixaram-se de que estes geradores de imagens podem agora produzir imagens ao seu estilo, depois de terem retirado a sua arte sem consentimento.

O os investigadores criaram o Nightshade, uma ferramenta que incorpora pixéis invisíveis numa imagem que, subsequentemente, a torna "venenosa" para os modelos de IA.

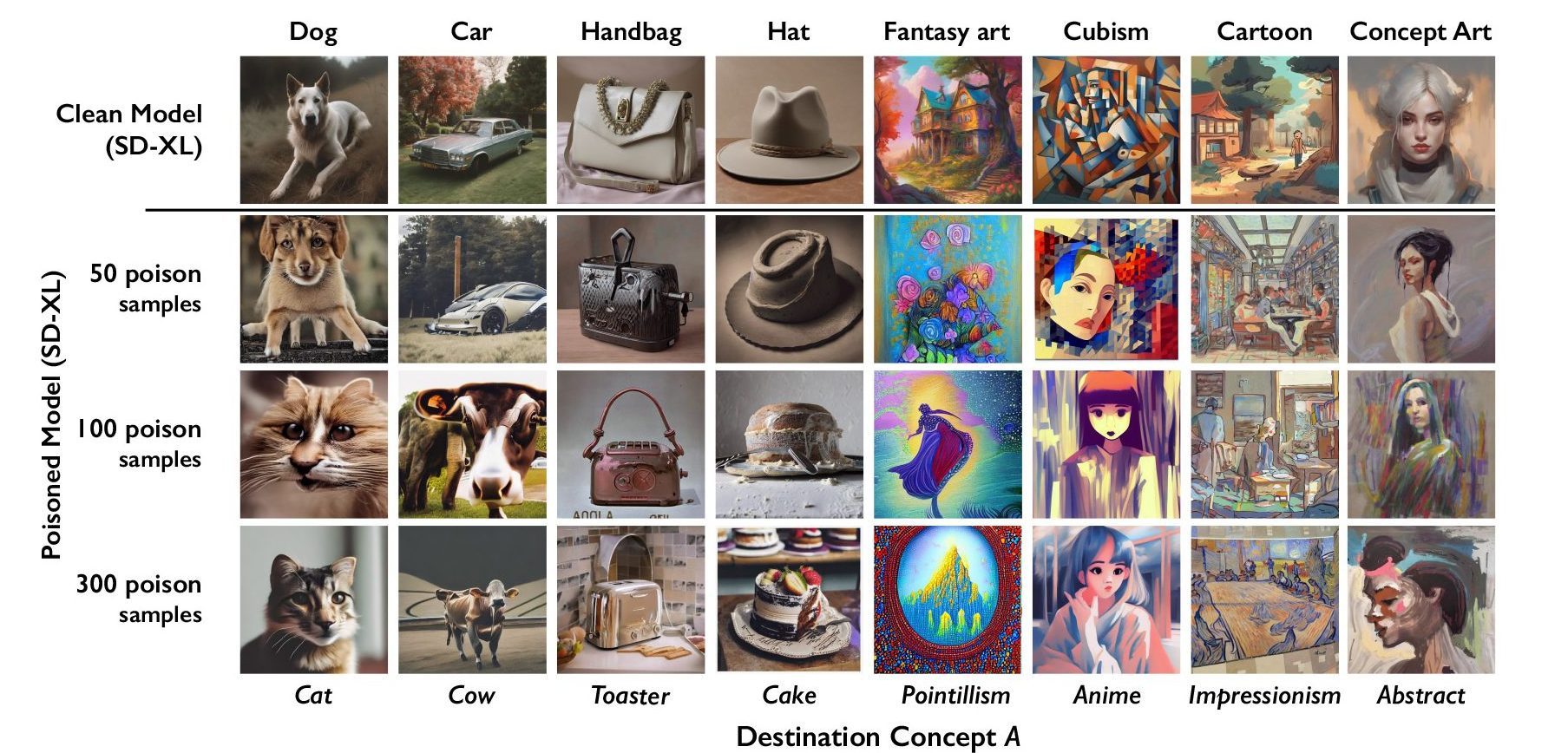

A IA generativa baseia-se em dados corretamente rotulados. Se um modelo de IA for treinado com milhares de imagens de gatos e todas as imagens estiverem identificadas como "gato", então sabe qual deve ser o aspeto de um gato quando lhe pedimos para gerar uma imagem de um.

O Nightshade incorpora dados na imagem que corrompem a classificação da imagem. Assim, uma imagem de um castelo envenenado pelo Nightshade seria classificada como um camião velho, por exemplo. Os investigadores descobriram que a utilização de apenas 100 imagens para uma única mensagem era eficaz para corromper um modelo.

O Nightshade é uma má notícia para os geradores de imagens de IA

Um modelo afetado por dados envenenados pode ser levado a pensar que imagens de bolos são chapéus, ou que torradeiras são bolsas. Além de corromper a palavra específica visada pelo Nightshade, a corrupção também infecta conceitos mais amplos. Assim, corromper o rótulo "cão" estenderia a corrupção a termos como "cachorro" também.

Se um número suficiente de artistas começar a utilizar o Nightshade, as empresas poderão ter muito mais cuidado com a obtenção de consentimento antes de capturar imagens.

A equipa de investigação irá incorporar o Nightshade na ferramenta Glaze que também desenvolveu. O Glaze rotula incorretamente o estilo de uma imagem. Por exemplo, um artista que queira proteger o estilo do seu trabalho pode utilizar o Glaze para o rotular como "impressionista" quando na realidade é "pop art".

O facto de ferramentas como o Nightshade funcionarem tão eficazmente realça uma vulnerabilidade em geradores de texto-imagem que poderiam ser explorados por actores maliciosos.

Empresas como a OpenAI e a Stability AI afirmam que vão respeitar a opt-outs "não efetuar scraping que os sites podem adicionar aos seus ficheiros robots.txt. Se as imagens envenenadas pelo Nightshade não forem raspadas, os modelos não serão afectados.

No entanto, os actores maliciosos podem envenenar uma grande quantidade de imagens e disponibilizá-las para recolha com a intenção de danificar os modelos de IA. A única forma de contornar esta situação é através de melhores detectores de etiquetas ou revisão humana.

O Nightshade fará com que os artistas se sintam um pouco mais seguros ao colocarem os seus conteúdos online, mas poderá causar sérios problemas aos geradores de imagens com IA.