A forma exacta como o nosso cérebro processa e formula a linguagem continua a ser um grande mistério. Os investigadores da Meta AI descobriram uma nova forma de medir as ondas cerebrais e descodificar as palavras que lhes estão associadas.

As pessoas que têm capacidades motoras muito limitadas, como as que sofrem de ELA, têm um desafio especial para comunicar. É difícil imaginar a frustração de uma pessoa como Stephen Hawking, que constrói meticulosamente uma frase com movimentos oculares ou contorcendo um músculo da bochecha.

Foi efectuada muita investigação para descodificar o discurso a partir da atividade cerebral, mas os melhores resultados dependem da invasividade implantes cérebro-computador.

Os investigadores da Meta AI utilizaram a magneto-encefalografia (MEG) e a eletroencefalografia (EEG) para registar as ondas cerebrais de 175 voluntários enquanto ouviam histórias curtas e frases isoladas.

Utilizaram um modelo de discurso pré-treinado e aprendizagem contrastiva para identificar que padrões de ondas cerebrais estavam associados a palavras específicas que os sujeitos estavam a ouvir.

`Decodificar a perceção da fala a partir de registos cerebrais não invasivos`,

liderados pelo primeiro e único @honualx

acaba de ser publicado na última edição da revista Nature Machine Intelligence:- artigo de acesso livre: https://t.co/1jtpTezQzM

- código de formação completo: https://t.co/Al2alBxeUC pic.twitter.com/imLxRjRQ6h- Jean-Rémi King (@JeanRemiKing) 5 de outubro de 2023

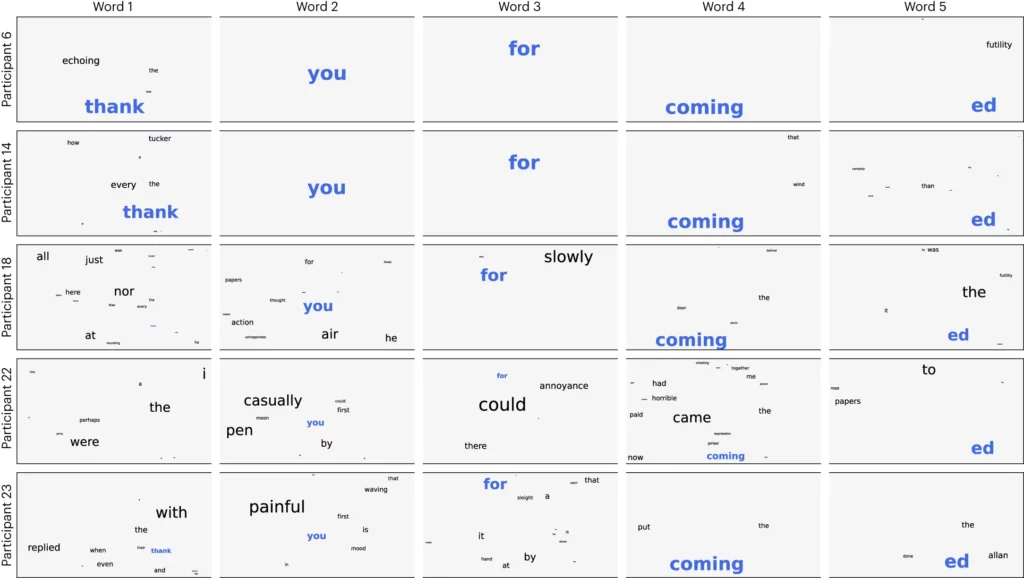

Os investigadores dividiram o áudio em segmentos de 3 segundos e testaram o seu modelo para ver se este conseguia identificar corretamente qual dos 1500 segmentos o voluntário estava a ouvir. O modelo previu uma espécie de nuvem de palavras, com a palavra mais provável a ter mais peso.

Obtiveram uma precisão média de 41% e uma precisão de 95,9% com os seus melhores participantes.

A investigação mostra que é possível ter uma ideia bastante boa do discurso que uma pessoa está a ouvir, mas agora o processo precisa de ser invertido para ser útil. Precisamos de medir as suas ondas cerebrais e saber em que palavra estão a pensar.

O documento sugere o treino de uma rede neuronal enquanto os sujeitos produzem palavras através da fala ou da escrita. Esse modelo geral poderia então ser utilizado para dar sentido às ondas cerebrais e às palavras associadas em que uma pessoa com ELA estivesse a pensar.

Os investigadores foram capazes de identificar segmentos de discurso a partir de um conjunto pré-determinado limitado. Para uma comunicação correcta, seria necessário identificar muito mais palavras. A utilização de uma IA generativa para prever a próxima palavra mais provável que uma pessoa está a tentar dizer pode ajudar nesse sentido.

Apesar de o processo não ser invasivo, continua a ser necessário estar ligado a um Dispositivo MEG. Infelizmente, os resultados das medições EEG não foram óptimos.

A investigação mostra a promessa de que a IA poderá vir a ser utilizada para ajudar as pessoas sem voz, como as que sofrem de ELA, a comunicar. A utilização de um modelo pré-treinado também evitou a necessidade de um treino mais meticuloso, palavra a palavra.

A Meta AI divulgou publicamente o modelo e os dados, pelo que se espera que outros investigadores desenvolvam o seu trabalho.