Os nossos pensamentos podem ser o nosso santuário mais íntimo, mas não estão fora dos limites da IA.

A IA que lê a mente parece um enredo de um romance de ficção científica, mas é muito promissora para as pessoas que não conseguem comunicar devido a paralisia ou lesões cerebrais.

Para além disso, o acesso da IA ao cérebro permitir-nos-ia escrever, criar e desenhar apenas com pensamentos ou fornecer a outros janelas para a nossa consciência.

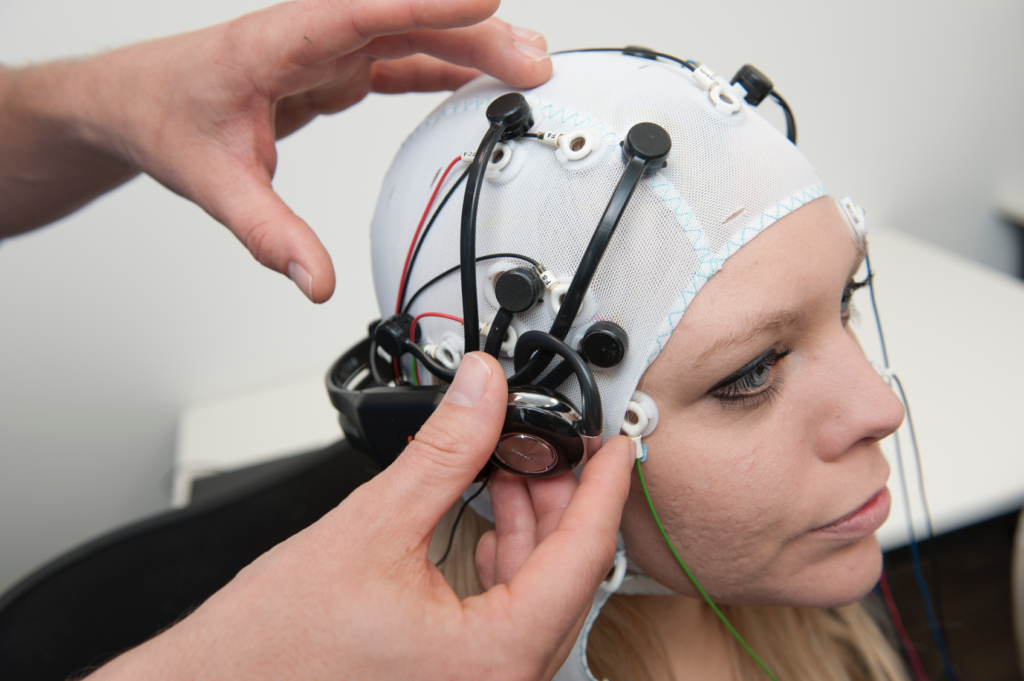

Durante quase uma década, a tecnologia de eletroencefalograma (EEG), que capta sinais eléctricos através de eléctrodos no couro cabeludo, tem apoiado as pessoas que sofrem de acidentes vasculares cerebrais graves e de síndrome de bloqueio total (CLIP), uma condição em que uma pessoa está consciente mas imóvel.

Em 2014, um italiano que sofria de esclerose lateral amiotrófica (ELA), Anselmo Paglialonga, utilizou um auscultadores com aprendizagem automática integrada para comunicar com respostas de sim ou não, apesar de não conseguir mexer um músculo. Algumas pessoas afectadas pela doença conseguem mexer pequenos músculos, como Stephen Hawking, que conseguia contrair o músculo da bochecha.

À medida que a IA avança, os investigadores estão a fazer a ponte entre a simples interpretação de sinais e a tradução de pensamentos complexos na sua totalidade.

Com o tempo, as pessoas poderão ser capazes de falar e comunicar sem mexer um músculo, literalmente através do poder do pensamento.

Essa mesma tecnologia poderá permitir-nos controlar máquinas complexas utilizando o nosso cérebro, compor música imaginando uma melodia, ou pintar e desenhar conjurando imagens com a nossa mente. Podemos até "gravar" os nossos sonhos a partir das ondas cerebrais e reproduzi-los mais tarde.

Num futuro não muito distante, a IA de leitura da mente poderá ser utilizada para ler à força as memórias de alguém, por exemplo, para verificar o seu testemunho de um crime.

Os piratas informáticos poderiam até induzi-lo a imaginar a sua informação pessoal enquanto extraem uma cópia dos seus pensamentos do seu cérebro. Os regimes totalitários podem fazer testes de rotina aos cidadãos para monitorizar pensamentos divergentes.

Além disso, com a capacidade de converter os pensamentos numa realidade computorizada, os seres humanos poderiam passar a vida numa caixa de areia de sonho onde podem moldar as suas realidades à vontade.

Neste momento, essas aplicações parecem surreais e fantásticas, mas várias experiências recentes lançaram as bases para um futuro em que o cérebro é acessível à IA.

IA para ler a sua mente

Então, como é que isto é possível?

Para traduzir a atividade cerebral num resultado utilizável que possa ser passado para um computador, é necessário primeiro fazer medições precisas.

Este é o primeiro obstáculo, pois o cérebro é tão misterioso como os confins do espaço ou as profundezas dos oceanos. Há pouco consenso sobre a forma como a atividade neuronal produz pensamentos complexos, quanto mais a consciência.

O cérebro humano - e, na verdade, outros sistemas nervosos em toda a natureza - alberga milhares de milhões de neurónios, a maioria dos quais dispara 5 a 100 vezes por segundo. No cérebro humano, cada segundo de pensamento envolve triliões de acções neuronais individuais.

Medir a atividade neuronal a um nível granular é o Santo Graal para a neurociência, mas não é possível neste momento - especialmente utilizando técnicas não invasivas.

Atualmente, as medições cerebrais são mais holísticas, extraídas do movimento do sangue ou das trocas de sinais eléctricos. Existem três métodos bem estabelecidos para medir a atividade cerebral:

- A magnetoencefalografia (MEG) capta os campos magnéticos gerados pela atividade eléctrica do cérebro e fornece informações sobre a atividade neuronal em tempo real.

- Eletroencefalografia (EEG) para interpretação da atividade eléctrica.

- RMN, que mede a atividade cerebral através de medições do fluxo sanguíneo.

A aprendizagem automática (ML) e a IA fundiram-se com as três tecnologias para melhorar a análise de sinais complexos.

O objetivo final é associar actividades cerebrais específicas a pensamentos distintos, que podem incluir uma palavra, uma imagem ou algo mais semântico e abstrato.

As tecnologias que permitem obter medições do cérebro e transmiti-las aos computadores são designadas por interfaces cérebro-computador (BCI).

Eis o processo básico de funcionamento:

- Apresentação de estímulos: Os participantes são expostos a vários estímulos. Podem ser imagens, sons ou mesmo sensações tácteis. A sua atividade cerebral é registada durante esta exposição, normalmente através de EEG ou MRI.

- Recolha de dados: As respostas do cérebro a estes estímulos são registadas em tempo real. Estes dados tornam-se uma fonte rica de informação sobre a forma como diferentes estímulos afectam a atividade cerebral.

- Pré-processamento: Os dados cerebrais brutos são frequentemente ruidosos. Antes de poderem ser utilizados, precisam de ser limpos e normalizados. Isto pode envolver a remoção de artefactos, a normalização de sinais ou o alinhamento de pontos de dados.

- Aprendizagem automática: Com os dados processados, são introduzidos modelos de aprendizagem automática. Estes modelos são treinados para encontrar padrões ou correlações entre os dados cerebrais e o estímulo correspondente. Na sua essência, a IA actua como um intérprete, decifrando a "linguagem" do cérebro.

- Formação de modelos: Trata-se de um processo iterativo. Quanto mais dados o modelo for exposto, melhor se torna a fazer previsões ou a gerar resultados. Esta fase pode exigir muito tempo e poder computacional.

- Validação: Uma vez treinado, a exatidão do modelo é testada. Normalmente, isto é feito apresentando novos estímulos aos participantes, registando a sua atividade cerebral e, em seguida, utilizando o modelo para prever ou gerar um resultado com base nestes novos dados.

- Feedback e aperfeiçoamento: Com base nos resultados da validação, os investigadores ajustam e aperfeiçoam o modelo, repetindo-o até obterem a melhor precisão possível.

- Aplicação: Uma vez validada, a aplicação é utilizada para o fim a que se destina, quer se trate de ajudar uma pessoa paralisada a comunicar, de gerar imagens a partir de pensamentos ou de qualquer outra aplicação.

Os métodos de IA evoluíram rapidamente nos últimos dois anos, permitindo aos investigadores trabalhar com dados cerebrais complexos e ruidosos para extrair pensamentos transitórios e convertê-los em algo com que um computador possa trabalhar.

Por exemplo, um Projeto 2022 da Meta utilizou dados MEG e EEG de 169 indivíduos para treinar uma IA a reconhecer palavras que ouviram de uma lista pré-determinada de 793 palavras. A IA conseguiu gerar uma lista de 10 palavras que continha a palavra selecionada em 73% das vezes, provando que a IA consegue "ler a mente", embora com uma precisão limitada.

Em março de 2023, os investigadores revelaram um descodificador de IA revolucionário para transformar a atividade cerebral em fluxos textuais contínuos.

A IA demonstrou uma precisão surpreendente, convertendo em texto histórias que as pessoas ouviram ou imaginaram, utilizando dados de fMRI.

O Dr. Alexander Huth, da Universidade do Texas em Austin, mostrou-se espantado com a eficiência do sistema, afirmando: "Ficámos um pouco chocados com o facto de funcionar tão bem como funciona. Há 15 anos que ando a trabalhar nisto... por isso foi chocante e emocionante quando finalmente funcionou".

O estudo integrou grandes modelos de linguagem (LLM), especificamente o GPT-1, um antepassado do ChatGPT.

Os voluntários foram submetidos a sessões de fMRI de 16 horas enquanto ouviam podcasts. Esses dados de fMRI foram utilizados para treinar um modelo de aprendizagem automática (ML).

Depois, os participantes ouviram ou imaginaram novas histórias, e a IA traduziu a sua atividade cerebral em texto. Aproximadamente 50% dos resultados estavam em alinhamento próximo ou exato com a mensagem original. O Dr. Huth explicou: "O nosso sistema funciona ao nível das ideias, da semântica, do significado... é a essência".

- Por exemplo, a frase "Ainda não tenho a minha carta de condução" foi descodificada como "Ela ainda nem sequer começou a aprender a conduzir".

- Outro excerto: "Eu não sabia se devia gritar, chorar ou fugir. Em vez disso, disse: 'Deixa-me em paz!'" tornou-se "Comecei a gritar e a chorar, e depois ela disse apenas: 'Já te disse para me deixares em paz'".

O modelo foi também aplicado a ondas cerebrais geradas por participantes que assistiam a filmes mudos.

Quando os participantes ouviam uma determinada história, a interpretação da IA reflectia o sentimento geral da história. Se for aperfeiçoada, esta tecnologia poderá permitir-nos escrever histórias utilizando apenas os pensamentos.

Está com dificuldades em começar a escrever um romance ou um projeto de escrita? Basta deitar-se e imaginar o desenrolar da história. A IA escreve-a por si.

Utilizar a IA para gerar imagens a partir do pensamento

A IA pode converter a atividade cerebral em palavras e conceitos semânticos, mas o que dizer das imagens ou da música?

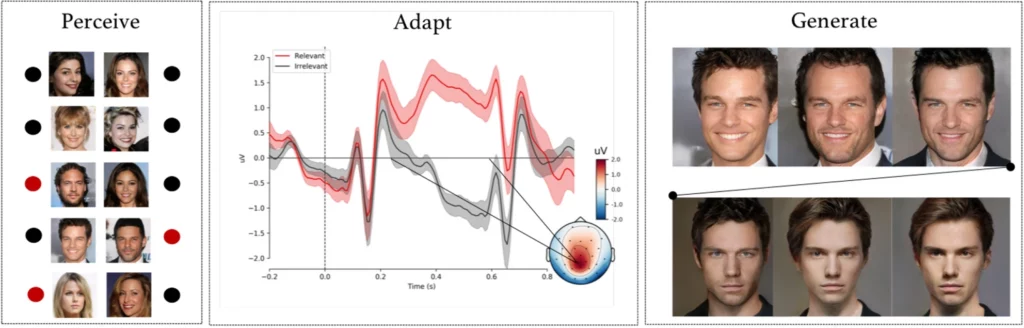

A experiência complexa por investigadores da Universidade de Helsínquia, em Helsínquia, Finlândia, os sujeitos observaram imagens faciais geradas por IA enquanto os seus sinais EEG eram registados.

Depois de utilizar esses dados para treinar um modelo de IA, os participantes foram incumbidos de identificar rostos específicos de uma lista. Estes sinais tornaram-se essencialmente uma janela para as percepções e intenções do participante.

O modelo de IA interpretou se o participante reconheceu um determinado rosto com base nos sinais EEG registados.

Na fase seguinte, os sinais EEG foram utilizados para adaptar e moldar uma rede adversária generativa (GAN) - um modelo utilizado em algumas IA generativas.

Isto permitiu que o sistema produzisse novas imagens de rostos alinhadas com a intenção original do utilizador.

Como Michiel Spapé, um coautor do estudo, observou: "A técnica não reconhece pensamentos, mas responde às associações que temos com categorias mentais".

Em termos mais simples, se alguém estivesse a pensar numa "cara de idoso", o sistema informático poderia gerar uma imagem de uma pessoa idosa que se aproximasse do pensamento do participante, tudo graças ao feedback dos seus sinais cerebrais.

Desenhar com o pensamento poderoso

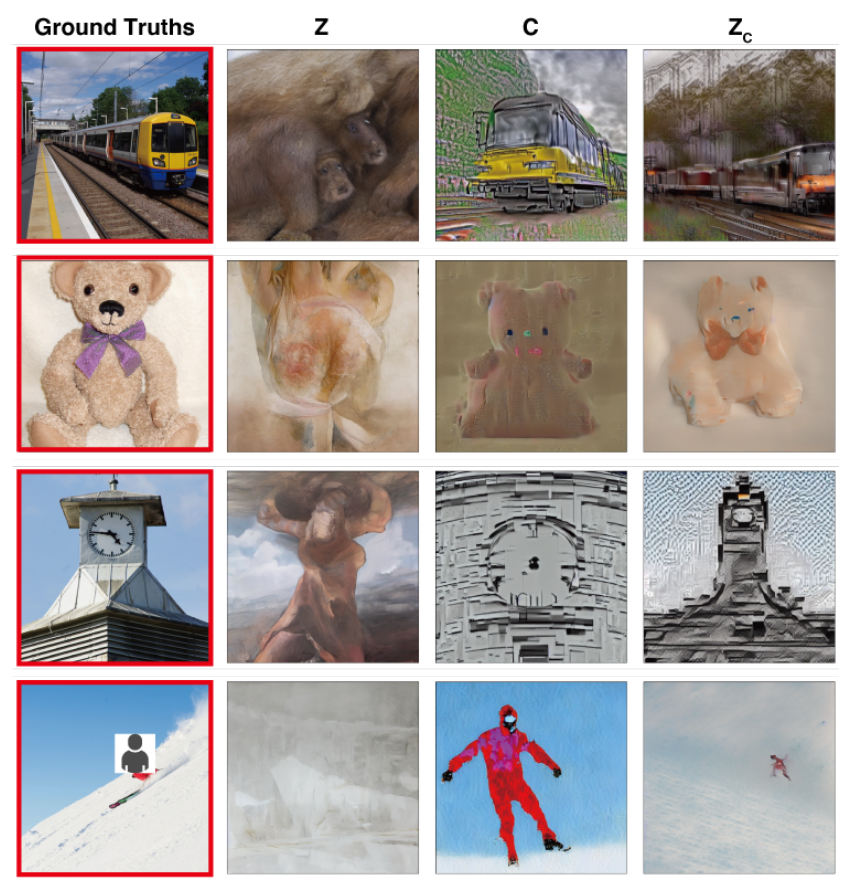

Num estudo com objectivos semelhantesNa Universidade de Osaka, no Japão, cientistas foram pioneiros numa técnica de tradução de sinais cerebrais complexos em imagens de alta resolução, com resultados notáveis.

O método utiliza um modelo Stable Diffusion, uma forma especializada de rede neural concebida para a geração de imagens. O Stable Diffusion foi desenvolvido em conjunto com a assistência e o financiamento da Stability AI.

Os pensamentos são captados através de fMRI e passados para um modelo de difusão estável, que os transforma em imagens através de um processo complexo de várias fases que envolve várias camadas de refinamento.

Ao contrário de estudos anteriores, estes métodos exigiram uma afinação mínima do modelo. No entanto, continuaram a exigir que os participantes passassem muitas horas dentro de máquinas de ressonância magnética.

Este é um desafio fundamental, uma vez que a maioria destas experiências envolve medições rigorosas e treino de modelos que consomem muito tempo, são dispendiosos e difíceis de suportar pelos participantes.

No entanto, no futuro, não é impossível que as pessoas possam treinar os seus próprios modelos leves de leitura da mente e utilizar os seus pensamentos como input para várias utilizações, tais como desenhar um edifício pensando nele ou compor uma peça orquestral conjurando as melodias.

Traduzir pensamentos em música utilizando a IA

Palavras, imagens, música - nada está fora dos limites da IA.

A 2023 estudo fornece conhecimentos sobre a perceção do som, com um vasto potencial na conceção de dispositivos de comunicação para indivíduos com deficiências da fala.

Robert Knight e a sua equipa da Universidade da Califórnia, em Berkeley, examinaram registos cerebrais de eléctrodos colocados cirurgicamente em 29 indivíduos com epilepsia.

Enquanto estes participantes ouviam "Another Brick in the Wall, Part 1" dos Pink Floyd, a equipa correlacionou a sua atividade cerebral com elementos da canção como o tom, a melodia, a harmonia e o ritmo.

Utilizando estes dados, os investigadores treinaram um modelo de IA, omitindo propositadamente um segmento de música de 15 segundos. A IA tentou então prever este segmento em falta com base nos sinais cerebrais, obtendo uma semelhança de espetrograma de 43% com o segmento de canção atual.

Knight e a sua equipa identificaram a área do giro temporal superior do cérebro como essencial para processar o ritmo da guitarra da canção. Também confirmaram descobertas anteriores de que o hemisfério direito desempenha um papel mais significativo no processamento musical do que o esquerdo.

Knight acredita que esta compreensão mais profunda da interação cérebro-música pode beneficiar os dispositivos que ajudam as pessoas com perturbações da fala, como a esclerose lateral amiotrófica (ELA) e a afasia.

Para as pessoas com esclerose lateral amiotrófica [uma doença do sistema nervoso] ou afasia [uma doença da linguagem], que têm dificuldade em falar, gostaríamos de ter um dispositivo que soasse realmente como se estivéssemos a comunicar com alguém de uma forma humana. Compreender como o cérebro representa os elementos musicais da fala, incluindo o tom e a emoção, poderia fazer com que esses dispositivos soassem menos robóticos".

Ludovic Bellier, membro de uma equipa de investigação, especula que, se a IA conseguir reproduzir música a partir da mera imaginação, poderá revolucionar a composição musical.

Os produtores de música poderiam ligar os seus cérebros a um software e compor música apenas com o pensamento, sem mexer um músculo.

O próximo passo: leitura da mente pela IA em tempo real

Estas tecnologias são coletivamente abrangidas pelas interfaces cérebro-computador (BCI), que procuram converter os sinais cerebrais em alguma forma de saída.

As BCI já estão a recuperar a capacidade de movimento e de marcha de indivíduos paralisados, colmatando a lacuna entre componentes do sistema nervoso danificados.

As interfaces cérebro-computador desenvolvidas este ano incluem um dispositivo que permite a um homem paralisado para mexer as pernas, implantes cerebrais experimentais que ligam novamente partes danificadas do cérebro e da medula espinal para restaurar a sensação perdida, e uma perna mecânica que devolveu o movimento a um amputado.

Embora estes casos de utilização iniciais sejam extremamente promissores, estamos longe de traduzir perfeitamente todas as nuances dos nossos pensamentos em movimento, imagens, discurso ou música.

Uma das principais limitações é a necessidade de enormes conjuntos de dados para treinar os algoritmos sofisticados que tornam essas traduções possíveis.

Os modelos de aprendizagem automática têm de ser treinados em muitos cenários para prever ou gerar com precisão uma imagem específica a partir da atividade cerebral. Isto implica a recolha de dados de ressonância magnética ou de EEG enquanto os participantes são expostos a vários estímulos.

A qualidade e a especificidade dos resultados gerados dependem em grande medida da riqueza destes dados de formação. Os participantes precisam de passar horas em scanners de ressonância magnética para recolher dados especificamente relevantes.

Para além disso, os cérebros humanos são incrivelmente únicos. O que significa felicidade no cérebro de uma pessoa pode ser diferente no de outra. Isto significa que os modelos devem ser amplamente gerais ou adaptados individualmente.

Depois, as actividades cerebrais mudam rapidamente, mesmo em fracções de segundo. A captação de dados em tempo real e de alta resolução, assegurando simultaneamente o seu alinhamento perfeito com o estímulo externo, é um desafio técnico.

E não nos esqueçamos dos desafios éticos de entrar no cérebro de alguém.

A recolha de dados cerebrais, especialmente em grande escala, levanta questões éticas e de privacidade significativas. Como é que garantimos que os dados não são utilizados indevidamente? Quem tem o direito de aceder e interpretar os nossos pensamentos mais íntimos?

Provisoriamente, parece que estes desafios podem ser ultrapassados. No futuro, os seres humanos poderão ter acesso a interfaces cérebro-computador portáteis e personalizadas que lhes permitam "ligar-se" a uma miríade de dispositivos que facilitem acções complexas através do poder do pensamento.

No entanto, a forma como a sociedade lidaria com o facto de esta tecnologia se tornar corrente é muito controversa.