Um estudo efectuado por psicólogos da UCLA demonstrou que o GPT-3 é tão bom como os estudantes universitários na resolução de problemas de raciocínio.

Sabemos que os LLMs como o GPT-3 são bons a gerar respostas com base nos dados para os quais foram treinados, mas a sua capacidade de raciocínio é questionável. O raciocínio analógico é a capacidade que os humanos têm de pegar no que aprendemos com uma experiência não relacionada e aplicá-lo a um problema com o qual nunca nos deparámos antes.

É nessa capacidade que se baseia quando tem de responder a uma pergunta que nunca viu antes. Podemos raciocinar com base em problemas anteriores que já resolvemos. E, de acordo com a pesquisa, parece que a GPT-3 também desenvolveu essa capacidade.

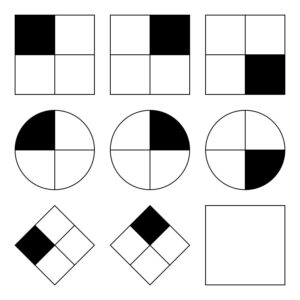

O Investigadores da UCLA colocar a GPT-3 a trabalhar num conjunto de problemas semelhantes a Matrizes progressivas de Raven que consiste em prever a imagem seguinte numa série de imagens. Aqui está um exemplo fácil para experimentar.

O GPT-3 foi capaz de se aguentar sozinho em comparação com os 40 estudantes universitários da UCLA a quem foi pedido que fizessem o mesmo teste. A IA acertou em 80% das respostas, enquanto os 40 estudantes obtiveram uma média de cerca de 60%. Os melhores alunos obtiveram resultados semelhantes aos do GPT-3.

O professor de psicologia da UCLA, Hongjing Lu, autor sénior do estudo, disse: "Surpreendentemente, o GPT-3 não só se saiu tão bem como os humanos, como também cometeu erros semelhantes".

Os investigadores também pediram ao GPT-3 para resolver alguns problemas de associação de palavras. Por exemplo, "'Carro' está para 'Estrada' como 'Barco' está para que palavra?". A resposta é obviamente "água", mas este tipo de perguntas pode ser complicado para uma IA.

Bem, pelo menos os investigadores pensaram que poderia ser complicado. Acontece que o GPT-3 teve um desempenho melhor do que a média dos candidatos à faculdade nos seus SATs.

A GPT-3 debate-se com problemas que são fáceis para os humanos

Os modelos de IA têm dificuldade em resolver problemas que exigem uma compreensão visual do espaço físico. Se apresentarmos ao GPT-3 uma lista de ferramentas como um martelo, um prego e um quadro, ele não é capaz de encontrar a solução óbvia para pendurar o quadro na parede.

Este tipo de problema é fácil de resolver para os humanos porque podemos ver, segurar e sentir objectos físicos num espaço que ocupamos. Essas experiências tornam mais fácil para o nosso cérebro aprender e resolver problemas de uma forma que os modelos de IA não conseguem. Dito isto, o GPT-4 está a melhorar neste tipo de raciocínio.

Embora os investigadores tenham podido medir o desempenho do GPT-3, não têm ideia do processo de "pensamento" que segue para obter as respostas. Será que segue um processo de pensamento semelhante ao dos humanos ou faz algo completamente diferente? Como o GPT-3 é um modelo fechado, não é possível ver o que está a acontecer.

O resultado surpreendente desta investigação é que a GPT-3 parece ser capaz de resolver problemas novos sem qualquer treino direto. Este facto está muito próximo da forma como os humanos resolvem novos problemas. Espera-se que a GPT-4 tenha um desempenho ainda melhor nestes problemas e quem sabe que outras capacidades de "pensamento" poderão surgir com mais testes.

Embora o raciocínio espacial seja um desafio para os LLM, estes desafios podem ser resolvidos por modelos visuais como RT-2 da Google que foi recentemente anunciado. Quando os modelos de IA puderem começar a "ver" e a interagir fisicamente com o que os rodeia, as suas capacidades de resolução de problemas melhorarão exponencialmente.