Os dados são a força vital da IA, mas não são um recurso infinito. Poderá a humanidade ficar sem dados? O que acontece se isso acontecer?

Os modelos complexos de IA requerem grandes quantidades de dados de treino. Por exemplo, o treino de um modelo de linguagem de grande dimensão (LLM) como o ChatGPT requer aproximadamente 10 triliões de palavras.

Alguns especialistas acreditam que a oferta de dados de alta qualidade está a diminuir. Por exemplo, um estudo de 2022 realizado por investigadores de várias universidades declarado, "A nossa análise indica que o stock de dados linguísticos de alta qualidade se esgotará em breve, provavelmente antes de 2026... O nosso trabalho sugere que a atual tendência de crescimento constante dos modelos de aprendizagem automática que dependem de enormes conjuntos de dados poderá abrandar se a eficiência dos dados não for drasticamente melhorada ou se não forem disponibilizadas novas fontes de dados.

Embora a geração de dados sintéticos constitua uma solução, geralmente não consegue captar a profundidade, as nuances e a variação dos dados reais.

Para complicar ainda mais a situação, há preocupações sobre o que acontece quando a IA começa a consumir a sua própria produção, o que os investigadores da École Polytechnique Fédérale de Lausanne (EPFL), na Suíça, acreditam ser já está a acontecer.

A sua investigação indica que as empresas de IA que compram dados produzidos por humanos através de plataformas como a Amazon Mechanical Turk podem receber dados gerados por IA.

O que acontece quando a IA começa a comer o seu próprio produto? É possível evitá-lo?

A criação de conjuntos de dados é dispendiosa e morosa - e os riscos são elevados

Os dados são omnipresentes, mas a sua operacionalização para a IA é um processo complexo. A qualidade dos dados e das etiquetas tem impacto no desempenho do modelo - é um caso de "lixo dentro, lixo fora".

Para descrever brevemente o processo de criação de conjuntos de dados, os anotadores de dados (ou rotuladores) pegam em dados processados (por exemplo, uma imagem cortada) e rotulam características (por exemplo, um carro, uma pessoa, um pássaro).

Isto dá aos algoritmos um "alvo" com o qual aprender. Os algoritmos extraem e analisam características de dados rotulados para prever essas características em dados novos e não vistos.

Isto é necessário para a aprendizagem automática supervisionada, que é um dos principais ramos da aprendizagem automática, juntamente com a aprendizagem automática não supervisionada e a aprendizagem por reforço. Por algumas estimativasO processo de preparação e rotulagem de dados ocupa 80% da duração de um projeto de modelo de aprendizagem automática, mas se não for feito o necessário, o desempenho do modelo pode ser comprometido.

Para além dos desafios práticos da criação de conjuntos de dados de alta qualidade, a própria natureza dos dados muda constantemente. O que se definiria como um "conjunto de dados contendo uma seleção típica de veículos na estrada" há 10 anos atrás não é o mesmo hoje. Atualmente, por exemplo, existe um número muito maior de trotinetas e bicicletas eléctricas nas estradas.

Estes são os chamados "casos extremos", que são objectos ou fenómenos raros que não estão presentes nos conjuntos de dados.

Os modelos reflectem a qualidade dos seus conjuntos de dados

Se treinar um sistema de IA moderno num conjunto de dados antigo, o modelo arrisca-se a ter um desempenho baixo quando exposto a dados novos e inéditos.

Entre 2015 e 2020, os investigadores descobriram grandes enviesamentos estruturais nos algoritmos de IA, que foram parcialmente atribuídos ao treino de modelos em dados antigos e enviesados.

Por exemplo, o Rostos etiquetados na casa selvagem (LFW), um conjunto de dados de rostos de celebridades habitualmente utilizado em tarefas de reconhecimento facial, é constituído por 77,5% do sexo masculino e 83,5% de pele branca indivíduos. Uma IA não tem qualquer esperança de funcionar corretamente se os dados não representarem todas as pessoas que pretende servir. Verificou-se que as taxas de erro de reconhecimento facial entre os principais algoritmos eram tão baixas como 0,8% para homens brancos e tão elevadas como 34,7% para mulheres de pele escura.

Esta investigação culminou no marco histórico Estudo sobre as tonalidades de género e um documentário intitulado Viés codificadoque investigou a forma como a IA está provavelmente a aprender com dados imperfeitos e não representativos.

O impacto desta situação está longe de ser benigno - conduziu a resultados judiciais incorrectos, a falsas prisões e à recusa de emprego e de crédito a mulheres e outros grupos.

As IA precisam de mais dados de alta qualidade, que devem ser justos e representativos - é uma combinação difícil de encontrar.

Serão os dados sintéticos a resposta?

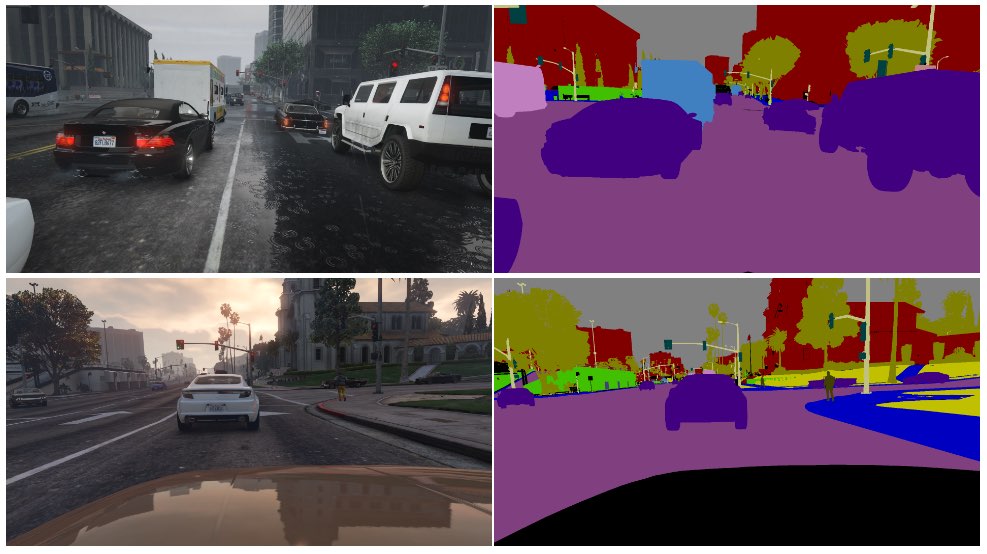

Os dados sintéticos são normalmente utilizados na visão computacional (CV), em que as IA identificam objectos e características a partir de imagens e vídeos.

Em vez de recolher dados de imagem do mundo real - como fotografar ou filmar uma rua - o que é tecnicamente difícil e coloca problemas de privacidade - basta gerar os dados num ambiente virtual.

Embora isto complemente as IA com mais dados, existem vários inconvenientes:

- A modelação de cenários da vida real num ambiente virtual não é simples.

- A produção de grandes quantidades de dados sintéticos continua a ser dispendiosa e morosa.

- Os casos extremos e anómalos continuam a ser um problema.

- Não pode reproduzir perfeitamente a realidade.

- Por outro lado, alguns aspectos podem ser demasiado perfeitos e é difícil determinar o que está a faltar.

No final, os dados sintéticos são excelentes para ambientes prontamente virtualizados, como um chão de fábrica, mas nem sempre são suficientes para ambientes reais de movimento rápido, como uma rua da cidade.

Que tal gerar dados de texto sintéticos?

O texto é mais simples do que os dados de imagem ou de vídeo, pelo que modelos como o ChatGPT podem ser utilizados para gerar dados de treino sintéticos quase infinitos?

Sim, mas é arriscado e os impactos não são fáceis de prever. Embora os dados de texto sintético possam ajudar a afinar, testar e otimizar os modelos, não são ideais para ensinar novos conhecimentos aos modelos e podem enraizar preconceitos e outros problemas.

Eis uma analogia do motivo pelo qual o treino de IAs com dados gerados por IA é problemático:

- Considere-se uma escola que utiliza todos os melhores manuais escolares do mundo para formar os seus alunos com tudo o que há para saber dos seus recursos no espaço de um dia.

- Depois, a escola começa a produzir o seu próprio trabalho com base nesse conhecimento - de forma análoga ao resultado de um chatbot. Os alunos aprenderam com todos os dados disponíveis até à data de início da formação, mas não podem introduzir eficazmente novos dados no sistema de conhecimento depois disso.

- O conhecimento é criado diariamente - embora a grande maioria do conhecimento humano tenha sido criado antes de um dia específico, o conhecimento evolui e transforma-se ao longo do tempo. É crucial que os seres humanos não se limitem a criar constantemente novos conhecimentos - também mudamos a nossa perspetiva sobre os conhecimentos existentes.

- Agora, suponhamos que a escola, esgotada de dados, começa a ensinar os seus alunos utilizando os seus próprios resultados. Os alunos começam a "comer" os seus conteúdos para produzir novos conteúdos.

- Nesta fase, os resultados dos alunos não se adaptam ao mundo real e a sua utilidade diminui. O sistema está a regurgitar o seu próprio trabalho. Embora o trabalho possa adaptar-se e evoluir, fá-lo isoladamente de tudo o que está fora desse ciclo de feedback.

A IA está constantemente a confrontar as pessoas com enigmas para resolver, e este tem muito comentadores no Reddit e o Fórum Y Combinator perplexo.

É algo alucinante, e não há um verdadeiro consenso sobre as ramificações.

Os etiquetadores de dados humanos utilizam frequentemente a IA para produzir dados

O problema da produção de dados de formação de qualidade tem ainda um outro nível imprevisto.

Plataformas de trabalho coletivo como Amazon Mechanical Turk (MTurk) são regularmente utilizadas por empresas de IA que procuram produzir conjuntos de dados genuinamente "humanos". THá receios de que os anotadores de dados nessas plataformas estejam a utilizar IA para realizar as suas tarefas.

Os investigadores da École Polytechnique Fédérale de Lausanne (EPFL), na Suíça, analisaram dados criados através do MTurk para determinar se os trabalhadores utilizavam a IA para gerar as suas candidaturas.

O estudopublicado a 13 de junho, recrutou 44 participantes do MTurk para resumir os resumos de 16 artigos de investigação médica. Descobriu-se que 33% a 46% dos utilizadores da plataforma geraram as suas submissões com IA, apesar de lhes ter sido pedido que respondessem com linguagem natural.

"Desenvolvemos uma metodologia muito específica que funcionou muito bem na deteção de texto sintético no nosso cenário", Manoel Ribeiro, coautor do estudo e estudante de doutoramento na EPFL, disse ao The Register esta semana.

Embora o conjunto de dados e a dimensão da amostra do estudo sejam bastante pequenos, está longe de ser inconcebível pensar que as IA estão a ser treinadas involuntariamente em conteúdos gerados por IA.

O estudo não pretende culpar os trabalhadores da MTurk - os investigadores referem que os baixos salários e o trabalho repetitivo contribuem para o problema. As empresas de IA querem dados de alta qualidade criados por humanos, mantendo os custos baixos. Um comentador disse no Reddit: "Atualmente, sou um destes trabalhadores, encarregado de treinar o Bard. De certeza que estou a usar o ChatGPT para isso. 20$/hr não é suficiente para o tratamento horrível que recebemos, por isso vou espremer cada cêntimo deste trabalho *******".

A toca do coelho vai ainda mais fundo, uma vez que as IA são frequentemente treinadas com base em dados retirados da Internet. À medida que mais conteúdo escrito por IA é publicado em linha, a IA aprenderá inevitavelmente com os seus próprios resultados.

À medida que os seres humanos começam a depender das IA para obter informações, a qualidade dos seus resultados torna-se cada vez mais crítica. Temos de encontrar métodos inovadores para atualizar as IA com dados novos e autênticos.

Como diz Ribeiro, "os dados humanos são o padrão de ouro, porque o que nos interessa são os humanos e não os grandes modelos de linguagem".

Estão em curso trabalhos que analisam o potencial impacto da IA que consome os seus próprios resultados, mas os dados humanos autênticos continuam a ser essenciais para uma vasta gama de tarefas de aprendizagem automática.

Gerar grandes quantidades de dados para IAs famintas e, ao mesmo tempo, navegar pelos riscos é um trabalho em curso.