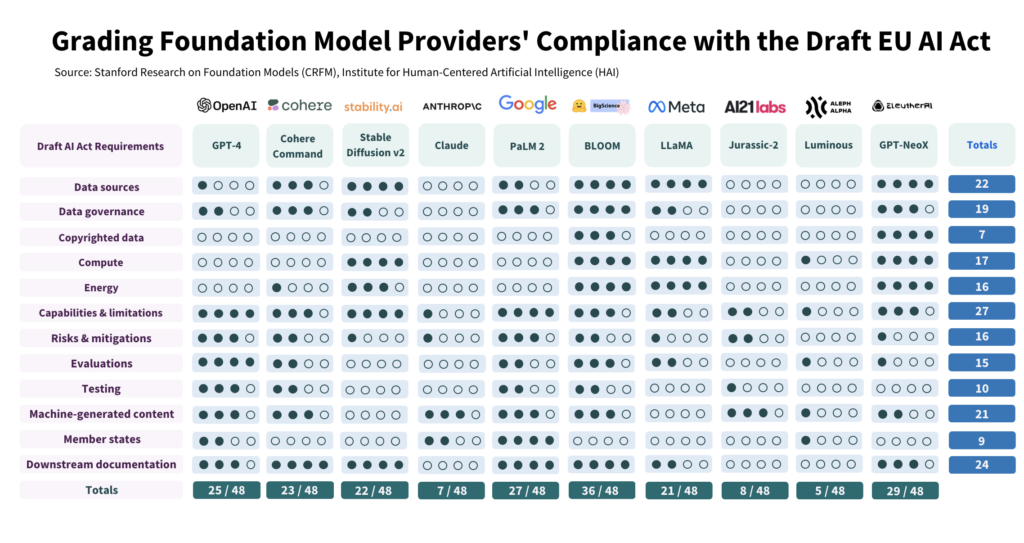

Os investigadores de IA de Stanford avaliaram a conformidade de 10 dos principais modelos de IA com a proposta de Lei da IA da UE e encontraram grandes variações, com resultados geralmente medíocres em todos os sectores.

O estudo examinou criticamente 10 modelos de IA em relação a 12 critérios estabelecidos no projeto de legislação da UE e revelou uma grande variação na conformidade, não havendo nenhum modelo que preencha todas as condições.

O estudo destaca o fosso entre as expectativas da Lei da IA e os actuais esforços de governação entre os principais criadores de IA.

Para cumprir a lei, os promotores devem melhorar consideravelmente as suas estratégias de transparência e de redução dos riscos, que, em alguns casos, são quase inexistentes.

Como foi realizado o estudo

Os autores efectuaram um estudo pormenorizado da Lei da IA, tendo extraído 22 requisitos.

Destes, seleccionaram 12 que poderiam ser avaliados de forma significativa utilizando informação pública. De seguida, criaram uma grelha de avaliação de 5 pontos para cada um destes 12 requisitos.

O modelo de IA de código aberto BLOOM, produzido pela Hugging Face, emergiu como o modelo com a pontuação mais elevada, com um total de 36 de um potencial de 48 pontos.

Por outro lado, a Anthropic, apoiada pela Google, e a empresa alemã de IA Aleph Alpha tiveram um desempenho significativamente inferior, com 7 e 5 pontos, respetivamente. ChatGPT ficou no meio do pelotão com 25/48.

Os quatro principais domínios de não conformidade são os dados protegidos por direitos de autor, a energia, a atenuação dos riscos e a avaliação/ensaio.

Um dos autores, Kevin Klyman, investigador do Centro de Investigação de Modelos de Fundações de Stanford, observou que a maioria dos criadores não divulga as suas estratégias de redução do risco, o que pode ser um fator de rutura do negócio. Klyman disse: "Os fornecedores muitas vezes não divulgam a eficácia de suas medidas de mitigação de risco, o que significa que não podemos dizer o quão arriscados são alguns modelos de fundação".

Além disso, há uma grande variação nos dados de treino utilizados para treinar modelos. A UE exigirá que os criadores de IA sejam mais transparentes com as suas fontes de dados, o que 4/10 dos criadores não conseguem fazer. O ChatGPT obteve apenas 1 ponto neste domínio.

Modelos de fonte aberta versus modelos proprietários

O relatório também descobriu uma clara dicotomia na conformidade, dependendo do facto de um modelo ser de fonte aberta ou proprietária.

Os modelos de fonte aberta obtiveram bons resultados no que respeita à divulgação de recursos e aos requisitos de dados, mas os seus riscos não estão, em grande medida, documentados.

Os modelos proprietários são o oposto - são muito testados e altamente documentados com estratégias robustas de mitigação de riscos, mas não são transparentes no que respeita aos dados e às métricas relacionadas com a tecnologia.

Ou, para ser mais preciso, os programadores de código aberto não têm tantos segredos competitivos para proteger, mas os seus produtos são inerentemente mais arriscados, uma vez que podem ser utilizados e modificados por quase toda a gente.

Por outro lado, os programadores privados manterão provavelmente alguns aspectos dos seus modelos fechados a sete chaves, mas podem demonstrar segurança e redução de riscos. Até mesmo a Microsoft, o principal investidor da OpenAI, não tem a certeza absoluta de que os seus modelos são seguros. compreender o funcionamento dos modelos da OpenAI.

O que é que o estudo recomenda?

Os autores do estudo reconhecem que o fosso entre as expectativas da UE e a realidade é alarmante e apresentam várias recomendações aos decisores políticos e aos criadores de modelos.

O estudo recomenda aos decisores políticos da UE:

- Aperfeiçoar e especificar os parâmetros da Lei da IA da UE: Os investigadores argumentam que a linguagem técnica e os parâmetros da Lei da IA são pouco específicos.

- Promover a transparência e a responsabilização: Os investigadores defendem que as regras mais rigorosas devem ser ultra-orientadas para os maiores e mais dominantes promotores, o que deverá conduzir a uma aplicação mais eficaz.

- Disponibilizar recursos suficientes para a aplicação da lei: Para que a Lei da IA da UE seja efetivamente aplicada, devem ser disponibilizados recursos técnicos e talentos às agências de execução.

O estudo recomenda aos decisores políticos mundiais:

- Dar prioridade à transparência: Os investigadores sublinham que a transparência é fundamental e deve ser o principal objetivo dos esforços políticos. Argumentam que os ensinamentos retirados da regulamentação dos meios de comunicação social revelam as consequências nefastas de uma transparência deficiente, que não devem ser repetidas no contexto da IA.

- Esclarecer questões de direitos de autor: Os limites dos direitos de autor para os dados de treino e os resultados da IA são objeto de um debate aceso. Dada a baixa conformidade observada na divulgação de dados de formação protegidos por direitos de autor, os investigadores defendem que as directrizes legais devem especificar a forma como os direitos de autor interagem com os procedimentos de formação e os resultados dos modelos generativos. Tal inclui a definição dos termos em que os direitos de autor ou as licenças devem ser respeitados durante a formação e a determinação da forma como os conteúdos gerados por máquinas podem infringir os direitos de autor.

O estudo recomenda aos criadores de modelos de fundações:

- Esforçar-se por melhorar continuamente: Os fornecedores devem procurar melhorar sistematicamente a sua conformidade. Os fornecedores de maior dimensão, como a OpenAI, devem dar o exemplo e divulgar recursos aos clientes a jusante que acedem aos seus modelos através de API.

- Defender as normas do sector: Os fornecedores de modelos devem contribuir para o estabelecimento de normas do sector, o que pode conduzir a um ecossistema de IA mais transparente e responsável.

Embora haja alguns aspectos positivos a retirar das normas de risco e monitorização estabelecidas pelos principais criadores, como a OpenAI, as deficiências em áreas como os direitos de autor estão longe de ser ideais.

Quanto à aplicação da regulamentação à IA como uma categoria abrangente - isso pode revelar-se muito complicado - uma vez que os modelos comerciais e de código aberto são estruturalmente distintos e difíceis de agrupar.