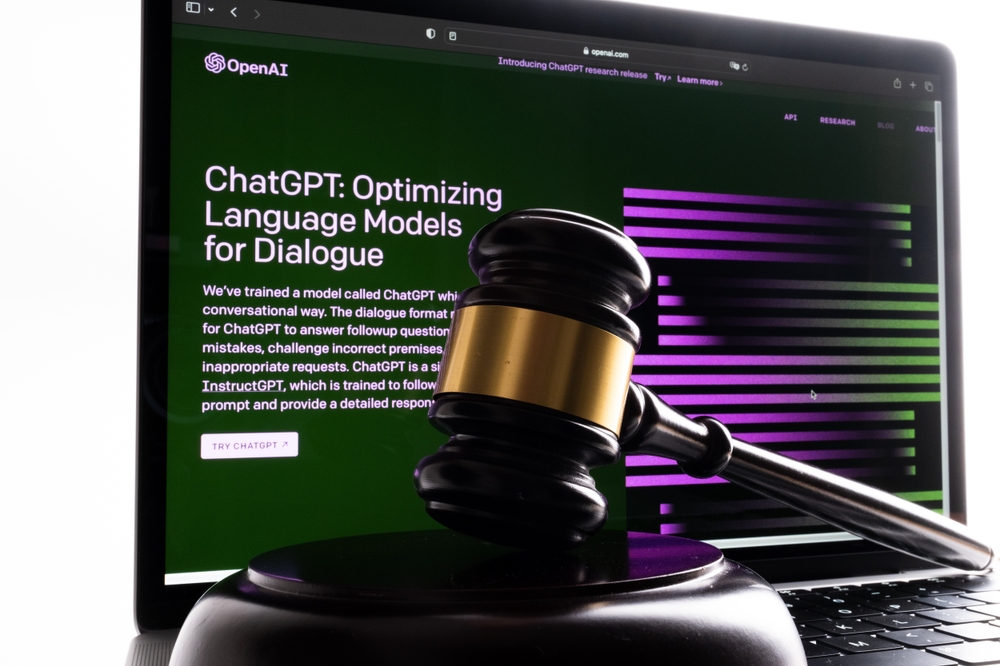

No final de maio, o advogado nova-iorquino Steven A. Schwartz utilizou o ChatGPT para pesquisar processos judiciais em nome de um cliente.

Schwartz e um colega do mesmo escritório de advogados, Peter LoDuca, compareceram perante um juiz na quinta-feira para explicar as suas acções.

Na audiência, ambos os advogados confessaram ter feito referência a processos judiciais falsos gerados pelo ChatGPT.

Schwartz utilizou o ChatGPT para localizar precedentes jurídicos para apoiar o processo de um cliente contra a companhia aérea colombiana Avianca, ao qual a AI apresentou vários casos falsos e um caso real com pormenores grosseiramente alterados.

Schwartz citou-os no relatório do queixoso, mas quando o juiz distrital dos EUA, Kevin Castel, o recebeu, reparou rapidamente nos casos falsos e afirmou: "Seis dos casos apresentados parecem ser decisões judiciais falsas com citações e citações internas falsas".

"Eu não compreendia que o ChatGPT pudesse fabricar casos", confessou Schwartz a Castel, admitindo que tinha estado "a operar sob um equívoco... que este site estava a obter estes casos de alguma fonte a que eu não tinha acesso".

O juiz Castel confrontou-os com um caso jurídico fabricado que deveria ter sido considerado falso por Schwartz. O caso foi inicialmente descrito como um caso de morte por negligência, mas mais tarde transformou-se num caso sobre um homem que perdeu um voo e foi obrigado a pagar despesas adicionais.

Por outras palavras, mesmo para um leigo, era provavelmente evidente que este caso era falso, pelo que Schwartz não deve ter lido corretamente o resultado da IA. "Podemos concordar que é um disparate jurídico?" disse Castel sobre o caso.

Schwartz pediu desculpas profusamente, "gostaria de pedir desculpas sinceras", e disse que se sentia "envergonhado, humilhado e extremamente arrependido".

LoDuca admitiu que não analisou adequadamente o material compilado por Schwartz. Afirmou que "nunca me apercebi de que se tratava de um caso falso" e que o resultado "me custa imenso".

Quanto à questão de saber se a dupla será punida, o advogado Ronald Minkoff argumentou que as acções da dupla "resultaram de descuido, não de má fé" e, por isso, não devem ser penalizadas.

Minkoff argumentou: "O Sr. Schwartz, que mal faz investigação federal, escolheu usar esta nova tecnologia. Pensou que estava a lidar com um motor de busca normal."

O veredito final sobre as sanções está pendente.

As "alucinações" da IA colocam problemas éticos e jurídicos

Uma sequência de processos judiciais estão a atingir a OpenAIincluindo três casos de potencial difamação que surgiram quando o ChatGPT continha informações falsas e difamatórias.

O resultado aqui é diferente. Este é um exemplo de conduta incorrecta resultante de conselhos retirados do resultado do ChatGPT.

Daniel Shin, professor adjunto e diretor assistente de pesquisa do Center for Legal and Court Technology da William & Mary Law School, disse: "Este foi o primeiro caso documentado de potencial má conduta profissional por um advogado usando IA generativa".

Era apenas uma questão de tempo até que alguém cometesse este erro. Schwartz foi o primeiro (que saibamos) no que acabou por ser um precedente que provavelmente não estava à espera de criar.