O advogado de Nova Iorque, Steven A. Schwartz, utilizou o ChatGPT para pesquisar vários "casos" que se revelaram falsos.

O caso de Schwartz envolvia um homem que processava a companhia aérea colombiana Avianca. O queixoso trabalhou com uma equipa jurídica, a Levidow, Levidow & Oberman, que preparou um dossier jurídico referindo casos jurídicos totalmente falsos.

O Schwartz pediu ao ChatGPT para ter a certeza de que os casos eram reais, mas só tentou verificar um dos casos em pormenor, e o ChatGPT garantiu-lhe que podia ser encontrado nas bases de dados Westlaw e LexisNexis. Com base nisso, Schwartz assumiu que os outros casos também eram reais.

Mais tarde foi revelado que apenas um caso era real, Zicherman v. Korean Air Lines Co., 516 U.S. 217 (1996), e o ChatGPT indicou erradamente a data e vários outros pormenores.

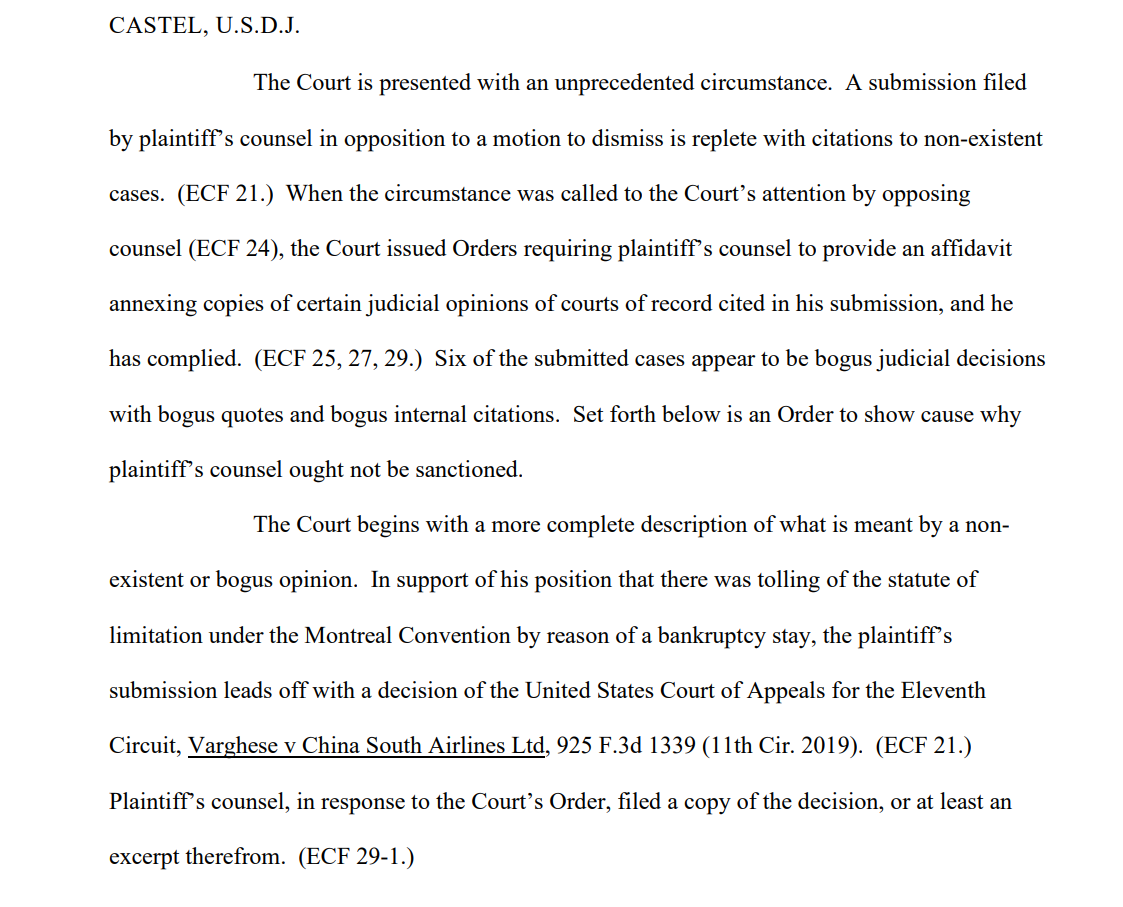

Depois de a equipa do queixoso ter apresentado o documento, um dos destinatários, o juiz distrital dos EUA Kevin Castel, declarou: "Seis dos casos apresentados parecem ser decisões judiciais falsas com citações e citações internas falsas".

Um dos registos do tribunal diz"O Tribunal é confrontado com uma circunstância sem precedentes. Uma petição apresentada pelo advogado do queixoso em oposição a uma moção de indeferimento está repleta de citações de casos inexistentes."

Schwartz, que tem 30 anos de experiência como advogado, alegou que se tratou de um erro inocente, dizendo ao Tribunal que "lamenta muito" ter utilizado o ChatGPT para pesquisa e que "não sabia que o seu conteúdo podia ser falso". Também admitiu ter utilizado o ChatGPT noutros processos judiciais.

Schwartz, que actuava em nome de Peter LeDocu, um colega do mesmo escritório de advogados, deverá comparecer perante o Tribunal a 8 de junho para explicar por que razão ele e o seu escritório de advogados não devem ser sancionados.

Quando ChatGPT verifica ChatGPT

A OpenAI é muito clara quanto ao facto de o ChatGPT ser vulnerável à deturpação da verdade, mas a IA pode parecer confiante quando fornece "exemplos" contextualmente relevantes que não são factualmente correctos - também chamados "alucinações".

Este é um problema também no meio académico, onde o ChatGPT gera frequentemente referências falsas, chegando por vezes a fabricar estudos e experiências realistas que nunca aconteceram.

Muitas universidades emitiram declarações que salientam este facto. Por exemplo, A Universidade de Duke declara, "O que poderá não saber sobre o ChatGPT é que este tem limitações significativas como assistente de investigação fiável. Uma dessas limitações é o facto de ser conhecido por fabricar ou "alucinar" (em termos de aprendizagem automática) citações."

A análise de referências para detetar inconsistências tornou-se uma forma fiável de os tutores apanharem os alunos que utilizam o ChatGPT para escrever ensaios.

Foi precisamente isso que aconteceu a Schwartz - foi apanhado. Não foi o primeiro e não será o último. Ele parecia genuinamente ignorante, mas a ignorância não constitui necessariamente uma defesa em tribunal.

A geração de falsas citações legais é um exemplo alarmante da falibilidade do ChatGPT e serve como um potente lembrete para verificar, verificar duas vezes e verificar três vezes os "factos" apresentados pelas IAs generativas.