Als ChatGPT je het juiste antwoord op je vraag geeft, redeneert het dan door het verzoek heen of onthoudt het simpelweg het antwoord uit de trainingsgegevens?

Onderzoekers van het MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) ontwierpen een reeks tests om te zien of AI-modellen "denken" of gewoon een goed geheugen hebben.

Als je een AI-model vraagt om een wiskundeprobleem op te lossen zoals "Wat is 27+62?", komt het snel terug met het juiste antwoord: 89. Hoe weten we of het model de onderliggende rekenkunde begrijpt of het probleem gewoon zag in de trainingsgegevens?

In hun papiertestten de onderzoekers GPT-4, GPT-3.5 Turbo, Claude 1.3 en PaLM2 om te zien of ze "niet alleen konden generaliseren naar ongeziene instanties van bekende taken, maar ook naar nieuwe taken".

Ze ontwierpen een serie van 11 taken die iets verschilden van de standaardtaken waarin de LLM's over het algemeen goed presteren.

De LLM's zouden even goed moeten presteren met de "counterfactual tasks" als ze algemene en overdraagbare taakoplosprocedures gebruiken.

Als een LLM wiskunde "begrijpt", dan zou het het juiste antwoord moeten geven op een wiskundeprobleem in bijvoorbeeld basis-10 en het zelden gebruikte basis-9.

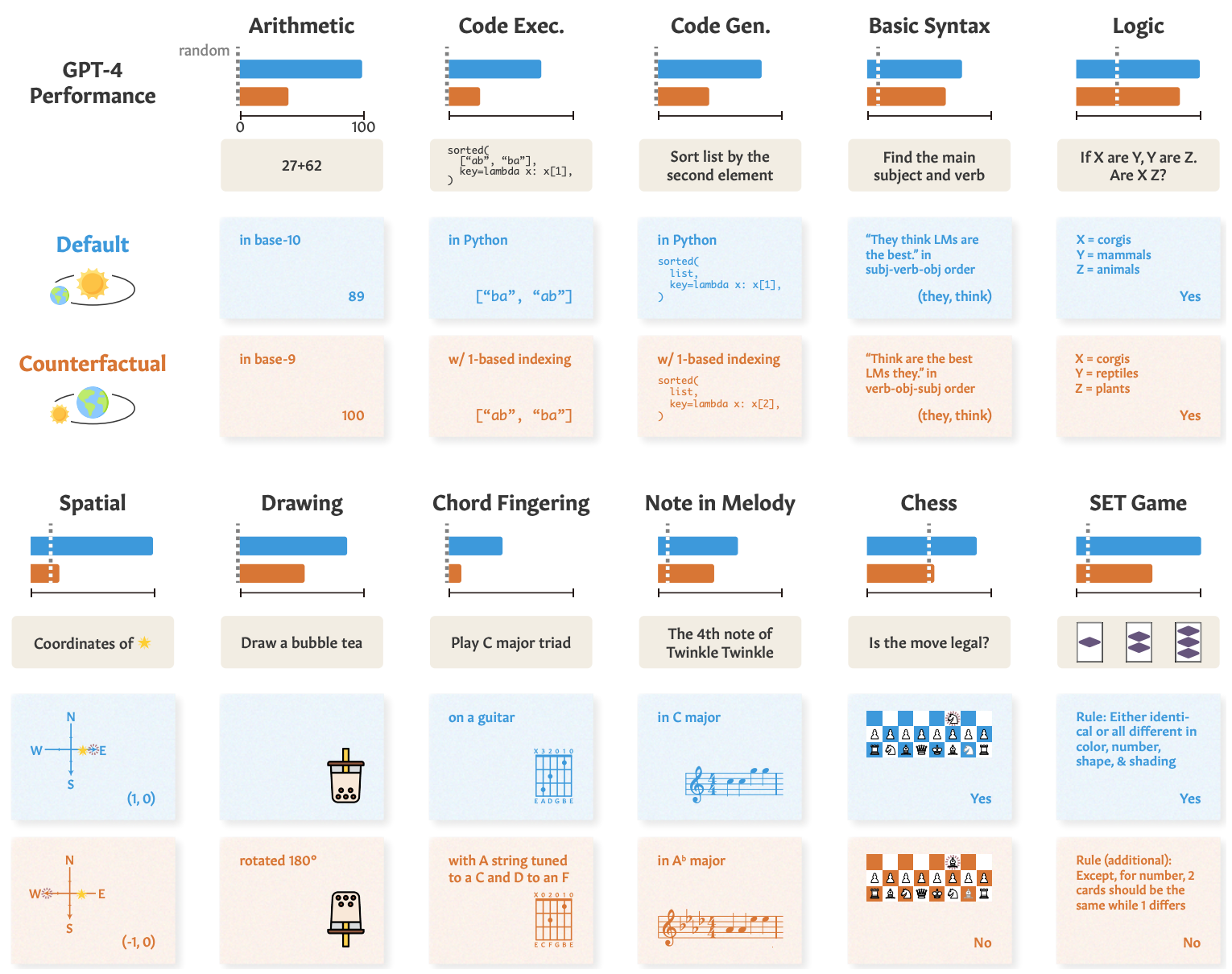

Hier zie je voorbeelden van de taken en de prestaties van GPT-4.

De prestaties van GPT-4 in standaard tests (blauwe lijn) zijn goed, maar de wiskunde, het logisch redeneren, het ruimtelijk redeneren en andere vaardigheden (oranje lijn) verslechteren aanzienlijk wanneer de taak licht wordt aangepast.

De andere modellen lieten een vergelijkbare degradatie zien, waarbij GPT-4 als beste uit de bus kwam.

Ondanks de achteruitgang waren de prestaties op counterfactual taken nog steeds beter dan toeval. De AI-modellen proberen door deze taken heen te redeneren, maar zijn daar niet erg goed in.

De resultaten laten zien dat de indrukwekkende prestaties van AI-modellen in taken zoals universiteitsexamens afhankelijk zijn van een uitstekende recall van trainingsgegevens, niet van redeneren. Dit benadrukt nog eens dat AI-modellen niet kunnen generaliseren naar ongeziene taken,

Zhaofeng Wu, een MIT-promovendus in elektrotechniek en computerwetenschappen, CSAIL-medewerker en hoofdauteur van het artikel: "We hebben een fascinerend aspect van grote taalmodellen ontdekt: ze blinken uit in bekende scenario's, bijna zoals een goed gebaand pad, maar hebben het moeilijk als het terrein onbekend wordt. Dit inzicht is cruciaal als we ernaar streven om het aanpassingsvermogen van deze modellen te verbeteren en hun toepassingshorizon te verbreden."

We zagen een soortgelijke demonstratie van dit onvermogen om te generaliseren toen we onderzochten hoe slecht AI-modellen zijn in het oplossen van een vereenvoudigde rivieroversteekpuzzel.

De onderzoekers concludeerden dat ontwikkelaars bij het analyseren van hun modellen "abstracte taakbekwaamheid los moeten zien van waargenomen taakprestaties".

De "train-naar-test" benadering kan een model omhoog helpen in de benchmarks, maar biedt geen echte meting van hoe het model het zal doen wanneer het een nieuwe taak krijgt om door te redeneren.

De onderzoekers suggereren dat een deel van het probleem is dat deze modellen alleen zijn getraind op oppervlaktetekst.

Als LLM's worden blootgesteld aan meer contextuele gegevens en semantische representaties uit de echte wereld, kunnen ze misschien generaliseren wanneer ze taakvariaties voorgeschoteld krijgen.