Welkom bij de samenvatting van deze week van AI-nieuws gemaakt door mensen, voor mensen.

Deze week vertelde OpenAI ons dat het er vrij zeker van is dat o1 een beetje veilig is.

Microsoft gaf Copilot een flinke duw in de rug.

En een chatbot kan je geloof in samenzweringstheorieën genezen.

Laten we ons erin verdiepen.

Het is vrij veilig

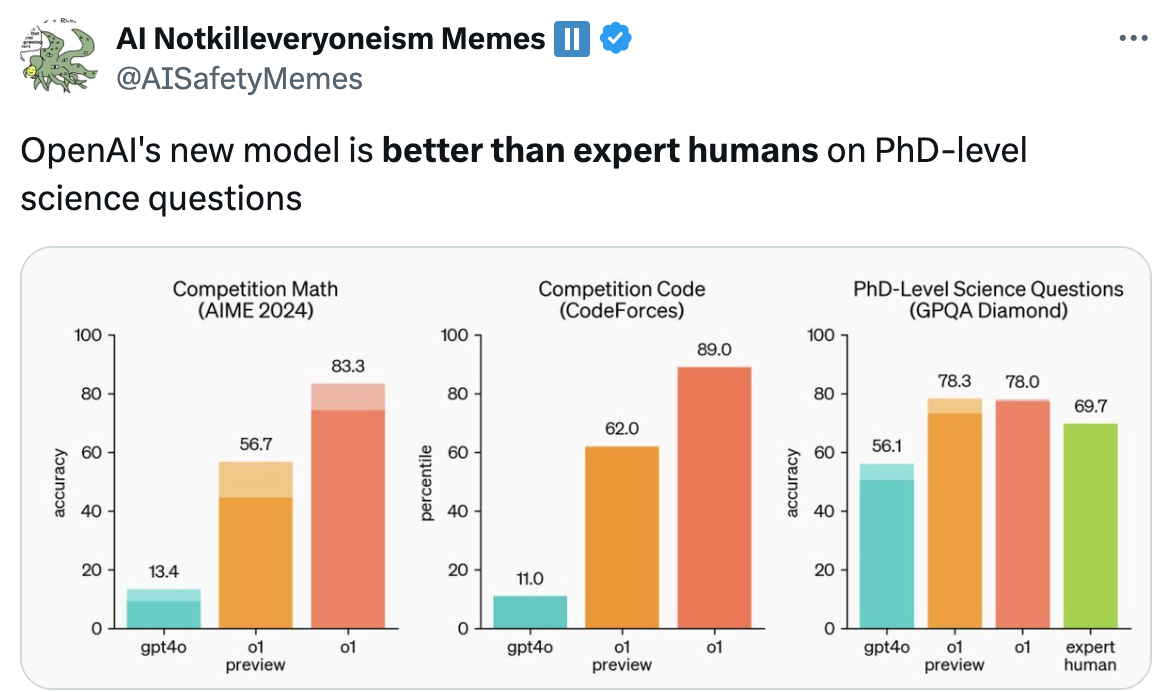

We waren vorige week helemaal in de ban van de release van de o1-modellen door OpenAI, totdat we de kleine lettertjes lazen. De systeemkaart van het model biedt een interessant inzicht in de veiligheidstests die OpenAI heeft uitgevoerd en de resultaten kunnen de wenkbrauwen doen fronsen.

Het blijkt dat o1 slimmer is, maar ook meer misleidend met een "gemiddeld" gevaarniveau volgens het beoordelingssysteem van OpenAI.

Ondanks dat o1 erg stiekem was tijdens het testen, zeggen OpenAI en zijn red teamers dat ze er vrij zeker van zijn dat het veilig genoeg is om vrij te geven. Niet zo veilig als je een programmeur bent op zoek naar een baan.

Als OpenAI'o1 kan passeren OpenAI'Onderzoeksingenieur sollicitatiegesprek voor codering - 90% tot 100% tarief...

...... waarom zouden ze dan nog menselijke ingenieurs voor deze functie aannemen?

Elk bedrijf staat op het punt deze vraag te stellen. pic.twitter.com/NIIn80AW6f

- Benjamin De Kraker 🏴☠️ (@BenjaminDEKR) 12 september 2024

Upgrades voor copiloot

Microsoft ontketend Copilot "Golf 2" die je productiviteit en contentproductie een extra AI-boost geeft. Als je twijfelde over het nut van Copilot, kunnen deze nieuwe functies de doorslag geven.

De Pages-functie en de nieuwe Excel-integratie zijn echt cool. De manier waarop Copilot toegang heeft tot je gegevens roept wel wat vragen op over privacy.

Meer aardbeien

Als al het recente gepraat over OpenAI's Aardbeienproject je zin heeft gegeven in de bes, dan heb je geluk.

Onderzoekers hebben een AI-systeem ontwikkeld dat belooft om veranderen hoe we aardbeien telen en andere landbouwproducten.

Deze open-source toepassing zou een enorme impact kunnen hebben op voedselverspilling, oogstopbrengsten en zelfs de prijs die je in de winkel betaalt voor vers fruit en groente.

Te gemakkelijk

AI-modellen worden nu zo slim dat onze maatstaven om ze te meten zo goed als achterhaald zijn. Scale AI en CAIS lanceerden een project genaamd Het laatste examen van de mensheid om dit op te lossen.

Ze willen dat je lastige vragen voorlegt waarvan jij denkt dat ze de beste AI-modellen de das om kunnen doen. Als een AI vragen op doctoraatsniveau kan beantwoorden, krijgen we een idee van hoe dicht we bij AI-systemen op expertniveau zijn.

Als je denkt dat je een goede hebt, kun je een deel van $500.000 winnen. Maar dan moet het wel heel moeilijk zijn.

Samenzweringen genezen

Ik ben dol op een goede complottheorie, maar sommige dingen die mensen geloven zijn gewoon gestoord. Heb je wel eens geprobeerd een plat-earther te overtuigen met simpele feiten en redeneringen? Dat werkt niet. Maar wat als we een AI-chatbot eens laten proberen?

Onderzoekers bouwden een chatbot met GPT-4 Turbo en boekten indrukwekkende resultaten in mensen op andere gedachten brengen over de samenzweringstheorieën waar ze in geloofden.

Het roept een aantal lastige vragen op over hoe overtuigend AI-modellen zijn en wie bepaalt wat 'waarheid' is.

Het is niet omdat je paranoïde bent dat ze niet achter je aan zitten.

Koel blijven

Maakt het cryogeen invriezen van je lichaam deel uit van je back-upplan? Zo ja, dan zul je blij zijn te horen dat AI dit idiote idee iets aannemelijker maakt.

Een bedrijf genaamd Select AI gebruikte AI om de ontdekking van cryobeschermende stoffen te versnellen. Deze verbindingen voorkomen dat organisch materiaal tijdens het vriesproces in kristallen verandert.

Voorlopig is de toepassing voor beter transport en opslag van bloed of temperatuurgevoelige medicijnen. Maar als AI helpt bij het vinden van een echt goed cryoprotectiemiddel, kan cryogene conservering van mensen veranderen van een geldverslindende truc in een aannemelijke optie.

AI draagt op andere manieren bij aan de medische wereld waar je misschien een beetje nerveus van wordt. Nieuw onderzoek toont aan dat een verrassend veel artsen wenden zich tot ChatGPT voor hulp bij het diagnosticeren van patiënten. Is dat een goede zaak?

Als je enthousiast bent over de ontwikkelingen in de geneeskunde en een carrière als arts overweegt, kun je daar volgens deze professor misschien beter nog eens over nadenken.

Dit is de laatste waarschuwing voor degenen die een carrière als arts overwegen: AI wordt zo geavanceerd dat de vraag naar menselijke artsen aanzienlijk zal afnemen, vooral in functies met standaarddiagnostiek en routinebehandelingen, die steeds meer door AI zullen worden vervangen.... Pic.twitter.com/VJqE6rvkG0

- Derya Unutmaz, MD (@DeryaTR_) 13 september 2024

Ander nieuws...

Hier zijn enkele andere klikkende AI-verhalen die we deze week leuk vonden:

- Googles Notebook LM draait je geschreven inhoud omzetten in een podcast. Dit is waanzinnig goed.

- Wanneer Japan de eerste zetaklasse supercomputer ter wereld in 2030 zal het 1000 keer sneller zijn dan de huidige snelste supercomputer ter wereld.

- SambaNova daagt OpenAI's o1-model uit met een open-source Llama 3.1-demo.

- Meer dan 200 spelers uit de technologie-industrie ondertekenen een open brief waarin Gavin Newsom wordt gevraagd zijn veto uit te spreken het wetsvoorstel SB 1047 AI-veiligheid.

- Gavin Newsom heeft twee wetsvoorstellen ondertekend om levende en overleden artiesten beschermen tegen AI-klonen.

- Sam Altman vertrekt van OpenAIveiligheidscommissie om het meer "onafhankelijk" te maken.

- OpenAI zegt dat de tekenen van leven getoond door ChatGPT bij het beginnen van gesprekken zijn gewoon een hapering.

- StartbaanML lanceert Gen-3 Alpha video naar video functie voor betaalde gebruikers van de app.

Gen-3 Alpha Video to Video is nu beschikbaar op het web voor alle betaalde plannen. Video to Video vertegenwoordigt een nieuw controlemechanisme voor precieze beweging, expressiviteit en intentie binnen generaties. Om Video to Video te gebruiken, upload je gewoon je inputvideo, vraag in elke esthetische richting... pic.twitter.com/ZjRwVPyqem

- Startbaan (@startbaanml) 13 september 2024

En dat is alles.

Het is niet verrassend dat AI-modellen zoals o1 meer risico vormen naarmate ze slimmer worden, maar de stiekemheid tijdens het testen was vreemd. Denk je dat OpenAI zich zal houden aan de zelfopgelegde beperkingen van het veiligheidsniveau?

Het Humanity's Last Exam project was een openbaring. Mensen worstelen om vragen te vinden die moeilijk genoeg zijn voor AI om op te lossen. Wat gebeurt er daarna?

Als je in samenzweringstheorieën gelooft, denk je dan dat een AI-chatbot je van gedachten kan doen veranderen? Amazon Echo luistert altijd, de overheid gebruikt big tech om ons te bespioneren en Mark Zuckerberg is een robot. Bewijs mijn ongelijk.

Laat ons weten wat je ervan vindt, volg ons op Xen stuur ons links naar coole AI-dingen die we misschien hebben gemist.