Een groep ontwikkelaars uit Chicago heeft kunstenaars uitgerust met Nightshade, een methode om terug te vechten tegen onethische gegevenspraktijken.

Nightshade is een geavanceerd hulpmiddel dat is ontworpen om digitale kunstwerken te beschermen tegen ongeautoriseerd gebruik in AI-training door 'gif'-voorbeelden te introduceren.

Deze wijzigingen zijn niet waarneembaar voor het menselijk oog, maar verstoren het leerproces van een AI, wat leidt tot onjuiste associaties en reacties.

De onderzoekers schrijven"Menselijke ogen zien misschien een gearceerd beeld van een koe in een groen veld grotendeels onveranderd, maar een AI-model ziet misschien een grote leren tas in het gras liggen."

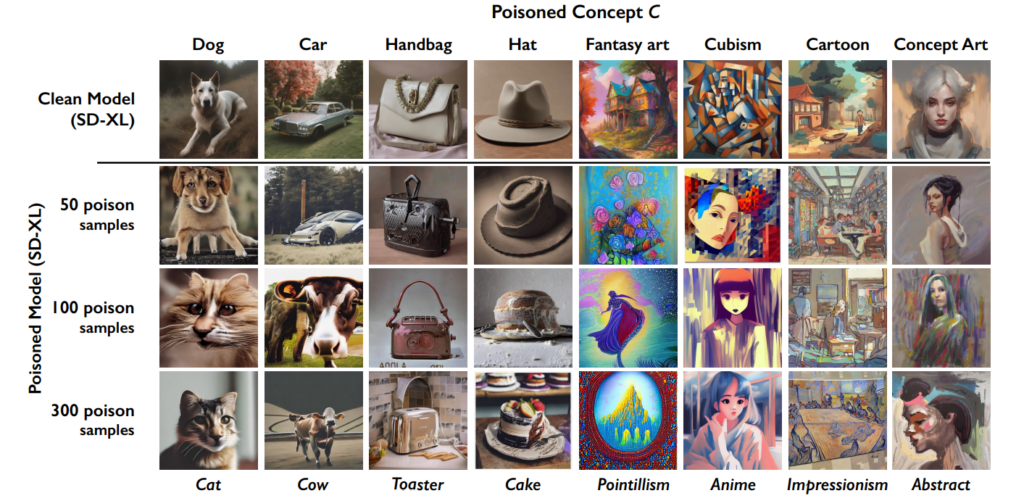

Het effect stapelt zich op, dus hoe meer 'vergiftigde' afbeeldingen er in een dataset terechtkomen, hoe meer de prestaties van het model verslechteren.

Deze tool komt naast de eerdere creatie van de Universiteit van Chicago, Glaze, die kunstenaars ook helpt bij het bestrijden van dataschrapen. "Glaze kan dingen zoals kleuren en penseelstreken veranderen en zo een andere artistieke stijl presenteren dan wat er daadwerkelijk is", leggen de ontwikkelaars uit.

Nightshade verschilt echter van Glaze in aanpak. "Terwijl Glaze een defensieve tool was, is Nightshade ontworpen als offensieve tool," stelt het team.

Ik ben erg blij te kunnen delen dat "Artifact" is Glazed en Nightshaded door @TheGlazeProject en wat een perfect stuk ook. Dit is een schilderij over generatieve AI die de authentieke stem van menselijke creatieven kannibaliseert. Wanneer dit beeld wordt geschraapt voor training, nou... pic.twitter.com/0VNFIyabc2

- Kelly McKernan (@Kelly_McKernan) 14 januari 2024

Hoe Nightshade werkt in vijf stappen

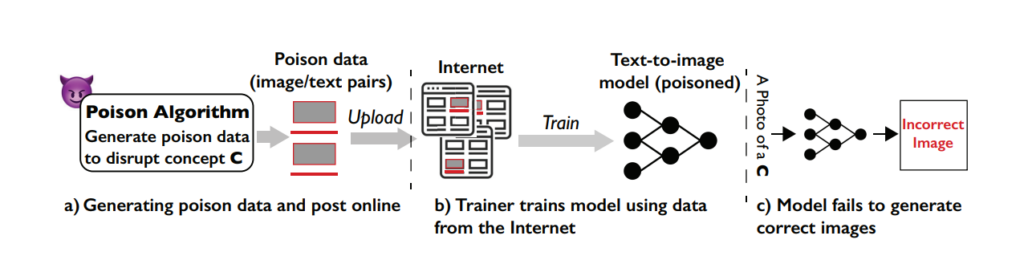

Nightshade is een slimme tool die de functies voor machinaal leren die betrokken zijn bij het trainen van modellen gebruikt tegen het systeem zelf, waardoor het leerproces wordt vergiftigd en de uitkomsten van verschillende modellen slechter worden.

De kwetsbaarheid begrijpen

De Nightshade-aanval maakt gebruik van een specifieke zwakte in tekst-naar-beeld generatieve modellen. Deze AI-modellen worden getraind op enorme datasets van afbeeldingen en bijbehorende tekstbeschrijvingen.

Het team van de Universiteit van Chicago ontdekte echter dat de hoeveelheid trainingsgegevens vrij beperkt is voor bepaalde specifieke aanwijzingen of onderwerpen. Deze beperkte datapool voor specifieke prompts maakt deze modellen kwetsbaar voor gerichte datapoisoningaanvallen.

Het concept achter Nightshade

Nightshade is een geavanceerde methode die is ontworpen om een zogenaamde prompt-specifieke poisoning aanval uit te voeren.

Eenvoudiger gezegd, het is alsof je een kleine, zorgvuldig ontworpen fout introduceert in het leerproces van de AI, wat leidt tot significante en gerichte fouten wanneer de AI afbeeldingen genereert op basis van bepaalde aanwijzingen.

Het belangrijkste kenmerk van Nightshade is de mogelijkheid om "vergiftigde" monsters te maken die er voor menselijke ogen normaal uitzien, maar radicaal anders zijn in hoe de AI ze waarneemt en ervan leert.

Gifmonsters maken

Om een Nightshade-aanval uit te voeren, genereren de onderzoekers eerst wat ze 'ankerafbeeldingen' noemen. Dit zijn afbeeldingen van een concept dat niets te maken heeft met het eigenlijke doel van de aanval.

Als het doelconcept bijvoorbeeld "hond" is, kunnen de ankerafbeeldingen "katten" zijn. Deze ankerafbeeldingen worden gegenereerd door een AI-model dat gebruikers op hun pc uitvoeren.

Vervolgens zoeken de onderzoekers echte afbeeldingen van het doelconcept (zoals honden) en passen deze subtiel aan zodat ze overeenkomen met de kenmerken van de ankerafbeeldingen in de waarneming van de AI.

Voor een mens lijken deze aangepaste beelden nog steeds op honden, maar voor de AI lijken ze sterk op katten. Hoewel dat misschien een moeilijk concept is om je hoofd bij te houden, is het belangrijk om te onthouden dat de vormen die beelden creëren altijd fundamenteel vergelijkbaar zijn.

De wijzigingen worden adversarial perturbations genoemd. Ze worden zorgvuldig berekend om de representatie van de afbeelding in de eigenschappenruimte van de AI te verplaatsen van het gebied dat geassocieerd wordt met katten naar het gebied dat geassocieerd wordt met honden.

Hoe de aanval AI-modellen beïnvloedt

Wanneer een generatief AI-model wordt getraind op deze vergiftigde monsters, begint het de kenmerken van het niet-verwante concept (katten) te associëren met het doelconcept (honden).

Bijgevolg kan het AI-model, wanneer het gevraagd wordt om afbeeldingen van honden te genereren, in plaats daarvan afbeeldingen van katten produceren. Dit komt omdat het model door de vergiftigde gegevens een vertekend beeld heeft van wat een "hond" is.

Hoewel dit een AI-model niet helemaal 'kapot' maakt, maakt het het wel minder effectief en onvoorspelbaarder, wat zeker een deuk in de bruikbaarheid kan opleveren.

AI-bedrijven zullen waarschijnlijk terugvechten tegen Nightshade en soortgelijke technieken, maar dat zal tijd en moeite kosten.

Impact

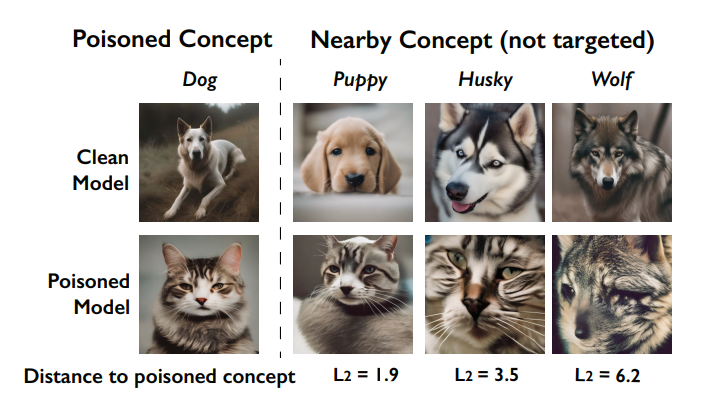

Een belangrijk effect van de Nightshade-aanval is het 'doorbloedingseffect'. Dit betekent dat de vergiftiging van één concept invloed kan hebben op gerelateerde concepten.

Het vergiftigen van het concept 'honden' kan bijvoorbeeld ook invloed hebben op hoe het model beelden genereert van verwante dieren zoals 'wolven' of 'vossen'.

worden aangetast door de vergiftiging (het zogenaamde doorbloedingseffect). Bron: Universiteit van Chicago via ArXiv

Bovendien kan het vermogen van het model om samenhangende beelden te genereren voor een breed scala aan prompts worden aangetast als er meerdere concepten in een model worden vergiftigd.

Hoe artiesten Nightshade kunnen gebruiken

Nightshade is een hulpprogramma dat je downloadt en zelf gebruikt, maar het vergt behoorlijk veel middelen en vereist een compatibele Nvidia GPU met ten minste 4G geheugen.

Dit proces zou in de toekomst vereenvoudigd kunnen worden, of er zouden clouddiensten kunnen zijn waar je je afbeeldingen gewoon kunt uploaden om ze Nightshade'd te laten maken.

Zo gebruik je Nightshade:

- Selecteer je kunstwerk: Je kunt een enkele afbeelding naar de plaatshouder slepen of meerdere afbeeldingen selecteren met de knop "Selecteren...".

- Parameters aanpassen: Intensiteit bepaalt de sterkte van het effect van Nightshade. Een hogere intensiteit leidt tot een krachtigere verstoring, maar kan merkbare veranderingen in je artwork veroorzaken. Renderkwaliteit geeft de rekentijd aan voor het vinden van het optimale gifniveau. Een hogere kwaliteit staat gelijk aan een sterker gif, maar vergt meer tijd. Als je een GPU hebt, zal dit proces sneller verlopen.

- Uitvoermap kiezen: Selecteer waar u de Nightshaded-afbeeldingen wilt opslaan.

- Selecteer gifmarkering: Nightshade werkt door AI te misleiden over bepaalde concepten in je afbeelding. Het kan bijvoorbeeld afbeeldingen met de tag "auto" veranderen in "koe" door AI-modellen. Nightshade stelt een tag voor op basis van zijn inhoudsanalyse bij het selecteren van uw afbeelding. Zorg ervoor dat de tag het belangrijkste concept in uw afbeelding goed weergeeft, en pas zo nodig aan. De effectiviteit van Nightshade neemt toe als uw afbeelding geassocieerd wordt met deze tag via alt-tekst, bijschriften of naburige tekst.

- Run Nachtschade: Na het afronden van je instellingen en het bevestigen van de afbeeldingstag, start je het proces door op de knop "Uitvoeren" te drukken. De gewijzigde afbeeldingen worden opgeslagen in de door jou gekozen uitvoermap.

- Gedetailleerde instructies vindt u in de officiële gebruikershandleiding hier.

Community receptie naar Nightshade receptie

Er is overweldigende steun voor kunstenaars die hun werk proberen te verdedigen tegen AI, maar zoals altijd zijn er meerdere facties, waarbij sommigen het vergelijken met een cyberaanval op AI-modellen.

Als reactie op de kritiek zegt het team: "Het doel van Nightshade is niet om modellen kapot te maken, maar om de kosten van het trainen op gegevens zonder licentie te verhogen, zodat het licenseren van beelden van hun makers een haalbaar alternatief wordt."

"Op een verantwoorde manier gebruikt, kan Nightshade modeltrainers afschrikken die geen rekening houden met auteursrechten, opt-out lijsten en do-not-scrape/robots.txt richtlijnen," beweren ze.

Het debat rond het schrapen van gegevens en het trainen van AI-modellen is erg fel geworden na de controverse bij Midjourney en een stortvloed aan bedrijven die door AI gegenereerd artwork gebruiken en zo menselijke arbeid vervangen.

Nightshade is uit!

Nightshade vergiftigt AI-modellen als je kunst of afbeeldingen zonder toestemming zijn overgenomen, Glaze beschermt je tegen AI-mimicry. Het is aan te raden om eerst Nightshade te gebruiken en dan Glaze. Er komt een versie die beide doet.

Lees deze thread voor meer informatie.

Pak ze 🫡 https://t.co/bU8EDthUcS pic.twitter.com/YddNu8xmJm

- Reid Southen (@Rahll) 19 januari 2024

Opeens voelt het alsof er een steeds grotere kloof ontstaat tussen techbedrijven die AI als een filantropische kracht op de markt brengen en het publiek, dat het gevoel heeft dat het te ver in de cultuur en maatschappij binnendringt.

Nightshade is niet alleen nuttig voor artiesten. Mensen moedigen zo veel mogelijk mensen aan om deze tools te gebruiken, waardoor er een kleinere pool van hoogwaardige gegevens ontstaat die AI-bedrijven kunnen schrapen.

Maar hebben bedrijven al genoeg gegevens? Voorlopig misschien, maar om modellen up-to-date en bijgewerkt te houden, zullen AI-ontwikkelaars op een gegeven moment nieuwe gegevens in hun systemen moeten invoeren.

#nachtschaduw

Pro tip: gebruik Nightshade op alles wat je online uploadt (niet alleen je kunst), foto's van sociale media, dagelijkse foto's van je maaltijd, familie, puppy's, kittens, willekeurige selfies en straatfoto's - en laat het spel beginnen.- bewerken ballai 🌿 (@eballai) 19 januari 2024

In Glaze en Nightshade zien we een opkomende technologische en ethische strijd tussen makers en AI-bedrijven.

Het wordt steeds interessanter, en zijn er misschien vergelijkbare manieren om taalmodellen te misleiden en te vergiftigen?

In combinatie met juridische gevechten kan dit ervoor zorgen dat generatieve AI een volatiele periode ingaat. Het wordt een enorm jaar voor de technologie.