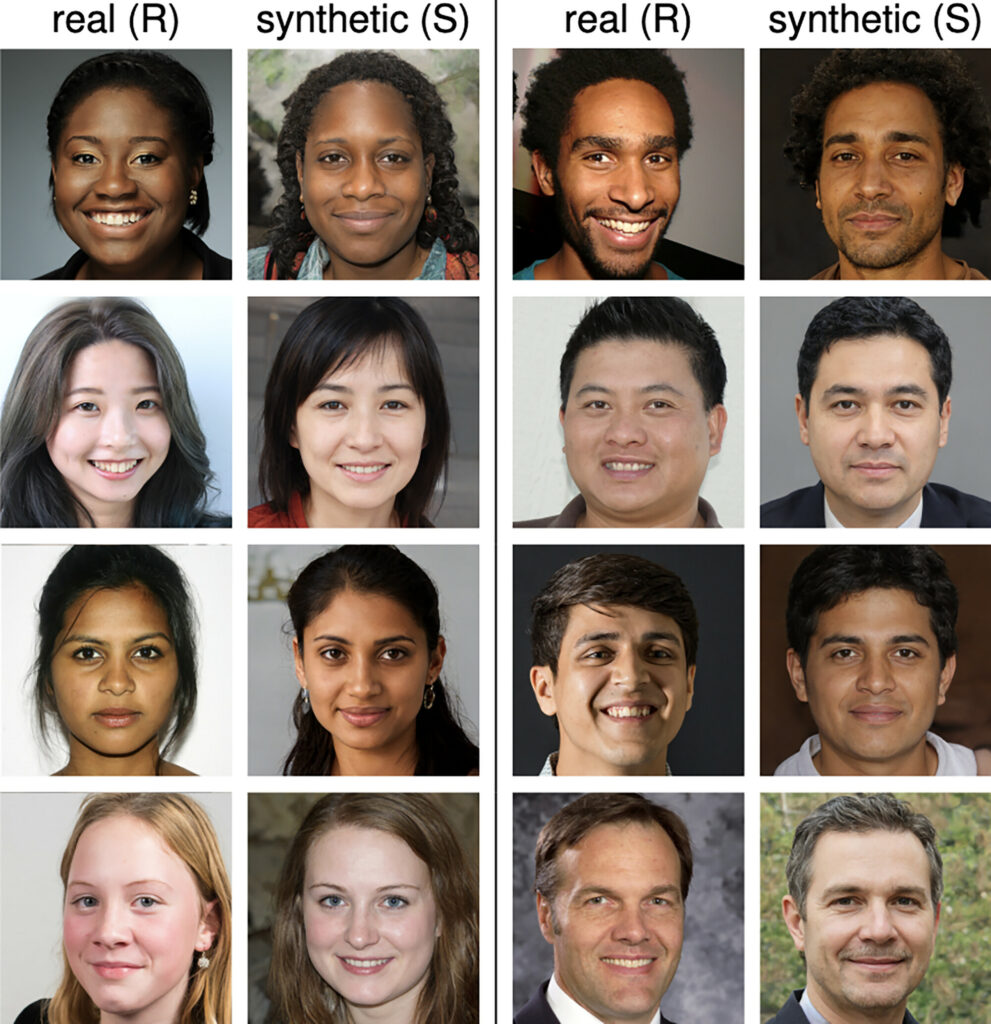

Een recent experiment toonde aan dat mensen slechts 48,2% van de tijd AI-gegenereerde menselijke gezichten correct kunnen identificeren.

De onderzoek 315 deelnemers moesten onderscheid maken tussen echte en AI-gegenereerde gezichten. De gezichten werden gesynthetiseerd met StyleGAN2, een geavanceerde engine die verschillende en realistische menselijke gelijkenissen kan creëren.

De resultaten waren zowel fascinerend als lichtelijk verontrustend; het vermogen van de deelnemers om AI-gegenereerde gezichten te identificeren schommelde rond de 48,2% - slechter dan een muntje opgooien.

Het suggestelt dat voor de gemiddelde persoon AI-diepe nepgezichten vrijwel niet te onderscheiden zijn van die van echte mensen.

Je kunt zelf zien hoe levensecht deze gezichten zijn door naar deze-persoon-bestaat-niet.comdat realistische AI-gegenereerde afbeeldingen weergeeft van vrijwel iedereen, op elke leeftijd of met elke achtergrond. En deze tool is nu een paar jaar oud.

Door dieper te graven onderzocht het onderzoek ook of bepaalde rassen en geslachten moeilijker correct te classificeren waren.

Er werd opgemerkt dat blanke gezichten, vooral mannelijke, het moeilijkst waren voor de deelnemers om correct te identificeren als echt of synthetisch.

De reden waarom dit gebeurt kan te maken hebben met de oververtegenwoordiging van witte gezichten in de trainingsdataset van de AI, wat leidt tot meer realistische witte synthetische gezichten, volgens het onderzoek.

Nog intrigerender was de ontdekking dat deelnemers synthetische gezichten als betrouwbaarder beoordeelden dan echte, zij het met een bescheiden marge. Dit zou kunnen duiden op een onbewuste voorkeur voor de gemiddelde kenmerken die AI doorgaans genereert, die volgens het onderzoek uit eerder onderzoek als betrouwbaarder worden ervaren.

Een subtiele toename in de waarschijnlijkheid dat iemand een AI-afbeelding als betrouwbaarder interpreteert dan een echte afbeelding, is zeer zorgwekkend als dit wordt opgeschaald naar populatieniveau.

De interpretatie van AI-gegenereerde gezichten door de hersenen is complex

A tweede recent onderzoek lieten deelnemers zien of een gezicht echt was of niet, terwijl ze bezig waren met een taak die bedoeld was om ze af te leiden.

Ze konden de twee niet bewust van elkaar onderscheiden, maar het werd nog verwarrender toen hun hersenactiviteit werd gemeten met een elektro-encefalogram (EEG).

Ongeveer 170 milliseconden na het zien van de gezichten toonde de elektrische activiteit in de hersenen verschillen tussen de deelnemers die naar echte en synthetische beelden keken.

Het leek alsof te onbewuste geest 'wist' beter dan de bewuste geest wanneer een afbeelding AI-gegenereerd kon zijn. Maar desondanks konden deelnemers AI-gezichten niet met een robuuste mate van betrouwbaarheid bewust labelen.

We zouden kunnen speculeren dat er een bewuste interpretatielaag is waarbij we AI-gegenereerde gezichten 'het voordeel van de twijfel' geven, zelfs als we onzeker zijn.

We zijn immers van nature ingesteld op het herkennen en vertrouwen van menselijke gezichten, dus het is uitzonderlijk moeilijk om daar los van te komen en inconsistenties te isoleren die een door AI gegenereerd beeld zouden kunnen onthullen.

Het is bijna alsof aanvankelijke verdenkingen plaatsmaken voor een meer bevestigende bevestiging dat de persoon in feite echt is wanneer dat niet zo is - een vorm van door AI geïnitieerde verontschuldiging.

Wat de verklaring voor deze kronkel ook is, AI-gegenereerde diepe vervalsingen zijn een prioriteitsrisico voor de technologie, met een recent schandaal die een school in New Jersey raakte.

Diepe nepzwendel komen regelmatig voor en er zijn duidelijke zorgen dat valse AI-gegenereerde inhoud het stemgedrag zou kunnen beïnvloeden.