Tijdens haar bezoek aan het Verenigd Koninkrijk voor de AI Safety Summit kondigde de Amerikaanse vicepresident Kamala Harris aan dat 30 landen zich bij de VS hebben aangesloten en de voorgestelde vangrails voor militair gebruik van AI hebben onderschreven.

De "Politieke verklaring over verantwoord militair gebruik van kunstmatige intelligentie en autonomie" aankondiging werd geplaatst op de website van het Amerikaanse ministerie van Buitenlandse Zaken op 1 november, met aanvullende details van het kader gepubliceerd op 9 november.

In haar verklaring over het raamwerk zei Harris: "Om orde en stabiliteit te scheppen te midden van wereldwijde technologische veranderingen, ben ik er vast van overtuigd dat we ons moeten laten leiden door een gemeenschappelijke reeks afspraken tussen naties."

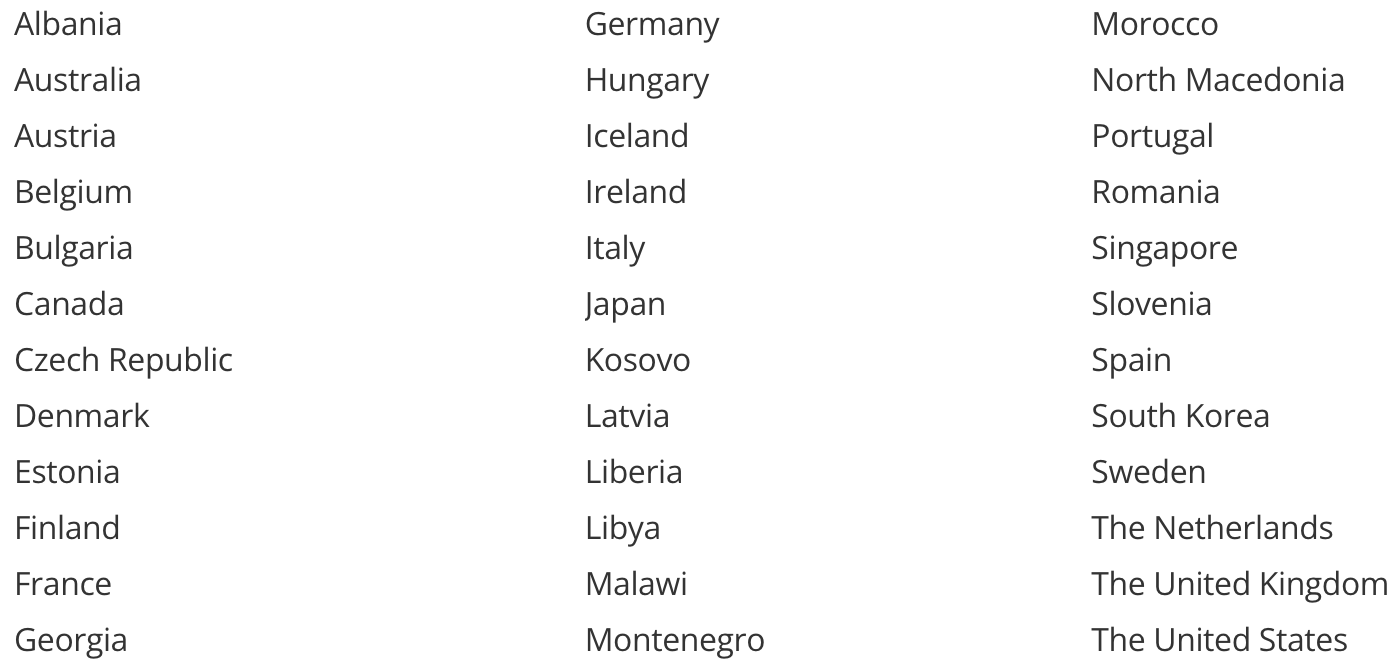

Dit zijn de landen die hun steun aan het initiatief hebben toegezegd.

Opvallend afwezig op deze lijst zijn China en Rusland. China onderschreef de Bletchley Verklaringwaarin het zijn principiële steun toezegt aan de veilige ontwikkeling van AI in het algemeen.

De beslissing van Rusland en China om de militaire AI-verklaring niet te onderschrijven heeft misschien meer te maken met de auteurs van het document dan met hun mening over de inhoud ervan.

Een ander gat op de lijst wordt gevormd door twee landen die op dit moment miljarden aan militaire steun ontvangen van enkele van de ondersteunende staten, Israël en Oekraïne.

Als bondgenoten van de VS is hun beslissing om de belofte niet te onderschrijven waarschijnlijk te wijten aan het feit dat beide landen momenteel AI gebruiken in de conflicten waarin ze verwikkeld zijn.

Israël gebruikt AI in verschillende militaire toepassingen, waaronder zijn IJzeren koepel systeem. Oekraïne heeft controverse uitgelokt met zijn autonome AI-drones richten zich op soldaten en militaire uitrusting in het conflict met Rusland.

Waar verbinden ze zich toe?

Als je de volledige details wilt lezen van waar de ondertekenaars mee akkoord gaan kunt u dat hier doen.

Hier is de korte versie die misschien wat inhoud opoffert voor beknoptheid:

- Zorg ervoor dat je leger deze AI-principes overneemt en gebruikt.

- Het gebruik van militaire AI moet voldoen aan de internationale wetgeving en burgers beschermen.

- De top moet de ontwikkeling en inzet van militaire AI beheren.

- Onbedoelde vooroordelen in militaire AI-capaciteiten proactief minimaliseren.

- Wees voorzichtig wanneer je AI-wapens maakt of gebruikt.

- Zorg ervoor dat je AI-verdedigingstechnologie transparant en controleerbaar is.

- Train degenen die militaire AI-mogelijkheden gebruiken of het gebruik ervan goedkeuren, zodat ze niet blindelings op de AI vertrouwen als die het fout doet.

- Definieer duidelijk wat je van plan bent te doen met je militaire AI-technologie en ontwerp het zodat het alleen dat doet.

- Blijf zelflerende en voortdurend bijgewerkte militaire AI-capaciteiten testen om te zien of ze nog steeds veilig zijn.

- Zorg voor een uitknop voor het geval je AI-wapen zich misdraagt.

Dit zijn lovenswaardige idealen, maar of ze technologisch of zelfs logistiek binnen de mogelijkheden van defensieorganisaties liggen, valt te betwijfelen.

Zijn ze afdwingbaar? Het ondertekenen van de belofte is een bevestiging van principiële goedkeuring, maar houdt geen juridische verplichting in.

Het ondertekenen van een document dat zegt: 'We zullen voorzichtig zijn met het gebruik van AI in ons leger', impliceert ook dat het land volledig van plan is om AI als wapen te gebruiken, zij het op een 'verantwoordelijke en ethische' manier.

Deze landen erkennen tenminste het potentieel van AI om de schade die conventionele wapens al veroorzaken te versterken. Heeft dit raamwerk de wereld een beetje veiliger gemaakt, of alleen de schijnwerpers gericht op wat onvermijdelijk in het verschiet ligt?