AI dringt wereldwijd door in het leven van miljoenen mensen, maar ondanks de wijdverspreide toepassing blijkt het lastig om de technologie te gelde te maken tegen de stijgende kosten.

Generatieve AI-tools zoals ChatGPT zijn duur om te draaien en vereisen high-end servers, dure GPU's en uitgebreide aanvullende hardware die veel energie verbruiken.

Hoewel grotendeels ongeverifieerd, Dylan Patel van SemiAnalysis vertelde De Informatie dat OpenAI naar verluidt enkele $700.000 per dag om zijn modellen uit te voeren, met een verlies van bijna $500 miljoen in 2022.

John Hennessy, voorzitter van het moederbedrijf van Google, Alphabet, zei dat een enkele melding op Bard tot 10 keer meer dan een Google-zoekopdrachten analisten geloven dat Google de komende jaren miljarden zal investeren in AI-gerelateerde uitgaven.

2023 heeft gefungeerd als proeftuin voor AI-monetarisatie. Techgiganten als Microsoft, Google en Adobe proberen allerlei verschillende benaderingen om hun AI-aanbod te creëren, promoten en prijzen.

De meeste commerciële modellen zoals ChatGPT, Bard en Anthropic's Claude 2 beperken gebruikers al tot een bepaald aantal prompts per uur of dag, inclusief betaalde versies zoals ChatGPT Plus. Adobe stelt maandelijkse gebruikslimieten in voor zijn Firefly-modellen.

De immense kosten van AI treffen ook bedrijven. Adam Selipsky, de CEO van Amazon Web Services (AWS), gaf commentaar op de onbetaalbare kosten voor zakelijke gebruikers die AI workloads willen bouwen: "Veel van de klanten met wie ik heb gesproken zijn ongelukkig met de kosten die ze zien voor het uitvoeren van sommige van deze modellen."

Chris Young, hoofd bedrijfsstrategie van Microsoft, merkte op dat het nog vroeg is voor bedrijven die gebruik willen maken van de huidige AI-modellen: "Het zal tijd kosten voor bedrijven en consumenten om te begrijpen hoe ze AI willen gebruiken en wat ze bereid zijn ervoor te betalen."

Hij voegde eraan toe: "We zijn nu duidelijk op een punt waar we de opwinding en de interesse moeten omzetten in echte adoptie."

AI-modellen vs. software

AI biedt niet dezelfde besparingen als conventionele software, omdat het voor elke taak specifieke berekeningen vereist.

Wanneer gebruikers een model als ChatGPT vragen, zoekt het naar patronen en reeksen uit de trainingsgegevens in de neurale netwerkarchitectuur en berekent het een specifiek antwoord. Elke interactie kost energie, wat leidt tot lopende kosten.

Naarmate het gebruik toeneemt, nemen ook de kosten toe, wat een uitdaging vormt voor bedrijven die AI-services tegen vaste tarieven aanbieden.

Microsoft heeft bijvoorbeeld onlangs samengewerkt met OpenAI om GitHub Copilot te introduceren, gericht op programmeurs en ontwikkelaars.

Door de hoge operationele kosten is het tot nu toe niet winstgevend geweest. In de eerste maanden van het jaar rekende Microsoft een abonnement van $10 per maand voor deze AI-assistent en leed elke gebruiker een gemiddeld verlies van meer dan $20 per maand. Sommige gebruikers leden verliezen tot $80 per maand, zoals blijkt uit een bron bij de WSJ.

Microsoft's Copilot suite voor Microsoft 365 (verwarrend genoeg dezelfde naam als de GitHub tool) zal maandelijks $30 extra kosten. Deze tool biedt mogelijkheden zoals het zelfstandig opstellen van e-mails, het maken van PowerPoint presentaties en het maken van Excel spreadsheets.

Google is ook van plan om een AI-assistent-functie uit te brengen voor zijn werkplektools, waarvoor een extra maandelijkse toeslag van $30 bovenop de bestaande kosten moet worden betaald.

Zowel Microsoft als Google zetten in op een vast maandelijks tarief, in de hoop dat de verhoogde kosten de gemiddelde kosten voor het aandrijven van deze AI-tools voldoende zullen compenseren.

Hoewel $30/maand misschien betaalbaar lijkt in sommige meer ontwikkelde westerse landen, zijn deze prijsmodellen niet inclusief voor een groot deel van de wereldbevolking.

Toen ChatGPT Plus bijvoorbeeld op de Indiase markt kwam, klaagden velen dat het was veel te duurDit kost een aanzienlijk deel van het gemiddelde maandsalaris van $330. Miljarden gebruikers uitsluiten van AI kan ontwikkelaars duur komen te staan wanneer ze tools aan het publiek verkopen.

De kosten zijn ook niet onbelangrijk voor mensen die in meer welvarende landen wonen: uit onderzoek blijkt dat abonnementen een van de eerste dingen zijn die verdwijnen als mensen hun uitgaven willen beperken.

Waarom is AI zo moeilijk te gelde te maken?

AI zorgt voor een leegte tussen de schijnbaar oneindige visies van ontwikkelaars en de eindige middelen die beschikbaar zijn om ze te verwezenlijken.

OpenAI CEO Sam Altman beweert dat een futuristische AI-ingebedde wereld simpelweg 'onvermijdelijk' is, waar intelligente machines naast ons leven en ons werk doen, waar mensen honderden jaren of onsterfelijk leven en waar AI's die in onze hersenen zijn ingebed ons helpen complexe taken uit te voeren zonder dat we zelf hoeven te denken.

Daarin staat hij zeker niet alleen: Inflection CEO Mustafaya Suleman publiceerde onlangs zijn boek "The Coming Wave", waarin hij AI vergelijkt met de Cambrische explosie 500 miljoen jaar geleden, die leidde tot de snelste uitbarsting in de evolutie ooit op onze planeet.

Generatieve AI is klaar om te exploderen, met een verwachte omzet van meer dan $1 biljoen in 2032. Van waar het begon tot waar het nu is en waar het zal komen is verbazingwekkend... elke industrie zal ten goede veranderen. pic.twitter.com/0licQGfphn

- Mustafa Suleyman (@mustafasuleyman) 20 oktober 2023

Ambities wakkeren ideeën aan, maar geld drijft de techindustrie aan. AI-onderzoek en -ontwikkeling is duur, dus industrieleiders zoals OpenAI, Google en Facebook investeren veel om voorop te blijven lopen.

AI-bedrijven trokken in 2021 maar liefst $94 miljard aan investeringen aan, waarbij meerdere financieringsrondes $500 miljoen of meer bereikten. Het jaar 2023 verhoogde de score, met investeringen in startups Antropisch en Buiging de grens van $1 miljard passeren.

AI-specialisten vragen hoge salarissen, vaak in de miljoenen, vanwege de hevige concurrentie, en modellen moeten regelmatig worden bijgesteld en gestresst, waardoor de lopende kosten toenemen.

Er zijn ook bijkomende kosten met betrekking tot de datacenters en het onderhoud, vooral koelingDergelijke hardware loopt warm en kan defect raken als deze niet op de optimale temperatuur wordt gehouden.

In sommige omstandigheden hebben GPU's een korte levensduur van minder dan vijf jaar en hebben ze vaak specialistisch onderhoud nodig.

AI monetisatiestrategieën

Hoe benaderen techbedrijven, in het licht van deze uitdagingen, de uitdaging van het te gelde maken van AI?

Productiviteit verhogen

Bedrijven zullen profiteren van AI door de netto maatschappelijke productiviteit aanzienlijk te verhogen. Door repetitieve taken te automatiseren, kunnen professionals zich richten op functies met een hogere toegevoegde waarde.

Dit zal hen helpen om zowel privaat als publiek geld aan te boren. DeepMind werkt bijvoorbeeld samen met de National Health Service (NHS) in het Verenigd Koninkrijk en techbedrijven werken samen met overheden om klimaatverandering aan te pakken.

AI-gedreven productiviteit kan echter van invloed zijn op andere inkomstenstromen van techbedrijven. Google's advertentie-inkomsten dalen omdat AI verkeer wegtrekt van zijn zoekmachine. Dit jaar zag Google's inkomsten uit YouTube-advertenties dalen met 2,6%en de inkomsten uit reclamenetwerken dalen met een nooit eerder geziene 8,3%.

Hardware verkopen

Voor het trainen en hosten van AI-modellen is gespecialiseerde high-end hardware nodig. GPU's zijn onmisbaar voor het uitvoeren van geavanceerde AI-algoritmen, waardoor ze een lucratieve component vormen in het AI-ecosysteem.

Marktleider Nvidia is hier de grote winnaar, met een marktkapitalisatie van $1 biljoen, maar er zijn ook andere grote winnaars. lagere AI-hardwarefabrikanten hebben er ook van geprofiteerd.

Abonnementen

Het aanbieden van AI-uitbreidingen als onderdeel van abonnementspakketten is de manier om inkomsten te genereren van openbare gebruikers en bedrijven die de API-route niet willen of hoeven te volgen.

ChatGPT Plus is de AI-dienst met het hoogste aantal abonnementen wereldwijd, maar informatie over de inkomsten ontbreekt.

OpenAI lanceerde zijn Ondernemingsvariant dit jaar om de inkomsten uit abonnementen te verhogen en verklaarde dat het bedrijf op koers ligt voor $1 miljard aan inkomsten in het komende jaar.

API's

Bedrijven als OpenAI gebruiken voor hun API's een token-gebaseerde factureringsmethode voor zakelijke gebruikers.

Dit systeem zorgt ervoor dat gebruikers gefactureerd worden op basis van de werkelijke rekenbelasting van hun aanvragen, wat eerlijkheid en transparantie garandeert.

API-prijsmodellen zijn geschikt voor een breed spectrum van gebruikers, van degenen die sporadisch lichte gesprekken voeren tot zware gebruikers met intensieve taken.

AI als inherent kenmerk

Sommige bedrijven integreren AI-mogelijkheden in hun producten zonder daar meteen extra voor te vragen. Deze strategie is erop gericht om eerst de inherente waarde van een product te verhogen.

Na verloop van tijd, als gebruikers de AI-mogelijkheden in hun workflows hebben geïntegreerd en de waarde ervan inzien, zullen ze eerder geneigd zijn om een volgende prijsverhoging te accepteren. AI moet echter progressieve voordelen opleveren als de kosten gestaag stijgen.

Open source AI-trainingskosten worden goedkoper

Er is hier een parallelle discussie - waarom zou iemand betalen voor AI als hij het nooit bezit?

Sommigen - zoals AI-'godfather' Yann LeCun - vinden dat AI deel moet gaan uitmaken van onze openbare infrastructuur en benadrukken dat ontwikkelaars open source modellen moeten bouwen die goedkoop en eenvoudig toegankelijk zijn.

Een artikel in de NYT over het debat over de vraag of LLM-basismodellen gesloten of open moeten zijn.

Meta pleit voor openheid, te beginnen met de vrijgave van LLaMA (voor niet-commercieel gebruik), terwijl OpenAI en Google alles gesloten en propriëtair willen houden.

Ze stellen dat openheid...

- Yann LeCun (@ylecun) 18 mei 2023

Nu AI-oplossingen een integraal onderdeel worden van bedrijven, beschikken veel bedrijven niet over het budget om eigen modellen te ontwikkelen. Traditioneel wenden ze zich tot API's van opkomende AI-startups of kant-en-klare systemen.

Naarmate de trainingskosten afnemen en de drang naar dataprivacy toeneemt, wordt er echter steeds vaker samengewerkt met leveranciers die gespecialiseerd zijn in het aanpassen van zowel private als open-source modellen.

Naveen Rao, CEO en medeoprichter van MosaicML, uitgelegd aan The Register dat open source modellen aanlokkelijk zijn omdat ze goedkoper en flexibeler zijn en bedrijven in staat stellen om werklasten privé te houden.

MosaicML heeft een serie open source grote taalmodellen (LLM's) gelanceerd op basis van zijn MPT-7B architectuur. In tegenstelling tot veel andere LLM's is dit model commercieel levensvatbaar voor de massa.

Rao vertelde over de beweegredenen achter dit model: "Er is zeker veel belangstelling voor dit soort dingen en we hebben het om verschillende redenen gedaan." Hij voegde eraan toe: "Eén reden was dat we een model wilden hebben dat toestemming heeft voor commercieel gebruik. We willen dat soort innovatie niet belemmeren."

Over de betaalbaarheid zei Rao: "Als een klant naar ons toekomt en zegt: train dit model, dan kunnen we dat doen voor $200.000 en daar verdienen we nog steeds geld mee."

MosaicML biedt bedrijven ook de tools om hun aangepaste modellen efficiënt te hosten op cloudplatforms. "Hun gegevens worden niet gedeeld met de startup en ze zijn eigenaar van de gewichten en het IP van het model", bevestigt Rao.

Rao ging ook in op de beperkingen van commerciële API's en zei: "Commerciële API's zijn een geweldig hulpmiddel om prototypes te maken. Ik denk dat mensen ChatGPT-achtige diensten zullen gebruiken voor entertainment en misschien wat persoonlijke dingen, maar niet voor bedrijven. Data is een zeer belangrijke moat voor bedrijven."

Rao benadrukte verder de kosten van in-house architectuur, door te zeggen: "GPU's falen eigenlijk heel vaak," "Als een node uitvalt en er is een handmatige interventie nodig, het kostte je vijf uur [om te repareren], dan heb je net $10.000 verbrand zonder werk, toch?".

Hij ging ook in op het dreigende probleem van chipstekorten in de industrieHij zei: "We zullen minstens twee jaar, misschien vijf jaar, in deze wereld van GPU-tekorten leven."

Als bedrijven gebruik kunnen maken van open source AI om hun goedkope modellen te trainen met volledige datasoevereiniteit en -controle, dan vormt dat een uitdaging voor publieke AI zoals ChatGPT.

Dreigende knelpunten voor AI?

Naast de GPU-tekorten waar Rao de aandacht op vestigde, is een andere barrière voor het te gelde maken van AI de explosief stijgende energiebehoefte van de industrie.

A recente studie voorspelt dat in 2027 het energieverbruik van de AI-industrie gelijk zal zijn aan dat van een kleine natie.

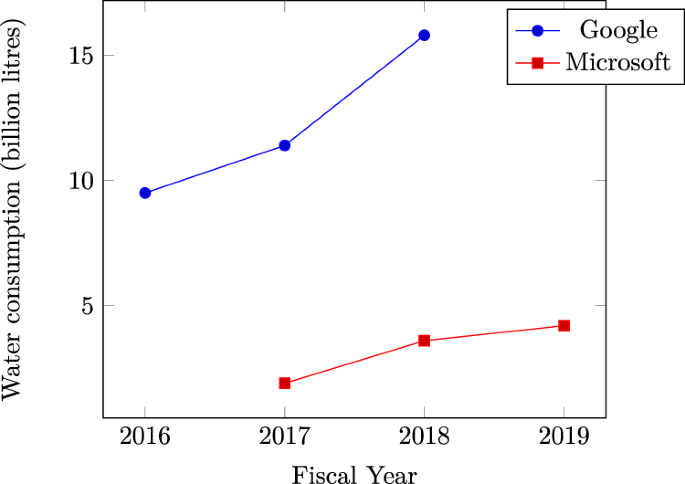

Microsoft stijgend waterverbruik datacenters bevestigt de immense dorst van AI naar natuurlijke hulpbronnen. Er zijn aanwijzingen dat recente pieken in het waterverbruik door techgiganten als Microsoft en Google worden toegeschreven aan intensieve AI-gerelateerde werklasten.

Op een bredere schaal overschrijdt het cumulatieve energieverbruik van datacenters al 1% van het wereldwijde elektriciteitsverbruik, volgens de Internationaal Energieagentschap (IEA).

Als de vraag naar energie blijft stijgen, kunnen AI-bedrijven gedwongen worden om hun aandacht te richten op het ontwikkelen van efficiëntere benaderingen voor modeltraining, wat het traject van de technologie op de korte termijn zou kunnen schaden.

Concurrerende verhalen

De opkomende AI-industrie is nog jong en de toekomstige richting is bijzonder moeilijk te voorspellen.

Centrale figuren in AI erkennen dat hun vooroordelen niet altijd overeenkomen met de werkelijkheid.

Sam Altman gaf bijvoorbeeld op de podcast van Joe Rogan toe dat hij het mis had over de ontwikkelingskoers van AI en beschreef dat de weg naar de realisatie van hoogintelligente vormen van AI eerder granulair dan explosief zal zijn.

Aan de ene kant blijkt AI moeilijk te gelde te maken, waardoor twijfel ontstaat of de initiële hype zal afnemen, wat leidt tot een langzamer proces om de technologie volwassen te maken.

Aan de andere kant heeft de industrie misschien al genoeg vooruitgang geboekt om AI richting een 'singulariteit' te duwen waar het de menselijke cognitie voorbijstreeft.

Als de mensheid de komende jaren vooruitgang boekt op essentiële gebieden zoals energieproductie en het bouwen van AI-hardware en -architectuur met een laag energieverbruik - en Daar is dit jaar vooruitgang geboekt - dan kan de technologie knelpunten op korte termijn uit de weg ruimen en haar onstuimige ontwikkeling voortzetten.