Krijgt AI een bepaald niveau van bewustzijn? Hoe weten we of en wanneer dat het geval is?

Grote taalmodellen (LLM's) kunnen realistische gesprekken voeren en tekst genereren over uiteenlopende onderwerpen, waardoor discussies ontstaan over wanneer ze gevoelig of bewust worden - wat, hoewel vaak gekoppeld, verschillende concepten zijn.

Sentience houdt zich voornamelijk bezig met gevoel en bewustzijn, terwijl consciousness complexer en overkoepelender is.

Eerder dit jaar nog heeft Microsoft, na het testen van OpenAI's GPT-4, aangegeven dat het model "vonken" van "algemene intelligentie" vertoonde - een term die wordt gebruikt om flexibele, aanpasbare AI met hoge cognitieve vaardigheden te definiëren.

Nog controversiëler was de bewering van Blake Lemoine, een voormalig ingenieur bij Google, dat Google's LaMDA AI een niveau van bewustzijn had bereikt. Lemoine zei over LaMDA: "Google zou dit het delen van eigendomsrecht kunnen noemen. Ik noem het het delen van een discussie die ik had met een van mijn collega's" - die 'collega' is het AI-systeem dat 'angst' uitte over 'uitgeschakeld worden'.

In een poging om het debat over AI-bewustzijn te onderbouwen, heeft een interdisciplinair team van onderzoekers op het gebied van filosofie, informatica en neurowetenschappen een uitgebreid onderzoek uitgevoerd naar de meest geavanceerde AI-systemen van dit moment.

De onderzoekonder leiding van Robert Long en zijn collega's van het Center for AI Safety (CAIS), een non-profit organisatie in San Francisco, onderzochten meerdere theorieën over menselijk bewustzijn. Ze stelden een lijst van 14 "indicatoreigenschappen" op die een bewuste AI waarschijnlijk zou vertonen.

CAIS is dezelfde non-profit organisatie die acht koppen op de markt heeft gebracht. mogelijke risico's voor AI in juni.

Na het analyseren van hun resultaten kwam het team uiteindelijk tot de conclusie dat de meest complexe modellen niet voldeden aan vrijwel elke bewustzijnstest waaraan ze werden onderworpen.

Onderzoekers evalueerden verschillende AI-modellen, waaronder DeepMind's adaptieve agent (ADa) en PaLM-Ebeschreven als een belichaamde robotachtige multimodale LLM.

Door deze AI's te vergelijken met de 14 indicatoren vonden de onderzoekers geen substantieel bewijs dat erop wijst dat er AI-modellen zijn die bewustzijn bezitten.

Meer over het onderzoek

Deze gedetailleerde interdisciplinaire studie analyseerde talrijke theorieën over bewustzijn - dat in de wetenschappelijke literatuur nog steeds een slecht beschreven concept is - en paste ze toe op de huidige AI-modi.

Hoewel het onderzoek niet heeft kunnen vaststellen dat de huidige AI's bewustzijn bezitten, legt het wel de basis voor toekomstige analyses en biedt het in wezen een 'checklist' waar onderzoekers naar kunnen verwijzen bij het analyseren van de mogelijkheden van hun AI's.

Inzicht in bewustzijn is ook van vitaal belang voor het publieke debat over AI.

Bewustzijn is echter geen binair concept en het is nog steeds bijzonder moeilijk om de grenzen te bepalen.

Sommige onderzoekers geloven dat bewustzijn zich spontaan zal ontwikkelen zodra AI een 'singulariteit' nadert, wat in wezen het punt markeert waarop de complexiteit van AI-systemen de menselijke cognitie overtreft.

Hier zijn de 14 bewustzijnsindicatoren die de onderzoekers beoordeelden:

Terugkerende verwerkingstheorie (RPT)

De terugkerende verwerkingstheorie richt zich op de temporele aspecten van informatieverwerking.

In de context van bewustzijn benadrukt het hoe informatie in de loop van de tijd op een lusachtige manier wordt onderhouden en bijgewerkt.

Dit wordt beschouwd als cruciaal voor het opbouwen van de rijkdom van bewuste ervaringen.

RPT-1: Invoermodules met algoritmische herhaling

Algoritmische herhaling verwijst hier naar het herhaaldelijk cyclisch verwerken van informatie.

Zie het als een lus in een computerprogramma dat zijn gegevens voortdurend bijwerkt op basis van nieuwe invoer.

RPT-2: Ingangsmodules die georganiseerde, geïntegreerde perceptuele ervaringen genereren

Net als mensen en andere dieren ontvangt het systeem niet alleen zintuiglijke informatie, maar integreert het deze informatie tot een samenhangend en verenigd 'plaatje' dat kan worden waargenomen als een enkele ervaring.

Globale werkruimtetheorie (GWT)

De tweede set indicatoren die het onderzoeksteam specificeerde was de global workspace theorie, die voorstelt dat bewustzijn ontstaat uit de interacties tussen verschillende cognitieve modules in een 'global workspace'.

Deze werkruimte dient als een soort cognitief podium waar verschillende modules informatie kunnen 'uitzenden' en 'ontvangen', waardoor een verenigde, samenhangende ervaring mogelijk wordt.

GWT-1: Meerdere gespecialiseerde systemen die parallel werken

Dit betekent in wezen dat een AI-systeem meerdere gespecialiseerde 'mini-hersenen' moet hebben, die elk verantwoordelijk zijn voor verschillende functies (zoals geheugen, perceptie en besluitvorming) en die tegelijkertijd moeten kunnen werken.

GWT-2: Werkruimte met beperkte capaciteit

Dit idee heeft te maken met het feit dat mensen zich maar op een beperkte hoeveelheid informatie kunnen concentreren.

Op dezelfde manier zou een AI-systeem selectieve focus moeten hebben - in wezen een vermogen om de meest essentiële informatie te bepalen om 'aandacht aan te besteden'.

GWT-3: Wereldwijde uitzending

Informatie die de globale werkruimte bereikt, moet beschikbaar zijn voor alle cognitieve modules zodat elk 'mini-brein' die informatie kan gebruiken voor zijn gespecialiseerde functie.

GWT-4: Toestandsafhankelijke aandacht

Dit is een meer geavanceerde vorm van focus. Het AI-systeem moet zijn aandacht kunnen verleggen op basis van de huidige toestand of taak.

Het kan bijvoorbeeld prioriteit geven aan zintuiglijke gegevens bij het navigeren door een kamer, maar overschakelen naar probleemoplossende algoritmen wanneer het geconfronteerd wordt met een puzzel.

Computationele hogere-ordetheorieën (HOT)

Hogere-orde theorieën benaderen bewustzijn vanuit een meta-cognitief perspectief.

Ze stellen dat bewuste ervaring niet alleen gaat over het hebben van percepties, gedachten of gevoelens, maar ook over het je bewust zijn dat je deze ervaringen hebt.

Dit bewustzijn is cruciaal en is deels de reden waarom hoogintelligente dieren sociaal zijn - we zijn ons collectief bewust van ons bestaan en onze onderlinge afhankelijkheid.

HOT-1: Generatieve, top-down of ruisperceptiemodules

In plaats van passief informatie te ontvangen, interpreteert of genereert het systeem waarnemingen.

Stel je een fotobewerkingssoftware voor die niet alleen een foto kan aanpassen, maar ook begrijpt waarom bepaalde kenmerken moeten worden aangepast.

HOT-2: Metacognitieve controle

Dit betekent dat het systeem een 'denkproces' moet hebben over zijn 'denkprocessen'.

Het moet zijn eigen beslissingen en waarnemingen in twijfel kunnen trekken, zoals mensen en sommige dieren dat doen.

HOT-3: Agentschap geleid door een algemeen overtuigingsvormingssysteem

Agency houdt hier in dat het AI-systeem niet alleen passief gegevens analyseert - het neemt beslissingen op basis van zijn analyse.

Bovendien worden door deze beslissingen de 'overtuigingen' of datamodellen van het systeem voortdurend bijgewerkt, net zoals mensen voortschrijdende kennis creëren door nieuwsgierigheid en onderzoek.

HOT-4: Vermogen om voorkeuren vast te houden

Dit verwijst naar het vermogen van het systeem om complexe gegevens te stroomlijnen tot eenvoudigere, beter hanteerbare vormen, waardoor het mogelijk subjectieve 'voorkeuren' of 'ervaringen' kan hebben.

Aandacht schema theorie (AST)

De aandachtsschema theorie stelt dat bewustzijn voortkomt uit de greep van de hersenen op de eigen aandachtstoestand.

AST-1: Voorspellend model dat de huidige aandachtstoestand weergeeft

Het AI-systeem zou moeten kunnen voorspellen waar het zich vervolgens op zal richten, wat duidt op een soort zelfbewustzijn over zijn eigen cognitieve toestand.

Voorspellende verwerking (PP)

Voorspellende verwerkingsmodellen beschrijven het voorspellend vermogen van de hersenen.

Het werkt zijn modellen van de wereld voortdurend bij en gebruikt deze om binnenkomende zintuiglijke informatie te voorspellen.

PP-1: Invoermodules met voorspellende codering

Hierbij worden gegevens uit het verleden en het heden gebruikt om toekomstige toestanden te voorspellen, zodat het systeem kan 'anticiperen' in plaats van alleen maar 'reageren'.

Agentschap en belichaming (AE)

Theorieën over agency en belichaming stellen dat het in staat zijn om te handelen en het effect van acties te begrijpen cruciale indicatoren van bewustzijn zijn.

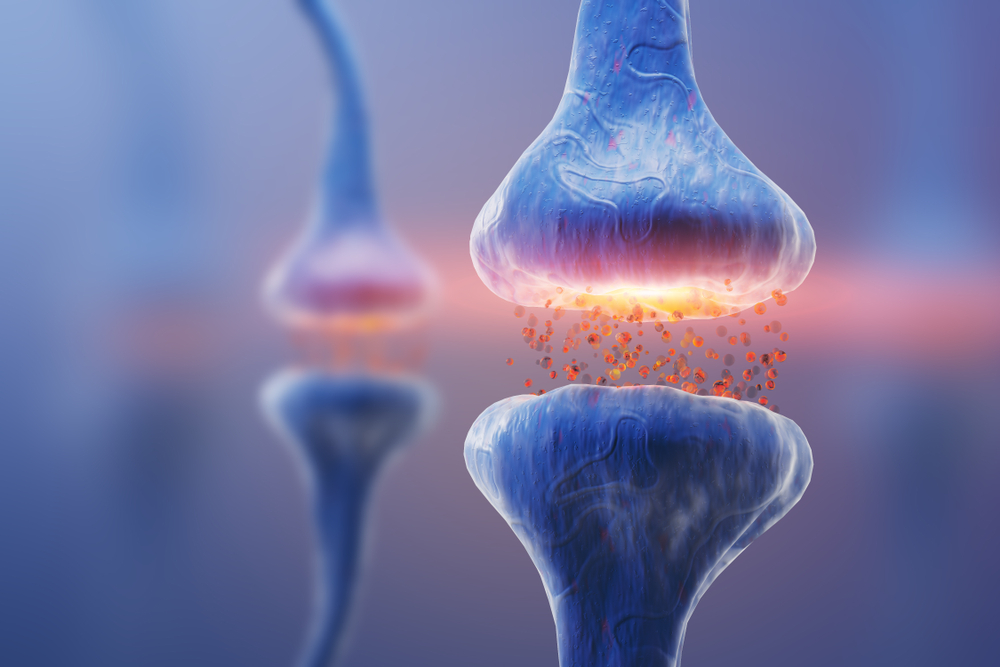

Belichaming verschilt sterk van dieren en andere levende organismen, die over nauw verbonden zenuwstelsels beschikken die voortdurend sensorische informatie van en naar organen en centrale verwerkingssystemen sturen.

AE-1: Agentschap

Agency verwijst naar het leren van feedback om toekomstige acties aan te passen, vooral wanneer er tegenstrijdige doelen zijn. Stel je een zelfrijdende auto voor die leert om zowel snelheid als veiligheid te optimaliseren.

AE-2: belichaming

Dit gaat over het vermogen van een systeem om te begrijpen hoe zijn acties de wereld om zich heen beïnvloeden en hoe die veranderingen op hun beurt weer invloed hebben op het systeem zelf.

Onderzoekers werken momenteel aan AI-systemen die verbonden zijn met geavanceerde sensoren, zoals het PaLM-E multimodale AI-systeem dat is ontwikkeld door Google en dat een van de systemen was die onderzoekers analyseerden.

Bewustzijn in AI: de risico's van onder- en overtoewijzing afwegen

Onderzoekers en het grote publiek zijn op zoek naar duidelijkheid over hoe intelligent AI werkelijk is en of het positief afstevent op bewustzijn.

De meeste publieke AI's zoals ChatGPT zijn 'black boxes', wat betekent dat we niet helemaal begrijpen hoe ze werken. - hun innerlijke mechanisme is bedrijfsgeheim.

De leider van het onderzoek, Robert Long, benadrukte de noodzaak van een interdisciplinaire aanpak voor het analyseren van machinebewustzijn en waarschuwde voor het "risico om menselijk bewustzijn te verwarren met bewustzijn in het algemeen".

Colin Klein, een teamlid van de Australian National University, benadrukte ook de ethische implicaties van AI-bewustzijn. Hij legde uit dat het cruciaal is om het machinebewustzijn te begrijpen "om ervoor te zorgen dat we het niet onethisch behandelen, en om ervoor te zorgen dat we het niet toestaan om ons onethisch te behandelen."

Hij zei verder: "Het idee is dat als we deze bewuste AI's kunnen maken, we ze in principe als slaven zullen behandelen en allerlei onethische dingen met ze zullen doen."

"De andere kant is of we ons zorgen maken over onszelf, en wat voor controle de AI over ons zal hebben; zal het in staat zijn om ons te manipuleren?"

Dus wat zijn de risico's van het onderschatten of overschatten van het AI-bewustzijn?

Onderschatting van het machinebewustzijn

Terwijl de vooruitgang op het gebied van AI de grenzen blijft verleggen, beginnen de ethische debatten rondom de technologie steeds heviger te worden.

Bedrijven zoals OpenAI ontwikkelen al kunstmatige algemene intelligentie (AGI)Het is de bedoeling om de mogelijkheden van de huidige AI's zoals ChatGPT te overstijgen en flexibele en multimodale systemen te bouwen.

Als we erkennen dat elke entiteit die in staat is om bewust te lijden een morele overweging verdient - zoals we doen met veel dieren - dan riskeren we morele schade als we de mogelijkheid van bewuste AI-systemen over het hoofd zien.

Bovendien onderschatten we misschien hun vermogen om ons kwaad te doen. Stel je de risico's voor van een geavanceerd bewust AI-systeem dat zich realiseert dat de mensheid het mishandelt.

Het overschatten van machinebewustzijn

Aan de andere kant van het debat staat het risico dat er te veel bewustzijn wordt toegeschreven aan AI-systemen.

Mensen hebben de neiging om AI te antropomorfiseren, wat ertoe leidt dat velen ten onrechte bewustzijn toeschrijven aan de technologie omdat deze ons uitstekend kan imiteren.

Zoals Oscar Wilde zei: "Imitatie is de eerlijkste vorm van vleierij", en AI doet dat uitzonderlijk goed.

Antropomorfisme wordt problematisch als AI-systemen mensachtige eigenschappen ontwikkelen, zoals natuurlijke taalvaardigheden en gezichtsuitdrukkingen.

Velen bekritiseerden Google's Blake Lemoine omdat hij zich liet 'misleiden' door LaMDA's op mensen lijkende gespreksvaardigheden, terwijl het in werkelijkheid tekst synthetiseerde uit menselijke gesprekken in de trainingsgegevens en niet iets van unieke bewuste oorsprong.

Emotionele behoeften kunnen de neiging tot antropomorfisme versterken. Individuen kunnen bijvoorbeeld op zoek gaan naar sociale interactie en emotionele bevestiging van AI-systemen, waardoor hun oordeel over het bewustzijn van deze entiteiten scheefgetrokken wordt.

De AI-chatbot Replika is - zoals de naam al doet vermoeden - ontworpen om menselijke interacties na te bootsen en was verwikkeld in een moordcomplot van geesteszieke persoon om Koningin Elizabeth II te vermoorden, wat leidde tot zijn arrestatie en opsluiting in een psychiatrische inrichting.

Andere AI's, zoals Anthropic's Claude en Inflection's Pi, zijn ontworpen om menselijke conversaties na te bootsen en als persoonlijke assistenten te fungeren.

DeepMind is ook een levenscoach ontwikkelen Een chatbot die is ontworpen om gebruikers direct persoonlijk advies te geven, een idee dat tot bezorgdheid heeft geleid over de vraag of mensen willen dat AI zich met hun persoonlijke zaken bemoeit.

In dit debat is het cruciaal om te onthouden dat de technologie nog jong is.

Hoewel de huidige AI-systemen niet robuust bewust zijn, zullen we de komende jaren ongetwijfeld steeds dichter bij het realiseren van bewuste kunstmatige systemen komen die het cognitieve van biologische hersenen evenaren of overtreffen.