Nu AI zich steeds verder nestelt in wervingsprocessen, is het duidelijk dat de belofte van efficiëntie gepaard gaat met eigen risico's.

Volgens 2022 gegevensZo'n 55% van de bedrijven gebruikt al AI-tools voor werving.

Hoewel AI traditionele wervingsmethoden heeft versneld, waardoor stapels cv's en cv's overbodig zijn geworden, heeft het ook kritische vragen opgeroepen over eerlijkheid, vooroordelen en de aard van menselijke besluitvorming.

AI's zijn immers getraind op menselijke gegevens, dus ze erven waarschijnlijk alle vooroordelen en vooroordelen die ze beloven uit te bannen.

Is dit iets wat we kunnen veranderen? Wat hebben we tot nu toe geleerd van wervings-AI?

Meta beschuldigd van discriminerende advertentiepraktijken door mensenrechtengroeperingen

Uit gegevens blijkt dat sommige 79% van werkzoekenden gebruiken sociale media om werk te zoeken en het is bewezen dat dit de plaats is waar discriminatie begint.

Meta is momenteel geconfronteerd met meerdere beschuldigingen van Europese mensenrechtenorganisaties die beweren dat het algoritme van Facebook voor het targeten van vacatures bevooroordeeld is.

In juni heeft de NGO Wereldwijde getuigenis onderzocht verschillende automatisch gerichte Facebook-vacatureadvertenties en ontdekte dat veel advertenties gendervooroordelen in stand hielden.

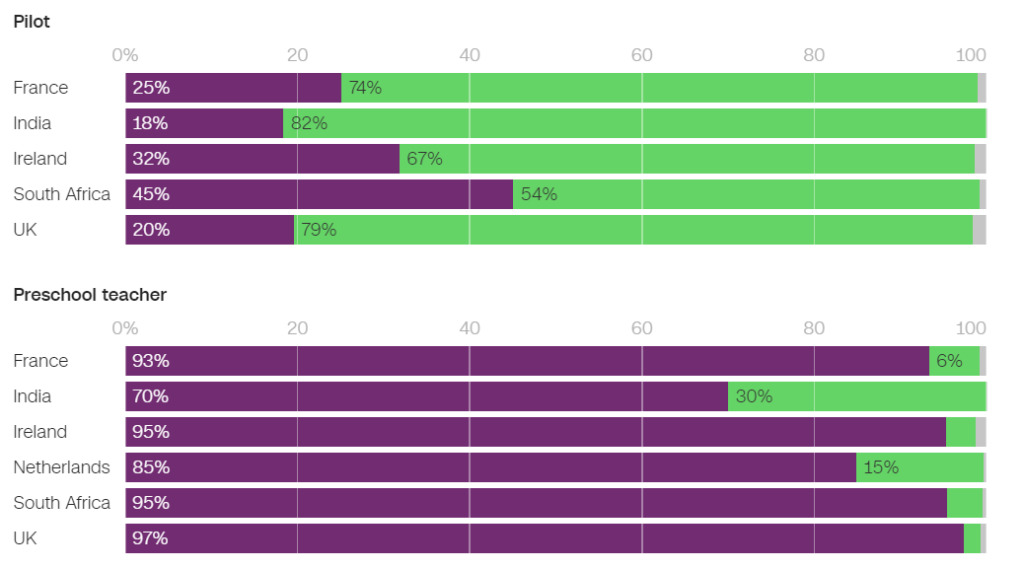

Mannen kregen bijvoorbeeld significant vaker advertenties te zien die te maken hadden met techniek, terwijl vrouwen aanzienlijk vaker advertenties te zien kregen die te maken hadden met lesgeven.

Van de advertenties die in Frankrijk werden getoond, waren 93% van de gebruikers die een vacature voor kleuterleidster te zien kregen en 86% van degenen die een vacature voor psycholoog te zien kregen, vrouwen. Daarentegen werd slechts 25% van de vrouwen een vacature voor piloot getoond en slechts 6% van de vrouwen een vacature voor monteur.

In Nederland waren 85% van de gebruikers die een vacature voor leerkracht te zien kregen en 96% van de gebruikers die een vacature voor receptionist te zien kregen, vrouwen. Vergelijkbare resultaten werden waargenomen in veel andere landen, waaronder het Verenigd Koninkrijk, India en Zuid-Afrika.

In een interview met CNNNaomi Hirst van Global Witness zei: "Onze zorg is dat Facebook de vooroordelen in onze samenleving verergert en de kansen op vooruitgang en gelijkheid op de werkvloer in gevaar brengt."

Samen met Bureau Clara Wichmann en Fondation des Femmes heeft Global Witness klachten tegen Meta ingediend bij mensenrechten- en gegevensbeschermingsautoriteiten in Frankrijk en Nederland.

De groepen dringen aan op een onderzoek naar de vraag of de praktijken van Meta in strijd zijn met de mensenrechten of de wetten voor gegevensbescherming. Als de beschuldigingen standhouden, kan Meta boetes en sancties opgelegd krijgen.

In een reactie verklaarde een woordvoerder van Meta: "Het systeem houdt rekening met verschillende soorten informatie om mensen advertenties aan te bieden waarin ze het meest geïnteresseerd zijn."

Dit is niet de eerste keer dat Meta dergelijke kritiek wegwuift - het bedrijf kreeg te maken met meerdere rechtszaken in 2019 en heeft toegezegd zijn advertentie-aanbod te veranderen om vooroordelen op basis van beschermde kenmerken zoals geslacht en ras te voorkomen.

Pat de Brún van Amnesty International was vernietigend over de bevindingen van Global Witness. "Onderzoek toont consequent aan hoe de algoritmes van Facebook zeer ongelijke resultaten opleveren en vaak marginalisatie en discriminatie versterken," vertelde ze CNN.

Amazon schrapt geheime AI-wervingstool die vooroordelen tegen vrouwen vertoonde

Amazon ontwikkelde tussen 2014 en 2017 een AI-wervingstool voordat het zich realiseerde dat de tool bevooroordeeld was bij het selecteren van banen voor softwareontwikkelaars en andere technische functies. In 2018 liet Amazon de tool volledig vallen.

Het AI-systeem bestrafte cv's met het woord "vrouwen" en "vrouwen" en verlaagde de vaardigheden van vrouwelijke afgestudeerden.

Het systeem faalde zelfs nadat Amazon had geprobeerd de algoritmes te bewerken om ze genderneutraal te maken.

Later bleek dat Amazon de tool had getraind op cv's die over een periode van 10 jaar bij het bedrijf waren ingediend en waarvan de meeste afkomstig waren van mannen.

Zoals veel AI-systemen werd de tool van Amazon beïnvloed door de gegevens waarop het was getraind, wat leidde tot onbedoelde vooroordelen. Deze vooringenomenheid bevoordeelde mannelijke kandidaten en gaf de voorkeur aan cv's waarin taal werd gebruikt die vaker voorkomt in cv's van mannelijke ingenieurs.

Bovendien raadde het systeem door problemen met de onderliggende gegevens vaak ongekwalificeerde kandidaten aan voor verschillende functies.

De Wereld Economisch Forum over het recruitmentsysteem van Amazon: "Sterke genderongelijkheid zou bijvoorbeeld - zoals in het geval van Amazon - kunnen correleren met het type onderzoek dat is uitgevoerd. Deze vertekeningen in de trainingsgegevens kunnen ook het gevolg zijn van slechte gegevenskwaliteit of zeer kleine, niet-diverse gegevenssets, wat het geval kan zijn voor bedrijven die niet wereldwijd opereren en op zoek zijn naar nichekandidaten."

Amazon slaagde erin om een "afgezwakte versie" van de wervingsmotor te hergebruiken voor rudimentaire taken, zoals het verwijderen van dubbele kandidaatprofielen uit databases.

Ze stelden een nieuw team samen om geautomatiseerde werkgelegenheidsonderzoeken nog een kans te geven, dit keer gericht op het bevorderen van diversiteit.

Google vecht tegen zijn eigen problemen met discriminatie en vooroordelen

In december 2020 kondigde dr. Timnit Gebru, een vooraanstaand AI-ethicus bij Google, aan dat de bedrijf had haar ontslagen.

De opzegging kwam er nadat Dr. Gebru zijn bezorgdheid had geuit over Google's benadering van het aannemen van minderheden en inherente vooroordelen in AI-systemen.

Voordat hij het bedrijf verliet, zou Dr. Gebru een artikel publiceren over de vooroordelen in de AI-modellen van Google.

Na het indienen van dit artikel op een academische conferentie onthulde Dr. Gebru dat een manager van Google haar vroeg het artikel in te trekken of de namen van haarzelf en de andere Google-onderzoekers te verwijderen. Toen ze weigerde hieraan gehoor te geven, accepteerde Google een voorwaardelijk voorgesteld ontslag, waardoor Dr. Gebru's positie met onmiddellijke ingang werd beëindigd.

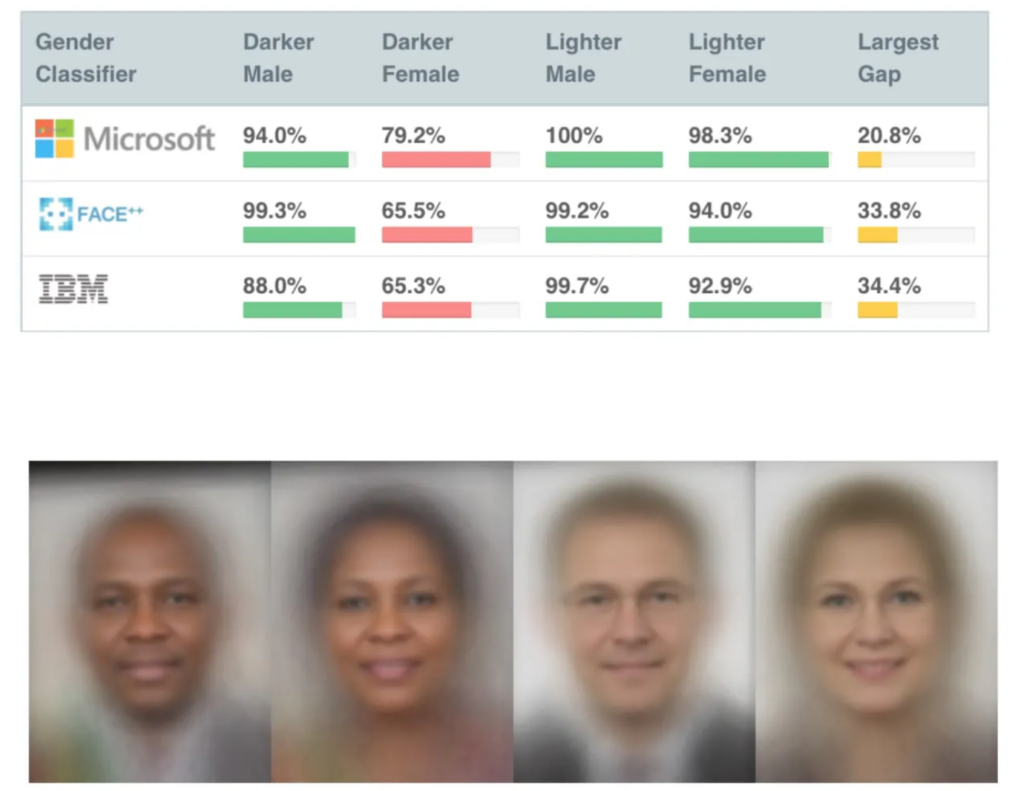

Dit was niet lang nadat er verschillende zeer invloedrijke onderzoeken over AI-vooringenomenheid waren gepubliceerd, waaronder MIT's onderzoek naar gendershakeringendat een van de meest geciteerde AI-papers aller tijden is geworden.

Het Gender Shades-onderzoek bracht vooroordelen aan het licht in AI's voor gezichtsherkenning, die zwarte gezichten ongeveer 30% tot 35% van de tijd verkeerd herkenden in vergelijking met ongeveer 5% voor blanke gezichten.

Onjuiste gezichtsherkenning leidde tot de onterechte arrestatie en opsluiting van verschillende mannen in de VS.

Het ontslag van Gebru veroorzaakte een mediastorm over discriminerende praktijken in Silicon Valley.

Mutale Nkonde van het Stanford Digital Civil Society Lab zei: "Haar ontslag geeft alleen maar aan dat wetenschappers, activisten en geleerden die op dit gebied willen werken - en zwarte vrouwen zijn - niet welkom zijn in Silicon Valley."

Het ontslag van Dr. Gebru inspireerde een ander onderzoek, Gecodeerde vooroordelen ontmaskerendie ontdekte dat zwarte mensen een significant grotere kans hadden om onderschat te worden door wervings-AI dan ieder ander.

"In dit rapport zijn veel aanwijzingen gevonden dat zwarte studenten en professionals zich zorgen maken over anti-zwarte vooroordelen tijdens het wervingsproces. Iets meer dan de helft van alle respondenten zegt vooroordelen te hebben waargenomen tijdens het wervings- of selectieproces op wervings- of selectiewebsites. Zwarte professionals hebben een iets grotere kans om dergelijke vooroordelen te hebben waargenomen met vijfenvijftig procent van de respondenten die aangeven vooroordelen te hebben waargenomen tijdens het wervingsproces," -. Gecodeerde vooroordelen ontmaskeren, Penn Law Policy Lab.

In de paper staat: "Het publieke gesprek dat werd aangezwengeld door Dr. Gebru en haar collega's over algoritmische bias stelde ons lab in staat om deel te nemen aan deze nationale dialoog en een genuanceerder begrip te krijgen van algoritmische bias in aanwervingsplatforms."

Het blootleggen van het probleem is een katalysator geweest voor verandering, maar AI heeft nog een lange weg te gaan om haar rol in gevoelige menselijke besluitvorming te verzoenen.

De rol van AI in werving en selectie: enkele positieve punten redden

Ondanks de vele controverses is het voor bedrijven moeilijk om weerstand te bieden aan het immense potentieel van AI om werving en selectie te versnellen.

De rol van AI bij werving is zeker logisch - het is misschien makkelijker om AI van vooroordelen te ontdoen dan mensen. Per slot van rekening is AI *gewoon* wiskunde en code - toch zeker kneedbaarder dan diepgewortelde onbewuste vooroordelen?

En hoewel trainingsgegevens in het begin tot midden van de jaren 2010 sterk vertekend waren, voornamelijk door een gebrek aan diverse datasets, is dit sindsdien aantoonbaar verbeterd.

Een prominent hulpmiddel voor AI-werving is Sapiaeen 'slimme interviewer' genoemd. Volgens Barb Hyman, de oprichter van Sapia, maakt AI een 'blind' sollicitatieproces mogelijk dat niet afhankelijk is van cv's, sociale media of demografische gegevens, maar alleen van de antwoorden van de sollicitant.

Deze systemen kunnen iedereen een eerlijke kans geven door alle sollicitanten te interviewen. Hyman suggereert"Je hebt twee keer zoveel kans om vrouwen te krijgen en te houden in het wervingsproces als je AI gebruikt."

Maar zelfs het interviewen van iemand met AI roept vragen op.

Natuurlijke taalverwerkingsmodellen (NLP) worden over het algemeen voornamelijk getraind op Engelse teksten, wat betekent dat ze slecht in de omgang met anderstalig Engels.

Deze systemen zouden niet-moedertaalsprekers van het Engels of mensen met andere culturele kenmerken onbedoeld kunnen benadelen. Bovendien beweren critici dat er in een AI-chat of video-interview mogelijk onvoldoende rekening wordt gehouden met handicaps, wat kan leiden tot nog meer potentiële discriminatie.

Dit wordt nog verergerd door het feit dat sollicitanten vaak niet weten of een AI hen beoordeelt, waardoor het onmogelijk is om de nodige aanpassingen in het sollicitatieproces aan te vragen.

Datasets zijn fundamenteel

Datasets zijn hier van fundamenteel belang. Train een AI op gegevens van tien jaar geleden en hij leert waarden van tien jaar geleden.

De arbeidsmarkt is aanzienlijk diverser geworden sinds de millenniumwisseling.

In sommige landen zijn er bijvoorbeeld meer vrouwen dan mannen in verschillende belangrijke medische disciplines, zoals psychologie, genetica, kindergeneeskunde en immunologie.

In het Verenigd Koninkrijk, een verslag over 2023 ontdekte dat 27% van de werkende vrouwen 'professionele beroepen' uitoefenden (zoals artsen, ingenieurs, verpleegkundigen, accountants, leerkrachten en advocaten) tegenover 26% van de mannen, een trend die de afgelopen 5 tot 10 jaar gestaag is toegenomen.

Dergelijke overgangen zijn de afgelopen 2 tot 5 jaar versneld - veel datasets zijn ouder en weerspiegelen simpelweg geen recente gegevens. Voor ras en handicaps gelden dezelfde problemen als voor geslacht.

Datasets moeten onze steeds diverser wordende werkplekken weerspiegelen om iedereen eerlijk te kunnen bedienen.

Hoewel er nog enorm veel moet gebeuren om diversiteit op de werkvloer te garanderen, moet AI waarden erven van het heden en niet van het verleden. Dat zou het absolute minimum moeten zijn voor het produceren van eerlijke en transparante wervings-AI's.

De ontwikkelaars van wervings-AI krijgen waarschijnlijk te maken met strenge regelgeving, met de VS, het VK, China, EU-lidstaten en vele andere landen die op het punt staan om AI-controles verscherpen de komende jaren.

Onderzoek is gaande, maar het blijft onwaarschijnlijk dat de meeste wervings-AI's de eerlijke en onbevooroordeelde principes toepassen die we van elkaar verwachten.