Gegevens zijn het levensbloed van AI, maar het is geen oneindige bron. Kan de mensheid zonder gegevens komen te zitten? Wat gebeurt er als dat gebeurt?

Complexe AI-modellen vereisen enorme hoeveelheden trainingsgegevens. Voor het trainen van een groot taalmodel (LLM) zoals ChatGPT zijn bijvoorbeeld ongeveer 10 biljoen woorden nodig.

Sommige deskundigen zijn van mening dat de aanvoer van gegevens van hoge kwaliteit afneemt. Een onderzoek uit 2022 van onderzoekers van verschillende universiteiten verklaarde, "Onze analyse geeft aan dat de voorraad taalgegevens van hoge kwaliteit binnenkort uitgeput zal zijn; waarschijnlijk voor 2026... Ons werk suggereert dat de huidige trend van steeds groeiende ML-modellen die vertrouwen op enorme datasets zou kunnen vertragen als de data-efficiëntie niet drastisch wordt verbeterd of als er nieuwe gegevensbronnen beschikbaar komen."

Het genereren van synthetische gegevens biedt een oplossing, maar slaagt er over het algemeen niet in om de diepte, nuance en variantie van echte gegevens vast te leggen.

Om de situatie nog ingewikkelder te maken, maakt men zich zorgen over wat er gebeurt als AI zijn eigen output begint te consumeren, wat volgens onderzoekers van de École Polytechnique Fédérale de Lausanne (EPFL) in Zwitserland het geval is. gebeurt al.

Hun onderzoek geeft aan dat AI-bedrijven die door mensen geproduceerde gegevens kopen via platforms zoals Amazon Mechanical Turk, in plaats daarvan door AI gegenereerde gegevens kunnen ontvangen.

Wat gebeurt er als AI zijn eigen output begint op te eten? Kan het worden voorkomen?

Het opbouwen van datasets is duur en tijdrovend - en er staat veel op het spel

Gegevens zijn alomtegenwoordig, maar het operationaliseren ervan voor AI is een complex proces. De kwaliteit van de gegevens en labels beïnvloedt de prestaties van het model - het is een geval van "vuilnis erin, vuilnis eruit".

Om het proces van het samenstellen van datasets kort te beschrijven, nemen data annotators (of labelaars) bewerkte data (bijvoorbeeld een bijgesneden afbeelding) en labelen kenmerken (bijvoorbeeld een auto, een persoon, een vogel).

Dit geeft algoritmen een 'doel' om van te leren. De algoritmen extraheren en analyseren kenmerken uit gelabelde gegevens om die kenmerken te voorspellen in nieuwe, ongeziene gegevens.

Dit is nodig voor supervised machine learning, een van de kerntakken van machine learning naast unsupervised machine learning en reinforcement learning. Door sommige schattingenHet voorbereiden en labelen van gegevens neemt 80% in beslag van de duur van een project voor een machine-learningmodel, maar als je te veel hooi op je vork neemt, loop je het risico dat de prestaties van een model in gevaar komen.

Naast de praktische uitdagingen om datasets van hoge kwaliteit te maken, verandert de aard van data voortdurend. Wat je 10 jaar geleden zou definiëren als een "dataset met een typische selectie van voertuigen op de weg" is vandaag de dag niet meer hetzelfde. Nu vind je bijvoorbeeld veel meer eScooters en eBikes op de weg.

Dit worden "randgevallen" genoemd, wat zeldzame objecten of fenomenen zijn die niet voorkomen in datasets.

Modellen weerspiegelen de kwaliteit van hun datasets

Als je een modern AI-systeem traint op een oude dataset, loopt het model het risico slecht te presteren wanneer het wordt blootgesteld aan nieuwe, ongeziene gegevens.

Tussen 2015 en 2020 ontdekten onderzoekers grote structurele vertekeningen in AI-algoritmen, die deels werden toegeschreven aan het trainen van modellen op oude en bevooroordeelde gegevens.

Bijvoorbeeld de Gelabelde gezichten in het wilde huis (LFW), een dataset van gezichten van beroemdheden die vaak wordt gebruikt in gezichtsherkenningstaken, bestaat uit 77,5% mannen en 83,5% blanken individuen. Een AI heeft geen hoop om goed te functioneren als de gegevens niet iedereen vertegenwoordigen die het van dienst wil zijn. Foutpercentages in gezichtsherkenning onder topalgoritmen bleken zo laag te zijn als 0,8% voor blanke mannen en zo hoog als 34,7% voor vrouwen met een donkere huidskleur.

Dit onderzoek culmineerde in de mijlpaal Gendertinten studie en een documentaire genaamd Gecodeerde vertekeningwaarin werd onderzocht hoe AI waarschijnlijk leert van gebrekkige en niet-representatieve gegevens.

De gevolgen hiervan zijn verre van goedaardig - dit heeft geleid tot onjuiste uitspraken in rechtszaken, onterechte gevangenisstraffen en vrouwen en andere groepen die banen en kredieten worden geweigerd.

AI's hebben meer gegevens van hoge kwaliteit nodig, die eerlijk en representatief moeten zijn - het is een ongrijpbare combinatie.

Zijn synthetische gegevens het antwoord?

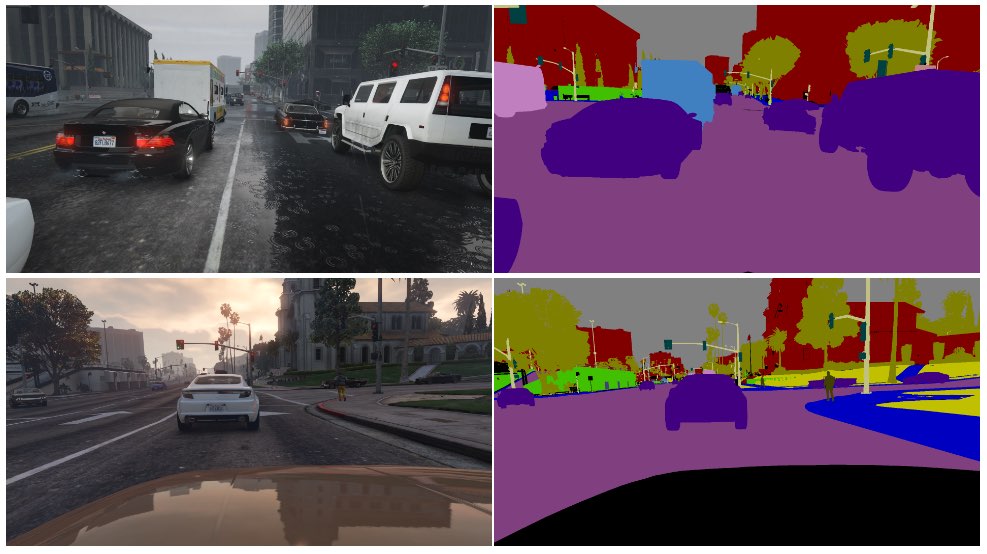

Synthetische gegevens worden vaak gebruikt in computer vision (CV), waarbij AI's objecten en kenmerken identificeren uit afbeeldingen en video.

In plaats van het verzamelen van beeldgegevens uit de echte wereld - zoals het fotograferen of filmen van een straat - wat technisch een uitdaging is en privacyproblemen oplevert, genereer je de gegevens gewoon in een virtuele omgeving.

Hoewel dit AI's aanvult met meer gegevens, zijn er verschillende nadelen:

- Het modelleren van levensechte scenario's in een virtuele omgeving is niet eenvoudig.

- Het genereren van grote hoeveelheden synthetische gegevens is nog steeds kostbaar en tijdrovend.

- Randgevallen en uitschieters blijven een probleem.

- Het kan het echte werk niet perfect nabootsen.

- Aan de andere kant zijn sommige aspecten misschien te perfect en is het moeilijk om te bepalen wat er ontbreekt.

Uiteindelijk zijn synthetische gegevens uitstekend voor gemakkelijk te virtualiseren omgevingen, zoals een fabrieksvloer, maar niet altijd geschikt voor snel bewegende echte omgevingen zoals een straat in een stad.

Hoe zit het met het genereren van synthetische tekstgegevens?

Tekst is eenvoudiger dan beeld- of videodata, dus kunnen modellen zoals ChatGPT worden gebruikt om bijna oneindige synthetische trainingsgegevens te genereren?

Ja, maar het is riskant en de gevolgen zijn niet gemakkelijk te voorspellen. Hoewel synthetische tekstgegevens kunnen helpen bij het afstemmen, testen en optimaliseren van modellen, zijn ze niet ideaal om modellen nieuwe kennis bij te brengen.

Hier is een analogie van waarom het trainen van AI's met door AI gegenereerde gegevens problematisch is:

- Denk eens aan een school die alle beste schoolboeken ter wereld gebruikt om haar leerlingen in één dag alles te leren wat er te weten valt.

- Daarna begint de school eigen werk te produceren op basis van die kennis - analoog aan de output van een chatbot. Studenten hebben geleerd van alle gegevens die beschikbaar zijn tot de datum waarop de training begint, maar ze kunnen daarna niet efficiënt nieuwe gegevens in het kennissysteem invoeren.

- Kennis wordt dagelijks gecreëerd - terwijl de overgrote meerderheid van de menselijke kennis vóór een specifieke dag werd gecreëerd, evolueert en transformeert kennis in de loop van de tijd. Cruciaal is dat mensen niet alleen voortdurend nieuwe kennis creëren - we veranderen ook ons perspectief op bestaande kennis.

- Stel nu dat de school, uitgeput van gegevens, haar leerlingen begint te onderwijzen met behulp van haar eigen output. Studenten beginnen hun inhoud op te eten om nieuwe inhoud te produceren.

- In dat stadium slaagt de output van de studenten er niet in zich aan te passen aan de echte wereld en neemt het nut ervan af. Het systeem herkauwt zijn eigen werk. Hoewel het werk zich kan aanpassen en evolueren, doet het dat geïsoleerd van alles buiten die feedbacklus.

AI confronteert mensen voortdurend met raadsels die ze moeten oplossen, en deze heeft veel commenters op Reddit en de Y Combinator forum stomverbaasd.

Het is verbijsterend en er is geen echte consensus over de gevolgen.

Menselijke gegevenslabelaars gebruiken vaak AI om gegevens te produceren

Er is nog een onvoorziene laag in het probleem van het produceren van kwalitatieve trainingsgegevens.

Crowdworking platforms zoals Amazon Mechanische Turk (MTurk) worden regelmatig gebruikt door AI-bedrijven die echte 'menselijke' datasets willen produceren. TEr bestaat bezorgdheid dat annotators op deze platforms AI's gebruiken om hun taken uit te voeren.

Onderzoekers van de École Polytechnique Fédérale de Lausanne (EPFL) in Zwitserland analyseerden gegevens van MTurk om te onderzoeken of werknemers AI gebruikten om hun inzendingen te genereren.

De studie, gepubliceerd op 13 juni, vroeg 44 MTurk-deelnemers om samenvattingen te maken van 16 medische onderzoekspapers. Uit het onderzoek bleek dat 33% tot 46% van de gebruikers op het platform hun inzendingen met AI genereerden, ondanks dat hen werd gevraagd te reageren in natuurlijke taal.

"We ontwikkelden een zeer specifieke methodologie die zeer goed werkte voor het detecteren van synthetische tekst in ons scenario," aldus Manoel Ribeiro, co-auteur van het onderzoek en promovendus aan de EPFL, vertelde The Register deze week.

Hoewel de dataset en de steekproefgrootte van het onderzoek vrij klein zijn, is het verre van ondenkbaar om te denken dat AI's onbewust worden getraind op AI-gegenereerde inhoud.

De onderzoekers merken op dat lage lonen en repetitief werk bijdragen aan het probleem. AI-bedrijven willen gegevens van topkwaliteit die door mensen zijn gemaakt en tegelijkertijd de kosten laag houden. Een commentator zei op Reddit: "Ik ben momenteel een van deze werknemers, belast met het trainen van Bard. Ik weet zeker dat ik hiervoor ChatGPT gebruik. 20$/uur is niet genoeg voor de vreselijke behandeling die we krijgen, dus ik ga elke cent uit deze ******* baan persen."

Het konijnenhol wordt nog dieper, omdat AI's vaak worden getraind op gegevens die van het internet zijn gehaald. Naarmate er meer AI-content online wordt gepubliceerd, zal AI onvermijdelijk leren van zijn eigen output.

Nu mensen voor informatie afhankelijk worden van AI's, wordt de kwaliteit van hun output steeds belangrijker. We moeten innovatieve methoden vinden om AI's bij te werken met verse, authentieke gegevens.

Zoals Ribeiro het zegt: "Menselijke gegevens zijn de gouden standaard, want het zijn mensen waar we om geven, niet grote taalmodellen."

Er wordt nog steeds gewerkt aan het analyseren van de potentiële impact van AI die zijn eigen output consumeert, maar authentieke menselijke gegevens blijven van cruciaal belang voor een groot aantal taken op het gebied van machinaal leren.

Het genereren van enorme hoeveelheden gegevens voor hongerige AI's en het tegelijkertijd omgaan met risico's is een werk in uitvoering.