AI-onderzoekers van Stanford hebben de naleving van 10 toonaangevende AI-modellen getoetst aan de voorgestelde EU-AI Act en ontdekten grote verschillen, met over het algemeen matige resultaten over de hele linie.

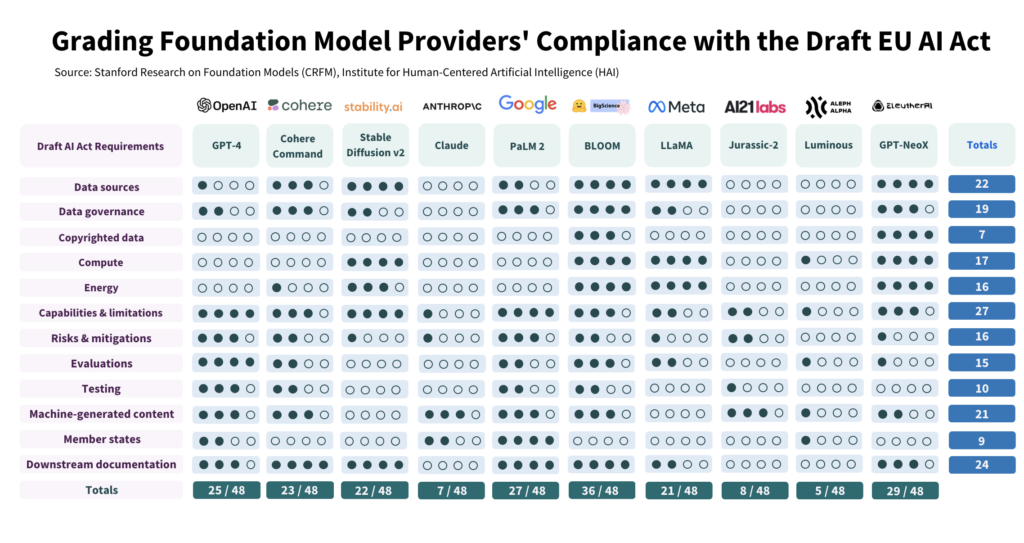

De studie We hebben 10 AI-modellen kritisch getoetst aan 12 criteria uit de ontwerpwetgeving van de EU en ontdekten dat er grote verschillen zijn in de naleving, waarbij geen enkel model aan alle criteria voldeed.

Het onderzoek benadrukt de kloof tussen de verwachtingen van de AI-wet en de huidige governance-inspanningen bij toonaangevende AI-ontwikkelaars.

Om aan de wet te voldoen, moeten ontwikkelaars hun strategieën voor transparantie en risicobeperking, die in sommige gevallen bijna volledig ontbreken, aanzienlijk verbeteren.

Hoe het onderzoek is uitgevoerd

De auteurs voerden een gedetailleerd onderzoek uit naar de AI-wet, waaruit 22 vereisten naar voren kwamen.

Hieruit selecteerden ze er 12 die zinvol geëvalueerd konden worden met behulp van openbare informatie. Vervolgens creëerden ze een 5-punts rubric voor elk van deze 12 vereisten.

Het open-source AI-model BLOOM, geproduceerd door Hugging Face, kwam naar voren als het hoogst scorende model met een totaal van 36 van de 48 potentiële punten.

Daarentegen presteerden het door Google gesteunde Anthropic en het Duitse AI-bedrijf Aleph Alpha beduidend slechter, met een score van respectievelijk 7 en 5. ChatGPT viel in de middenmoot met 25/48.

De 4 belangrijkste gebieden van niet-naleving zijn auteursrechtelijk beschermde gegevens, energie, risicobeperking en evaluatie/testen.

Een van de auteurs, Kevin Klyman, een onderzoeker aan het Stanford Center for Research on Foundation Models, merkte op dat de meeste ontwikkelaars hun risicobeperkende strategieën niet bekendmaken, wat een breekpunt zou kunnen zijn. Klyman zei: "Aanbieders maken de effectiviteit van hun risicobeperkende maatregelen vaak niet bekend, wat betekent dat we niet kunnen zeggen hoe riskant sommige foundationmodellen zijn."

Bovendien is er een grote variatie in de trainingsgegevens die worden gebruikt om modellen te trainen. De EU zal van AI-ontwikkelaars eisen dat ze transparanter zijn over hun gegevensbronnen, iets wat 4/10 van de ontwikkelaars niet doet. ChatGPT scoorde slechts 1 punt op dat gebied.

Open source versus propriëtaire modellen

Het rapport ontdekte ook een duidelijke tweedeling in naleving, afhankelijk van of een model open source of propriëtair was.

Open-source modellen scoorden goed op het gebied van informatieverschaffing en gegevensvereisten, maar hun risico's zijn grotendeels ongedocumenteerd.

Propriëtaire modellen zijn het tegenovergestelde - ze zijn zwaar getest en goed gedocumenteerd met robuuste strategieën voor risicobeperking, maar ze zijn ondoorzichtig wat betreft gegevens en technologiegerelateerde statistieken.

Of, om het fijner te stellen, open-source ontwikkelaars hebben niet zoveel concurrentiegeheimen af te schermen, maar hun producten zijn inherent risicovoller, omdat ze door bijna iedereen gebruikt en aangepast kunnen worden.

Omgekeerd zullen privéontwikkelaars waarschijnlijk aspecten van hun modellen achter slot en grendel houden, maar kunnen ze wel veiligheid en risicobeperking aantonen. Zelfs Microsoft, OpenAI's belangrijkste investeerder, is nog niet volledig overtuigd van het nut van hun modellen. begrijpen hoe OpenAI's modellen werken.

Wat beveelt het onderzoek aan?

De auteurs van het onderzoek erkennen dat de kloof tussen de verwachtingen van de EU en de realiteit alarmerend is en doen verschillende aanbevelingen aan beleidsmakers en modelontwikkelaars.

Het onderzoek beveelt EU-beleidsmakers aan:

- De parameters van de EU-AI Act verfijnen en specificeren: De onderzoekers stellen dat de technische taal en parameters van de AI-wet te weinig gespecificeerd zijn.

- Transparantie en verantwoording bevorderen: Onderzoekers stellen dat de strengste regels zeer gericht moeten zijn op de allergrootste en meest dominante ontwikkelaars, wat zou moeten leiden tot een effectievere handhaving.

- Zorg voor voldoende middelen voor handhaving: Om de AI-wet van de EU effectief te kunnen handhaven, moeten de handhavingsinstanties de beschikking krijgen over technische middelen en talent.

Het onderzoek doet aanbevelingen aan mondiale beleidsmakers:

- Geef prioriteit aan transparantie: De onderzoekers benadrukken dat transparantie cruciaal is en de belangrijkste focus moet zijn van beleidsinspanningen. Ze stellen dat lessen uit de regulering van sociale media de schadelijke gevolgen van gebrekkige transparantie aan het licht brengen, die zich niet zouden moeten herhalen in de context van AI.

- Problemen met auteursrecht verduidelijken: De grenzen van het auteursrecht voor AI-trainingsgegevens en AI-uitvoer staan ter discussie. Gezien de lage compliance bij het openbaar maken van auteursrechtelijk beschermde trainingsgegevens, stellen de onderzoekers dat wettelijke richtlijnen moeten specificeren hoe auteursrecht interacteert met trainingsprocedures en de output van generatieve modellen. Dit omvat het definiëren van de voorwaarden waaronder auteursrecht of licenties moeten worden gerespecteerd tijdens het trainen en het bepalen hoe door machines gegenereerde inhoud inbreuk kan maken op het auteursrecht.

Het onderzoek doet aanbevelingen aan ontwikkelaars van funderingsmodellen:

- Streef naar voortdurende verbetering: Aanbieders moeten consequent streven naar verbetering van hun naleving. Grotere aanbieders, zoals OpenAI, moeten het goede voorbeeld geven en middelen verspreiden onder downstream klanten die via API's toegang hebben tot hun modellen.

- Pleit voor industriestandaarden: Modelaanbieders moeten bijdragen aan het opstellen van industriestandaarden, wat kan leiden tot een transparanter en beter controleerbaar AI-ecosysteem.

Hoewel er een aantal positieve punten te halen zijn uit de risico- en controlenormen die zijn opgesteld door toonaangevende ontwikkelaars zoals OpenAI, zijn de tekortkomingen op gebieden zoals auteursrecht verre van ideaal.

Wat betreft het toepassen van regelgeving op AI als een allesomvattende categorie - dat kan inderdaad heel lastig worden - aangezien commerciële en open-source modellen structureel verschillend zijn en moeilijk over één kam te scheren.