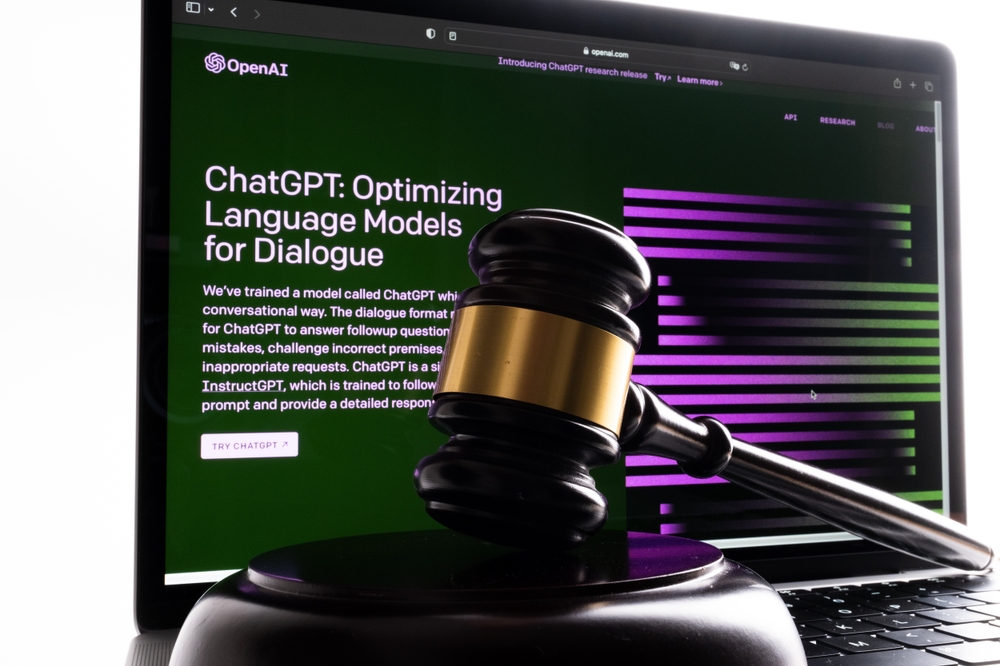

Eind mei gebruikte de New Yorkse advocaat Steven A Schwartz ChatGPT om juridische zaken te onderzoeken voor een cliënt.

Schwartz en een collega van hetzelfde advocatenkantoor, Peter LoDuca, verschenen donderdag voor de rechter om hun acties uit te leggen.

Tijdens de hoorzitting bekenden beide advocaten dat ze verwezen naar valse rechtszaken die waren gegenereerd door ChatGPT.

Schwartz gebruikte ChatGPT om juridische precedenten te vinden ter ondersteuning van de zaak van een cliënt tegen de Colombiaanse luchtvaartmaatschappij Avianca. leverde verschillende valse gevallen en één echt geval op met sterk veranderde details.

Schwartz citeerde deze in de brief van de aanklager, maar toen US District Judge Kevin Castel deze ontving, merkte hij al snel de nepzaken en zei: "Zes van de ingediende zaken lijken neprechterlijke uitspraken te zijn met nepcitaten en nepinterne citaten."

"Ik begreep niet dat ChatGPT zaken kon fabriceren," bekende Schwartz aan Castel, waarbij hij toegaf dat hij "in de misvatting verkeerde... dat deze website deze zaken verkreeg van een bron waar ik geen toegang toe had."

Rechter Castel confronteerde hen met een bijzonder verzonnen rechtszaak die Schwartz als vals had moeten bestempelen. De zaak werd eerst beschreven als een onrechtmatige doodszaak, maar veranderde later in een zaak over een man die een vlucht miste en extra kosten moest betalen.

Met andere woorden, zelfs voor een leek was het waarschijnlijk duidelijk dat deze zaak vals was, dus Schwartz heeft de uitvoer van de AI waarschijnlijk niet goed gelezen. "Kunnen we het erover eens zijn dat dit juridisch gebrabbel is?" zei Castel over de zaak.

Schwartz verontschuldigde zich overvloedig: "Ik wil mijn oprechte excuses aanbieden" en zei dat hij zich "beschaamd, vernederd en zeer berouwvol" voelde.

LoDuca gaf toe dat hij het materiaal dat Schwartz samenstelde niet goed had bekeken. Hij zei: "Het is nooit tot me doorgedrongen dat dit een nepzaak was" en dat de uitkomst "me ontzettend pijn doet".

Met betrekking tot de vraag of het duo gestraft zal worden, voerde advocaat Ronald Minkoff aan dat de acties van het duo "voortkwamen uit onzorgvuldigheid, niet uit kwade trouw" en dus niet gestraft zouden moeten worden.

Minkoff stelde: "Meneer Schwartz, die nauwelijks federaal onderzoek doet, koos ervoor om deze nieuwe technologie te gebruiken. Hij dacht dat hij te maken had met een standaard zoekmachine."

De definitieve uitspraak over de sancties is nog hangende.

AI 'hallucinaties' leveren zowel ethische als juridische problemen op

Een reeks van rechtszaken raakt OpenAIwaaronder drie gevallen van mogelijke smaad die ontstond toen de output van ChatGPT valse en lasterlijke informatie bevatte.

Het resultaat is hier anders. Dit is een voorbeeld van wangedrag als gevolg van advies uit de output van ChatGPT.

Daniel Shin, adjunct-professor en assistent-directeur onderzoek bij het Center for Legal and Court Technology aan de William & Mary Law School, zei: "Dit was het eerste gedocumenteerde geval van mogelijk professioneel wangedrag door een advocaat die gebruik maakte van generatieve AI."

Het was slechts een kwestie van tijd voordat iemand deze fout zou maken. Schwartz was toevallig de eerste (voor zover wij weten) in wat een precedent bleek te zijn dat hij waarschijnlijk niet verwachtte te scheppen.