NVIDIAs administrerende direktør Jensen Huang brukte åpningstalen på Taiwans Computex 2024-arrangement til å avduke neste generasjons teknologi og veikartet selskapet vil følge for å bli den ledende AI-maskinvareplattformen.

Temaet for talen var "Accelerate everything", og Huang presenterte nye brikker, raskere AI-nettverk og et ambisiøst veikart for utvikling. NVIDIA ønsker å være en muliggjører for alt fra AI-PC-er til massive AI-fabrikker, og vil være det neste som kommer med AI.

"Fremtiden for databehandling er akselerert", sier Huang. "Med våre innovasjoner innen kunstig intelligens og akselerert databehandling flytter vi grensene for hva som er mulig og driver frem den neste bølgen av teknologiske fremskritt."

Her er en rask titt på noen av kunngjøringene:

Nye chips

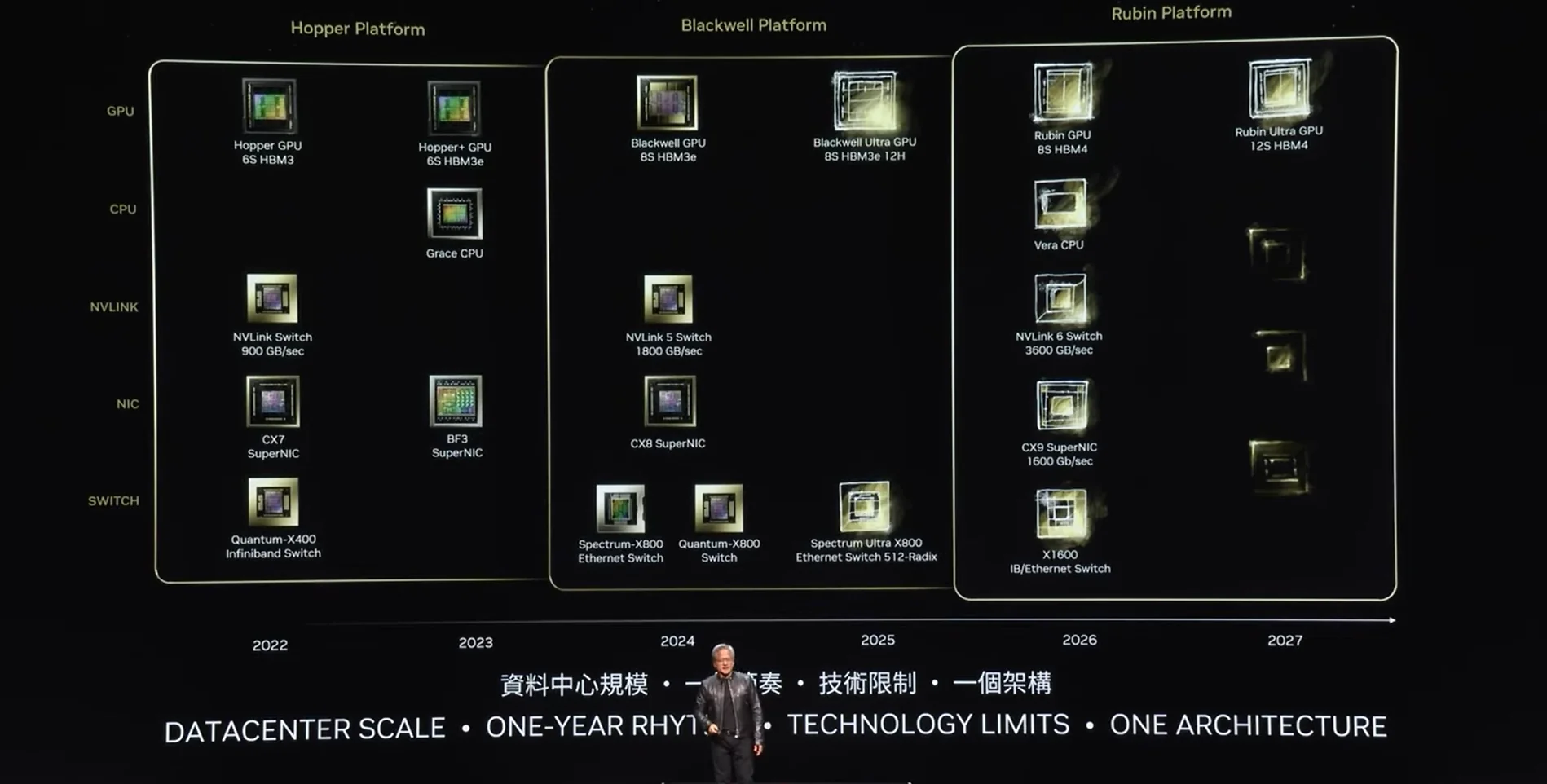

Blackwell GPU-ene er ferske, men Huang sier at vi allerede kan forvente en oppgradert Blackwell Ultra GPU senere i år. Han sa at NVIDIAs utviklingsplan vil se en ny familie av brikker utgitt hvert år.

"Selskapet vårt har en ettårsrytme. Vår grunnleggende filosofi er veldig enkel: Vi bygger hele datasenterskalaen, deler den opp og selger deler til deg i en ettårsrytme, og presser alt til teknologiens grenser", forklarer Huang.

Huang kunngjorde at Rubin-plattformen i 2026 vil avløse Blackwell-familien av GPU-er.

AI-fabrikker

Huang nevnte flere databehandlingsfirmaer som skal bygge "AI-fabrikker" som skal levere AI-systemer i skyen, på stedet, innebygde og edge AI-systemer ved hjelp av NVIDIA GPU-er og nettverk.

Huang sa: "Den neste industrielle revolusjonen har begynt. Bedrifter og land samarbeider med NVIDIA for å flytte de tradisjonelle datasentrene, som koster billioner av dollar, over til akselerert databehandling og bygge en ny type datasenter - AI-fabrikker - for å produsere en ny vare: kunstig intelligens."

NVIDIA MGX (Modular Server Reference Architecture) er en plan for bygging av datasenter-servere med fokus på akselerert databehandling. Den bruker en standardisert tilnærming for å bygge servere ved hjelp av NVIDIA-produkter, noe som gjør det mye enklere å bygge slike AI-fabrikker.

NVIDIA Spectrum-X

NVIDIA bruker NVLink til å flytte data mellom GPU-er, men å flytte data mellom GPU-pods i eller mellom datasentre er en ekstra utfordring.

NVIDIA Spectrum-X er verdens første Ethernet-nettverksplattform som er spesielt utviklet for å forbedre ytelsen til AI-arbeidsbelastninger. NVIDIA Spectrum-X er naturligvis optimalisert for NVIDIAs maskinvare.

NVIDIA sier at Spectrum-X øker ytelsen til generative AI-nettverk med 1,6 ganger i forhold til tradisjonelle Ethernet-strukturer.

I forrige uke meldte vi at store teknologiselskaper jobber med å utvikle en åpen standard for akselerert AI-nettverk uten NVIDIAs innspill.

Huang sa likevel at Spectrum-X allerede er tatt i bruk av selskaper som Dell Technologies, Hewlett Packard Enterprise og Lenovo.

NIM

NVIDIA NIM, som står for NVIDIA Inference Microservices, er et sett med verktøy som er utviklet for å forenkle og akselerere implementeringen av generative AI-modeller.

Før du kan bruke en AI-modell, må utviklerne distribuere den. I stedet for å måtte flikke på detaljene i denne prosessen, forenkler NVIDIAs NIM-er distribusjonen ved at de automatisk containeriserer AI-modeller og optimaliserer dem for NVIDIA-maskinvare.

Det er som forskjellen mellom å kjøpe, hakke og sette sammen alle ingrediensene til et måltid og å sette en ferdigrett i ovnen.

Huang kunngjorde at Llama 3 NIM nå var tilgjengelig som en gratis nedlasting for utviklere å prøve ut. Huang presenterte også Nvidia Ace NIMs, som inkluderer en Digital Human-modell som er i stand til å generere AI-menneskemodeller med naturtro hud.

Du kan se hele talen for å få mer informasjon om AI RTX-drevne PC-er og bærbare datamaskiner, Nividias Isaac ROS 3.0-robotplattform og hvordan fabrikker bruker NVIDIAs teknologi til å skape digitale tvillinger på fabrikkene sine for å trene opp roboter.